Ein ausführlicher Leitfaden für technisches SEO

Veröffentlicht: 2021-07-16Keyword-Recherche, hochwertige Inhalte, Linkaufbau, On-Page-SEO – diese Taktiken helfen Ihnen, Ihr organisches Ranking zu verbessern. Aber Strategien zur Suchmaschinenoptimierung bringen Sie nur so weit.

Ihr technisches SEO-Haus in Ordnung zu bringen, ist das letzte Puzzleteil beim Website-Ranking.

Beim technischen SEO geht es darum, Ihren Suchenden ein erstklassiges Weberlebnis zu bieten. Die Leute wollen schnell ladende Webseiten, stabile Grafiken und Inhalte, mit denen man leicht interagieren kann.

In diesem Artikel werden wir untersuchen, was technisches SEO ist und wie es sich auf das Website-Wachstum auswirkt.

Was ist technisches SEO (und wie wirkt es sich auf das Wachstum aus)?

Technisches SEO ist der Prozess, bei dem sichergestellt wird, dass Ihre Website die technischen Anforderungen von Suchmaschinen erfüllt, um das organische Ranking zu verbessern. Indem Sie bestimmte Elemente Ihrer Website verbessern, helfen Sie den Suchmaschinen-Spidern, Ihre Webseiten einfacher zu crawlen und zu indizieren.

Starkes technisches SEO kann auch dazu beitragen, Ihre Benutzererfahrung zu verbessern, die Conversions zu steigern und die Autorität Ihrer Website zu stärken.

Zu den Schlüsselelementen des technischen SEO gehören:

- Krabbeln

- Indizierung

- Rendern

- Site-Architektur

Selbst mit qualitativ hochwertigen Inhalten, die der Suchabsicht entsprechen, einen Mehrwert bieten und reif für Backlinks sind, wird es schwierig sein, ohne angemessenes technisches SEO ein Ranking zu erzielen. Je einfacher Sie Google das Leben machen, desto wahrscheinlicher wird Ihre Website ranken.

Es wurde vorgeschlagen, dass die Reaktionsgeschwindigkeit eines Systems die Verzögerungen nachahmen sollte, die Menschen erfahren, wenn sie miteinander interagieren. Das bedeutet, dass Seitenantworten etwa 1-4 Sekunden dauern sollten.

Wenn das Laden Ihrer Website länger als vier Sekunden dauert, verlieren die Leute möglicherweise das Interesse und springen ab.

Die Seitengeschwindigkeit wirkt sich nicht nur auf die Benutzererfahrung aus, sondern kann sich auch auf die Verkäufe auf E-Commerce-Websites auswirken.

Wie Kit Eaton in Fast Company berühmt schrieb:

„ Amazon hat berechnet, dass eine Verlangsamung des Seitenaufbaus von nur einer Sekunde das Unternehmen jedes Jahr 1,6 Milliarden US-Dollar Umsatz kosten könnte. Google hat berechnet, dass sie durch eine Verlangsamung ihrer Suchergebnisse um nur vier Zehntelsekunden 8 Millionen Suchanfragen pro Tag verlieren könnten – was bedeutet, dass sie viele Millionen weniger gesponserte Anzeigen schalten würden. ”

Der Beweis, dass eine langsam ladende Website, nur ein Element der technischen SEO, das Unternehmenswachstum direkt beeinflussen kann.

Sollten Sie einen technischen SEO-Berater beauftragen oder Ihr eigenes Audit durchführen?

Sie sollten alle paar Monate ein technisches SEO-Audit durchführen. Dies hilft Ihnen, technische Faktoren (auf die wir gleich eingehen werden), On-Page-Faktoren wie Website-Inhalte und Off-Page-Faktoren wie Backlinks zu überwachen.

Tools wie Ahrefs erleichtern die Durchführung Ihres eigenen Audits. Sie sind auch billiger und schneller als die Einstellung eines technischen SEO-Beraters. Ein Berater kann Wochen oder sogar Monate brauchen, um ein Audit abzuschließen, während die Durchführung Ihres eigenen Audits Stunden oder Tage dauern kann.

Experteneinblicke von einem erfahrenen Berater können jedoch wichtig sein, wenn Sie:

- Sie stellen eine neue Website bereit und möchten sicherstellen, dass sie richtig eingerichtet ist

- Sie ersetzen eine alte Website durch eine neue und möchten eine nahtlose Migration sicherstellen

- Haben Sie mehrere Websites und benötigen Sie Einblicke, ob Sie sie separat optimieren oder zusammenführen sollten

- Führen Sie Ihre Webseiten in mehreren Sprachen aus und möchten Sie sicherstellen, dass jede Version richtig eingerichtet ist

Wie auch immer, um technisches SEO richtig zu machen, priorisieren Sie ein umfassendes Verständnis der Grundlagen.

1. Crawling und Indizierung

Suchmaschinen müssen in der Lage sein, Webseiten zu identifizieren, zu crawlen, darzustellen und zu indizieren.

Website-Architekturen

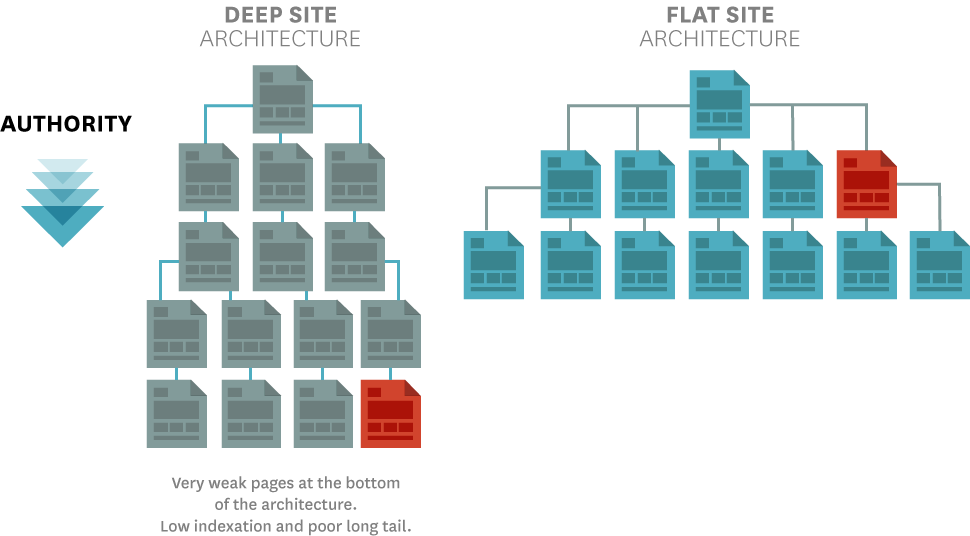

Webseiten, die nicht eindeutig mit der Homepage verbunden sind, sind für Suchmaschinen schwerer zu identifizieren.

Sie werden wahrscheinlich keine Probleme haben, Ihre Homepages indiziert zu bekommen. Seiten, die nur wenige Klicks von der Homepage entfernt sind, verursachen jedoch aus verschiedenen Gründen häufig Crawling- und Indexierungsprobleme, insbesondere wenn zu wenige interne Links auf sie verweisen.

Flache Website-Architekturen, bei denen Webseiten klar miteinander verknüpft sind, helfen, dieses Ergebnis zu vermeiden:

Die Verwendung einer Säulenseitenstruktur mit internen Links zu relevanten Seiten kann Suchmaschinen dabei helfen, den Inhalt Ihrer Website zu indexieren. Da Homepages oft eine höhere Seitenautorität haben, macht das Verbinden von ihnen Seiten für Crawling-Suchmaschinen-Spider auffindbarer.

XML-Sitemaps

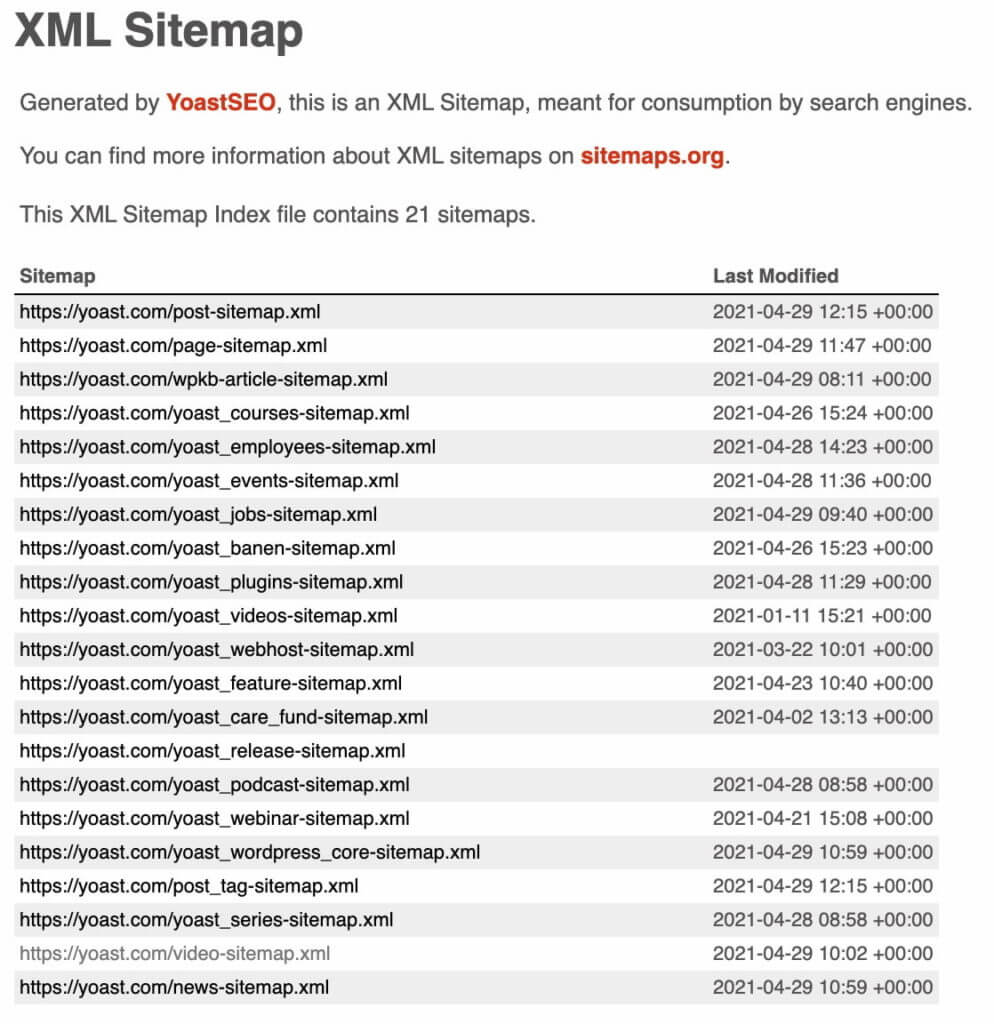

XML-Sitemaps bieten eine Liste aller wichtigsten Seiten Ihrer Website. Obwohl sie anstelle der Reaktionsfähigkeit auf Mobilgeräten und anderer Ranking-Faktoren überflüssig erscheinen mögen, hält Google sie dennoch für wichtig.

XML-Sitemaps sagen Ihnen:

- Wann eine Seite zuletzt geändert wurde

- Wie oft Seiten aktualisiert werden

- Welche Priorität haben Seiten auf Ihrer Website?

In der Google Search Console können Sie die XML-Sitemap überprüfen, die die Suchmaschine beim Crawlen Ihrer Website sieht. Hier ist die XML-Sitemap von Yoast.com:

Verwenden Sie die folgenden Tools, um regelmäßig nach Crawling-Fehlern zu suchen und um zu sehen, ob Webseiten von Suchmaschinen-Spidern indexiert werden:

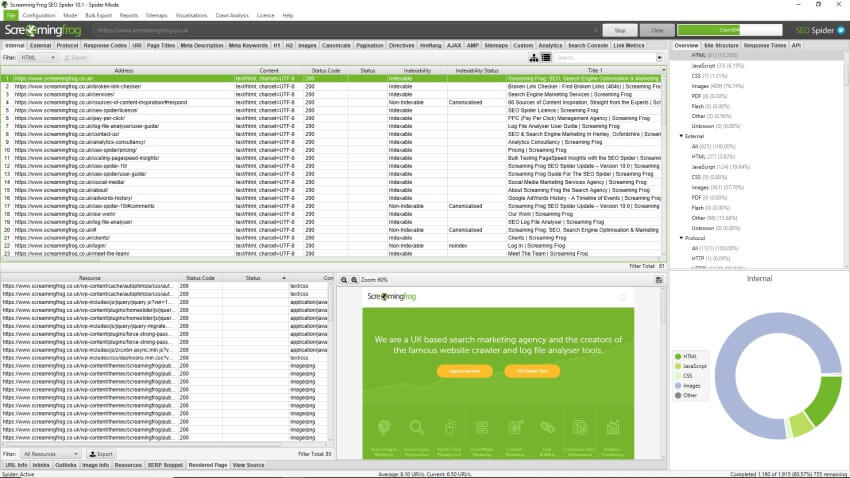

Schreiender Frosch

Screaming Frog ist der Goldstandard der Branche zur Identifizierung von Indexierungs- und Crawling-Problemen:

Wenn Sie es ausführen, extrahiert es die Daten von Ihrer Website und prüft auf häufige Probleme wie fehlerhafte Weiterleitungen und URLs. Mit diesen Erkenntnissen können Sie schnelle Änderungen vornehmen, wie z. B. das Beheben eines 404-defekten Links, oder langwierigere Korrekturen planen, z. B. das Aktualisieren von Meta-Beschreibungen auf der gesamten Website.

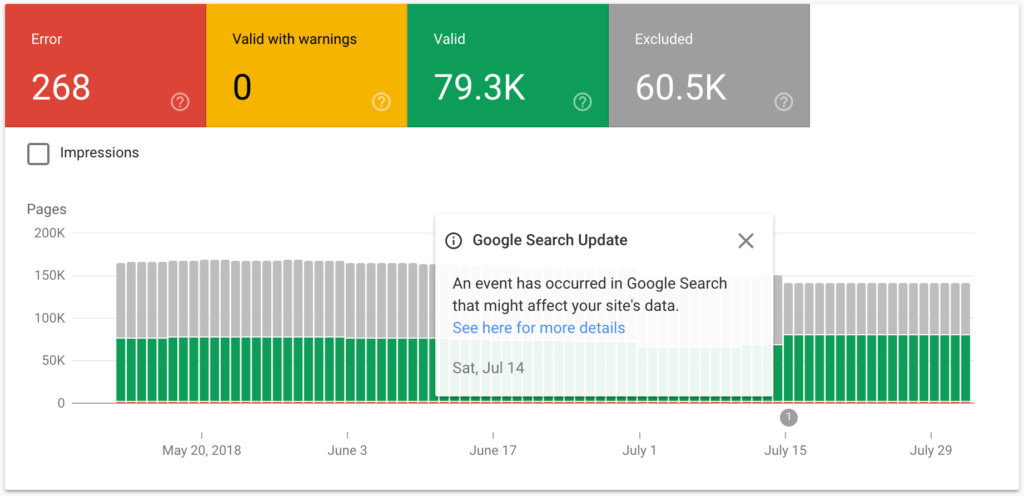

Abdeckungsbericht und Indizierung mit der Google Search Console prüfen

Die Google Search Console verfügt über einen hilfreichen Abdeckungsbericht, der Ihnen mitteilt, ob Google Seiten, die Sie entdecken müssen, nicht vollständig indexieren oder rendern kann:

Manchmal werden Webseiten von Google zwar indexiert, aber falsch dargestellt. Das bedeutet, dass Google die Seite zwar indexieren kann, aber nicht 100 % des Inhalts crawlt.

2. Seitenstruktur

Ihre Seitenstruktur ist die Grundlage aller anderen technischen Elemente. Es beeinflusst Ihre URL-Struktur und die robots.txt-Datei, mit der Sie entscheiden können, welche Seiten von Suchmaschinen gecrawlt und welche ignoriert werden sollen.

Viele Crawling- und Indexierungsprobleme sind das Ergebnis schlecht durchdachter Website-Strukturen. Wenn Sie eine klare Website-Struktur aufbauen können, in der sowohl Google als auch Suchende leicht navigieren können, werden Sie später keine Crawling- und Indexierungsprobleme haben.

Kurz gesagt, einfache Website-Strukturen helfen Ihnen bei anderen technischen SEO-Aufgaben.

Eine übersichtliche Seitenstruktur verknüpft Webseiten logisch, sodass weder Menschen noch Suchmaschinen durch die Reihenfolge der Seiten verwirrt werden.

Verwaiste Seiten sind solche, die von anderen Seiten abgeschnitten sind, weil sie keine internen Links haben. Site-Manager sollten diese vermeiden, da sie anfällig dafür sind, von Suchmaschinen nicht gecrawlt und indexiert zu werden.

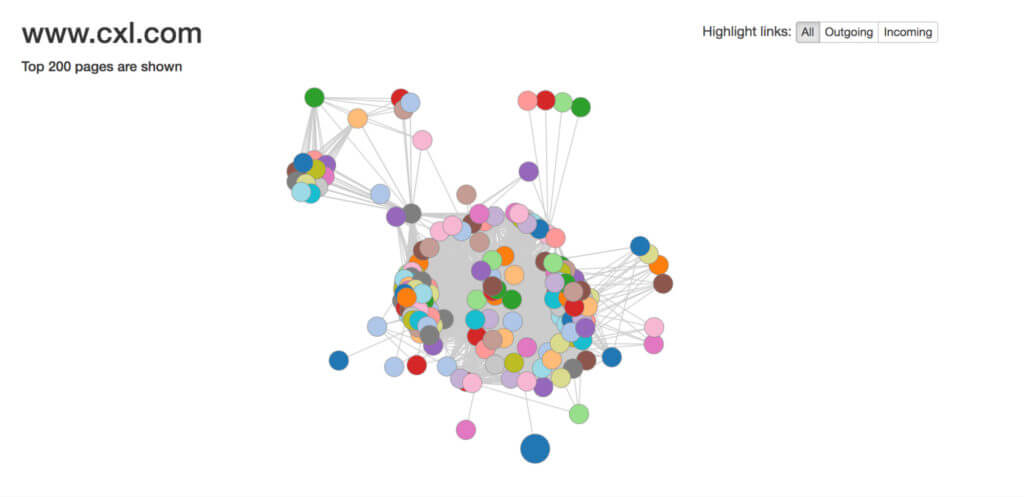

Tools wie Visual Site Mapper können Ihnen dabei helfen, die Struktur Ihrer Website klar zu sehen und zu beurteilen, wie gut Seiten miteinander verlinkt sind. Eine solide interne Verlinkungsstruktur zeigt die Beziehung zwischen Ihren Inhalten für Google und Nutzer gleichermaßen:

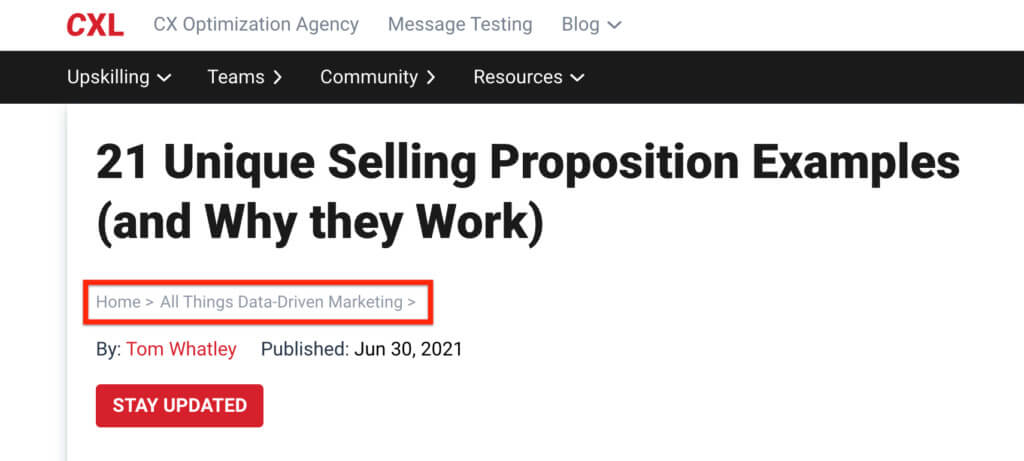

Breadcrumbs-Navigation

Die Breadcrumb-Navigation ist gleichbedeutend damit, Suchmaschinen und Benutzern viele Hinweise zu hinterlassen, welche Art von Inhalt sie erwarten können.

Die Breadcrumbs-Navigation fügt automatisch interne Links zu Unterseiten Ihrer Website hinzu:

Dies trägt dazu bei, die Architektur Ihrer Website zu verdeutlichen, und macht es Menschen und Suchmaschinen leicht, das zu finden, wonach sie suchen.

Strukturierte Daten

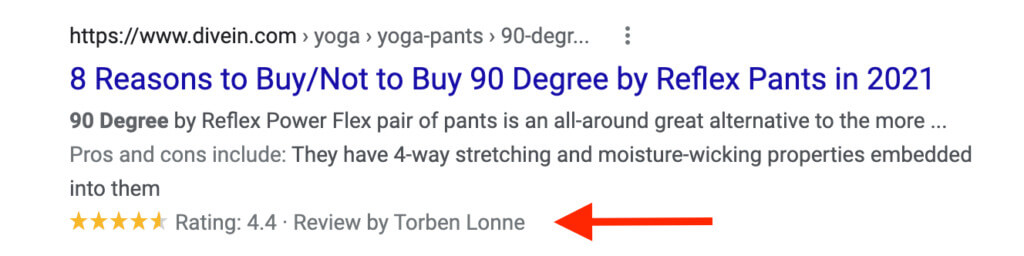

Die Verwendung von Markup-Code für strukturierte Daten kann Suchmaschinen helfen, Ihre Inhalte besser zu verstehen. Als Bonus können Sie auch in Rich Snippets erscheinen, was mehr Suchende dazu anregen kann, sich zu Ihrer Website durchzuklicken.

Hier ist ein Beispiel für ein Bewertungs-Rich Snippet in Google:

Sie können Googles Structured Data Markup Helper verwenden, um neue Tags zu erstellen.

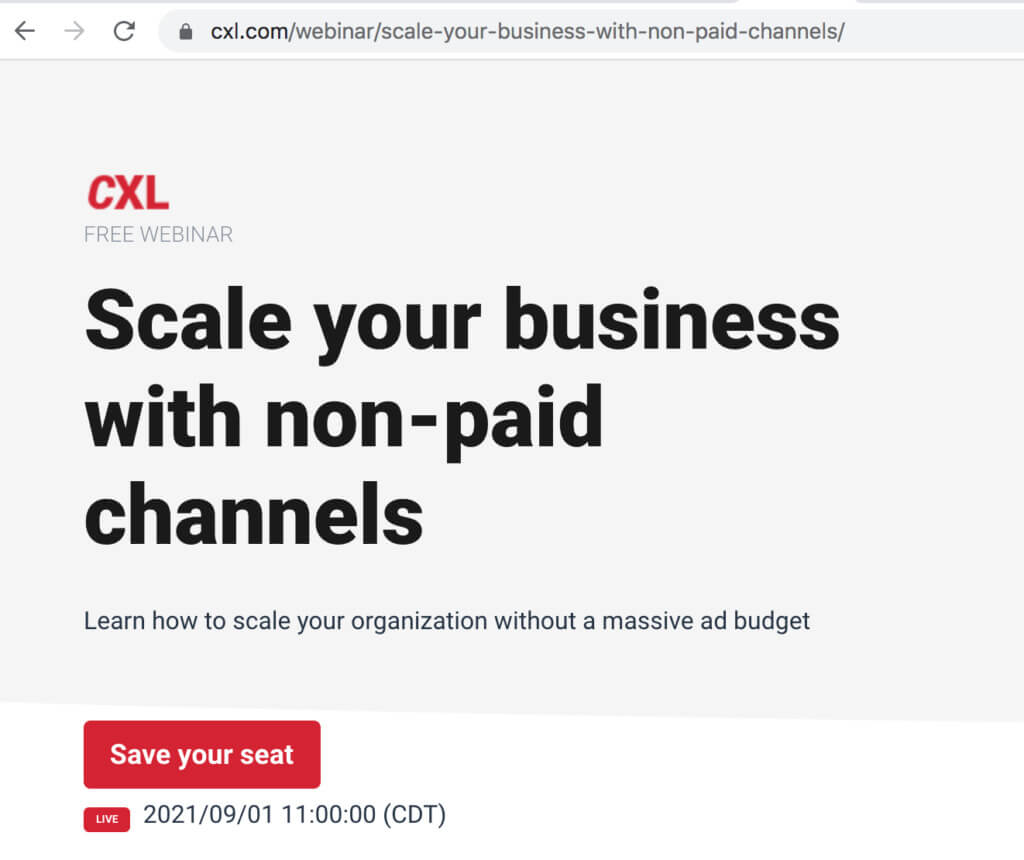

URL-Struktur

Lange komplizierte URLs mit scheinbar zufälligen Zahlen, Buchstaben und Sonderzeichen verwirren Benutzer und Suchmaschinen.

URLs müssen einem einfachen und konsistenten Muster folgen. Auf diese Weise können Benutzer und Suchmaschinen leicht nachvollziehen, wo sie sich auf Ihrer Website befinden.

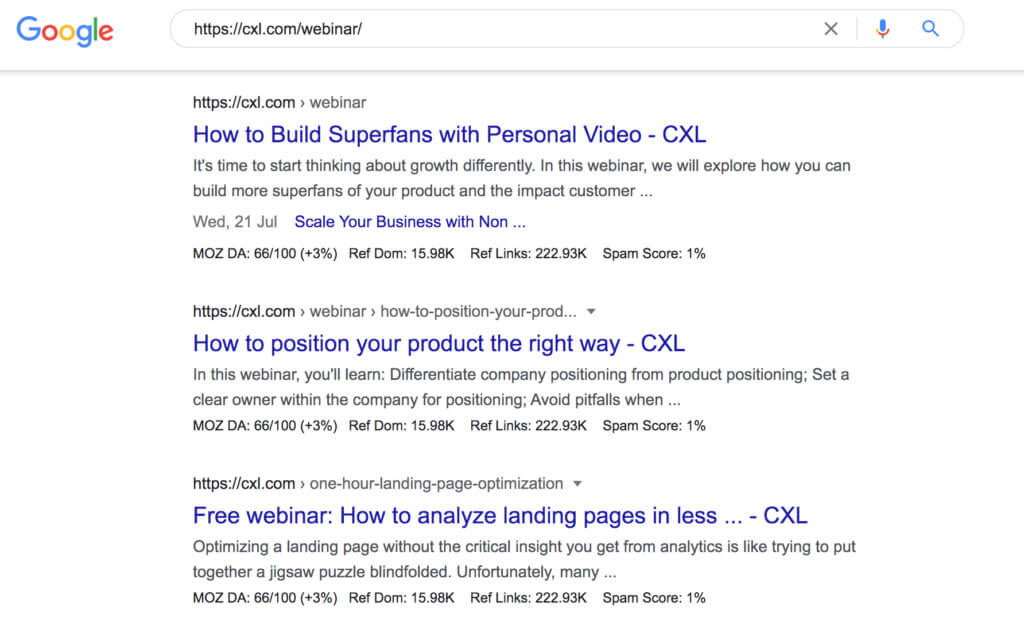

Auf CXL enthalten alle Seiten im Webinar-Hub den Unterordner /webinar/, damit Google erkennen kann, dass diese Seiten in die Kategorie „Webinar“ fallen:

Google erkennt das auch eindeutig so. Wenn Sie https://cxl.com/webinar/ in die Suchleiste eingeben, ruft Google relevante Webinar-Ergebnisse ab, die in diesen Ordner fallen:

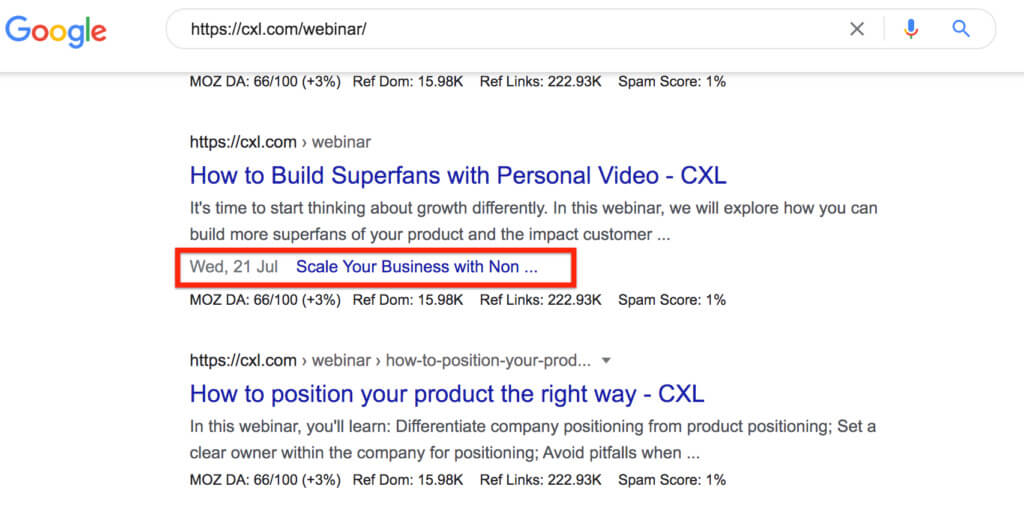

Seitenlinks innerhalb der Ergebnisse zeigen auch, dass Google die Kategorisierung erkennt:

3. Inhaltsqualität

Qualitativ hochwertiger Inhalt ist zweifellos einer der stärksten Vorzüge Ihrer Website. Aber es gibt auch eine technische Seite zum Inhalt.

Doppelte Inhalte

Das Erstellen von Originalinhalten in hoher Qualität ist eine Möglichkeit, um sicherzustellen, dass auf Websites keine Probleme mit doppelten Inhalten auftreten. Duplicate Content kann ein Problem sein, auch wenn der Standard allgemein hoch ist.

Wenn ein CMS mehrere Versionen derselben Seite auf verschiedenen URLs erstellt, zählt dies als Duplicate Content. Alle großen Websites haben irgendwo doppelten Inhalt – das Problem ist, wann der doppelte Inhalt indiziert wird.

Um zu vermeiden, dass doppelte Inhalte Ihren Rankings schaden, fügen Sie das noindex-Tag zu doppelten Seiten hinzu.

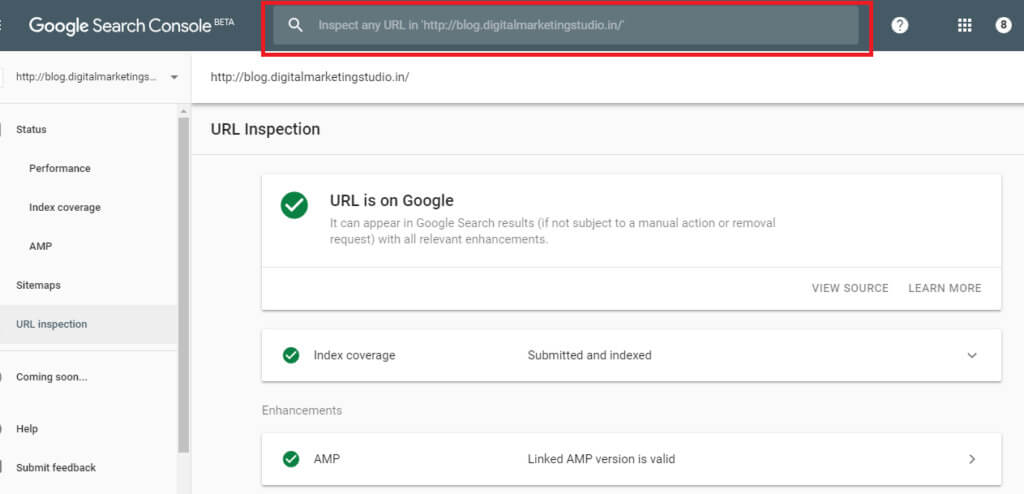

In der Google Search Console können Sie überprüfen, ob Ihre noindex-Tags eingerichtet sind, indem Sie URL prüfen verwenden:

Wenn Google Ihre Seite immer noch indexiert, wird die Meldung „URL ist für Google verfügbar“ angezeigt. Das würde bedeuten, dass Ihr noindex-Tag nicht korrekt eingerichtet wurde. Ein Popup-Fenster „Von noindex-Tag ausgeschlossen“ teilt Ihnen mit, dass die Seite nicht mehr indexiert ist.

Es kann einige Tage oder Wochen dauern, bis Google die Seiten, die Sie nicht indexieren möchten, erneut crawlt.

Verwenden Sie robots.txt

Wenn Sie auf Ihrer Website Beispiele für doppelten Inhalt finden, müssen Sie diese nicht löschen. Stattdessen können Sie Suchmaschinen daran hindern, sie zu crawlen und zu indizieren.

Erstellen Sie eine robots.txt-Datei, um Suchmaschinen-Crawler von Seiten zu blockieren, die Sie nicht mehr indizieren möchten. Dies können verwaiste Seiten oder Duplicate Content sein.

Kanonische URLs

Den meisten Webseiten mit Duplicate Content sollte einfach ein noindex-Tag hinzugefügt werden. Aber was ist mit diesen Seiten mit sehr ähnlichen Inhalten? Dies sind oft Produktseiten.

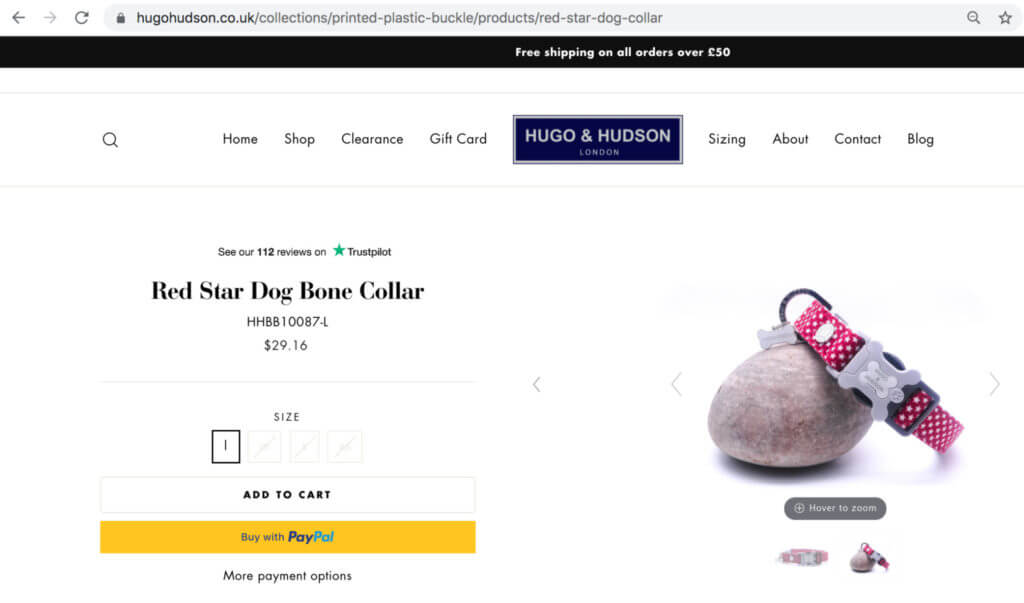

Zum Beispiel verkauft Hugo & Hudson Produkte für Hunde und hostet ähnliche Seiten mit leichten Abweichungen in Größe, Farbe und Beschreibung:

Ohne kanonische Tags würde das Auflisten desselben Produkts mit geringfügigen Abweichungen bedeuten, dass für jedes Produkt unterschiedliche URLs erstellt werden müssten.

Mit kanonischen Tags versteht Google, wie die primäre Produktseite von den Varianten sortiert wird, und geht nicht davon aus, dass Variantenseiten Duplikate sind.

4. Seitengeschwindigkeit

Die Seitengeschwindigkeit kann sich direkt auf das Ranking einer Seite auswirken. Wenn Sie sich nur auf ein Element der technischen SEO konzentrieren könnten, sollte das Verständnis, was zur Seitengeschwindigkeit beiträgt, ganz oben auf der Liste stehen.

Seitengeschwindigkeit und organischer Traffic

Eine schnell ladende Website ist nicht das einzige, was Sie für hochrangige Seiten benötigen, aber Google verwendet sie als Rankingfaktor.

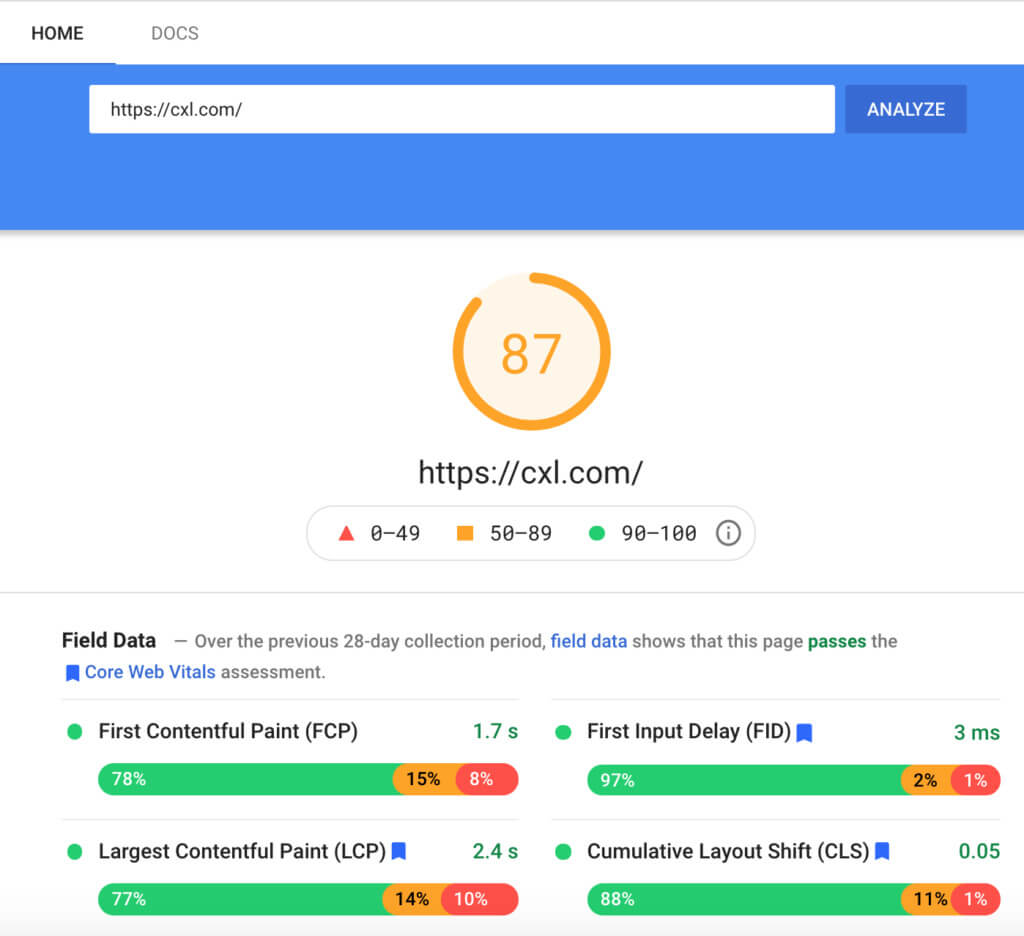

Mit Google PageSpeed Insights können Sie die Ladezeit Ihrer Website schnell einschätzen:

CDNs und Ladezeit

CDNs oder Content Delivery Networks reduzieren den gesamten Datentransfer zwischen dem Cache-Server des CDN und dem Suchenden. Da die Übertragung der Datei weniger Zeit in Anspruch nimmt, verringert sich die Wartezeit und die Seite wird schneller geladen.

Aber CDNs können getroffen und verfehlt werden. Wenn sie nicht richtig eingerichtet sind, können sie die Ladezeiten Ihrer Website sogar verlangsamen. Wenn Sie CDNs installieren, stellen Sie sicher, dass Sie Ihre Ladezeiten sowohl mit als auch ohne CDN mit webpagetest.org testen.

Mobile Reaktionsfähigkeit

Mobile Freundlichkeit ist mittlerweile ein wichtiger Rankingfaktor. Der Mobile-Friendly-Test von Google ist ein einfacher Usability-Test, um zu sehen, ob Ihre Webseiten funktionsfähig sind und eine gute UX auf einem Smartphone bieten.

Die Web-App hebt auch einige Dinge hervor, die Site-Manager tun können, um ihre Seiten zu verbessern.

Google empfiehlt beispielsweise die Verwendung von AMPs (Accelerated Mobile Pages), die darauf ausgelegt sind, Inhalte viel schneller auf Mobilgeräten bereitzustellen.

Weiterleitungen und Seitengeschwindigkeit

Weiterleitungen können Websites verbessern, indem sichergestellt wird, dass es keine defekten Links gibt, die zu Sackgassen führen, oder Probleme im Zusammenhang mit Link-Equity und -Juice. Viele Weiterleitungen führen jedoch dazu, dass Ihre Website langsamer geladen wird.

Je mehr Weiterleitungen, desto mehr Zeit verbringen Suchende damit, auf die gewünschte Zielseite zu gelangen.

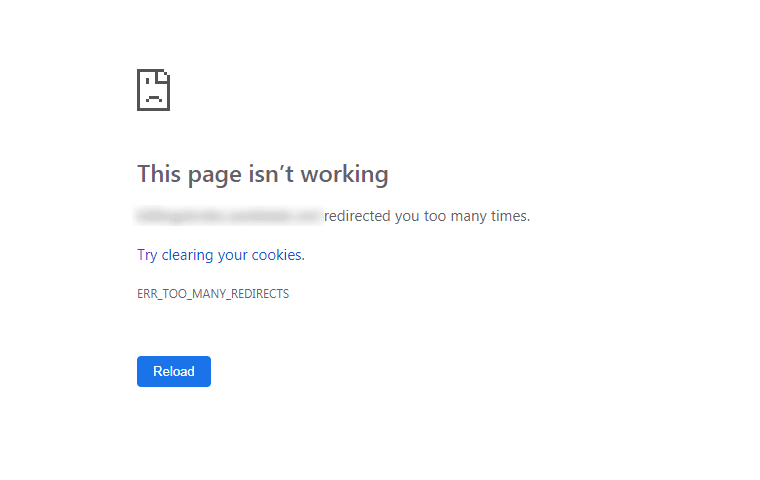

Da Weiterleitungen die Ladezeiten von Websites verlangsamen, ist es wichtig, die Anzahl der Seitenweiterleitungen gering zu halten. Weiterleitungsschleifen (d. h. wenn mehrere Weiterleitungen auf dieselbe Seite führen) verursachen ebenfalls Ladeprobleme und Fehlermeldungen:

Große Dateien und Ladezeit

Große Dateien wie hochauflösende Fotos und Videos brauchen länger zum Laden. Indem Sie sie komprimieren, können Sie die Ladezeit verkürzen und die allgemeine Benutzererfahrung verbessern.

Gängige Erweiterungen wie GIF, JPEG und PNG bieten viele Lösungen zum Komprimieren von Bildern.

Um Zeit zu sparen, versuchen Sie, Ihre Bilder in großen Mengen mit speziellen Komprimierungstools wie tinypng.com und compress.io zu komprimieren.

Streben Sie nach PNG-Bildformaten, da diese in der Regel das beste Verhältnis von Qualität zu Komprimierung erreichen.

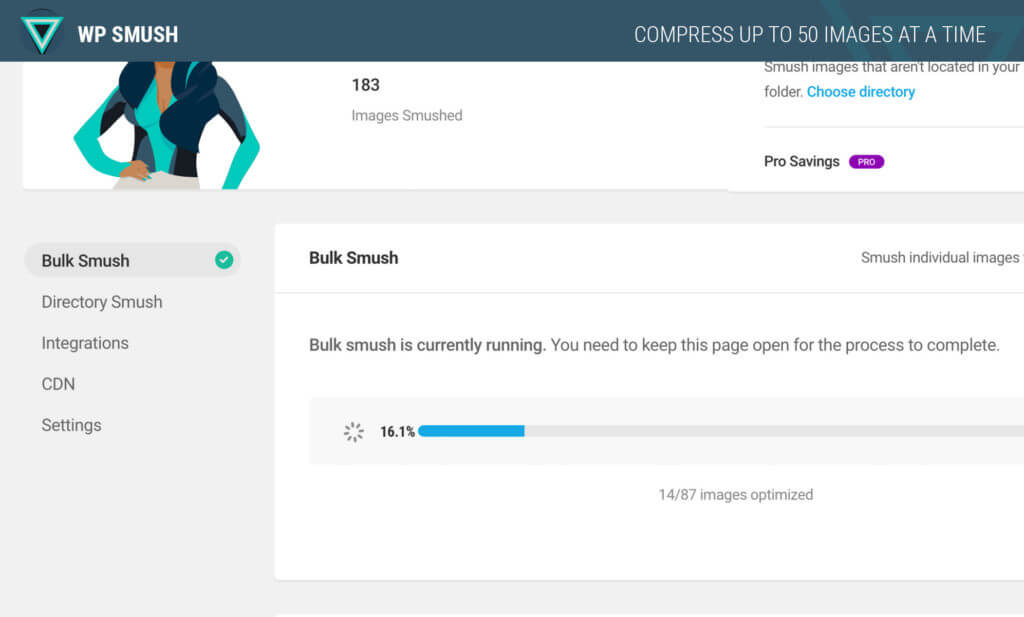

WordPress-Plugins wie SEO Friendly Images und Smush können Ihnen auch dabei helfen, Ihre Bilder zu komprimieren:

Wenn Sie Bildbearbeitungsplattformen verwenden, kann die Auswahl der Option „Für Web speichern“ dazu beitragen, dass die Bilder nicht zu groß sind.

Es ist jedoch ein Jonglierakt. Es ist alles sehr gut, all Ihre großen Dateien zu komprimieren, aber wenn es die Benutzererfahrung negativ beeinflusst, indem eine Webseite mit schlechter Qualität angezeigt wird, wäre es besser, die Dateien gar nicht erst zu komprimieren.

Cache-Plugins und Speichern von Ressourcen

Der Browser-Cache spart Ressourcen auf dem Computer eines Besuchers, wenn er neue Websites besucht. Wenn sie zum zweiten Mal zurückkehren, liefern diese eingesparten Ressourcen die benötigten Informationen schneller.

Durch die Kombination des Cachings von W3 Total Cache und der Komprimierung von Autoptimize können Sie Ihre Cache-Leistung und Ladezeit verbessern.

Plugins

Es ist einfach, mehrere Plugins zu Ihrer Website hinzuzufügen – aber achten Sie darauf, sie nicht zu überladen, da sie die Ladezeit Ihrer Seiten um Sekunden verlängern können.

Das Entfernen von Plugins, die keinen wichtigen Zweck erfüllen, trägt dazu bei, die Ladezeit Ihrer Seite zu verbessern. Beschränken Sie Ihre Website darauf, nur Plugins auszuführen, die eine Menge Wert hinzufügen.

Sie können mit Google Analytics überprüfen, ob Plugins wertvoll oder überflüssig sind. Deaktivieren Sie Plug-ins in einer Testumgebung manuell (eines nach dem anderen) und testen Sie die Ladegeschwindigkeit.

Sie können auch Live-Tests durchführen, um zu sehen, ob sich das Deaktivieren bestimmter Plugins auf Conversions auswirkt. Beispielsweise das Deaktivieren eines Opt-in-Box-Plug-ins und das Messen, ob sich dies auf die Opt-in-Rate auswirkt.

Verwenden Sie alternativ ein Tool wie Pingdom-Tools, um zu messen, ob Plugins die Ladegeschwindigkeit beeinflussen.

Skripte von Drittanbietern

Im Durchschnitt verlängert jedes Drittanbieter-Skript die Ladezeit der Seite um weitere 34 Sekunden.

Während einige Skripte wie Google Analytics erforderlich sind, hat sich auf Ihrer Website möglicherweise Skripts von Drittanbietern angesammelt, die leicht entfernt werden könnten.

Dies passiert häufig, wenn Sie Ihre Website aktualisieren und veraltete Assets nicht entfernen. Artefakte aus alten Iterationen verschwenden Ressourcen und beeinträchtigen Geschwindigkeit und UX. Sie können ein Tool wie Purify CSS verwenden, um unnötiges CSS zu entfernen, oder sicherstellen, dass Ihre Entwickler es regelmäßig überprüfen und bereinigen.

Fazit

Die Optimierung der technischen Suchmaschinenoptimierung ist kein einheitlicher Prozess. Es gibt Elemente, die für einige Websites sinnvoll sind, aber nicht für alle, und dies hängt von Ihrer Zielgruppe, der erwarteten Benutzererfahrung, der Customer Journey, den Zielen und dergleichen ab.

Indem Sie die Grundlagen hinter technischem SEO lernen, werden Sie mit größerer Wahrscheinlichkeit Webseiten für Google und Besucher gleichermaßen erstellen und optimieren. Sie werden auch in der Lage sein, technische SEO-Audits durchzuführen oder die Methoden eines Profis zu verstehen.

Sind Sie bereit, die Konkurrenz mit technischem SEO zu überflügeln? Melden Sie sich noch heute für den technischen SEO-Kurs von CXL an.