テクニカルSEOの詳細ガイド

公開: 2021-07-16キーワード調査、高品質のコンテンツ、リンク構築、ページ上のSEO-これらの戦術は、オーガニックランキングの向上に役立ちます。 しかし、検索エンジン最適化戦略は、これまでのところあなたを連れて行くだけです。

あなたの技術的なSEOの家を整頓することは、サイトランキングのパズルの最後のピースです。

テクニカルSEOとは、検索者に最高品質のWebエクスペリエンスを提供することです。 人々は、高速読み込みのWebページ、安定したグラフィック、および操作しやすいコンテンツを求めています。

この記事では、技術的なSEOとは何か、そしてそれがWebサイトの成長にどのように影響するかを探ります。

テクニカルSEOとは何ですか(そしてそれは成長にどのように影響しますか)?

テクニカルSEOは、オーガニックランキングを向上させるために、ウェブサイトが検索エンジンの技術的要件を満たしていることを確認するプロセスです。 Webサイトの特定の要素を改善することで、検索エンジンのスパイダーがWebページをより簡単にクロールしてインデックスに登録できるようになります。

強力な技術的SEOは、ユーザーエクスペリエンスの向上、コンバージョンの増加、サイトの権限の強化にも役立ちます。

テクニカルSEOの重要な要素は次のとおりです。

- クロール

- インデックス作成

- レンダリング

- サイトアーキテクチャ

検索の意図に答え、価値を提供し、バックリンクが豊富な高品質のコンテンツであっても、適切な技術的SEOが実施されていないとランク付けするのは困難です。 グーグルの生活を楽にするほど、あなたのサイトはランク付けされる可能性が高くなります。

システムの応答速度は、人間が相互作用するときに経験する遅延を模倣する必要があることが示唆されています。 つまり、ページの応答には約1〜4秒かかるはずです。

サイトの読み込みに4秒以上かかると、人々は興味を失い、跳ね返る可能性があります。

ページ速度はユーザーエクスペリエンスに影響を与えるだけでなく、eコマースサイトの売上にも影響を与える可能性があります。

キット・イートンがFast Companyで有名に書いたように、

「 Amazonは、ページの読み込みがわずか1秒遅くなると、毎年16億ドルの売り上げが発生する可能性があると計算しました。 Googleは、検索結果を10分の4秒遅くすると、1日あたり800万回の検索が失われる可能性があると計算しています。つまり、提供されるスポンサー付き広告は数百万回少なくなります。 」

読み込みの遅いサイトは、技術的なSEOの1つの要素にすぎず、ビジネスの成長に直接影響を与える可能性があることを証明します。

技術的なSEOコンサルタントを使用する必要がありますか、それとも独自の監査を行う必要がありますか?

数か月ごとに技術的なSEO監査を実施する必要があります。 これは、技術的要因(これから詳しく説明します)、サイトコンテンツなどのページ上の要因、および被リンクなどのページ外の要因を監視するのに役立ちます。

Ahrefsのようなツールを使用すると、独自の監査を簡単に実行できます。 彼らはまた、技術的なSEOコンサルタントを雇うよりも安くて速いです。 コンサルタントは監査を完了するのに数週間または数か月かかる場合がありますが、自分で実施する場合は数時間または数日かかる場合があります。

とはいえ、経験豊富なコンサルタントからの専門家の洞察は、次の場合に重要になる可能性があります。

- 新しいWebサイトを展開していて、正しく設定されていることを確認したい

- 古いサイトを新しいサイトに置き換えており、シームレスな移行を保証したい

- 複数のウェブサイトを持っていて、それらを個別に最適化するか、それらをマージするかについての洞察が必要です

- Webページを複数の言語で実行し、各バージョンが適切に設定されていることを確認する

いずれにせよ、技術的なSEOを正しく行うには、基本を十分に理解することを優先します。

1.クロールとインデックス作成

検索エンジンは、Webページを識別、クロール、レンダリング、およびインデックス付けできる必要があります。

ウェブサイトのアーキテクチャ

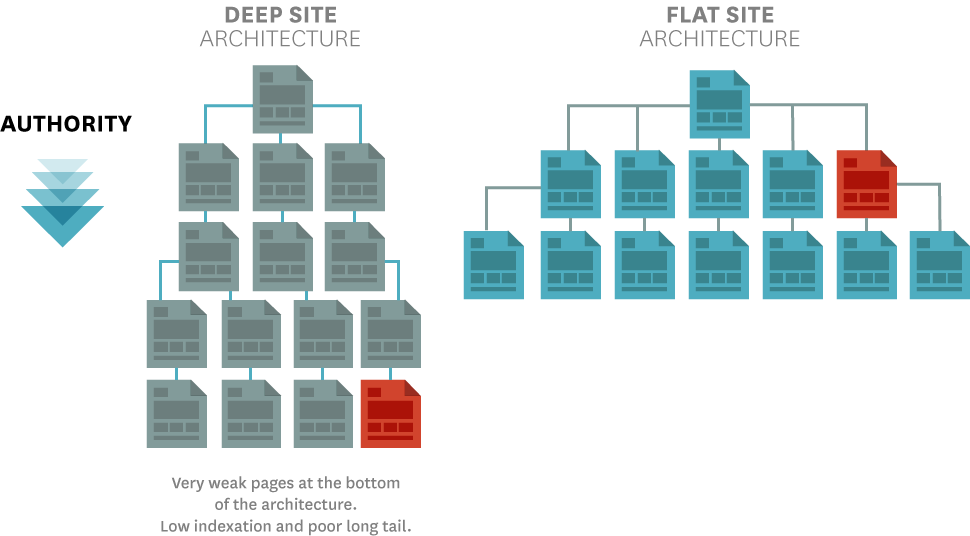

ホームページに明確に接続されていないWebページは、検索エンジンが識別しにくいものです。

ホームページのインデックスを作成するのに問題はないでしょう。 ただし、ホームページから数回クリックするだけのページでは、さまざまな理由でクロールとインデックス作成の問題が発生することがよくあります。特に、それらを指す内部リンクが少なすぎる場合はそうです。

Webページが互いに明確にリンクされているフラットなWebサイトアーキテクチャは、この結果を回避するのに役立ちます。

関連するページへの内部リンクを備えたピラーページ構造を使用すると、検索エンジンがサイトのコンテンツのインデックスを作成するのに役立ちます。 ホームページは多くの場合、より高いページ権限を持っているため、ホームページを接続すると、クロール検索エンジンスパイダーがページを見つけやすくなります。

XMLサイトマップ

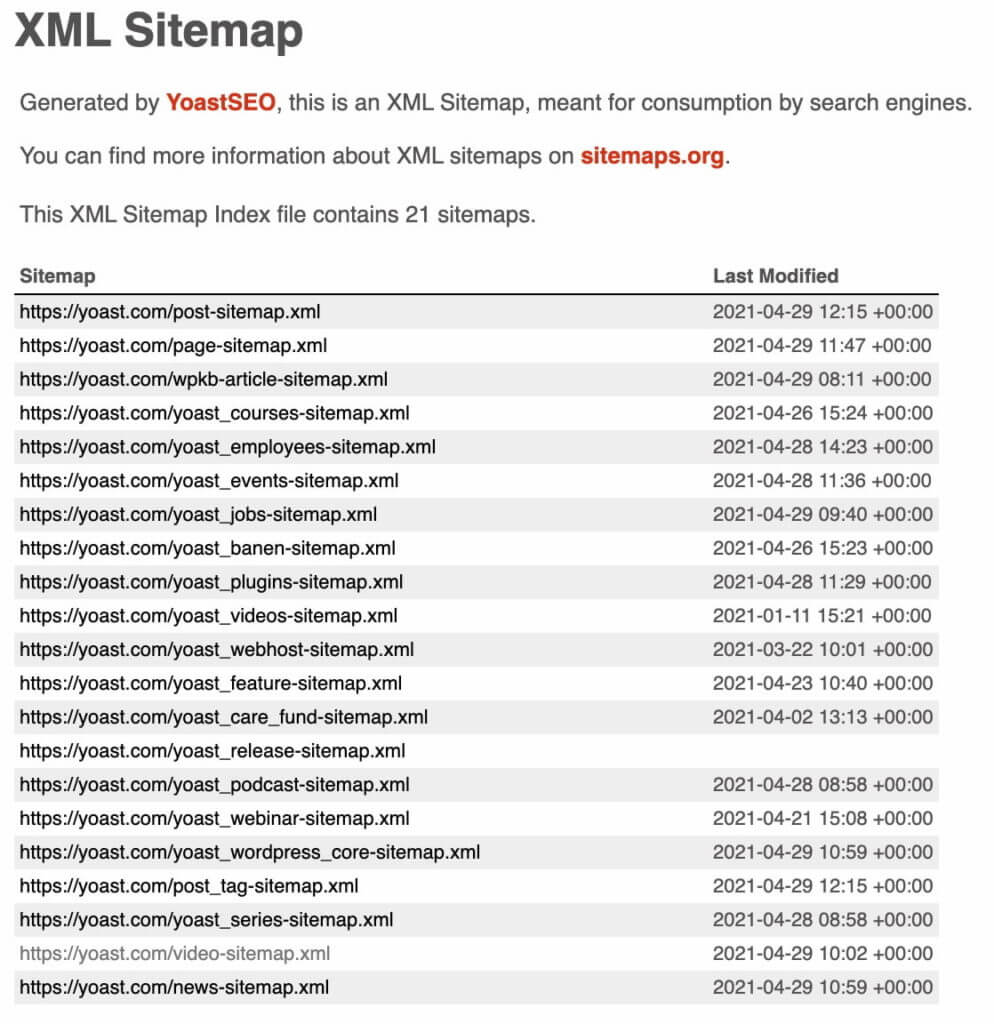

XMLサイトマップは、サイトで最も重要なすべてのページのリストを提供します。 モバイルの応答性やその他のランキング要素の代わりに冗長に見えるかもしれませんが、Googleは依然としてそれらを重要であると考えています。

XMLサイトマップは次のことを示しています。

- ページが最後に変更されたのはいつ

- ページが更新される頻度

- あなたのサイトの優先ページ

Google検索コンソール内で、サイトをクロールするときに検索エンジンが表示するXMLサイトマップを確認できます。 Yoast.comのXMLサイトマップは次のとおりです。

次のツールを使用して、クロールエラーを定期的にチェックし、Webページが検索エンジンスパイダーによってインデックスに登録されているかどうかを確認します。

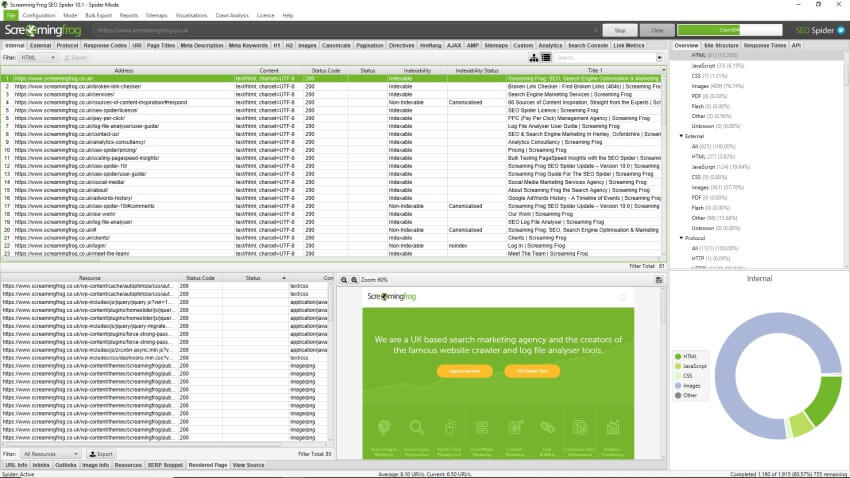

悲鳴を上げるカエル

Screaming Frogは、インデックス作成とクロールの問題を特定するための業界のゴールドスタンダードです。

実行すると、サイトからデータが抽出され、リダイレクトやURLの破損などの一般的な問題がないか監査されます。 これらの洞察を使用して、404の壊れたリンクを修正するなどの迅速な変更を行ったり、サイト全体のメタ記述の更新などのより長い修正を計画したりできます。

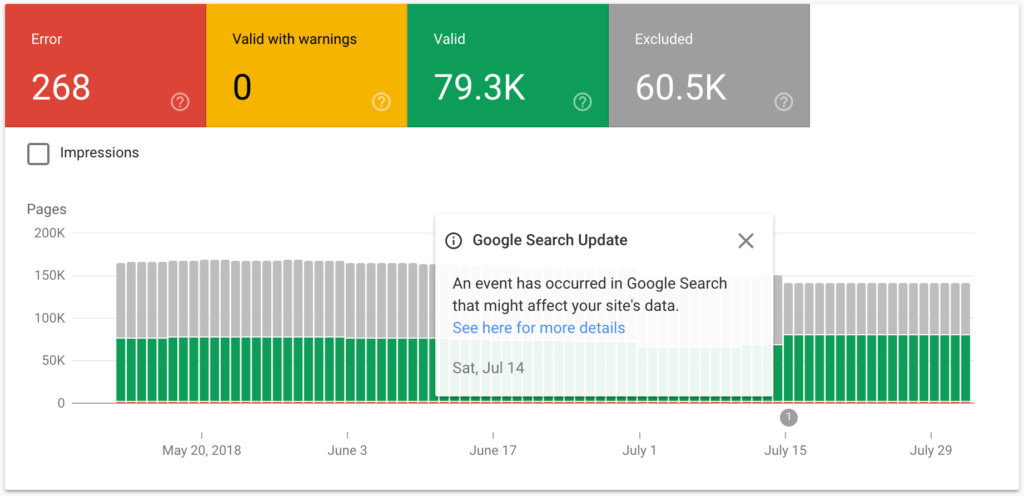

カバレッジレポートとGoogle検索コンソールを使用したインデックスの確認

Google Search Consoleには、検出する必要のあるページをGoogleが完全にインデックスに登録またはレンダリングできないかどうかを通知する便利なカバレッジレポートがあります。

時々、ウェブページはグーグルによって索引付けされるかもしれませんが、間違ってレンダリングされます。 つまり、Googleはページのインデックスを作成できますが、コンテンツの100%をクロールしているわけではありません。

2.サイト構造

サイト構造は、他のすべての技術要素の基盤です。 これは、URL構造とrobots.txtに影響を与えます。これにより、検索エンジンがクロールできるページと無視するページを決定できます。

クロールとインデックス作成の問題の多くは、よく考えられていないWebサイト構造の結果です。 Googleと検索者の両方が簡単にナビゲートできる明確なサイト構造を構築できれば、後でクロールやインデックス作成の問題が発生することはありません。

要するに、単純なWebサイト構造は、他の技術的なSEOタスクに役立ちます。

きちんとしたサイト構造はWebページを論理的にリンクするので、人間も検索エンジンもページの順序について混乱することはありません。

孤立したページとは、内部リンクがないために他のページから切り離されたページです。 サイト管理者は、検索エンジンによってクロールおよびインデックス作成されないことに対して脆弱であるため、これらを回避する必要があります。

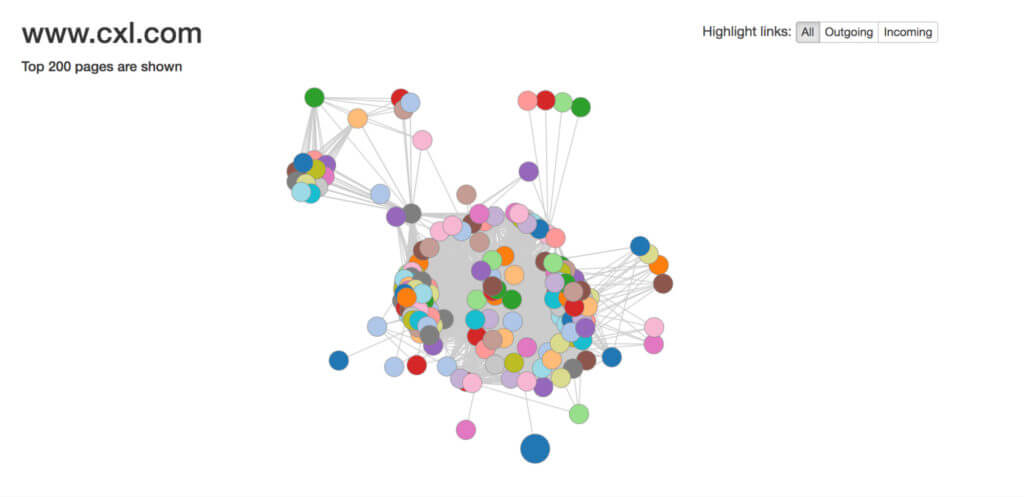

Visual Site Mapperのようなツールは、サイトの構造を明確に確認し、ページが相互にどの程度リンクされているかを評価するのに役立ちます。 強固な内部リンク構造は、Googleのコンテンツとユーザーの関係を示しています。

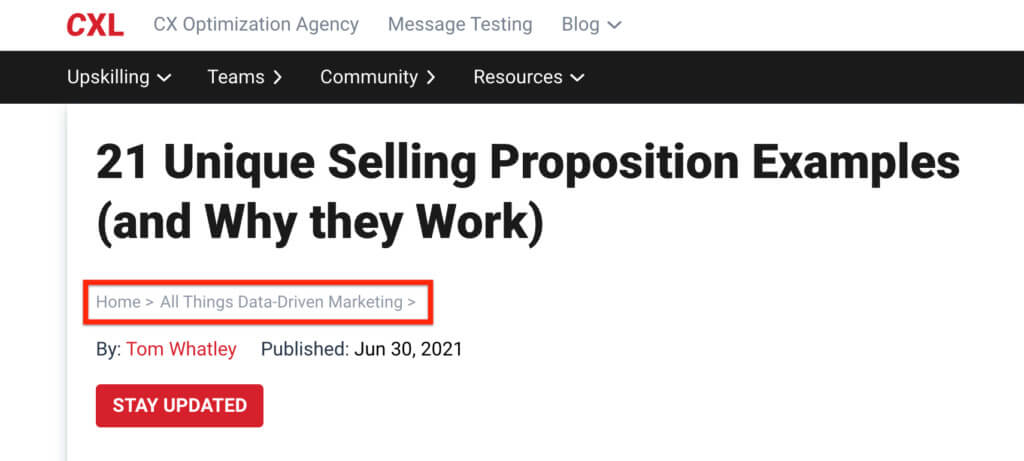

パンくずナビゲーション

パンくずナビゲーションは、検索エンジンやユーザーが期待できるコンテンツの種類について多くの手がかりを残すことに相当します。

ブレッドクラムナビゲーションは、サイトのサブページへの内部リンクを自動的に追加します。

これにより、サイトのアーキテクチャが明確になり、人間や検索エンジンが探しているものを簡単に見つけることができます。

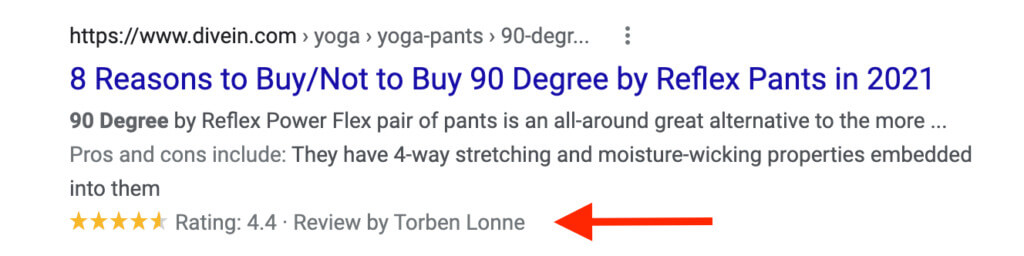

構造化データ

構造化データマークアップコードを使用すると、検索エンジンがコンテンツをよりよく理解するのに役立ちます。 ボーナスとして、それはまたあなたがより多くの検索者があなたのサイトにクリックスルーすることを奨励することができるリッチスニペットで紹介されることを可能にします。

Googleのレビューリッチスニペットの例を次に示します。

Googleの構造化データマークアップヘルパーを使用して、新しいタグを作成できます。

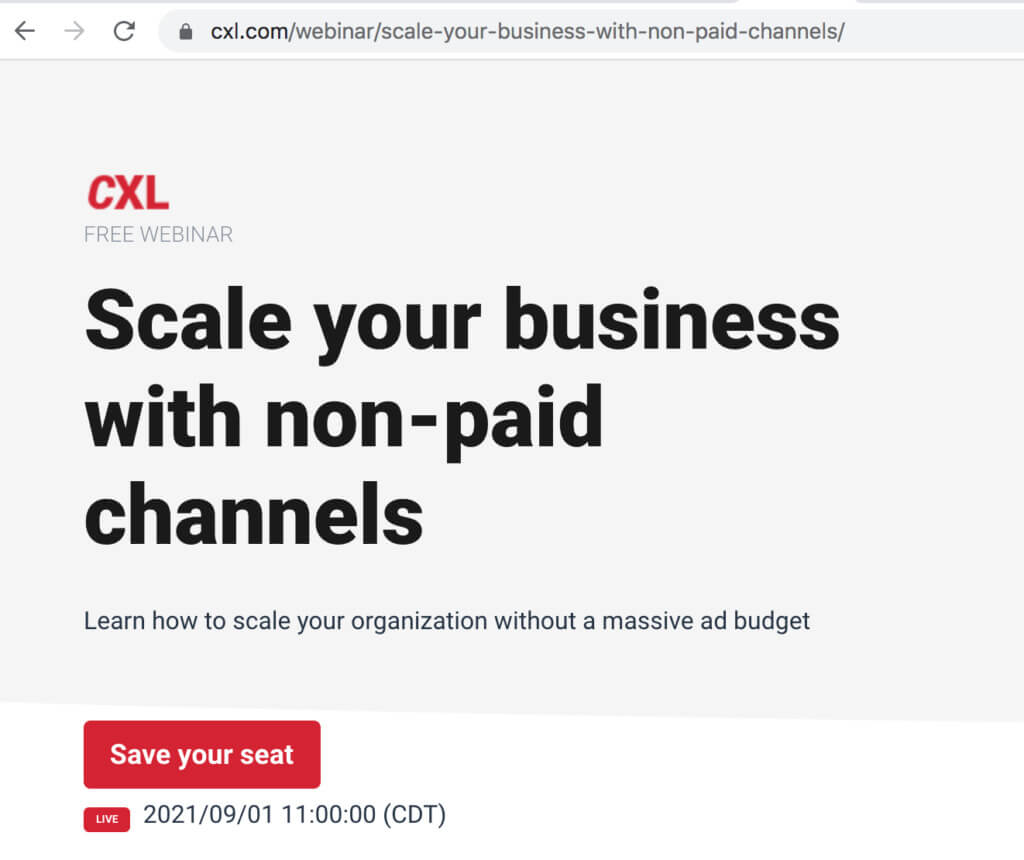

URL構造

一見ランダムな数字、文字、特殊文字を特徴とする長く複雑なURLは、ユーザーと検索エンジンを混乱させます。

URLは、単純で一貫性のあるパターンに従う必要があります。 そうすれば、ユーザーと検索エンジンは自分がサイトのどこにいるかを簡単に理解できます。

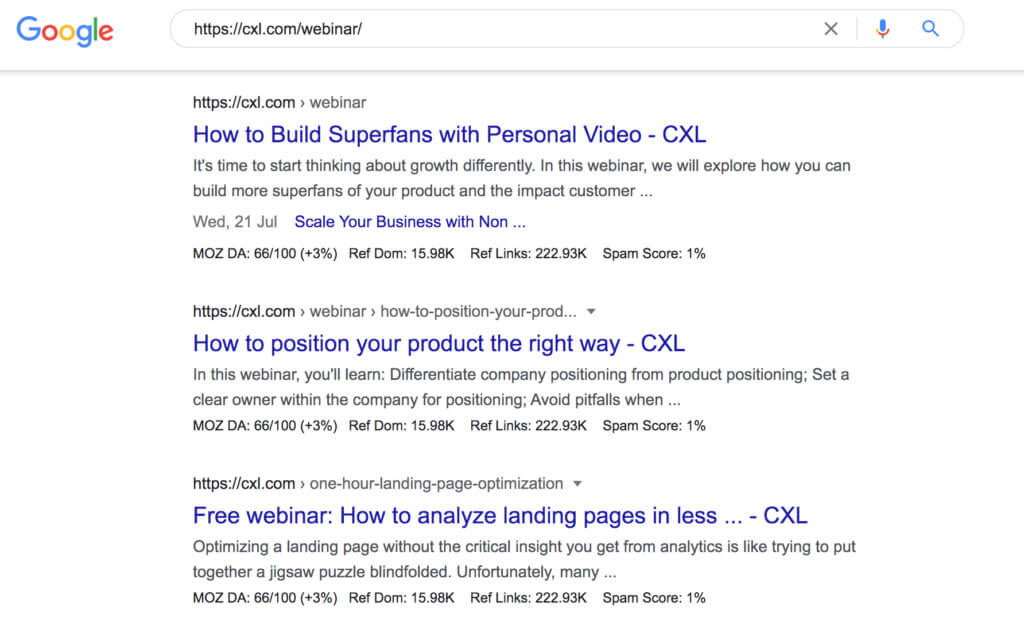

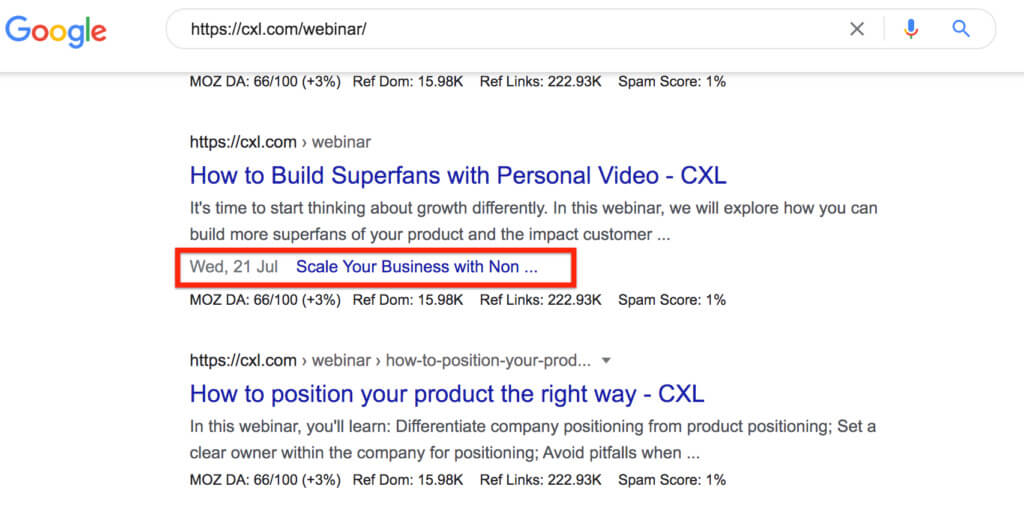

CXLでは、ウェビナーハブのすべてのページに/ webinar / subfolderが含まれており、これらのページが「ウェビナー」カテゴリに分類されることをGoogleが認識できるようになっています。

グーグルもこのようにはっきりと認識しています。 検索バーにhttps://cxl.com/webinar/と入力すると、Googleは次のフォルダーに分類される関連するウェビナーの結果を表示します。

結果内のサイトリンクは、Googleが分類を認識していることも示しています。

3.コンテンツの品質

高品質のコンテンツは間違いなくあなたのサイトの最も強力な資産の1つです。 しかし、コンテンツには技術的な側面もあります。

重複するコンテンツ

オリジナルの高品質なコンテンツを作成することは、サイトで重複コンテンツの問題が発生しないようにする1つの方法です。 重複するコンテンツは、標準が一般的に高い場合でも問題になる可能性があります。

CMSが異なるURLに同じページの複数のバージョンを作成する場合、これは重複コンテンツとしてカウントされます。 すべての大規模なサイトには、どこかに重複コンテンツがあります。問題は、重複コンテンツがインデックスに登録される場合です。

重複するコンテンツがランキングに悪影響を与えないようにするには、重複するページにnoindexタグを追加します。

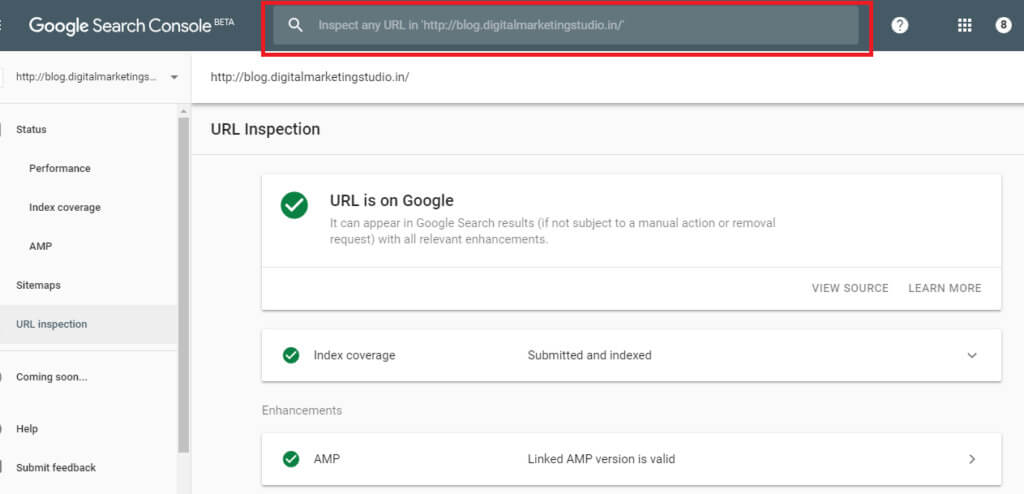

Google Search Console内で、Inspect URLを使用して、noindexタグが設定されているかどうかを確認できます。

Googleがまだページのインデックスを作成している場合は、「URLはGoogleで利用可能です」というメッセージが表示されます。 これは、noindexタグが正しく設定されていないことを意味します。 「noindexタグで除外」ポップアップは、ページがインデックスに登録されなくなったことを示します。

Googleは、インデックスに登録したくないページを再クロールするのに数日または数週間かかる場合があります。

robots.txtを使用する

サイトで重複コンテンツの例を見つけた場合、それらを削除する必要はありません。 代わりに、検索エンジンによるクロールとインデックス作成をブロックできます。

robots.txtファイルを作成して、インデックスを作成する必要がなくなったページから検索エンジンのクローラーをブロックします。 これらは孤立したページまたは重複したコンテンツである可能性があります。

正規URL

コンテンツが重複しているほとんどのWebページには、noindexタグを追加するだけです。 しかし、非常によく似たコンテンツが含まれているページについてはどうでしょうか。 これらは多くの場合、製品ページです。

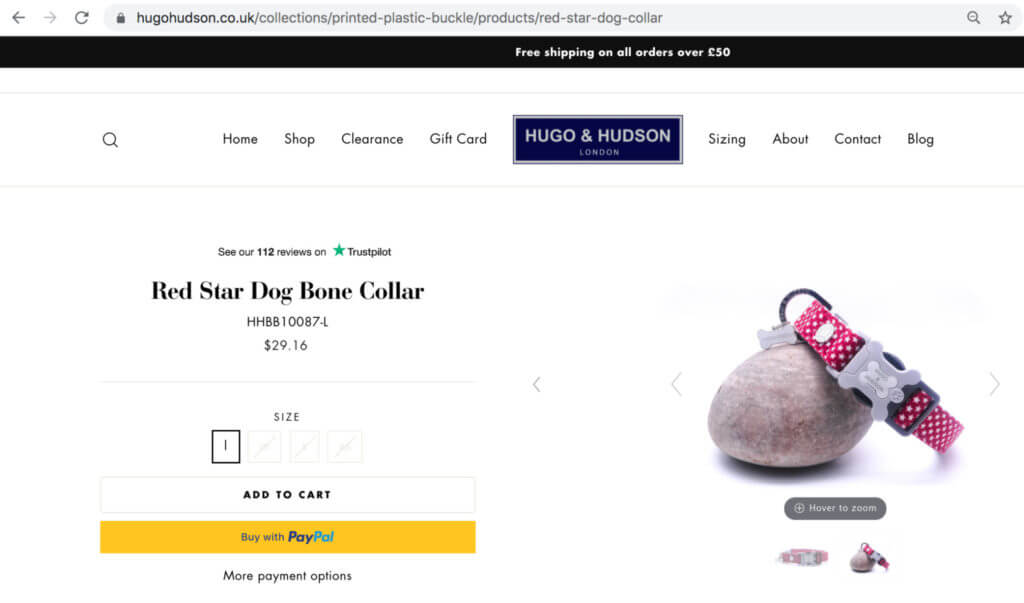

たとえば、Hugo&Hudsonは犬向けの製品を販売しており、サイズ、色、説明がわずかに異なる同様のページをホストしています。

正規のタグがない場合、わずかなバリエーションで同じ商品をリストすると、商品ごとに異なるURLを作成することになります。

正規タグを使用すると、Googleはバリエーションから主要な商品ページを並べ替える方法を理解し、バリエーションページが重複しているとは想定しません。

4.サイトの速度

ページ速度は、ページのランキングに直接影響する可能性があります。 技術的なSEOの1つの要素にのみ焦点を当てることができる場合は、ページ速度に寄与するものを理解することがリストの一番上にあるはずです。

ページ速度とオーガニックトラフィック

上位のページに必要なのは高速読み込みサイトだけではありませんが、Googleはそれをランキング要素として使用しています。

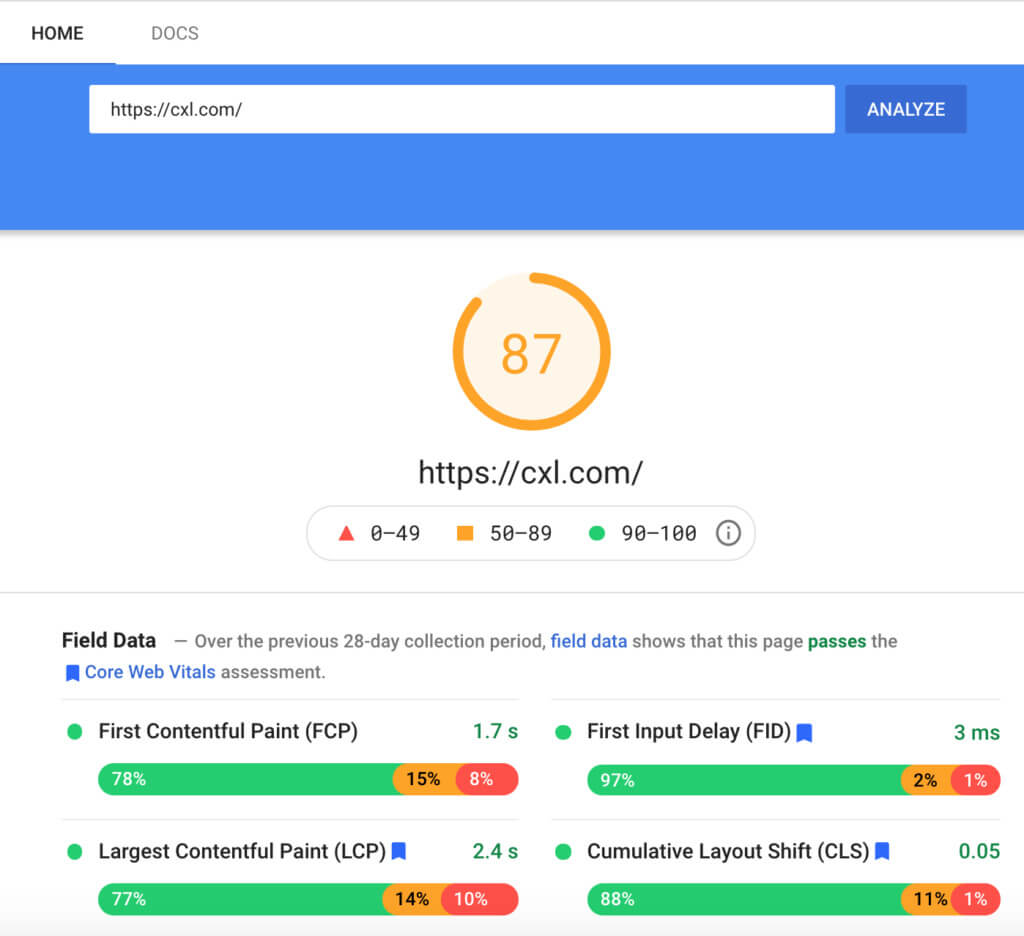

Google PageSpeed Insightsを使用すると、ウェブサイトの読み込み時間をすばやく評価できます。

CDNとロード時間

CDNまたはコンテンツ配信ネットワークは、CDNのキャッシュサーバーとサーチャー間の全体的なデータ転送を削減します。 ファイルの転送にかかる時間が短くなるため、待機時間が短縮され、ページの読み込みが速くなります。

しかし、CDNはヒットしたりミスしたりする可能性があります。 それらが適切に設定されていない場合、実際にはWebサイトの読み込み時間が遅くなる可能性があります。 CDNをインストールする場合は、webpagetest.orgを使用して、CDNがある場合とない場合の両方でロード時間をテストしてください。

モバイルの応答性

モバイルフレンドリーは現在、重要なランキング要素です。 Googleのモバイルフレンドリーテストは、ウェブページが機能していてスマートフォンで優れたUXを提供しているかどうかを確認するための簡単なユーザビリティテストです。

Webアプリは、サイト管理者がページを改善するために実行できるいくつかのことも強調しています。

たとえば、モバイルデバイスにコンテンツをはるかに高速に配信するように設計されたAMP(Accelerated Mobile Pages)を使用することをお勧めします。

リダイレクトとページ速度

リダイレクトは、行き止まりのページにつながる壊れたリンクや、リンクの公平性とジュースを取り巻く問題がないことを確認することで、サイトを改善できます。 ただし、リダイレクトが多いと、Webサイトの読み込みが遅くなります。

リダイレクトが多いほど、検索者が目的のランディングページに到達するために費やす時間が長くなります。

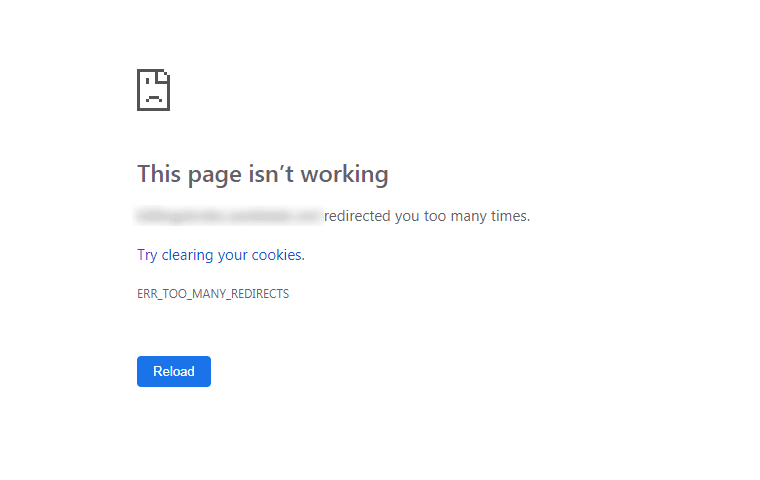

リダイレクトによってウェブサイトの読み込み時間が遅くなるため、ページリダイレクトの数を低く抑えることが重要です。 リダイレクトループ(つまり、複数のリダイレクトが同じページにつながる場合)も、読み込みの問題とエラーメッセージを引き起こします。

大きなファイルと読み込み時間

高解像度の写真やビデオなどの大きなファイルサイズは、読み込みに時間がかかります。 それらを圧縮することで、読み込み時間を短縮し、全体的なユーザーエクスペリエンスを向上させることができます。

GIF、JPEG、PNGなどの一般的な拡張機能には、画像を圧縮するための多くのソリューションがあります。

時間を節約するには、tinypng.comやcompressor.ioなどの専用の圧縮ツールを使用して画像をまとめて圧縮してみてください。

圧縮率に対する最高の品質を達成する傾向があるため、PNG画像形式を目指してください。

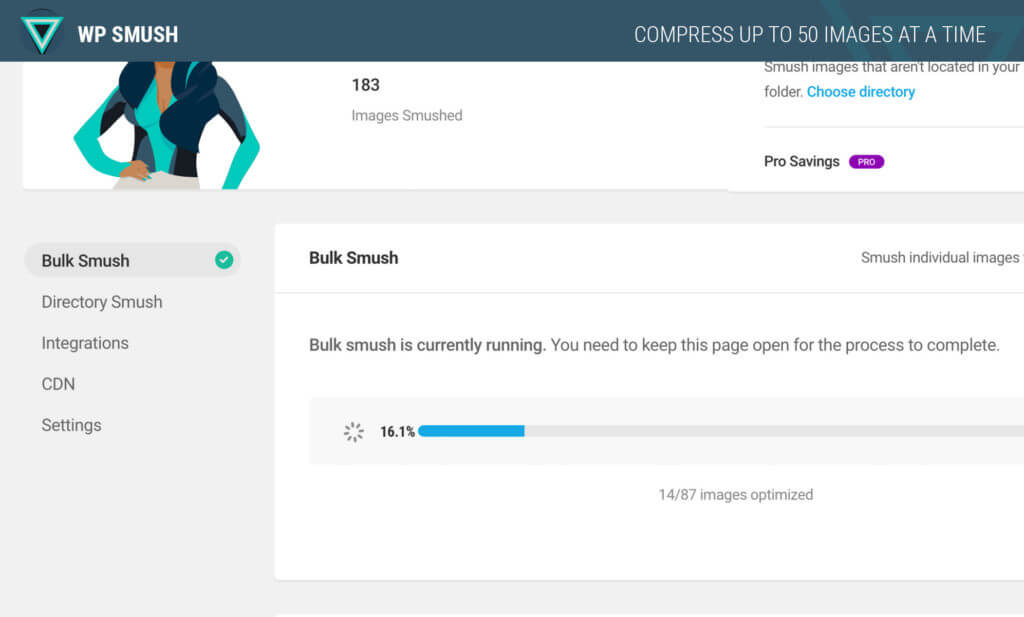

SEO Friendly ImagesやSmushなどのWordPressプラグインも、画像を圧縮する方法をガイドします。

画像編集プラットフォームを使用する場合、[Web用に保存]オプションを選択すると、画像が大きくなりすぎないようにすることができます。

しかし、それはジャグリング行為です。 すべての大きなファイルを非常によく圧縮しますが、質の悪いWebページを表示することでユーザーエクスペリエンスに悪影響を与える場合は、そもそもファイルを圧縮しない方がよいでしょう。

プラグインのキャッシュとリソースの保存

ブラウザのキャッシュは、訪問者が新しいWebサイトに頻繁にアクセスするときに、訪問者のコンピュータのリソースを節約します。 彼らが再び戻ったとき、これらの節約されたリソースはより速い速度で必要な情報を提供します。

W3 Total CacheのキャッシュとAutoptimizeの圧縮を組み合わせると、キャッシュのパフォーマンスとロード時間を改善できます。

プラグイン

サイトに複数のプラグインを追加するのは簡単ですが、ページの読み込み時間が数秒長くなる可能性があるため、プラグインをオーバーロードしないように注意してください。

重要な目的を果たさないプラグインを削除すると、ページの読み込み時間を改善するのに役立ちます。 大量の価値を追加するプラグインのみを実行するようにサイトを制限します。

プラグインが価値があるか冗長であるかは、GoogleAnalyticsで確認できます。 テスト環境では、プラグインを手動でオフにして(一度に1つずつ)、ロード速度をテストします。

ライブテストを実行して、特定のプラグインを無効にするとコンバージョンに影響するかどうかを確認することもできます。 たとえば、オプトインボックスプラグインをオフにして、それがオプトイン率に影響するかどうかを測定します。

または、Pingdomツールなどのツールを使用して、プラグインが読み込み速度に影響を与えているかどうかを測定します。

サードパーティのスクリプト

平均して、各サードパーティスクリプトはページの読み込み時間に34秒を追加します。

Google Analyticsのようないくつかのスクリプトが必要ですが、サイトには、簡単に削除できるサードパーティのスクリプトが蓄積されている場合があります。

これは、サイトを更新し、無効なアセットを削除しない場合によく発生します。 古いイテレーションからのアーティファクトはリソースを浪費し、速度とUXに影響を与えます。 Purify CSSなどのツールを使用して、不要なCSSを削除したり、開発者が一貫してチェックしてパージしたりすることができます。

結論

技術的なSEOを最適化することは、万能のプロセスではありません。 一部のWebサイトには意味のある要素がありますが、すべてではありません。これは、オーディエンス、期待されるユーザーエクスペリエンス、カスタマージャーニー、目標などによって異なります。

技術的なSEOの背後にある基礎を学ぶことにより、Googleと訪問者の両方のためにWebページを作成して最適化する可能性が高くなります。 また、技術的なSEO監査を実行したり、専門家の方法を理解したりすることもできます。

テクニカルSEOとの競争を上回る準備はできていますか? 今すぐCXLテクニカルSEOコースにサインアップしてください。