Comment mener un audit SEO technique

Publié: 2022-04-12Les éléments techniques du référencement de votre site Web sont cruciaux pour les performances de recherche. Comprenez-les et maintenez-les et votre site Web peut se classer en bonne place, générer du trafic et aider à augmenter les ventes. Si vous les négligez, vous courez le risque que des pages n'apparaissent pas dans les SERP.

Dans cet article, vous apprendrez à effectuer un audit SEO technique pour trouver et résoudre les problèmes dans la structure de votre site Web. Nous examinerons les principaux facteurs de classement, notamment le contenu, la vitesse, la structure et la compatibilité avec les mobiles, pour nous assurer que votre site peut être exploré et indexé.

Nous vous montrerons également les outils dont vous avez besoin pour améliorer les efforts et les performances de référencement sur la page et hors page, et comment les utiliser.

Utiliser un audit SEO technique pour améliorer vos performances SEO

Considérez un audit SEO technique comme un bilan de santé d'un site Web. Tout comme vous examinez périodiquement vos campagnes de marketing numérique pour en tirer le meilleur parti, un audit technique SEO évalue les performances du site pour identifier les domaines à améliorer.

Ces domaines se répartissent en trois catégories :

1. Erreurs techniques

Identifier les drapeaux rouges à l'arrière et à l'avant de votre site Web qui ont un impact négatif sur les performances et, par conséquent, sur votre référencement. Les erreurs techniques incluent les problèmes d'exploration, les liens rompus, la lenteur de la vitesse du site et le contenu dupliqué. Nous allons examiner chacun d'eux dans cet article.

2. Erreurs UX

L'expérience utilisateur (UX) a tendance à être considérée davantage comme un problème de conception que comme un problème de référencement. Cependant, la structure de votre site Web aura un impact sur les performances de référencement.

Pour mieux comprendre quelles pages sont importantes et lesquelles sont moins prioritaires, Google utilise un algorithme appelé Page Importance.

L'importance de la page est déterminée par le type de page, les liens internes et externes, la fréquence de mise à jour et votre plan de site. Plus important encore du point de vue UX, cependant, il est déterminé par la position de la page. En d'autres termes, où la page se trouve sur votre site.

Cela fait de l'architecture du site Web un facteur SEO technique important. Plus il est difficile pour un utilisateur de trouver une page, plus il faudra de temps à Google pour la trouver. Idéalement, un utilisateur devrait pouvoir se rendre là où en aussi peu de clics que possible.

Un audit SEO technique résout les problèmes de structure et d'accessibilité du site qui les empêchent de le faire.

3. Opportunités de classement

C'est là que le référencement technique rencontre le référencement sur la page. En plus de prioriser les pages clés dans l'architecture de votre site, un audit permet de convaincre Google de l'importance d'une page en :

- Identifier et fusionner du contenu ciblant des mots-clés identiques ou similaires ;

- Suppression du contenu en double qui dilue l'importance, et ;

- Améliorer les métadonnées afin que les utilisateurs voient ce qu'ils recherchent dans les pages de résultats des moteurs de recherche (SERP).

Il s'agit d'aider Google à mieux comprendre votre site Web afin que les pages s'affichent pour les bonnes recherches.

Comme pour tout type de bilan de santé, un audit SEO technique ne devrait pas être une chose unique. Elle doit être effectuée lors de la création ou de la refonte de votre site Web, après tout changement de structure et périodiquement.

La règle générale est de réaliser un mini-audit tous les mois et un audit plus approfondi tous les trimestres. Le respect de cette routine vous aidera à surveiller et à comprendre comment les modifications apportées à votre site Web affectent les performances de référencement.

6 outils pour vous aider à réaliser un audit SEO technique

Voici les outils SEO que nous utiliserons pour effectuer un audit technique :

- Screaming Frog SEO Araignée

- Console de recherche Google

- Google Analytics

- Aperçu de la vitesse des pages Google

- Test Google Mobile-Friendly

- Test réactif de BrowserStack

Ces outils sont gratuits, à l'exception de Screaming Frog qui limite les utilisateurs du forfait gratuit à 500 pages.

Si vous gérez un grand site Web de plus de 500 pages, la version payante de Screaming Frog offre une exploration illimitée pour 149 $ par an.

Alternativement, vous pouvez utiliser l'outil d'audit de site de Semrush (gratuit jusqu'à 100 pages) ou l'outil d'audit de site Ahrefs. Les deux effectuent un travail similaire, avec les avantages supplémentaires du signalement des erreurs et des avertissements, et des instructions sur la façon de résoudre les problèmes techniques.

1. Trouvez votre fichier robots.txt et exécutez un rapport d'exploration pour identifier les erreurs

Les pages de votre site Web ne peuvent être indexées que si les moteurs de recherche peuvent les explorer. Par conséquent, avant d'exécuter un rapport d'exploration, consultez votre fichier robots.txt. Vous pouvez le trouver en ajoutant "robots.txt" à la fin de votre domaine racine :

https://votredomaine.com/robots.txt

Le fichier robots.txt est le premier fichier qu'un bot trouve lorsqu'il atterrit sur votre site. Les informations qu'ils contiennent leur indiquent ce qu'ils doivent et ne doivent pas ramper en "autorisant" et "en interdisant".

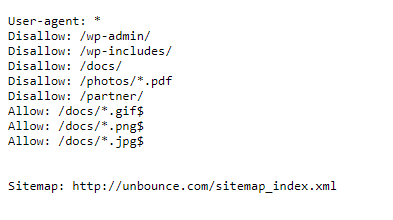

Voici un exemple tiré du site Web Unbounce :

Vous pouvez voir ici qu'Unbounce demande que les robots de recherche n'explorent pas certaines parties de son site. Ce sont des dossiers principaux qui n'ont pas besoin d'être indexés à des fins de référencement.

En les interdisant, Unbounce est en mesure d'économiser sur la bande passante et le budget d'exploration, c'est-à-dire le nombre de pages que Googlebot explore et indexe sur un site Web dans un délai donné.

Si vous gérez un grand site avec des milliers de pages, comme une boutique de commerce électronique, l'utilisation de robots.txt pour interdire les pages qui n'ont pas besoin d'indexation donnera à Googlebot plus de temps pour accéder aux pages importantes.

Ce que le robots.txt d'Unbounce fait également, c'est pointer les bots vers son sitemap. C'est une bonne pratique car votre sitemap fournit des détails sur chaque page que vous souhaitez que Google et Bing découvrent (plus à ce sujet dans la section suivante).

Examinez votre fichier robots.txt pour vous assurer que les robots n'explorent pas des dossiers et des pages privés. De même, vérifiez que vous n'interdisez pas les pages qui doivent être indexées.

Si vous avez besoin d'apporter des modifications à votre robots.txt, vous le trouverez dans le répertoire racine de votre serveur Web (si vous n'êtes pas habitué à ces fichiers, cela vaut la peine d'obtenir l'aide d'un développeur Web). Si vous utilisez WordPress, le fichier peut être modifié à l'aide du plugin gratuit Yoast SEO. D'autres plates-formes CMS comme Wix vous permettent d'apporter des modifications via des outils de référencement intégrés.

Exécutez un rapport d'exploration pour vérifier que votre site Web est indexable

Maintenant que vous savez que les robots reçoivent les bonnes instructions, vous pouvez exécuter un rapport d'exploration pour vérifier que les pages que vous souhaitez indexer ne sont pas gênées.

Entrez votre URL dans Screaming Frog, ou en allant dans Index > Couverture dans votre console de recherche Google.

Chacun de ces outils affichera les métriques d'une manière différente.

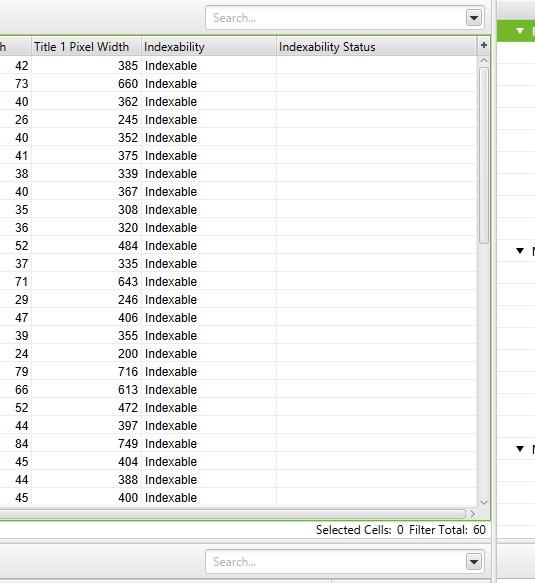

Screaming Frog examine chaque URL individuellement, divisant les résultats d'indexation en deux colonnes :

1. Indexabilité : Cela montre où une URL est indexable ou non indexable

2. Statut d'indexabilité : la raison pour laquelle une URL n'est pas indexable

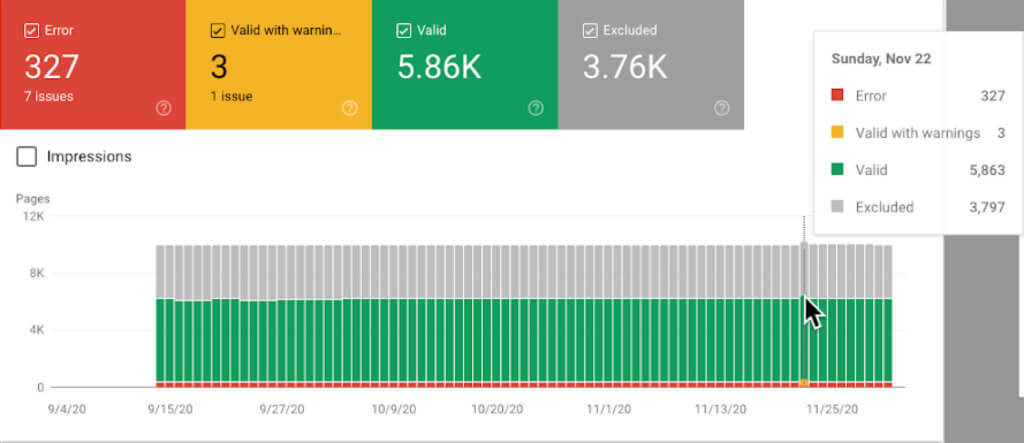

Le rapport de couverture de l'index de la console de recherche Google affiche l'état de chaque page de votre site Web.

Le rapport montre :

- Erreurs : erreurs de redirection, liens rompus et 404

- Valide avec avertissements : pages qui sont indexées mais avec des problèmes qui peuvent ou non être intentionnels

- Valide : pages indexées avec succès

- Exclus : pages exclues de l'indexation pour des raisons telles que le blocage par le fichier robots.txt ou la redirection

Signaler et corriger les erreurs de redirection pour améliorer l'exploration et l'indexation

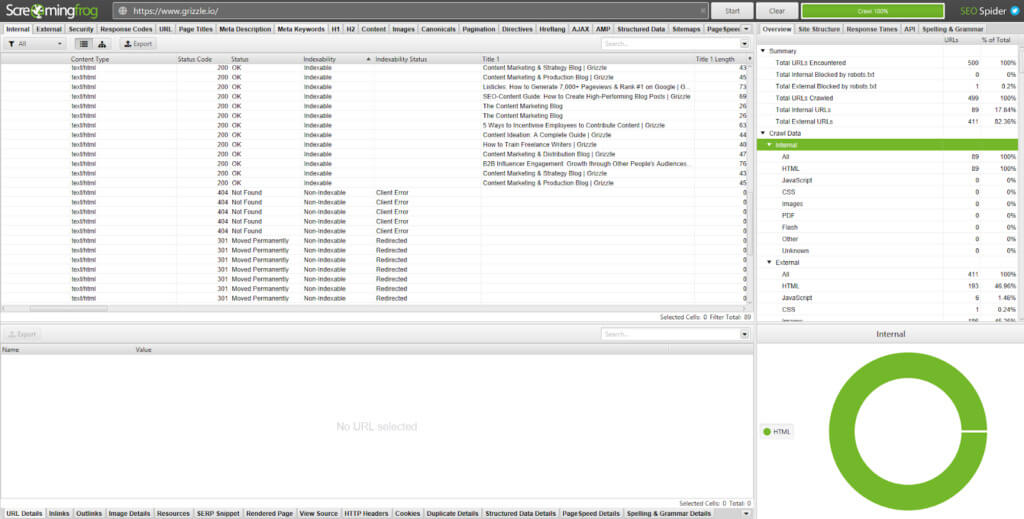

Toutes les pages de votre site Web reçoivent un code d'état HTTP. Chaque code correspond à une fonction différente.

Screaming Frog les affiche dans la colonne Status Code :

Tout va bien, la plupart des pages de votre site Web renverront un code d'état 200, ce qui signifie que la page est OK. Les pages contenant des erreurs afficheront un code d'état 3xx, 4xx ou 5xx.

Voici un aperçu des codes que vous pourriez voir dans votre audit et comment corriger ceux qui comptent :

Codes d'état 3xx

- 301 : redirection permanente. Le contenu a été déplacé vers une nouvelle URL et la valeur SEO de l'ancienne page est transmise.

Les 301 sont acceptables, tant qu'il n'y a pas de chaîne ou de boucle de redirection qui provoque plusieurs redirections. Par exemple, si la redirection A va vers B et C pour accéder à D, cela peut entraîner une mauvaise expérience utilisateur et une vitesse de page lente. Cela peut augmenter le taux de rebond et nuire aux conversions. Pour résoudre le problème, vous devrez supprimer les redirections B et C afin que la redirection A aille directement vers D.

En allant dans Rapports > Chaînes de redirection dans Screaming Frog, vous pouvez télécharger le chemin d'exploration de vos redirections et identifier les 301 à supprimer.

- 302 : redirection temporaire. Le contenu a été temporairement déplacé vers une URL.

Les 302 sont utiles à des fins telles que les tests A/B, où vous souhaitez tester un nouveau modèle ou une nouvelle mise en page. Cependant, si le 302 est en place depuis plus de trois mois, cela vaut la peine d'en faire un 301.

- 307 : Redirection temporaire en raison d'un changement de protocole de la source vers la destination.

Cette redirection doit être utilisée si vous êtes sûr que le déplacement est temporaire et que vous aurez toujours besoin de l'URL d'origine.

Codes d'état 4xx

- 403 : Accès interdit. Cela a tendance à s'afficher lorsque le contenu est caché derrière une connexion.

- 404 : La page n'existe pas en raison d'un lien brisé ou lorsqu'une page ou un article a été supprimé mais que l'URL n'a pas été redirigée.

Comme les chaînes de redirection, les 404 n'offrent pas une excellente expérience utilisateur. Supprimez tous les liens internes pointant vers des pages 404 et mettez-les à jour avec le lien interne redirigé.

- 410 : Page définitivement supprimée.

Vérifiez toutes les pages affichant une erreur 410 pour vous assurer qu'elles ont définitivement disparu et qu'aucun contenu ne peut justifier une redirection 301.

- 429 : Trop de demandes de serveur dans un court laps de temps.

Codes d'état 5xx

Tous les codes d'état 5xx sont liés au serveur. Ils indiquent que le serveur n'a pas pu exécuter une requête. Bien que ceux-ci nécessitent une attention particulière, le problème réside dans votre fournisseur d'hébergement ou votre développeur Web, et non dans votre site Web.

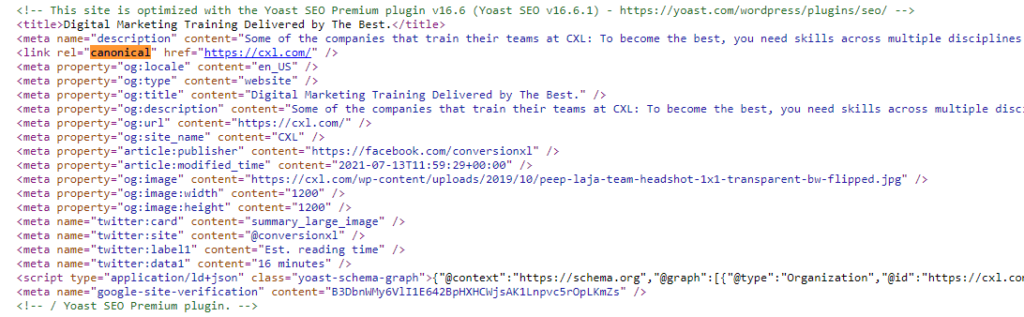

Configurez des balises canoniques pour diriger les moteurs de recherche vers des pages importantes

Les balises méta canoniques apparaissent dans la section <head> du code d'une page.

<link rel="canonical" href="https://www.votredomaine.com/page-abc/" />

Ils existent pour permettre aux robots des moteurs de recherche de savoir quelle page indexer et afficher dans les SERP lorsque vous avez des pages avec un contenu identique ou similaire.

Par exemple, supposons qu'un site de commerce électronique vendait une voiture de police bleue et qu'elle était répertoriée sous "jouets> voitures> voiture de police bleue" et "jouets> voitures de police> voiture bleue".

C'est la même voiture de police bleue sur les deux pages. La seule différence réside dans les liens du fil d'Ariane qui vous amènent à la page.

En ajoutant une balise canonique à la "page principale" ( jouets > voitures ), vous signalez aux moteurs de recherche qu'il s'agit du produit original. Le produit listé dans " jouets > voitures de police > voiture jouet bleue" est une copie.

Un autre exemple de cas où vous voudriez ajouter des balises canoniques est celui où les pages ont ajouté des paramètres d'URL.

Par exemple, « https://www.votredomaine.com/toys » affichera un contenu similaire à « https://www.votredomaine.com/toys?page=2 » ou « https://www.votredomaine.com/ toys?price=descending » qui ont été utilisés pour filtrer les résultats .

Sans balise canonique, les moteurs de recherche traiteraient chaque page comme unique. Non seulement cela signifie avoir plusieurs pages indexées, réduisant ainsi la valeur SEO de votre page maître, mais cela augmente également votre budget de crawl.

Les balises canoniques peuvent être ajoutées directement à la section <head> dans le code de page des pages supplémentaires (pas la page principale) ou si vous utilisez un CMS tel que WordPress ou Magneto, des plugins comme Yoast SEO qui simplifient le processus.

2. Passez en revue l'architecture et le plan du site de votre site pour rendre le contenu accessible

L'exécution d'une exploration de site permet de résoudre la plupart des erreurs techniques sur votre site Web. Nous devons maintenant examiner les erreurs UX.

Comme nous l'avons mentionné en haut, un utilisateur devrait pouvoir se rendre là où il veut être sur votre site en quelques clics. Une expérience humaine plus facile est synonyme d'une expérience de bot de recherche plus facile (ce qui, encore une fois, permet d'économiser sur le budget de crawl).

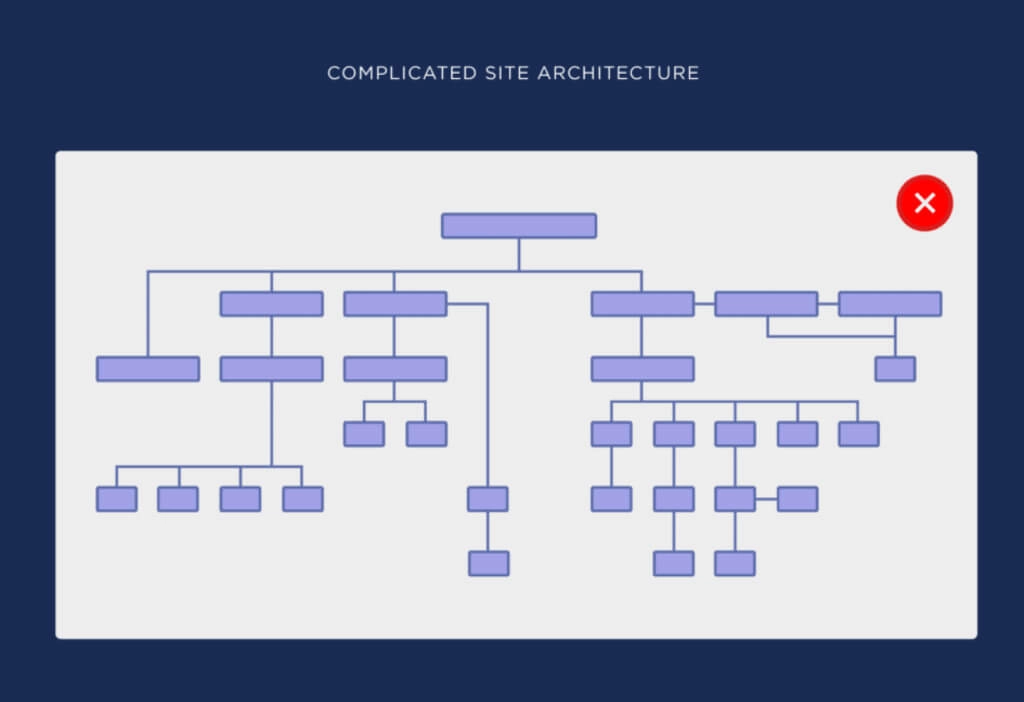

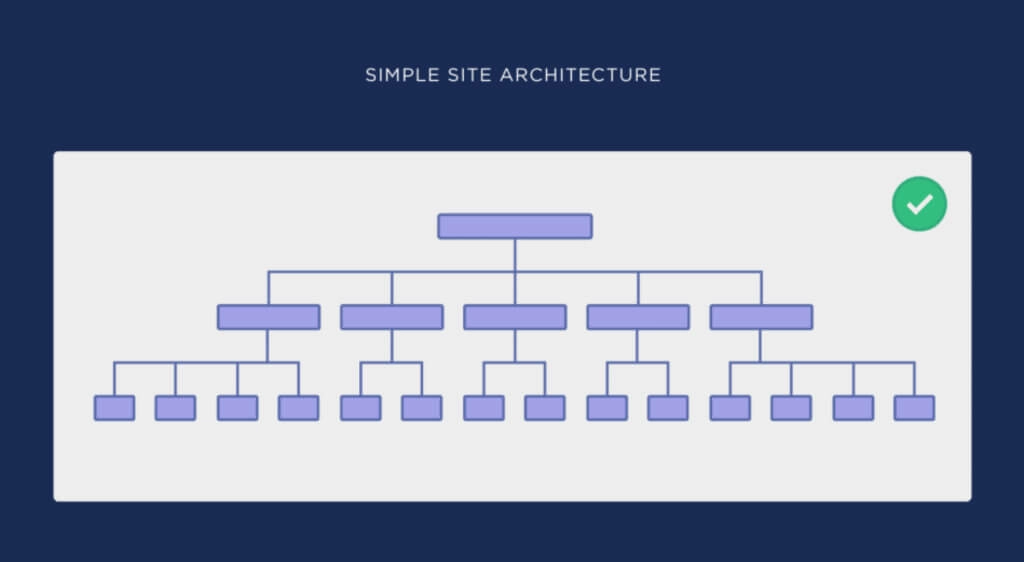

En tant que tel, la structure de votre site doit être logique et cohérente. Ceci est réalisé en aplatissant l'architecture de votre site Web.

Voici des exemples d'architecture de site compliquée et d'architecture de site simple (plate) du guide de Backlinko sur le sujet :

Vous pouvez voir à quel point il est plus facile dans la deuxième image de passer de la page d'accueil à n'importe quelle autre page du site.

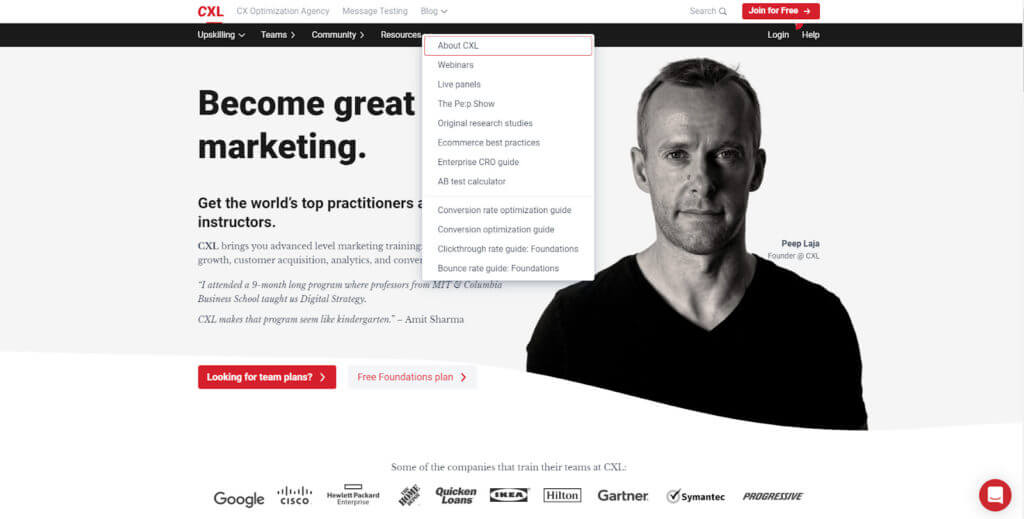

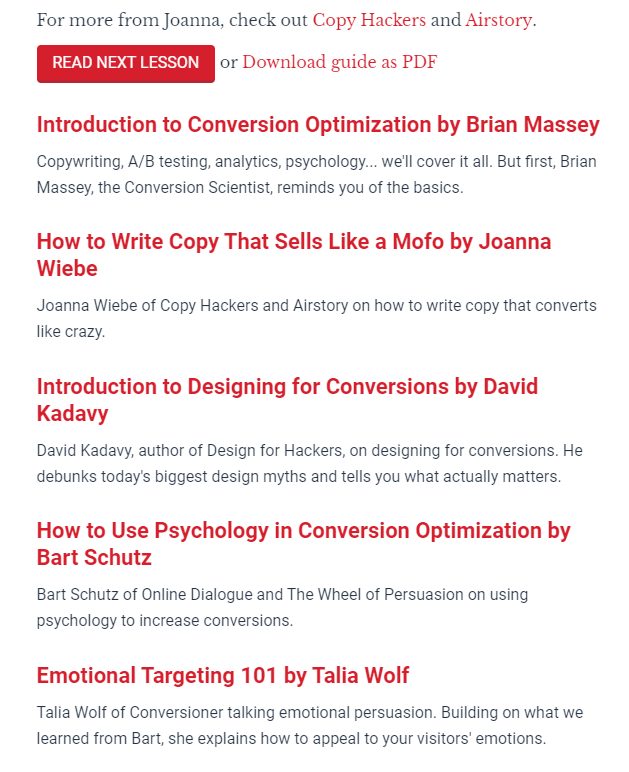

Pour un exemple concret, regardez la page d'accueil de CXL :

En trois clics, je peux accéder au contenu que je veux : "Comment écrire une copie qui se vend comme un mofo par Joanna Wiebe."

- Accueil > Ressources

- Ressources > Guide d'optimisation du taux de conversion

- Guide d'optimisation du taux de conversion > Comment écrire une copie qui se vend comme un mofo par Joanna Wiebe

Plus une page est proche de votre page d'accueil, plus elle est importante. Par conséquent, vous devriez chercher à regrouper les pages en fonction de mots-clés pour rapprocher celles qui sont les plus pertinentes pour votre public du haut du site.

Une architecture de site Web aplatie doit être reflétée par sa structure d'URL.

Par exemple, lorsque nous avons navigué vers " cxl.com/conversion-rate-optimization/how-to-write-copy-that-sells-like-a-mofo-by-joanna-wiebe/", l'URL a suivi le chemin que nous avons ont pris. Et en utilisant le fil d'Ariane, nous pouvons voir comment nous y sommes arrivés afin que nous puissions facilement revenir en arrière.

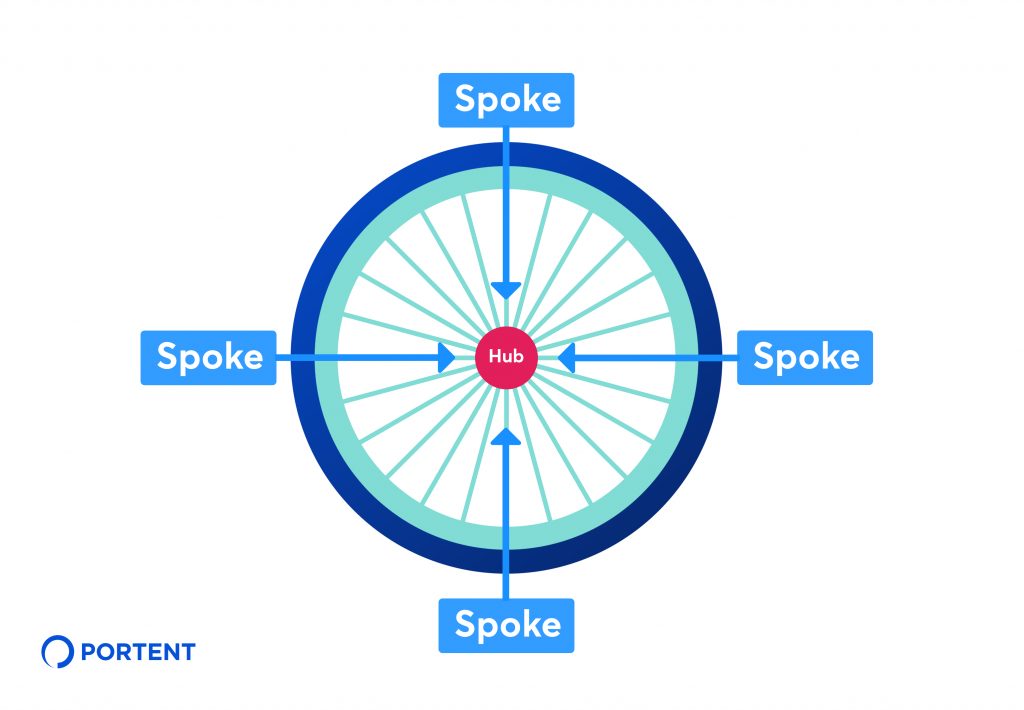

Pour créer une stratégie de référencement cohérente et organiser la relation entre les éléments de contenu, utilisez la méthode hub-and-spoke.

Portent décrit cette méthode comme « une stratégie de liaison interne qui consiste à lier plusieurs pages de contenu connexe (parfois appelées pages « parlées ») à une page de hub central. »

Dans notre exemple, "Optimisation du taux de conversion" guide est la plaque tournante, "Comment écrire une copie qui se vend comme un Mofo par Joanna Wiebe" est un rayon.

Selon la taille de votre site Web, vous aurez peut-être besoin de l'aide d'un développeur Web pour aplanir l'architecture et réviser la navigation. Cependant, vous pouvez facilement améliorer l'expérience utilisateur en ajoutant des liens internes vers les pages pertinentes.

Au bas de "Comment écrire une copie qui se vend comme un Mofo par Joanna Wiebe", par exemple, vous trouverez des liens vers d'autres contenus parlés.

Cela peut également être fait dans le corps du contenu, en créant des liens vers des pages liées à des mots-clés spécifiques.

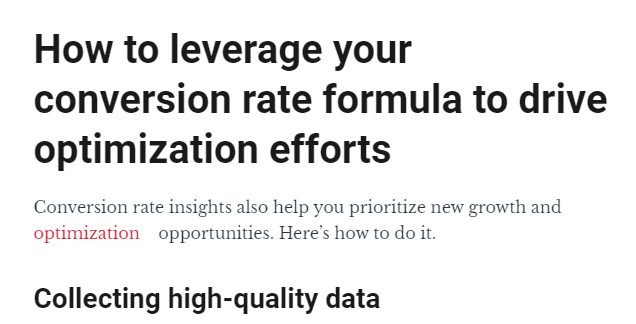

"Optimisation" dans l'image ci-dessus renvoie au guide d'optimisation du taux de conversion de CXL.

Organisez votre sitemap pour refléter la structure de votre site Web

Les URL qui figurent sur votre site doivent correspondre à celles de votre sitemap XML. C'est le fichier vers lequel vous devez pointer les bots dans votre robots.txt comme guide pour explorer votre site Web.

Comme robots.txt, vous pouvez trouver votre sitemap XML en ajoutant « sitemap.xml » à la fin de votre domaine racine :

https://votredomaine.com/sitemap.xml

Si vous mettez à jour l'architecture de votre site, votre sitemap devra également être mis à jour. Un CMS comme WordPress, Yoast SEO ou Google XML sitemaps peut générer et mettre à jour automatiquement un sitemap chaque fois qu'un nouveau contenu est créé. D'autres plateformes comme Wix et Squarespace ont également des fonctionnalités intégrées qui font de même.

Si vous devez le faire manuellement, les plans de site XML généreront automatiquement un plan de site XML que vous pourrez coller dans le dossier (/) de votre site Web. Cependant, vous ne devriez le faire que si vous êtes sûr de gérer ces fichiers. Si ce n'est pas le cas, faites-vous aider par un développeur Web.

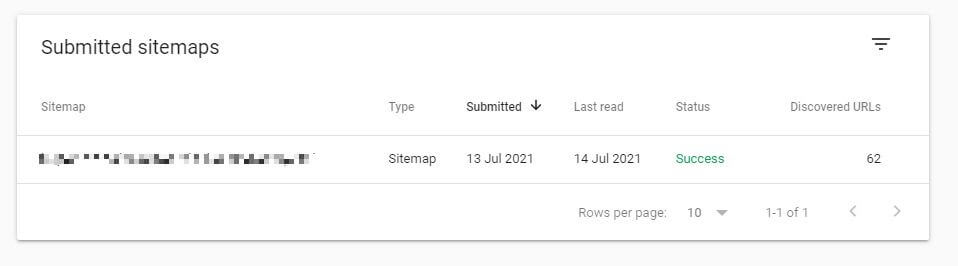

Une fois que vous avez votre sitemap mis à jour, soumettez-le à Index > Sitemaps dans la Google Search Console.

À partir de là, Google signalera tout problème d'exploration et d'indexation.

Les sitemaps de travail afficheront un statut de "Succès". Si l'état indique " Contient des erreurs " ou " Impossible de récupérer " , il y a probablement des problèmes avec le contenu du sitemap.

Comme pour votre fichier robots.txt, votre sitemap ne doit pas inclure de pages que vous ne souhaitez pas voir apparaître dans les SERP. Mais il devrait inclure chaque page que vous souhaitez indexer, exactement comment elle apparaît sur votre site.

Par exemple, si vous souhaitez que Google indexe « https://votredomaine.com/jouets », votre sitemap doit copier exactement ce domaine, y compris le protocole HTTPS. « http://votredomaine.com/toys » ou « /toys » signifie que les pages ne sont pas explorées.

3. Testez et améliorez la vitesse du site et la réactivité mobile

La vitesse du site a longtemps été un facteur dans le classement des moteurs de recherche. Google l'a confirmé pour la première fois en 2010. En 2018, ils ont augmenté les enjeux en déployant la vitesse des pages mobiles comme facteur de classement dans les résultats de recherche mobile.

Lors du classement d'un site Web en fonction de sa vitesse, Google examine deux points de données :

1. Vitesse de la page : combien de temps il faut pour qu'une page se charge

2. Vitesse du site : temps moyen nécessaire au chargement d'un échantillon de pages vues

Lors de l'audit de votre site, vous n'avez qu'à vous concentrer sur la vitesse de la page. Améliorez le temps de chargement des pages et vous améliorerez la vitesse du site. Google vous aide à le faire avec son analyseur PageSpeed Insights.

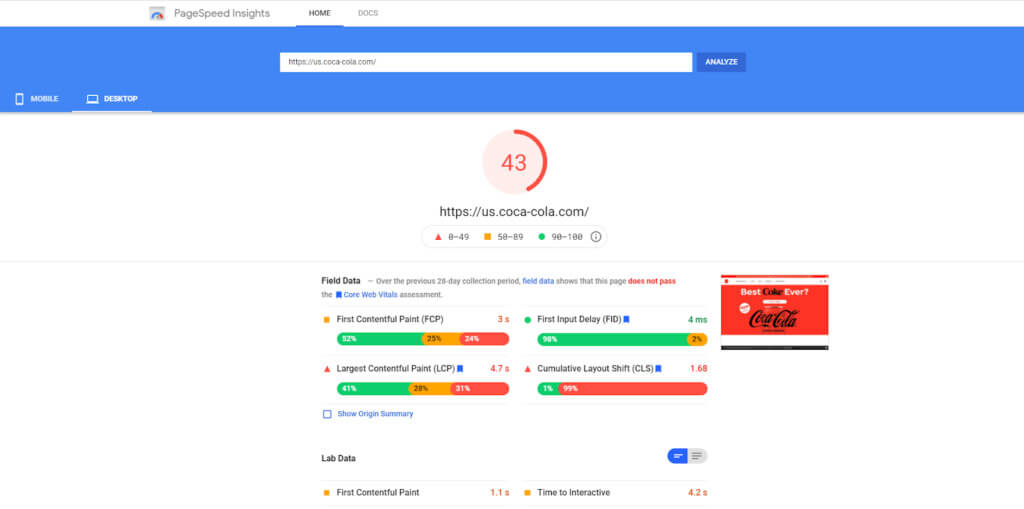

Entrez une URL et PageSpeed Insights la notera de 0 à 100. Le score est basé sur des données de terrain réelles recueillies auprès des utilisateurs du navigateur Google Chrome et des données de laboratoire. Il suggérera également des opportunités d'amélioration.

Une mauvaise image, JavaScript, l'optimisation des fichiers CSS et les pratiques de mise en cache du navigateur ont tendance à être les coupables du chargement lent des pages. Heureusement, ceux-ci sont faciles à améliorer :

- Réduisez la taille des images sans impact sur la qualité avec Optimizilla ou Squoosh. Si vous utilisez WordPress, des plugins d'optimisation comme Imagify Image Optimizer et TinyPNG font le même travail.

- Réduisez les fichiers JavaScript et CSS en collant votre code dans Minify pour supprimer les espaces et les commentaires

- Si vous utilisez WordPress, utilisez W3 Total Cache ou WP Super Cache pour créer et servir une version statique de vos pages aux internautes, plutôt que d'avoir la page générée dynamiquement chaque fois qu'une personne clique dessus. Si vous n'utilisez pas WordPress, la mise en cache peut être activée manuellement dans le code de votre site.

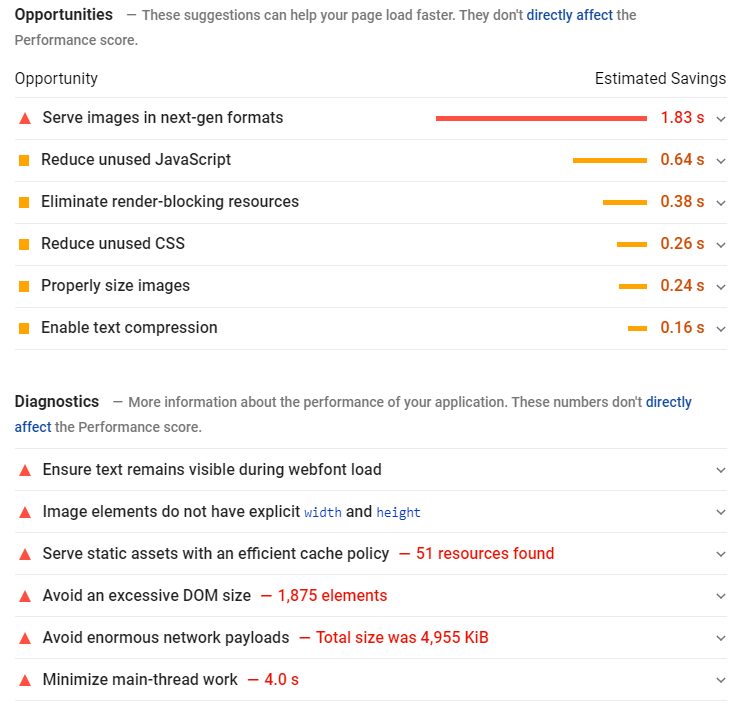

Commencez par prioriser vos pages les plus importantes. En accédant à Comportement > Vitesse du site dans votre Google Analytics, les métriques montreront les performances de pages spécifiques sur différents navigateurs et pays :

Vérifiez cela par rapport à vos pages les plus consultées et parcourez votre site de haut en bas.

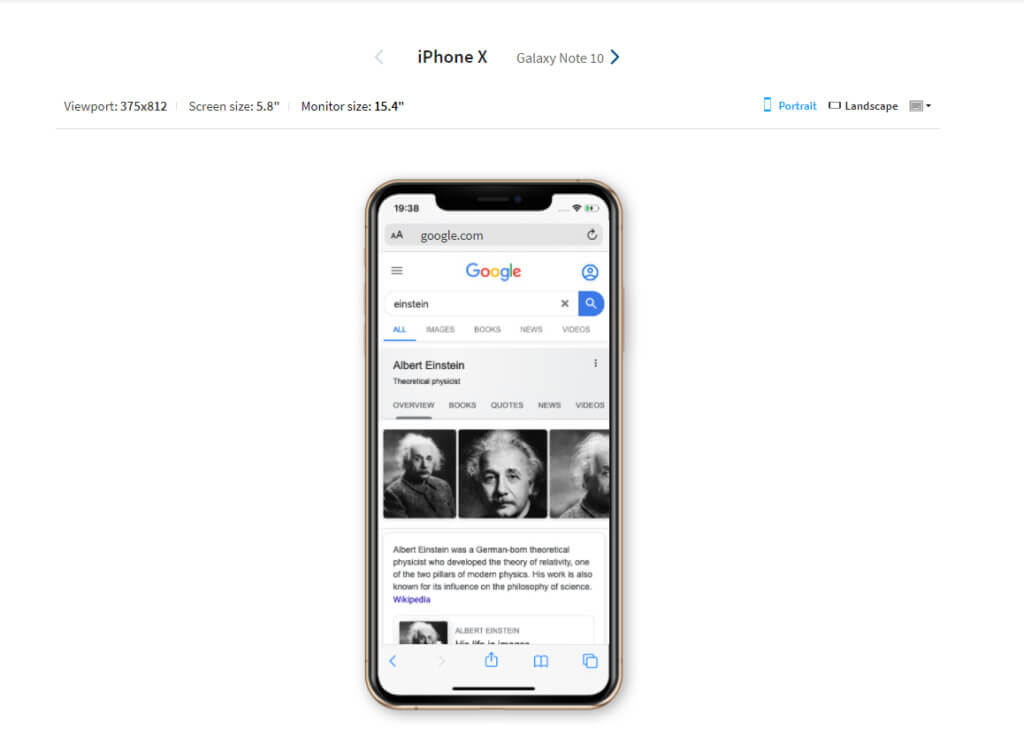

Comment savoir si votre site Web est adapté aux mobiles

En mars 2021, Google a lancé l'indexation mobile d'abord. Cela signifie que les pages indexées par Google seront basées sur la version mobile de votre site. Par conséquent, les performances de votre site sur des écrans plus petits auront le plus grand impact sur l'endroit où votre site apparaît dans les SERP.

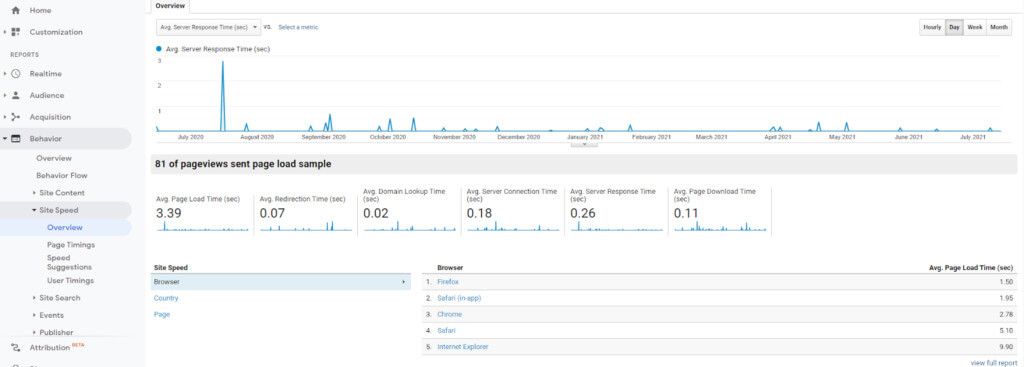

L'outil Mobile-Friendly Test de Google est un moyen simple de vérifier si votre site est optimisé pour les appareils mobiles :

Si vous utilisez une conception réactive ou mobile, vous ne devriez pas vous inquiéter. Les deux sont développés pour s'afficher sur des écrans plus petits et toute modification que vous apportez à la suite de votre audit SEO technique améliorera les performances du site et de la recherche sur tous les appareils.

Cependant, un design réactif ne garantit pas une excellente expérience utilisateur, comme le démontre Shanelle Mullin dans son article expliquant pourquoi le design réactif n'est pas une optimisation mobile.

Vous pouvez tester votre site sur de vrais appareils à l'aide de l'outil réactif de BrowserStack :

Les sites mobiles autonomes devraient également réussir le test de Google. Notez que des sites distincts pour les mobiles et les ordinateurs de bureau vous obligeront à auditer les deux versions.

Une autre option pour améliorer la vitesse du site sur mobile est les pages mobiles accélérées (AMP). AMP est un projet soutenu par Google conçu pour servir aux utilisateurs des versions simplifiées de pages Web afin qu'elles se chargent plus rapidement que HTML.

Google propose des tutoriels et des directives pour créer des pages AMP à l'aide de code ou d'un plug-in CMS. Cependant, il est important d'être conscient de la façon dont ceux-ci affecteront votre site.

Chaque page AMP que vous créez est une nouvelle page qui existe à côté de l'originale. Par conséquent, vous devrez déterminer comment ils s'intègrent dans votre schéma d'URL. Google recommande d'utiliser la structure d'URL suivante :

http://www.exemple.com/monarticle/amp

http://www.exemple.com/monarticle.amp.html

Vous devrez également vous assurer que les balises canoniques sont utilisées pour identifier la page maître. Cela peut être la page AMP, mais la page d'origine est préférée. En effet, les pages AMP proposent une version de base de votre page Web qui ne vous permet pas de générer des revenus publicitaires ou d'accéder au même niveau d'analyse approfondi.

Les pages AMP devront être auditées de la même manière que les pages HTML. Si vous êtes un abonné payant, Screaming Frog propose des fonctionnalités pour vous aider à trouver et à résoudre les problèmes AMP. Vous pouvez le faire dans la version gratuite, mais vous devrez télécharger votre liste de pages.

5. Trouvez et corrigez les problèmes de contenu en double et de cannibalisation des mots clés pour affiner le référencement

À ce stade, votre audit de contenu a déjà commencé. L'ajout de balises canoniques garantit que les pages maîtres reçoivent une valeur SEO sur des pages similaires. L'architecture de site aplatie facilite l'accès à votre contenu le plus important. Ce que nous cherchons à faire maintenant, c'est de peaufiner.

Examinez votre site pour le contenu dupliqué

Les pages qui contiennent des informations identiques ne sont pas toujours mauvaises. L'exemple de pages de voitures de police miniatures que nous avons utilisé précédemment, par exemple, est nécessaire pour fournir aux utilisateurs des résultats pertinents.

Ils deviennent un problème lorsque vous avez une page identique à celle pour laquelle vous essayez de vous classer. Dans de tels cas, vous faites en sorte que les pages se concurrencent pour le classement et les clics, diluant ainsi leur potentiel.

En plus des pages produits, des problèmes de contenu dupliqué peuvent survenir pour plusieurs raisons :

- Réutiliser les en-têtes, les titres de page et les méta-descriptions pour que les pages apparaissent identiques même si le contenu du corps ne l'est pas

- Ne pas supprimer ou rediriger des pages identiques utilisées à des fins d'historique ou de test

- Ne pas ajouter de balises canoniques à une seule page avec plusieurs URL

Une exploration du site aidera à identifier les pages en double. Vérifiez le contenu pour la duplication de :

- Titres

- Balises d'en-tête

- Méta descriptions

- Contenu du corps

Vous pouvez ensuite soit supprimer ces pages, soit réécrire les éléments dupliqués pour les rendre uniques.

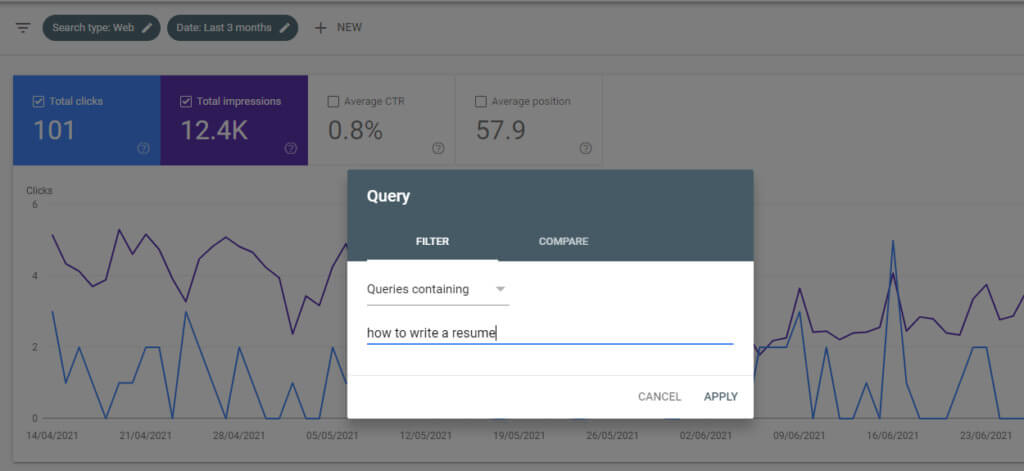

Fusionner du contenu qui cannibalise des mots-clés similaires

La cannibalisation des mots-clés s'apparente au contenu dupliqué en ce sens qu'elle oblige les moteurs de recherche à choisir entre des contenus similaires.

Cela se produit lorsque vous avez différents contenus sur votre site qui se classent pour la même requête. Soit parce que le sujet est similaire, soit parce que vous avez ciblé les mêmes mots-clés.

Par exemple, disons que vous avez écrit deux articles. L'un sur "Comment rédiger un CV" optimisé pour la phrase "comment rédiger un CV" et l'autre sur "Conseils pour la rédaction de CV" optimisé pour "rédaction de CV".

Les messages sont suffisamment similaires pour que les moteurs de recherche aient du mal à déterminer lequel est le plus important.

Googler "site : votredomaine.com + 'mot clé" vous aidera à déterminer facilement si la cannibalisation des mots clés est un problème.

Si vos messages sont classés n°1 et n°2, ce n'est pas un problème. Mais si votre contenu se classe plus bas dans les SERP, ou si un article plus ancien se classe au-dessus d'un article mis à jour, cela vaut probablement la peine de les fusionner :

- Accédez à la section Performances de votre console de recherche Google.

- Dans les filtres, cliquez sur Nouveau > Requête et entrez le mot-clé cannibalisé.

- Sous l'onglet Pages , vous pourrez voir quelle page reçoit le plus de trafic pour le mot-clé. C'est la page dans laquelle toutes les autres peuvent être fusionnées.

Par exemple, "Comment rédiger un CV" pourrait être élargi pour inclure des conseils de rédaction de CV et devenir un guide définitif pour la rédaction de CV.

Cela ne fonctionnera pas pour toutes les pages. Dans certains cas, vous voudrez peut-être envisager de supprimer le contenu qui n'est plus pertinent. Mais lorsque les mots-clés sont similaires, la combinaison de contenu contribuera à renforcer votre classement dans les recherches.

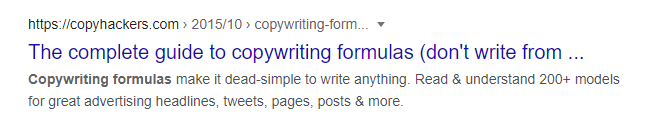

Améliorez les balises de titre et les méta descriptions pour augmenter votre taux de clics (CTR) dans les SERPs

Bien que les balises de titre et les méta descriptions ne soient pas un facteur de classement, il est indéniable qu'elles font une différence pour votre attrait. Ils sont essentiellement un moyen de faire de la publicité pour votre contenu.

Réaliser un audit SEO technique est le moment idéal pour optimiser les anciens titres et descriptions, et combler les éventuelles lacunes pour améliorer le CTR dans les SERP.

Les titres et les descriptions doivent être naturels, pertinents, concis et utiliser vos mots-clés cibles. Voici un exemple tiré du résultat de la recherche du guide des copyhackers sur les formules de rédaction :

La méta description indique aux lecteurs qu'ils apprendront pourquoi les formules de rédaction sont utiles et comment elles peuvent être appliquées dans le monde réel.

Bien que le titre soit également fort du point de vue du référencement, il a été tronqué. C'est probablement parce qu'il dépasse la limite de 600 pixels de Google. Gardez cette limite à l'esprit lorsque vous écrivez des titres.

Incluez des mots clés proches du début des titres et essayez de limiter le nombre de caractères à environ 60. Les recherches de Moz suggèrent que vous pouvez vous attendre à ce qu'environ 90 % de vos titres s'affichent correctement s'ils sont en dessous de cette limite.

De même, les méta descriptions doivent comporter environ 155 à 160 caractères pour éviter la troncature.

Il convient de noter que Google n'utilisera pas toujours votre méta description. En fonction de la requête de recherche, ils peuvent extraire une description de votre site à utiliser comme extrait. C'est hors de votre contrôle. Mais si vos mots-clés cibles sont présents dans vos balises META, vous vous donnerez un avantage sur les autres résultats qui suivent des termes similaires.

Conclusion

La réalisation d'un audit SEO technique vous aidera à analyser les éléments techniques de votre site Web et à améliorer les domaines qui entravent les performances de recherche et l'expérience utilisateur.

Mais suivre les étapes décrites dans cet article ne résoudra que les problèmes que vous rencontrez actuellement . Au fur et à mesure que votre entreprise se développe et que votre site Web évolue, et à mesure que les algorithmes de Google changent, de nouveaux problèmes liés aux liens, à la vitesse du site et au contenu surgiront.

Par conséquent, les audits techniques doivent faire partie d'une stratégie continue, parallèlement aux efforts de référencement sur page et hors page. Vérifiez votre site Web périodiquement ou chaque fois que vous apportez des mises à jour structurelles ou de conception à votre site Web.