So führen Sie ein technisches SEO-Audit durch

Veröffentlicht: 2022-04-12Die technischen Elemente der SEO Ihrer Website sind entscheidend für die Suchleistung. Wenn Sie sie verstehen und pflegen, kann Ihre Website einen herausragenden Rang einnehmen, den Verkehr steigern und den Umsatz steigern. Wenn Sie sie vernachlässigen, laufen Sie Gefahr, dass Seiten nicht in den SERPs angezeigt werden.

In diesem Artikel erfahren Sie, wie Sie ein technisches SEO-Audit durchführen, um Probleme in der Struktur Ihrer Website zu finden und zu beheben. Wir prüfen die wichtigsten Ranking-Faktoren wie Inhalt, Geschwindigkeit, Struktur und Mobilfreundlichkeit, um sicherzustellen, dass Ihre Website gecrawlt und indexiert werden kann.

Wir zeigen Ihnen auch die Tools, die Sie benötigen, um On-Page- und Off-Page-SEO-Bemühungen und -Leistung zu steigern, und wie Sie sie verwenden.

Verwenden Sie ein technisches SEO-Audit, um Ihre SEO-Leistung zu verbessern

Stellen Sie sich ein technisches SEO-Audit als einen Website-Gesundheitscheck vor. Ähnlich wie Sie Ihre digitalen Marketingkampagnen regelmäßig überprüfen, um das Beste aus ihnen herauszuholen, bewertet ein technisches SEO-Audit die Leistung der Website, um Bereiche mit Verbesserungspotenzial zu identifizieren.

Diese Bereiche fallen in drei Kategorien:

1. Technische Fehler

Identifizieren von Warnsignalen im Back- und Frontend Ihrer Website, die sich negativ auf die Leistung und damit auf Ihre SEO auswirken. Zu den technischen Fehlern gehören Crawling-Probleme, defekte Links, langsame Seitengeschwindigkeit und doppelte Inhalte. Wir werden uns jedes davon in diesem Artikel ansehen.

2. UX-Fehler

User Experience (UX) wird eher als Designproblem denn als SEO betrachtet. Die Struktur Ihrer Website wirkt sich jedoch auf die SEO-Leistung aus.

Um besser zu verstehen, welche Seiten wichtig sind und welche niedrigere Priorität haben, verwendet Google einen Algorithmus namens Page Importance.

Die Wichtigkeit der Seite wird durch den Seitentyp, interne und externe Links, die Aktualisierungshäufigkeit und Ihre Sitemap bestimmt. Aus UX-Sicht noch wichtiger ist jedoch, dass es durch die Seitenposition bestimmt wird. Mit anderen Worten, wo sich die Seite auf Ihrer Website befindet.

Dies macht die Website-Architektur zu einem wichtigen technischen SEO-Faktor. Je schwieriger es für einen Nutzer ist, eine Seite zu finden, desto länger dauert es, bis Google sie findet. Idealerweise sollte ein Benutzer in der Lage sein, mit so wenigen Klicks wie möglich dorthin zu gelangen.

Ein technisches SEO-Audit behebt Probleme mit der Seitenstruktur und Zugänglichkeit, die sie daran hindern.

3. Ranking-Möglichkeiten

Hier trifft technisches SEO auf Onpage-SEO. Neben der Priorisierung wichtiger Seiten in Ihrer Website-Architektur hilft ein Audit dabei, Google von der Wichtigkeit einer Seite zu überzeugen, indem es:

- Identifizieren und Zusammenführen von Inhalten, die auf dieselben oder ähnliche Schlüsselwörter abzielen;

- Entfernen von doppelten Inhalten, die die Bedeutung verwässern, und;

- Verbesserung der Metadaten, damit Benutzer auf den Ergebnisseiten von Suchmaschinen (SERPs) sehen, wonach sie suchen.

Es geht darum, Google dabei zu helfen, Ihre Website besser zu verstehen, damit Seiten für die richtigen Suchanfragen angezeigt werden.

Wie bei jeder Art von Gesundheitscheck sollte ein technischer SEO-Audit keine einmalige Sache sein. Es sollte durchgeführt werden, wenn Ihre Website erstellt oder neu gestaltet wird, nach Änderungen in der Struktur und in regelmäßigen Abständen.

Als Faustregel gilt, jeden Monat ein Mini-Audit und vierteljährlich ein vertiefendes Audit durchzuführen. Wenn Sie sich an diese Routine halten, können Sie überwachen und verstehen, wie sich Änderungen an Ihrer Website auf die SEO-Leistung auswirken.

6 Tools, die Ihnen bei der Durchführung eines technischen SEO-Audits helfen

Hier sind die SEO-Tools, die wir verwenden, um ein technisches Audit durchzuführen:

- Screaming Frog SEO-Spinne

- Google Search Console

- Google Analytics

- Google PageSpeed Insights

- Google-Test auf Optimierung für Mobilgeräte

- BrowserStack-Responsive-Test

Diese Tools sind kostenlos, mit Ausnahme von Screaming Frog, das Benutzer des kostenlosen Plans auf 500 Seiten beschränkt.

Wenn Sie eine große Website mit mehr als 500 Seiten betreiben, bietet die kostenpflichtige Version von Screaming Frog uneingeschränktes Crawling für 149 US-Dollar pro Jahr.

Alternativ können Sie das Site-Audit-Tool von Semrush (kostenlos für bis zu 100 Seiten) oder das Site-Audit-Tool von Ahrefs verwenden. Beide führen eine ähnliche Aufgabe aus, mit den zusätzlichen Vorteilen der Fehler- und Warnmeldung und Anweisungen zur Behebung technischer Probleme.

1. Suchen Sie Ihre robots.txt-Datei und führen Sie einen Crawling-Bericht aus, um Fehler zu identifizieren

Die Seiten Ihrer Website können nur indexiert werden, wenn Suchmaschinen sie crawlen können. Sehen Sie sich daher vor dem Erstellen eines Crawling-Berichts Ihre robots.txt-Datei an. Sie finden es, indem Sie „robots.txt“ am Ende Ihrer Root-Domain hinzufügen:

https://ihredomain.com/robots.txt

Die robots.txt-Datei ist die erste Datei, die ein Bot findet, wenn er auf Ihrer Website landet. Die darin enthaltenen Informationen sagen ihnen, was sie crawlen sollen und was nicht, indem sie „erlauben“ und „nicht zulassen“.

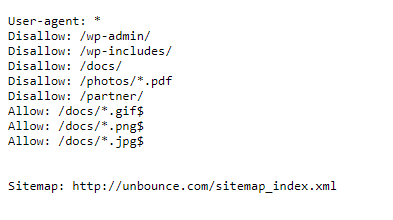

Hier ist ein Beispiel von der Unbounce-Website:

Sie können hier sehen, dass Unbounce verlangt, dass Such-Crawler bestimmte Teile seiner Website nicht crawlen. Dies sind Back-End-Ordner, die für SEO-Zwecke nicht indiziert werden müssen.

Indem sie nicht zugelassen werden, kann Unbounce Bandbreite und Crawling-Budget einsparen – die Anzahl der Seiten, die der Googlebot innerhalb eines bestimmten Zeitraums auf einer Website crawlt und indiziert.

Wenn Sie eine große Website mit Tausenden von Seiten betreiben, wie z. B. einen E-Commerce-Shop, wird der Googlebot durch Verwendung der robots.txt-Datei zum Sperren von Seiten, die keine Indexierung benötigen, mehr Zeit haben, zu den relevanten Seiten zu gelangen.

Was die robots.txt von Unbounce auch tut, ist, Bots auf ihre Sitemap zu verweisen. Dies ist eine bewährte Vorgehensweise, da Ihre Sitemap Details zu jeder Seite enthält, die Google und Bing entdecken sollen (mehr dazu im nächsten Abschnitt).

Sehen Sie sich Ihre robots.txt an, um sicherzustellen, dass Crawler keine privaten Ordner und Seiten durchsuchen. Stellen Sie außerdem sicher, dass Sie Seiten, die indiziert werden sollten, nicht verbieten.

Wenn Sie Änderungen an Ihrer robots.txt vornehmen müssen, finden Sie sie im Stammverzeichnis Ihres Webservers (wenn Sie mit diesen Dateien nicht vertraut sind, lohnt es sich, Hilfe von einem Webentwickler zu erhalten). Wenn Sie WordPress verwenden, kann die Datei mit dem kostenlosen SEO-Plugin Yoast bearbeitet werden. Bei anderen CMS-Plattformen wie Wix können Sie Änderungen über integrierte SEO-Tools vornehmen.

Führen Sie einen Crawling-Bericht aus, um zu überprüfen, ob Ihre Website indexierbar ist

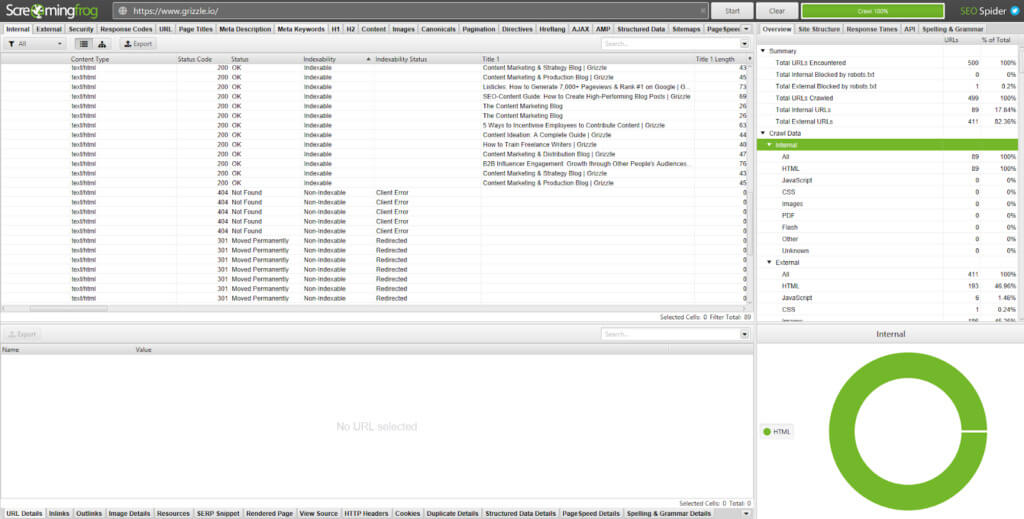

Da Sie nun wissen, dass Bots die richtigen Anweisungen erhalten, können Sie einen Crawling-Bericht erstellen, um zu überprüfen, ob die Seiten, die Sie indizieren möchten, nicht behindert werden.

Geben Sie Ihre URL in Screaming Frog ein oder gehen Sie in Ihrer Google Search Console zu Index > Coverage .

Jedes dieser Tools zeigt Metriken auf unterschiedliche Weise an.

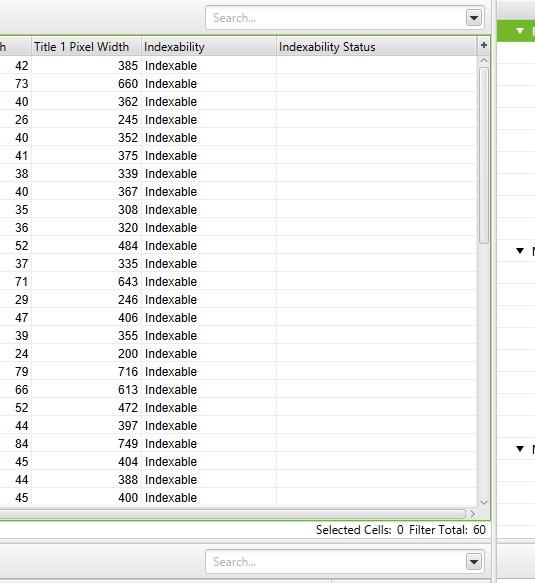

Screaming Frog betrachtet jede URL einzeln und teilt die Indexierungsergebnisse in zwei Spalten auf:

1. Indexierbarkeit: Zeigt an, wo eine URL indexierbar oder nicht indexierbar ist

2. Indexierbarkeitsstatus: Der Grund, warum eine URL nicht indexierbar ist

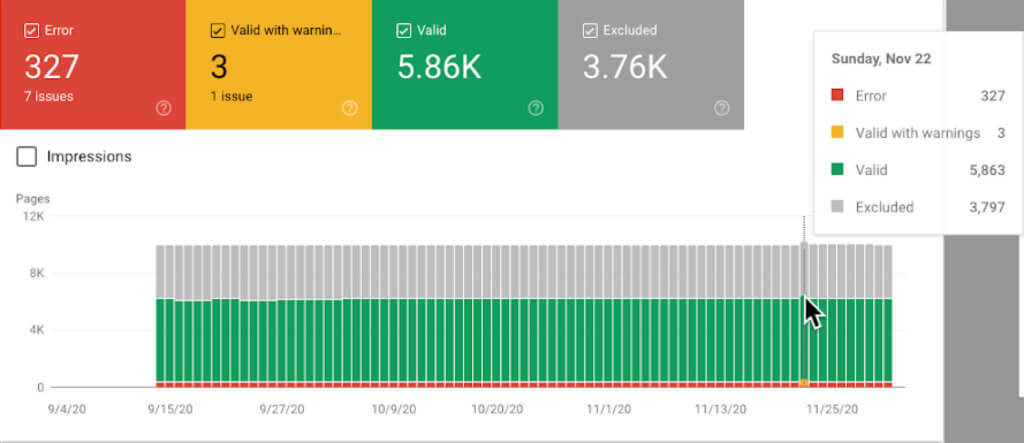

Der Indexabdeckungsbericht der Google Search Console zeigt den Status jeder Seite Ihrer Website an.

Der Bericht zeigt:

- Fehler: Umleitungsfehler, defekte Links und 404-Fehler

- Gültig mit Warnungen: Seiten, die indexiert sind, aber Probleme aufweisen, die möglicherweise beabsichtigt sind oder nicht

- Gültig: Erfolgreich indizierte Seiten

- Ausgeschlossen: Seiten, die von der Indexierung ausgeschlossen wurden, weil sie z. B. durch die robots.txt blockiert oder umgeleitet wurden

Kennzeichnen und beheben Sie Umleitungsfehler, um das Crawling und die Indexierung zu verbessern

Allen Seiten Ihrer Website wird ein HTTP-Statuscode zugewiesen. Jeder Code bezieht sich auf eine andere Funktion.

Screaming Frog zeigt diese in der Spalte Statuscode an:

Wenn alles in Ordnung ist, werden die meisten Seiten Ihrer Website einen 200-Statuscode zurückgeben, was bedeutet, dass die Seite in Ordnung ist. Seiten mit Fehlern zeigen einen 3xx-, 4xx- oder 5xx-Statuscode an.

Hier ist eine Übersicht über Codes, die Sie möglicherweise in Ihrem Audit sehen, und wie Sie die relevanten beheben können:

3xx Statuscodes

- 301: Permanente Weiterleitung. Inhalte wurden auf eine neue URL verschoben und der SEO-Wert der alten Seite wird weitergegeben.

301er sind in Ordnung, solange es keine Umleitungskette oder -schleife gibt, die mehrere Umleitungen verursacht. Wenn beispielsweise Redirect A zu Redirect B und C zu D führt, kann dies zu einer schlechten Benutzererfahrung und einer langsamen Seitengeschwindigkeit führen. Dies kann die Absprungrate erhöhen und Conversions beeinträchtigen. Um das Problem zu beheben, müssen Sie die Weiterleitungen B und C löschen, damit die Weiterleitung A direkt zu D geht.

Wenn Sie in Screaming Frog zu Berichte > Weiterleitungsketten gehen, können Sie den Crawling-Pfad Ihrer Weiterleitungen herunterladen und feststellen, welche 301-Fehler entfernt werden müssen.

- 302: Temporäre Umleitung. Inhalt wurde vorübergehend auf eine URL verschoben.

302er sind nützlich für Zwecke wie A/B-Tests, bei denen Sie eine neue Vorlage oder ein neues Layout testen möchten. Wenn 302 jedoch länger als drei Monate besteht, lohnt es sich, es zu einem 301 zu machen.

- 307: Temporäre Umleitung aufgrund einer Protokolländerung von der Quelle zum Ziel.

Diese Weiterleitung sollte verwendet werden, wenn Sie sicher sind, dass die Verschiebung vorübergehend ist und Sie immer noch die ursprüngliche URL benötigen.

4xx-Statuscodes

- 403: Zugriff verboten. Dies wird tendenziell angezeigt, wenn Inhalte hinter einem Login verborgen sind.

- 404: Seite existiert nicht aufgrund eines defekten Links oder wenn eine Seite oder ein Beitrag gelöscht wurde, aber die URL nicht umgeleitet wurde.

Wie Umleitungsketten sorgen 404-Fehler nicht für eine großartige Benutzererfahrung. Entfernen Sie alle internen Links, die auf 404-Seiten verweisen, und aktualisieren Sie sie mit dem umgeleiteten internen Link.

- 410: Seite dauerhaft gelöscht.

Überprüfen Sie jede Seite, die einen 410-Fehler anzeigt, um sicherzustellen, dass sie dauerhaft verschwunden sind und dass kein Inhalt eine 301-Weiterleitung rechtfertigen könnte.

- 429: Zu viele Serveranfragen in kurzer Zeit.

5xx-Statuscodes

Alle 5xx-Statuscodes sind serverbezogen. Sie zeigen an, dass der Server eine Anfrage nicht ausführen konnte. Obwohl diese Aufmerksamkeit erfordern, liegt das Problem bei Ihrem Hosting-Provider oder Webentwickler, nicht bei Ihrer Website.

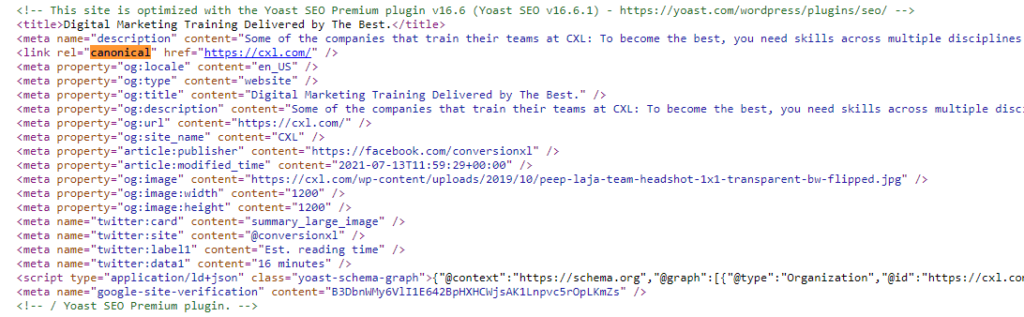

Richten Sie kanonische Tags ein, um Suchmaschinen auf wichtige Seiten hinzuweisen

Kanonische Meta-Tags erscheinen im Abschnitt <head> im Code einer Seite.

<link rel=“canonical“ href=“https://www.ihredomain.com/page-abc/“ />

Sie existieren, um Suchmaschinen-Bots mitzuteilen, welche Seite in SERPs indexiert und angezeigt werden soll, wenn Sie Seiten mit identischem oder ähnlichem Inhalt haben.

Angenommen, eine E-Commerce-Website verkaufte ein blaues Spielzeug-Polizeiauto, das unter „Spielzeug > Autos > blaues Spielzeug-Polizeiauto“ und „Spielzeug > Polizeiautos > blaues Spielzeugauto“ aufgeführt war.

Es ist auf beiden Seiten dasselbe blaue Spielzeugpolizeiauto. Der einzige Unterschied sind die Breadcrumb-Links, die Sie auf die Seite führen.

Durch das Hinzufügen eines Canonical Tags auf der „Masterpage“ ( Spielzeug > Autos ) signalisieren Sie Suchmaschinen, dass es sich um das Originalprodukt handelt. Bei dem unter „ Spielzeug > Polizeiautos > blaues Spielzeugauto“ aufgeführten Produkt handelt es sich um eine Kopie.

Ein weiteres Beispiel dafür, wann Sie kanonische Tags hinzufügen möchten, sind Seiten mit hinzugefügten URL-Parametern.

Beispielsweise würde „ https://www.ihredomain.com/toys“ ähnliche Inhalte wie „ https://www.ihredomain.com/toys?page=2“ oder „https://www.ihredomain.com/“ anzeigen . toys?price=descending“ , die zum Filtern von Ergebnissen verwendet wurden .

Ohne ein kanonisches Tag würden Suchmaschinen jede Seite als einzigartig behandeln. Dies bedeutet nicht nur, dass mehrere Seiten indiziert werden, wodurch der SEO-Wert Ihrer Masterseite verringert wird, sondern es erhöht auch Ihr Crawl-Budget.

Kanonische Tags können direkt zum <head> -Abschnitt im Seitencode zusätzlicher Seiten (nicht der Hauptseite) oder, wenn Sie ein CMS wie WordPress oder Magneto verwenden, Plugins wie Yoast SEO hinzugefügt werden, die den Prozess vereinfachen.

2. Überprüfen Sie Ihre Site-Architektur und Sitemap, um Inhalte barrierefrei zu machen

Das Ausführen eines Website-Crawls hilft, die meisten technischen Fehler auf Ihrer Website zu beheben. Jetzt müssen wir uns mit UX-Fehlern befassen.

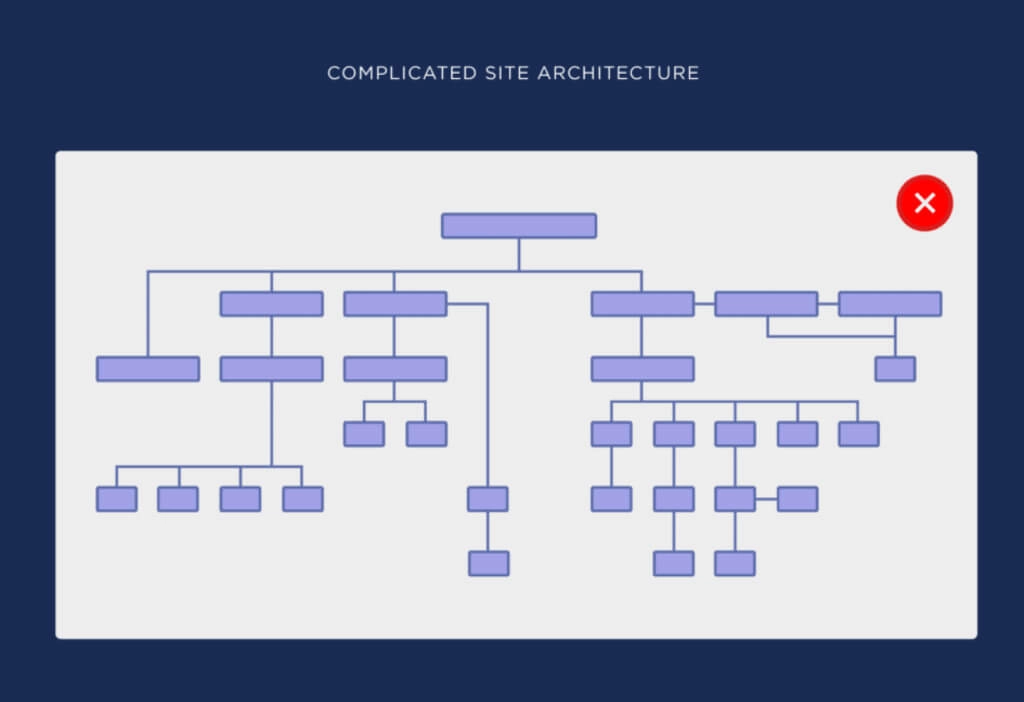

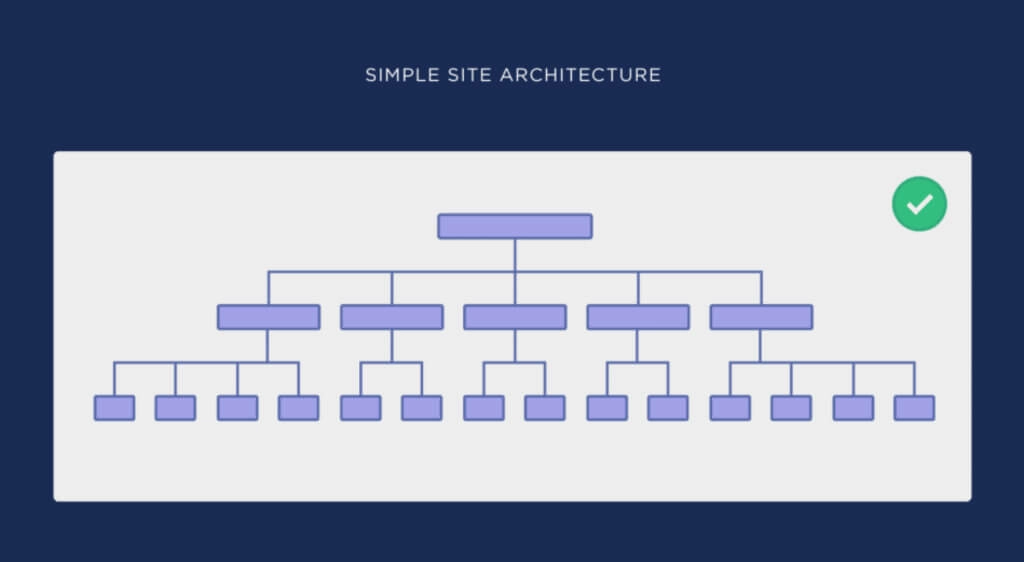

Wie wir oben erwähnt haben, sollte ein Benutzer in der Lage sein, mit wenigen Klicks dorthin zu gelangen, wo er auf Ihrer Website sein möchte. Eine einfachere menschliche Erfahrung ist gleichbedeutend mit einer einfacheren Suchbot-Erfahrung (was wiederum Crawl-Budget spart).

Daher muss Ihre Seitenstruktur logisch und konsistent sein. Dies wird erreicht, indem die Architektur Ihrer Website abgeflacht wird.

Hier sind Beispiele für komplizierte Seitenarchitekturen und einfache (flache) Seitenarchitekturen aus dem Backlinko-Leitfaden zum Thema:

Sie können im zweiten Bild sehen, wie viel einfacher es ist, von der Homepage zu einer anderen Seite der Website zu gelangen.

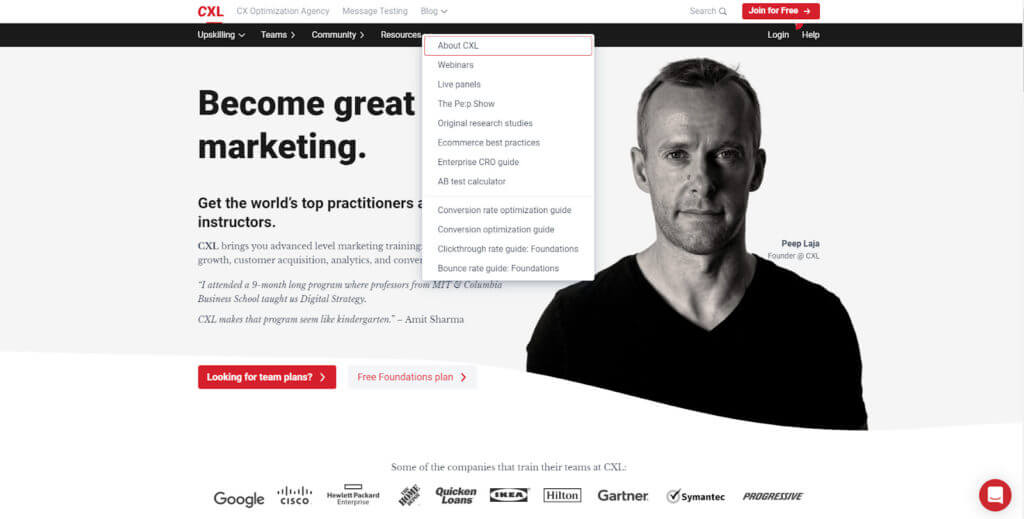

Ein Beispiel aus der Praxis finden Sie auf der CXL-Homepage:

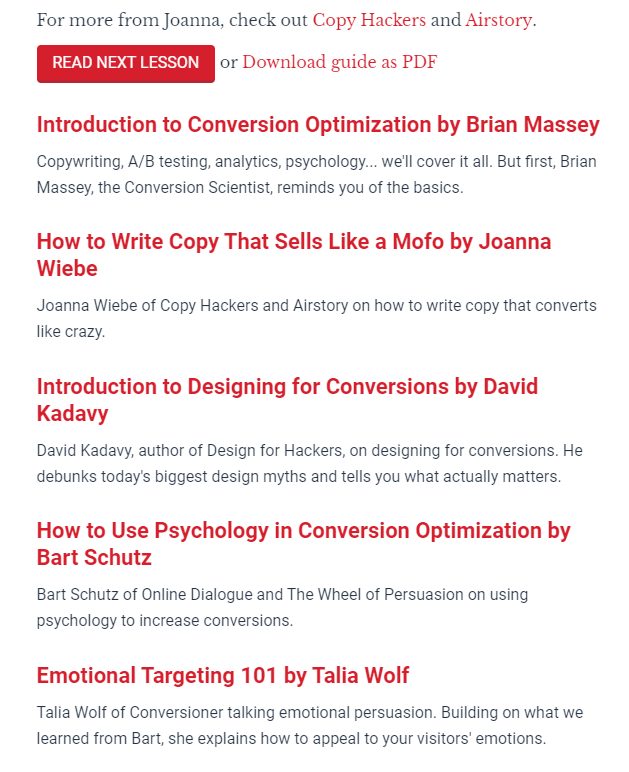

Mit drei Klicks komme ich zum gewünschten Inhalt: „How to Write Copy That Sells Like a Mofo by Joanna Wiebe.“

- Startseite > Ressourcen

- Ressourcen > Leitfaden zur Optimierung der Conversion-Rate

- Leitfaden zur Optimierung der Conversion-Rate > So schreiben Sie Texte, die sich wie ein Mofo verkaufen von Joanna Wiebe

Je näher eine Seite an Ihrer Homepage liegt, desto wichtiger ist sie. Daher sollten Sie versuchen, Seiten basierend auf Schlüsselwörtern neu zu gruppieren, um die für Ihr Publikum relevantesten näher an den Anfang der Website zu bringen.

Eine abgeflachte Website-Architektur sollte sich in ihrer URL-Struktur widerspiegeln.

Als wir beispielsweise zu „ cxl.com/conversion-rate-optimization/how-to-write-copy-that-sells-like-a-mofo-by-joanna-wiebe/“ navigierten, folgte die URL dem Pfad, den wir nahm. Und durch die Verwendung von Breadcrumbs können wir sehen, wie wir dorthin gekommen sind, damit wir leicht zurückkommen können.

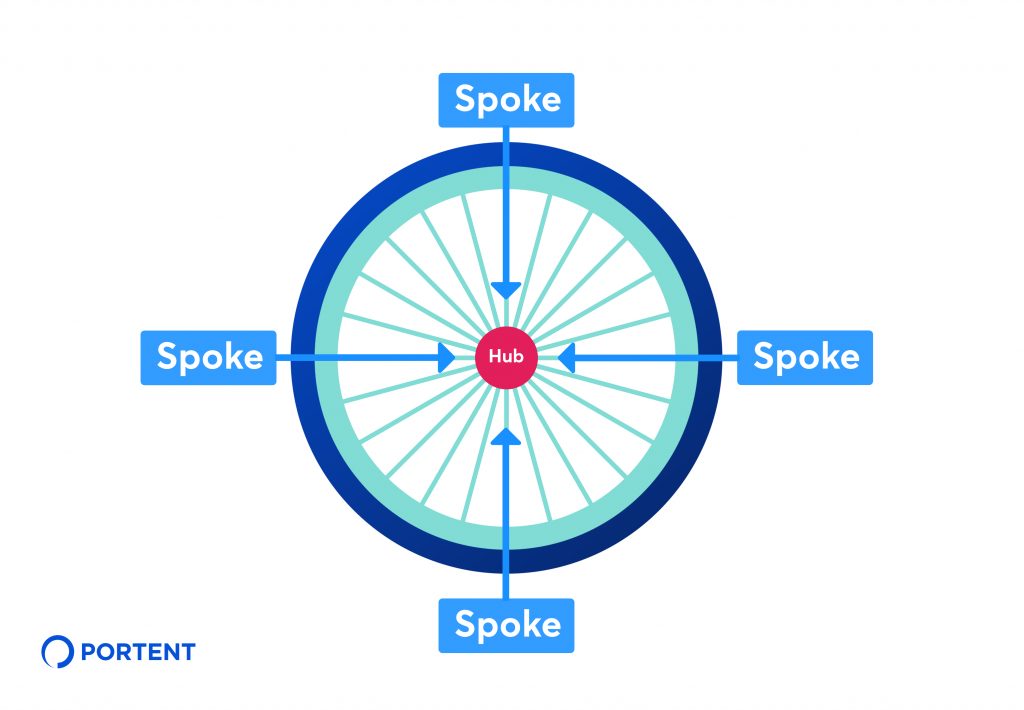

Verwenden Sie die Hub-and-Spoke-Methode, um eine konsistente SEO-Strategie zu erstellen und die Beziehung zwischen Inhalten zu organisieren.

Portent beschreibt diese Methode als „eine interne Verlinkungsstrategie, bei der mehrere Seiten mit verwandten Inhalten (manchmal als „Spoke“-Seiten bezeichnet) zurück zu einer zentralen Hub-Seite verknüpft werden“.

In unserem Beispiel „Conversion-Rate-Optimierung“ Guide ist der Hub, „How to Write Copy That Sells Like a Mofo von Joanna Wiebe“ ist eine Redewendung.

Abhängig von der Größe Ihrer Website benötigen Sie möglicherweise Hilfe von einem Webentwickler, um die Architektur zu vereinfachen und die Navigation zu überarbeiten. Sie können die Benutzererfahrung jedoch leicht verbessern, indem Sie interne Links zu relevanten Seiten hinzufügen.

Am Ende von „How to Write Copy That Sells Like a Mofo“ von Joanna Wiebe finden Sie beispielsweise Links zu anderen Spoken-Inhalten.

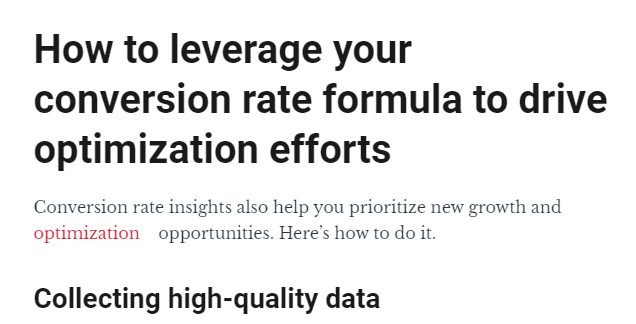

Dies kann auch im Textkörper erfolgen, indem Sie auf Seiten verlinken, die sich auf bestimmte Schlüsselwörter beziehen.

„Optimierung“ im obigen Bild verweist auf den CXL-Leitfaden zur Optimierung der Conversion-Rate.

Organisieren Sie Ihre Sitemap so, dass sie die Struktur Ihrer Website widerspiegelt

Die URLs auf Ihrer Website sollten mit denen in Ihrer XML-Sitemap übereinstimmen. Dies ist die Datei, auf die Sie Bots in Ihrer robots.txt als Leitfaden zum Crawlen Ihrer Website verweisen sollten.

Wie robots.txt können Sie Ihre XML-Sitemap finden, indem Sie „sitemap.xml“ am Ende Ihrer Root-Domain hinzufügen:

https://ihredomain.com/sitemap.xml

Wenn Sie Ihre Site-Architektur aktualisieren, muss auch Ihre Sitemap aktualisiert werden. Ein CMS wie WordPress, Yoast SEO oder Google XML-Sitemaps können eine Sitemap generieren und automatisch aktualisieren, wenn neue Inhalte erstellt werden. Andere Plattformen wie Wix und Squarespace haben ebenfalls integrierte Funktionen, die dasselbe tun.

Wenn Sie dies manuell tun müssen, generiert XML-Sitemaps automatisch eine XML-Sitemap, die Sie in den Ordner (/) Ihrer Website einfügen können. Sie sollten dies jedoch nur tun, wenn Sie mit diesen Dateien sicher umgehen können. Wenn nicht, holen Sie sich Hilfe von einem Webentwickler.

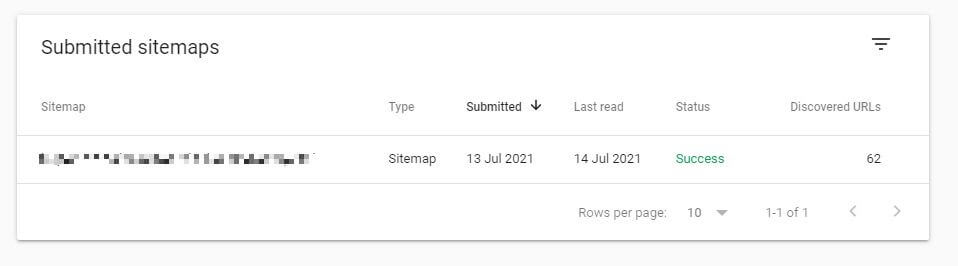

Sobald Sie Ihre aktualisierte Sitemap haben, reichen Sie sie unter Index > Sitemaps in der Google Search Console ein.

Von hier aus meldet Google alle Probleme mit der Crawlbarkeit und Indexierung.

Funktionierende Sitemaps zeigen den Status „Erfolg“ an. Wenn der Status „ Enthält Fehler “ oder „ Abrufen nicht möglich “ anzeigt, liegen wahrscheinlich Probleme mit dem Inhalt der Sitemap vor.

Wie bei Ihrer robots.txt-Datei sollte Ihre Sitemap keine Seiten enthalten, die Sie nicht in SERPs präsentieren möchten. Aber es sollte jede Seite enthalten, die Sie indizieren möchten, genau so, wie sie auf Ihrer Website erscheint.

Wenn Sie beispielsweise möchten, dass Google „ https://yourdomain.com/toys“ indexiert, sollte Ihre Sitemap genau diese Domain kopieren, einschließlich des HTTPS-Protokolls. „ http://yourdomain.com/toys“ oder „ /toys“ bedeutet, dass Seiten nicht gecrawlt werden.

3. Testen und verbessern Sie die Website-Geschwindigkeit und die Reaktionsfähigkeit auf Mobilgeräten

Die Geschwindigkeit der Website ist seit langem ein Faktor für das Ranking in Suchmaschinen. Google hat dies erstmals im Jahr 2010 bestätigt. Im Jahr 2018 haben sie den Einsatz erhöht, indem sie die Geschwindigkeit mobiler Seiten als Rankingfaktor in den mobilen Suchergebnissen eingeführt haben.

Beim Ranking einer Website nach Geschwindigkeit betrachtet Google zwei Datenpunkte:

1. Seitengeschwindigkeit : Wie lange es dauert, bis eine Seite geladen ist

2. Website-Geschwindigkeit: Die durchschnittliche Zeit, die zum Laden einer Stichprobe von Seitenaufrufen benötigt wird

Bei der Prüfung Ihrer Website müssen Sie sich nur auf die Seitengeschwindigkeit konzentrieren. Verbessern Sie die Seitenladezeit und Sie verbessern die Websitegeschwindigkeit. Google hilft Ihnen dabei mit seinem Analysetool PageSpeed Insights.

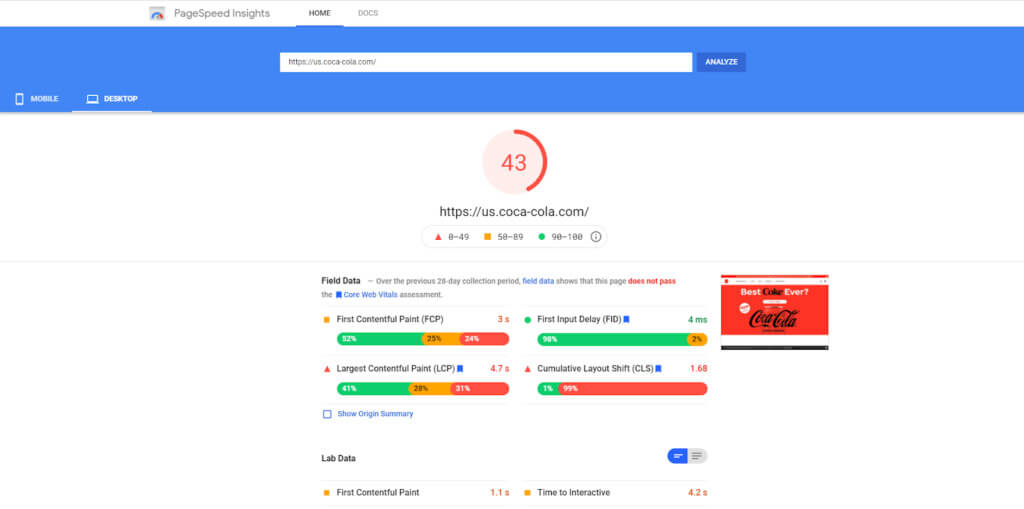

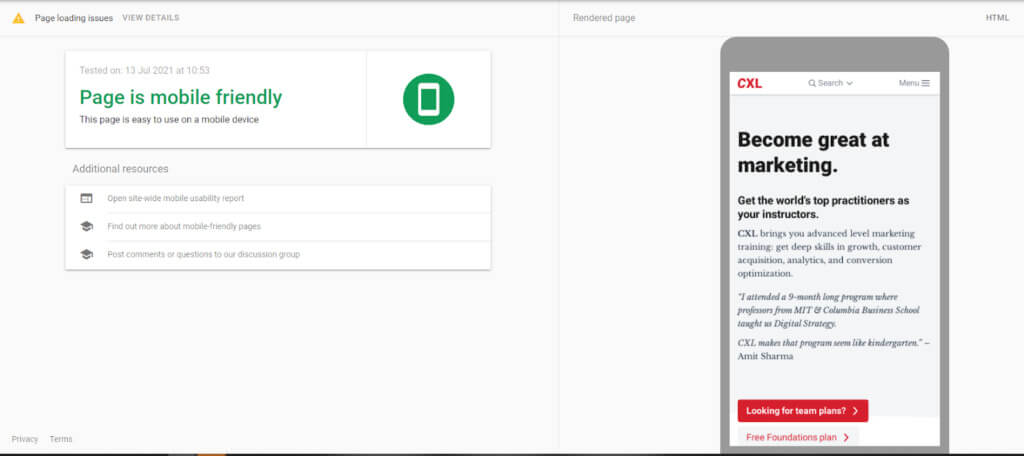

Geben Sie eine URL ein und PageSpeed Insights bewertet sie mit 0 bis 100. Die Punktzahl basiert auf realen Felddaten, die von Google Chrome-Browserbenutzern und Labordaten gesammelt wurden. Es wird auch Möglichkeiten zur Verbesserung aufzeigen.

Schlechtes Bild, JavaScript, CSS-Dateioptimierung und Browser-Caching-Praktiken sind in der Regel die Schuldigen für langsam ladende Seiten. Glücklicherweise sind diese leicht zu verbessern:

- Reduzieren Sie mit Optimizilla oder Squoosh die Größe von Bildern, ohne die Qualität zu beeinträchtigen. Wenn Sie WordPress verwenden, erledigen Optimierungs-Plugins wie Imagify Image Optimizer und TinyPNG die gleiche Aufgabe.

- Reduzieren Sie JavaScript- und CSS-Dateien, indem Sie Ihren Code in Minify einfügen, um Leerzeichen und Kommentare zu entfernen

- Wenn Sie WordPress verwenden, verwenden Sie W3 Total Cache oder WP Super Cache, um eine statische Version Ihrer Seiten zu erstellen und den Suchenden bereitzustellen, anstatt die Seite jedes Mal dynamisch generieren zu lassen, wenn eine Person darauf klickt. Wenn Sie WordPress nicht verwenden, kann das Caching manuell in Ihrem Site-Code aktiviert werden.

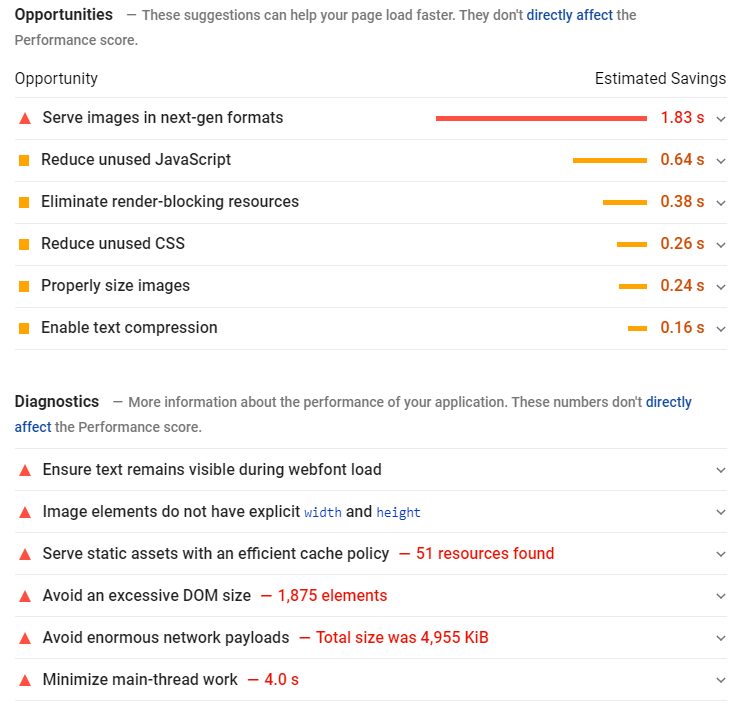

Beginnen Sie mit der Priorisierung Ihrer wichtigsten Seiten. Wenn Sie in Google Analytics zu Verhalten > Website-Geschwindigkeit gehen, zeigen die Messwerte, wie bestimmte Seiten in verschiedenen Browsern und Ländern abschneiden:

Vergleichen Sie dies mit Ihren meistbesuchten Seiten und arbeiten Sie Ihre Website von oben nach unten durch.

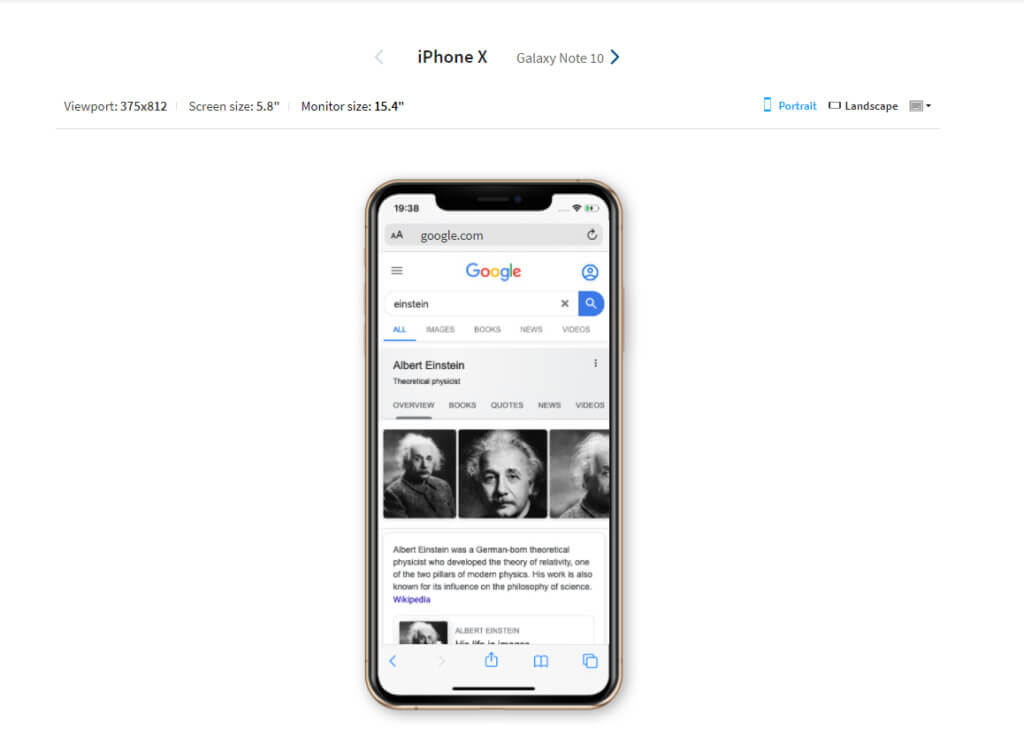

So finden Sie heraus, ob Ihre Website für Mobilgeräte optimiert ist

Im März 2021 führte Google die Mobile-First-Indexierung ein. Dies bedeutet, dass die von Google indizierten Seiten auf der mobilen Version Ihrer Website basieren. Daher hat die Leistung Ihrer Website auf kleineren Bildschirmen den größten Einfluss darauf, wo Ihre Website in SERPs erscheint.

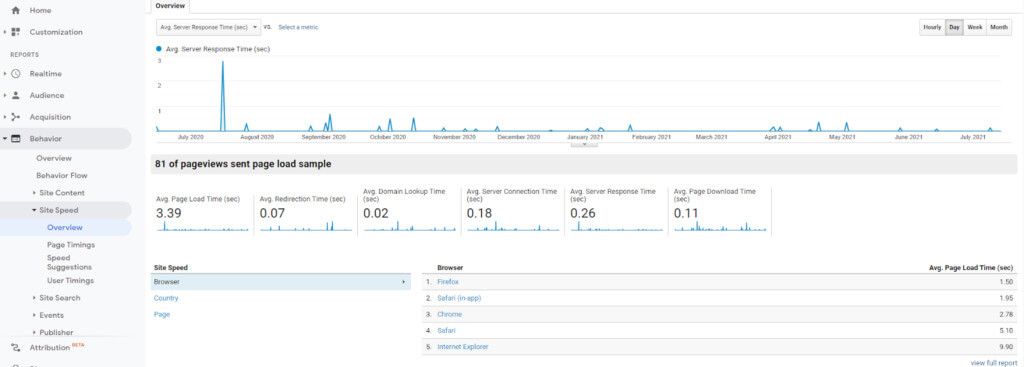

Mit dem Testtool für Mobilgeräte von Google können Sie ganz einfach überprüfen, ob Ihre Website für Mobilgeräte optimiert ist:

Wenn Sie ein responsives oder Mobile-First-Design verwenden, sollten Sie sich keine Sorgen machen. Beide wurden für die Darstellung auf kleineren Bildschirmen entwickelt, und alle Änderungen, die Sie als Ergebnis Ihres technischen SEO-Audits vornehmen, verbessern die Website- und Suchleistung auf allen Geräten.

Responsive Design garantiert jedoch noch keine großartige Benutzererfahrung, wie Shanelle Mullin in ihrem Artikel darüber demonstriert, warum Responsive Design keine mobile Optimierung ist.

Sie können Ihre Website mit dem responsiven Tool von BrowserStack auf echten Geräten testen:

Auch eigenständige mobile Websites sollten den Google-Test bestehen. Beachten Sie, dass separate Websites für Mobilgeräte und Desktops erfordern, dass Sie beide Versionen prüfen.

Eine weitere Option zur Verbesserung der Seitengeschwindigkeit auf Mobilgeräten sind Accelerated Mobile Pages (AMPs). AMP ist ein von Google unterstütztes Projekt, das entwickelt wurde, um Benutzern abgespeckte Versionen von Webseiten bereitzustellen, damit sie schneller als HTML geladen werden.

Google hat Tutorials und Richtlinien zum Erstellen von AMP-Seiten mit Code oder einem CMS-Plug-in. Es ist jedoch wichtig, sich darüber im Klaren zu sein, wie sich diese auf Ihre Website auswirken.

Jede von Ihnen erstellte AMP-Seite ist eine neue Seite, die neben dem Original existiert. Daher müssen Sie überlegen, wie sie in Ihr URL-Schema passen. Google empfiehlt die Verwendung der folgenden URL-Struktur:

http://www.example.com/myarticle/amp

http://www.example.com/myarticle.amp.html

Sie müssen auch sicherstellen, dass kanonische Tags verwendet werden, um die Masterseite zu identifizieren. Dies kann die AMP-Seite sein, aber die Originalseite wird bevorzugt. Dies liegt daran, dass AMP-Seiten eine Basisversion Ihrer Webseite bereitstellen, die es Ihnen nicht ermöglicht, Werbeeinnahmen zu erzielen oder auf dieselbe tiefgreifende Analyseebene zuzugreifen.

AMP-Seiten müssen genauso geprüft werden wie HTML-Seiten. Wenn Sie ein zahlender Abonnent sind, bietet Screaming Frog Funktionen, mit denen Sie AMP-Probleme finden und beheben können. Sie können dies in der kostenlosen Version tun, aber Sie müssen Ihre Seitenliste hochladen.

5. Finden und beheben Sie doppelte Inhalte und Keyword-Kannibalisierungsprobleme, um SEO zu optimieren

Zu diesem Zeitpunkt hat Ihre Inhaltsprüfung bereits begonnen. Durch das Hinzufügen von kanonischen Tags wird sichergestellt, dass Masterseiten gegenüber ähnlichen Seiten einen SEO-Wert erhalten. Die abgeflachte Website-Architektur erleichtert den Zugriff auf Ihre wichtigsten Inhalte. Was wir jetzt tun wollen, ist die Feinabstimmung.

Überprüfen Sie Ihre Website auf Duplicate Content

Seiten mit identischen Informationen sind nicht immer schlecht. Das Beispiel der Spielzeugpolizeiauto-Seiten, das wir zuvor verwendet haben, ist beispielsweise erforderlich, um den Benutzern relevante Ergebnisse zu liefern.

Sie werden zu einem Problem, wenn Sie eine Seite haben, die mit der Seite identisch ist, für die Sie ein Ranking erstellen möchten. In solchen Fällen lassen Sie Seiten um Rankings und Klicks konkurrieren und verwässern so ihr Potenzial.

Neben Produktseiten können Duplicate-Content-Probleme aus mehreren Gründen auftreten:

- Wiederverwendung von Kopfzeilen, Seitentiteln und Meta-Beschreibungen, um Seiten identisch erscheinen zu lassen, selbst wenn der Hauptinhalt es nicht ist

- Identische Seiten, die für historische oder Testzwecke verwendet werden, nicht löschen oder umleiten

- Kanonische Tags nicht zu einer einzelnen Seite mit mehreren URLs hinzufügen

Ein Website-Crawl hilft dabei, doppelte Seiten zu identifizieren. Überprüfen Sie den Inhalt auf Duplizierung von:

- Titel

- Header-Tags

- Meta-Beschreibungen

- Körperinhalt

Sie können diese Seiten dann entweder entfernen oder die duplizierten Elemente neu schreiben, um sie eindeutig zu machen.

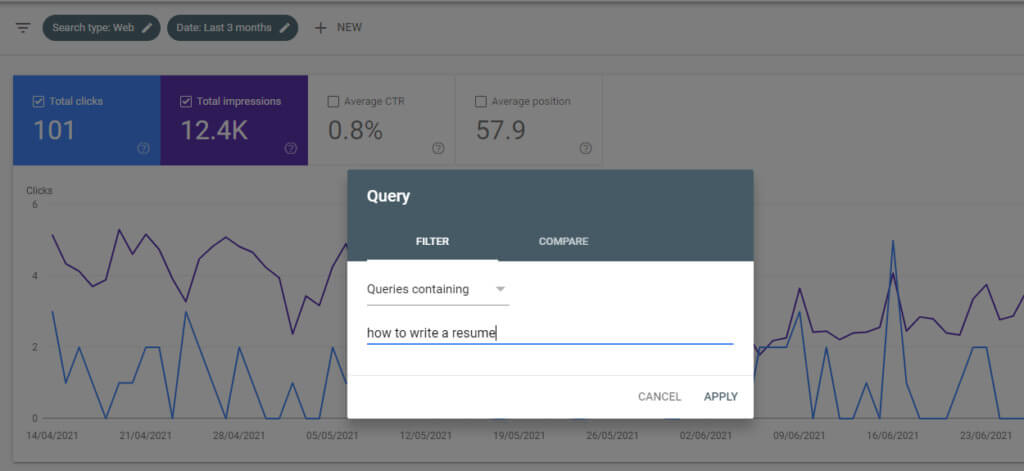

Führen Sie Inhalte zusammen, die ähnliche Keywords kannibalisieren

Die Kannibalisierung von Keywords ist wie Duplicate Content, da sie Suchmaschinen dazu zwingt, zwischen ähnlichen Inhalten zu wählen.

Es tritt auf, wenn Sie verschiedene Inhalte auf Ihrer Website haben, die für dieselbe Suchanfrage ranken. Entweder weil das Thema ähnlich ist oder Sie dieselben Keywords verwendet haben.

Angenommen, Sie haben zwei Beiträge geschrieben. Eine zum Thema „Wie schreibe ich einen Lebenslauf“, optimiert für den Ausdruck „Wie schreibe ich einen Lebenslauf“, und die andere zu „Tipps zum Schreiben von Lebensläufen“, optimiert für „Lebenslauf schreiben“.

Die Posts sind ähnlich genug, sodass Suchmaschinen Schwierigkeiten haben, herauszufinden, welcher am wichtigsten ist.

Wenn Sie „site: yourdomain.com + 'keyword“ googeln, können Sie leicht herausfinden, ob die Kannibalisierung von Keywords ein Problem darstellt.

Wenn Ihre Posts auf Platz 1 und 2 stehen, ist das kein Problem. Aber wenn Ihr Inhalt in den SERPs weiter unten rankt oder ein älterer Beitrag über einem aktualisierten rankt, lohnt es sich wahrscheinlich, sie zusammenzuführen:

- Gehen Sie zum Abschnitt Leistung Ihrer Google Search Console.

- Klicken Sie in den Filtern auf Neu > Abfrage und geben Sie das kannibalisierte Schlüsselwort ein.

- Auf der Registerkarte Seiten können Sie sehen, welche Seite den meisten Traffic für das Keyword erhält. Dies ist die Seite, mit der alle anderen zusammengeführt werden können.

Zum Beispiel könnte „Wie man einen Lebenslauf schreibt“ um Tipps zum Lebenslaufschreiben erweitert werden und zu einem endgültigen Leitfaden für das Schreiben von Lebensläufen werden.

Es wird nicht für jede Seite funktionieren. In einigen Fällen möchten Sie möglicherweise nicht mehr relevante Inhalte löschen. Aber wenn Keywords ähnlich sind, hilft das Kombinieren von Inhalten, Ihr Suchranking zu stärken.

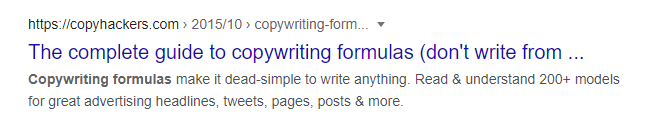

Verbessern Sie Titel-Tags und Meta-Beschreibungen, um Ihre Klickrate (CTR) in SERPs zu erhöhen

Titel-Tags und Meta-Beschreibungen sind zwar kein Ranking-Faktor, aber es ist nicht zu leugnen, dass sie einen Unterschied zu Ihrer Attraktivität machen. Sie sind im Wesentlichen eine Möglichkeit, für Ihre Inhalte zu werben.

Die Durchführung eines technischen SEO-Audits ist der ideale Zeitpunkt, um alte Titel und Beschreibungen zu optimieren und Lücken zu schließen, um die CTR in den SERPs zu verbessern.

Titel und Beschreibungen sollten natürlich, relevant und prägnant sein und Ihre Ziel-Keywords verwenden. Hier ist ein Beispiel aus dem Suchergebnis für Copyhackers' Guide to Copywriting Formulas:

Die Meta-Beschreibung sagt den Lesern, dass sie erfahren werden, warum Copywriting-Formeln nützlich sind und wie sie in der realen Welt angewendet werden können.

Obwohl der Titel auch aus SEO-Sicht stark ist, wurde er gekürzt. Dies liegt wahrscheinlich daran, dass die 600-Pixel-Grenze von Google überschritten wird. Beachten Sie diese Grenze beim Schreiben von Titeln.

Fügen Sie Schlüsselwörter am Anfang der Titel ein und versuchen Sie, die Zeichenzahl auf etwa 60 zu beschränken. Moz-Recherchen legen nahe, dass Sie davon ausgehen können, dass ~90 % Ihrer Titel richtig angezeigt werden, wenn sie unter dieser Grenze liegen.

Ebenso sollten Meta-Beschreibungen ungefähr 155-160 Zeichen lang sein, um ein Abschneiden zu vermeiden.

Beachten Sie, dass Google Ihre Meta-Beschreibung nicht immer verwendet. Abhängig von der Suchanfrage ziehen sie möglicherweise eine Beschreibung von Ihrer Website, um sie als Snippet zu verwenden. Das liegt außerhalb Ihrer Kontrolle. Aber wenn Ihre Ziel-Keywords in Ihren Meta-Tags vorhanden sind, verschaffen Sie sich einen Vorteil gegenüber anderen Ergebnissen, die nach ähnlichen Begriffen suchen.

Fazit

Die Durchführung eines technischen SEO-Audits hilft Ihnen, technische Elemente Ihrer Website zu analysieren und Bereiche zu verbessern, die die Suchleistung und das Benutzererlebnis beeinträchtigen.

Aber das Befolgen der Schritte in diesem Artikel löst nur alle Probleme, die Sie jetzt haben. Wenn Ihr Unternehmen wächst und sich Ihre Website weiterentwickelt und sich die Algorithmen von Google ändern, werden neue Probleme mit Links, Website-Geschwindigkeit und Inhalten auftreten.

Daher sollten technische Audits neben On-Page- und Off-Page-SEO-Bemühungen Teil einer fortlaufenden Strategie sein. Überprüfen Sie Ihre Website regelmäßig oder immer dann, wenn Sie Struktur- oder Designaktualisierungen an Ihrer Website vornehmen.