인공지능과 함께하는 전자음악의 미래

게시 됨: 2020-03-06미래에 컴퓨터 엔지니어가 작성한 코드 라인이 음악을 생성할 것이라고 말하면 어떨까요? 꽤 무서운 것 같죠?

소프트웨어가 음악을 만들고 인간이 그 과정에 참여할 필요가 없다고 상상하는 것은 매우 "미래적"인 것 같습니다. 그러나 미래에 대해 이야기하기 전에 AI가 음악을 만드는 방법을 이해하기 위해 전자 음악 프로덕션의 역사를 살펴봐야 합니다.

전자 음악 제작의 역사

전자음만으로 제작된 최초의 음악은 1950년대 독일에서 만들어졌습니다. 이전에 음악가들은 현, 해머, 전기 픽업으로 구성된 전자 기계 악기를 사용했습니다. 그러나 이러한 악기로 제작된 음악을 단순히 "일렉트로닉 음악"이라고 부를 수는 없습니다.

테레민 과 신디사이저 의 발명 이후 전자 음악의 기반이 형성되었습니다. 이 장치는 음악을 생성하기 위해 진동하는 현이 아니라 순수하게 전자 사운드를 사용했습니다.

인공 지능은 순수한 전자 사운드에서 음악을 만드는 것과 동일한 개념을 사용합니다.

이에 대해서는 나중에 이야기하겠지만 먼저 인공 지능이 무엇인지, 코드 묶음으로 음악을 만드는 방법을 살펴보겠습니다.

인공 지능이란 무엇입니까?

인공 지능은 "지능적인" 문제 해결 행동의 탐색과 "지능적인" 컴퓨터 시스템의 생성을 의미합니다. 인공 지능은 이미 대부분의 소프트웨어에서 없어서는 안될 부분입니다. 일반적으로 인공 지능은 명확하게 정의되지 않은 환경에서 인간과 유사한 의사 결정 구조를 시뮬레이션하려고 합니다.

공상 과학 영화에서 본 인공 지능의 가장 일반적인 예는 아이언 맨의 자비스와 자율 주행 첨단 우주선입니다.

인공 지능이 음악 멜로디, 드럼, 코드 및 기타 모든 필수 음악 요소를 먼저 만드는 방법을 이해하려면 AI가 일반적으로 어떻게 작동하는지 알아야 합니다.

AI는 어떻게 작동합니까?

AI는 더 나은 결과를 제공하는 상호 작용과 증거 기반 답변을 통해 학습하는 인지 시스템입니다. 인공 지능은 과거에 기록된 데이터와 사실로부터 결과를 평가합니다.

데이터셋이라고 하는 미리 기록된 데이터와 팩트가 많이 있습니다. 데이터 세트는 AI 알고리즘의 입력으로 작동합니다. 기계 학습 코드는 "RAW" 데이터에서 패턴을 추출하고 이 데이터에서 결론을 도출하는 데 도움이 됩니다. 전체 프로세스가 쉽게 들릴지 모르지만 상당히 복잡합니다.

인공 지능으로 어떻게 예술과 음악을 만들 수 있습니까?

머신 러닝은 결과를 처리하기 위해 데이터가 필요합니다. 따라서 관련 데이터를 데이터 세트로 제공하면 알고리즘을 학습시켜 예술 작품을 만들 수 있습니다. 예술을 만들기 위해 AI는 특정 규칙이 필요하지 않으며 수천 개의 미학적으로 만족스러운 예술 이미지만 있으면 됩니다. AI는 학습한 미학에서 새로운 이미지를 생성합니다.

에드몬드 벨라미의 초상(Portrait of Edmond Bellamy)은 무려 432,500달러에 팔린 작품입니다. 매혹적인 예술 작품을 만드는 수많은 AI 아티스트가 있습니다.

컴퓨터 과학자와 신경망 전문가는 인공 지능이 인간의 개입 없이 음악을 만들 수 있는 다음 단계로 기계 학습과 인공 지능을 발전시키길 원합니다.

AI로 음악 만들기

앞서 언급했듯이 전자 음악은 순수한 전자 사운드를 사용합니다. 함께 연결하면 사운드 샘플을 만드는 작은 샘플이 있습니다. 이러한 사운드 샘플의 다른 유형은 음악을 만드는 과정 전반에 걸쳐 사용됩니다.

사운드 샘플에는 초당 48,000개의 샘플이 있습니다. AI 알고리즘은 이러한 사운드를 조작하여 고유한 사운드 샘플을 만들 수 있습니다.

AI는 이러한 사운드 빌딩 블록을 사용하여 수천 곡의 노래를 분석하고 고유한 노래를 만들 수 있습니다. 모든 AI 소프트웨어는 딥 러닝을 사용하여 머신 러닝 모델을 분석하고 훈련합니다.

AI는 음표의 길이, 코드 템포, 각 음표가 서로 어떻게 연관되는지를 파악할 수 있습니다. 예를 들어, 노래의 분위기를 선택할 수 있습니다. 관현악 곡을 만들려면 사용되는 모든 소리가 관현악 소리가 됩니다. IBM Watson Beat, Google N Synth, Spotify의 Research Lab, Melodrive 및 Amper Music과 같은 최고의 회사를 포함하여 이 특정 분야를 중심으로 전체 산업이 활동하고 있습니다.

그들 중 일부는 MIDI 파일을 제공하는 반면 일부는 DAW에서 나중에 조작할 수 있는 다른 오디오 파일의 줄기를 제공합니다.

가장 인기 있는 AI 아티스트 두 명인 Google의 N Synth와 Amber Music을 살펴보겠습니다.

구글 마젠타의 N 신디사이저

N Synth는 "신경망" 신디사이저를 나타냅니다. Neural synth는 Google의 오픈 소스 연구 프로젝트로, 예술과 음악을 만드는 창의적인 과정에서 기계 학습 기반 AI의 역할을 탐구합니다.

Google의 마젠타색 스튜디오는 기계 학습의 도움으로 소리와 샘플을 생성하는 데 사용할 수 있는 플랫폼을 만들었습니다. 두 개의 서로 다른 사운드 샘플을 추가할 수 있으며 다른 조합으로 다양한 사운드 샘플을 생성할 수 있습니다.

현재 마젠타는 Ableton 라이브 플러그인과 Windows 및 Mac OS용 독립 실행형 소프트웨어와 함께 제공됩니다. Magenta는 샘플로 다양한 사운드를 생성할 수 있으며 오디오 파일을 사용하여 서로 쌓거나 DAW에서 재배열할 수 있습니다.

엠퍼뮤직.

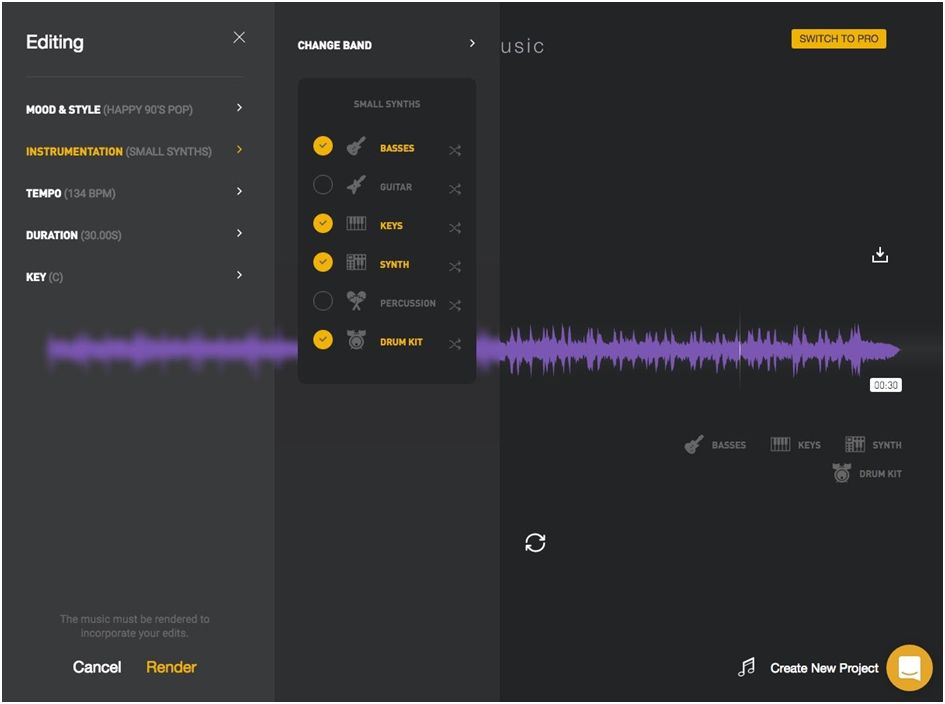

Ampermusic AI 음악 제작 플랫폼은 다른 플랫폼 중에서 가장 유망합니다. Ampere는 사용하기 쉽기 때문에 손쉽게 음악을 만드는 데 가장 인기 있는 플랫폼입니다.

그들의 웹사이트에 로그인하고 장르와 분위기를 선택하기만 하면 됩니다. 간단합니다. 필요에 따라 변경할 수 있는 오디오 파일을 제공합니다.

Amper에서 제공하는 음악은 전혀 나쁘지 않습니다. 유튜브 프로모션이나 직접 만든 영상의 배경음악으로 활용하실 수 있습니다. "코딩된" 음악과 "작성된" 음악을 구분할 수 없습니다.

결론

일부 음악 프로듀서에게는 기계 학습 알고리즘이 노래를 만들 수 있다는 생각이 매우 '끔찍'합니다. 지금은 AI가 그래미상을 받을 수 있는 곡을 만들기에는 턱없이 부족하다. 그러나 이것은 혁명의 시작에 불과합니다.

이때 인공 지능은 음악을 만드는 강력한 도구로 사용될 수 있습니다. 그래도 미래에는 AI가 인간 음악가를 대체할 만큼 충분히 능력이 있지만 어느 정도 수준입니다. 인간에게는 창의성이 있는 반면 AI는 여러 곡을 분석해 새로운 노래를 만듭니다.

따라서 현재로서는 AI가 협업을 위한 신뢰할 수 있는 도구이며 음악을 만드는 과정을 가속화한다고 말할 수 있습니다.