Zukunft der elektronischen Musik mit künstlicher Intelligenz

Veröffentlicht: 2020-03-06Was ist, wenn ich Ihnen sage, dass in Zukunft von Computeringenieuren geschriebene Codezeilen Musik produzieren werden? Es sieht ziemlich beängstigend aus, oder?

Sich vorzustellen, dass ein Stück Software Musik macht und Menschen nicht an dem Prozess teilnehmen müssen, erscheint sehr „futuristisch“. Aber bevor wir über die Zukunft sprechen, müssen wir einen Blick auf die Geschichte der elektronischen Musikproduktion werfen, um zu verstehen, wie eine KI Musik machen kann.

Geschichte der Produktion elektronischer Musik

Das erste Musikstück, das nur mit elektronischem Ton produziert wurde, entstand in den 1950er Jahren in Deutschland. Davor verwendeten Musiker elektromechanische Instrumente, die aus Saiten, Hämmern und elektrischen Tonabnehmern bestanden. Aber Musik, die von diesen Instrumenten produziert wird, kann nicht nur als „elektronische Musik“ bezeichnet werden.

Nach der Erfindung von Theremin und Synthesizern wurde die Basis der elektronischen Musik geschaffen. Diese Geräte verwendeten ausschließlich elektronischen Klang und nicht die vibrierenden Saiten, um die Musik zu erzeugen.

Künstliche Intelligenz wird das gleiche Konzept verwenden, um Musik aus einem rein elektronischen Klang zu erzeugen.

Wir werden später darüber sprechen, aber zuerst werfen wir einen Blick darauf, was künstliche Intelligenz ist und wie ein Haufen Codes ein Musikstück machen kann.

Was ist Künstliche Intelligenz?

Künstliche Intelligenz bedeutet die Erforschung eines „intelligenten“ Problemlösungsverhaltens und die Schaffung „intelligenter“ Computersysteme. Künstliche Intelligenz ist bereits fester Bestandteil der meisten Software. Generell versucht Künstliche Intelligenz, menschenähnliche Entscheidungsstrukturen in einer nicht klar definierten Umgebung zu simulieren.

Die häufigsten Beispiele für künstliche Intelligenz, die wir in Science-Fiction-Filmen gesehen haben, sind Jarvis aus Iron Man und selbstfahrende Hightech-Raumschiffe.

Um zu verstehen, wie künstliche Intelligenz musikalische Melodien, Trommeln, Akkorde und all die anderen wesentlichen musikalischen Elemente erschafft, müssen wir zuerst sehen, wie eine KI im Allgemeinen funktioniert.

Wie funktioniert KI?

KI ist ein kognitives System, das durch Interaktionen und evidenzbasierte Antworten lernt, die bessere Ergebnisse liefern. Künstliche Intelligenz wertet Ergebnisse aus in der Vergangenheit erfassten Daten und Fakten aus.

Es gibt eine Reihe von vorab aufgezeichneten Daten und Fakten, die als Datensatz bezeichnet werden. Der Datensatz dient als Eingabe für den KI-Algorithmus. Der Machine-Learning-Code extrahiert Muster aus den „RAW“-Daten und hilft, daraus eine Schlussfolgerung zu ziehen. Der ganze Prozess mag mühelos klingen, ist aber ziemlich kompliziert.

Wie können wir Kunst und Musik mit künstlicher Intelligenz erschaffen?

Maschinelles Lernen benötigt Daten, um Ergebnisse zu verarbeiten. Wenn wir also relevante Daten als unseren Datensatz bereitstellen, können wir unseren Algorithmus trainieren, um Kunstwerke zu erstellen. Um Kunst zu machen, braucht die KI kein bestimmtes Regelwerk, alles, was sie braucht, sind Tausende von ästhetisch ansprechenden Bildern von Kunst, und sie wird neue Bilder aus der erlernten Ästhetik erstellen.

„Portrait of Edmond Bellamy“ ist ein Kunstwerk, das für satte 432.500 Dollar verkauft wurde. Es gibt eine Fülle von KI-Künstlern da draußen, die faszinierende Kunstwerke erschaffen.

Informatiker und Experten für neuronale Netze wollen maschinelles Lernen und künstliche Intelligenz auf die nächste Stufe heben, auf der KI ohne menschliches Eingreifen Musik machen kann.

Musik machen mit KI

Wie ich bereits erwähnt habe, verwendet elektronische Musik rein elektronische Klänge. Es gibt kleine Samples, die aneinandergereiht ein Sound-Sample ergeben. Verschiedene Arten dieser Klangbeispiele werden während des gesamten Prozesses des Musikmachens verwendet.

Ein Soundsample enthält 48.000 Samples pro Sekunde. KI-Algorithmen können diese Klänge manipulieren, um ein einzigartiges Klangbeispiel zu erstellen.

KI kann diese Klangbausteine verwenden, um Tausende von Songs zu analysieren und daraus ihren einzigartigen Song zu machen. Die gesamte KI-Software verwendet Deep Learning, um ihr maschinelles Lernmodell zu analysieren und dann zu trainieren.

Die KI kann die Länge der Noten, das Tempo der Akkorde und die Beziehung zwischen den einzelnen Noten erfassen. Sie können beispielsweise die Stimmung des Liedes auswählen. Wenn Sie ein Orchesterlied machen möchten, werden alle verwendeten Klänge Orchesterklänge sein. Es gibt eine ganze Branche, die in diesem speziellen Bereich arbeitet, darunter Top-Unternehmen wie IBM Watson Beat, Google N Synth, Spotifys Research Lab, Melodrive und Amper Music.

Einige von ihnen liefern MIDI-Dateien, während andere Stems der verschiedenen Audiodateien liefern, die später in der DAW bearbeitet werden können.

Werfen wir einen Blick auf zwei der beliebtesten KI-Künstler: Googles N Synth und Amber Music.

Google Magentas N Synth

N Synth steht für „Neural“-Synth. Der neuronale Synthesizer ist Googles Open-Source-Forschungsprojekt, das die Rolle der durch maschinelles Lernen unterstützten KI im kreativen Prozess des Kunst- und Musikmachens untersucht.

Das Magenta-Studio von Google hat eine Plattform geschaffen, mit der mithilfe von Machine Learning Sounds und Samples generiert werden können. Sie können zwei verschiedene Klangbeispiele hinzufügen und es können viele verschiedene Klangbeispiele mit unterschiedlichen Kombinationen erzeugt werden.

Im Moment wird Magenta mit dem Ableton Live-Plug-in und einer eigenständigen Software für Windows und Mac OS geliefert. Magenta kann verschiedene Sounds als Samples erzeugen, die Sie dann mit der Audiodatei übereinander stapeln oder in einer DAW neu anordnen können.

Amper Musik.

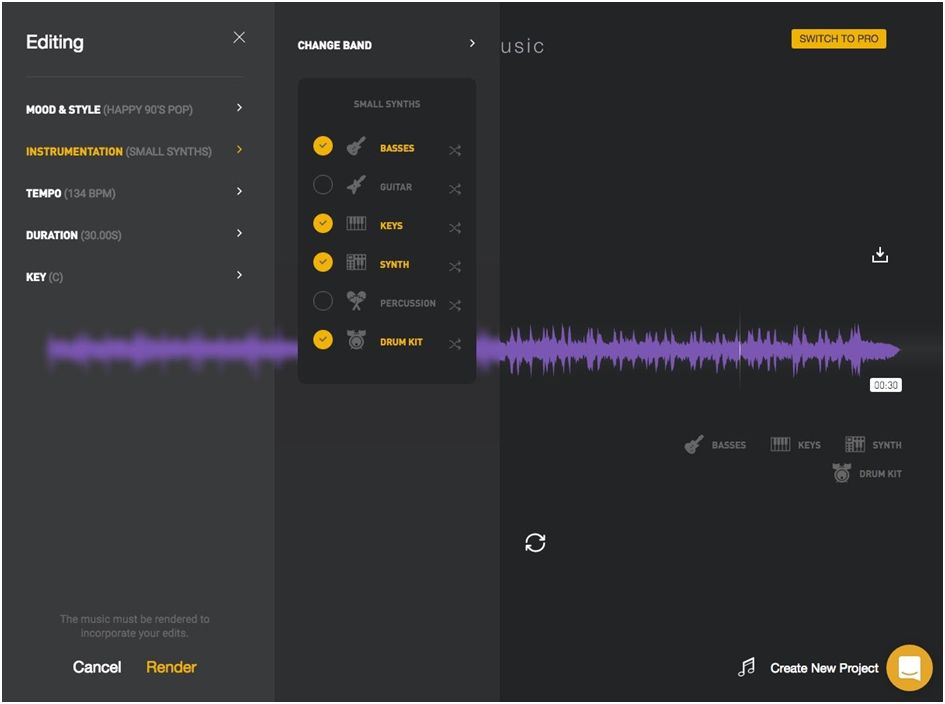

Die Musikproduktionsplattform Ampermusic AI ist die vielversprechendste unter anderen Plattformen. Die Benutzerfreundlichkeit von Ampere macht es zur beliebtesten Plattform, um mühelos Musik zu machen.

Sie müssen sich nur auf ihrer Website anmelden, ein Genre und eine Stimmung auswählen, und das war's. So einfach ist das. Es gibt Ihnen Audiodateien, die Sie nach Bedarf ändern können.

Die Musik von Amper ist überhaupt nicht schlecht. Es kann in Youtube-Werbeaktionen oder als Hintergrundmusik für ein von Ihnen erstelltes Video verwendet werden. Man kann nicht zwischen „kodierter“ Musik und „geschriebener“ Musik unterscheiden.

Fazit

Für einige Musikproduzenten ist die Vorstellung, dass ein maschineller Lernalgorithmus einen Song erstellen kann, sehr „gespenstisch“. Im Moment ist KI nicht gut genug, um einen Song zu machen, der bei Grammys einen Preis gewinnen kann. Aber das ist erst der Anfang einer Revolution.

Derzeit kann künstliche Intelligenz als mächtiges Werkzeug zur Musikproduktion eingesetzt werden. Dennoch ist die KI in der Zukunft in der Lage, menschliche Musiker zu ersetzen, aber auf einem bestimmten Niveau. Menschen haben einen Sinn für Kreativität, während KI eine Reihe von Songs analysiert und daraus dann einen neuen Song erstellt.

Im Moment können wir also nur sagen, dass KI ein zuverlässiges Werkzeug für die Zusammenarbeit ist und den Prozess des Musikmachens beschleunigt.