人工知能による電子音楽の未来

公開: 2020-03-06将来的には、コンピューターエンジニアが書いたコード行が音楽を生み出すとしたらどうでしょう。 かなり怖そうですね。

ソフトウェアが音楽を作り、人間がそのプロセスに参加する必要がないことを想像すると、非常に「未来的」に思えます。 しかし、将来について話す前に、AIがどのように音楽を作ることができるかを理解するために、電子音楽制作の歴史を見る必要があります。

電子音楽制作の歴史

電子音だけで制作された最初の音楽は、1950年代にドイツで作成されました。 これまで、ミュージシャンは、弦、ハンマー、電気ピックアップで構成される電気機械式の楽器を使用していました。 しかし、これらの楽器によって生み出される音楽は、単に「電子音楽」と呼ぶことはできません。

テルミンとシンセサイザーの発明後、電子音楽の基盤が形成されました。 これらのデバイスは、音楽を生成するために振動する弦ではなく、純粋に電子音を使用していました。

人工知能は、純粋に電子的な音から音楽を作成するという同じ概念を使用します。

これについては後で説明しますが、最初に、人工知能とは何か、そして一連のコードがどのように音楽を作ることができるかを見てみましょう。

人工知能とは何ですか?

人工知能とは、「インテリジェントな」問題解決行動の探求と「インテリジェントな」コンピューターシステムの作成を意味します。 人工知能はすでにほとんどのソフトウェアの不可欠な部分です。 一般に、人工知能は、明確に定義されていない環境で人間と同様の意思決定構造をシミュレートしようとします。

私たちがSF映画で見た人工知能の最も一般的な例は、アイアンマンのジャービスと自動運転のハイテク宇宙船です。

人工知能がどのように音楽のメロディー、ドラム、コード、およびその他すべての重要な音楽要素を最初に作成するかを理解するには、AIが一般的にどのように機能するかを確認する必要があります。

AIはどのように機能しますか?

AIは、より良い結果を提供する相互作用と証拠に基づく回答を通じて学習する認知システムです。 人工知能は、過去に記録されたデータと事実からの結果を評価します。

データセットと呼ばれる事前に記録されたデータと事実がたくさんあります。 データセットは、AIアルゴリズムの入力として機能します。 機械学習コードは、「RAW」データからパターンを抽出し、そこから結論を引き出すのに役立ちます。 プロセス全体は簡単に聞こえるかもしれませんが、それは非常に複雑です。

人工知能を使ってアートと音楽を作成するにはどうすればよいですか?

機械学習には、結果を処理するためのデータが必要です。 したがって、関連するデータをデータセットとして提供すれば、アルゴリズムをトレーニングしてアート作品を作成できます。 アートを作成するために、AIは特定のルールセットを必要としません。必要なのは、何千もの美的に心地よいアートの画像であり、学習した美学から新しい画像を作成します。

「エドモンドベラミーの肖像」は、なんと432,500ドルで販売された芸術作品です。 魅惑的なアート作品を作成しているAIアーティストはたくさんいます。

コンピューター科学者とニューラルネットワークの専門家は、機械学習と人工知能を次のレベルに引き上げたいと考えています。AIは、人間の介入なしに音楽を作成できます。

AIで音楽を作る

先に述べたように、電子音楽は純粋に電子的な音を使用します。 一緒につながれると、音のサンプルを作る小さなサンプルがあります。 これらのサウンドサンプルのさまざまなタイプは、音楽を作成するプロセス全体で使用されます。

サウンドサンプルには、1秒あたり48,000のサンプルがあります。 AIアルゴリズムは、これらのサウンドを操作して、独自のサウンドサンプルを作成できます。

AIは、これらのサウンドの構成要素を使用して、何千もの曲を分析し、それから独自の曲を作成できます。 すべてのAIソフトウェアは、ディープラーニングを使用して、機械学習モデルを分析してトレーニングします。

AIは、音符の長さ、和音のテンポ、および各音符が互いにどのように相互に関連するかを取得できます。 たとえば、曲のムードを選択できます。オーケストラの曲を作成する場合は、使用されるすべてのサウンドがオーケストラのサウンドになります。 IBM Watson Beat、Google N Synth、SpotifyのResearch Lab、Melodrive、Amper Musicなどのトップ企業を含め、この特定の分野に取り組んでいる業界全体があります。

それらのいくつかはMIDIファイルを提供しますが、それらのいくつかは後でDAWで操作できるさまざまなオーディオファイルのステムを提供します。

最も人気のある2人のAIアーティスト、GoogleのNSynthとAmberMusicを見てみましょう。

GoogleマゼンタのNシンセ

N Synthは、「Neural」Synthの略です。 ニューラルシンセはGoogleのオープンソースの研究プロジェクトであり、芸術や音楽を作る創造的なプロセスにおける機械学習を活用したAIの役割を探求しています。

Googleのマゼンタスタジオは、機械学習を利用してサウンドとサンプルを生成するために使用できるプラットフォームを作成しました。 2つの異なるサウンドサンプルを追加でき、さまざまな組み合わせでさまざまなサウンドサンプルを生成できます。

現時点では、マゼンタにはAbletonライブプラグインとWindowsおよびMacOS用のスタンドアロンソフトウェアが付属しています。 マゼンタはサンプルとしてさまざまなサウンドを生成できます。その後、オーディオファイルを使用してそれらを積み重ねたり、DAWで再配置したりできます。

アンパーミュージック。

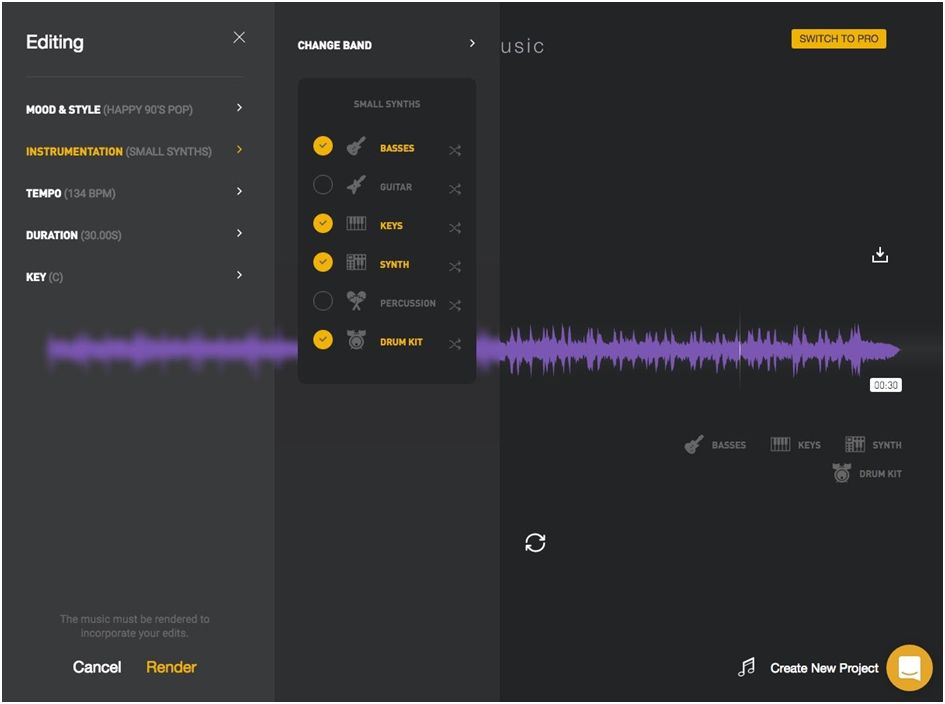

Ampermusic AI音楽制作プラットフォームは、他のプラットフォームの中で最も有望です。 Ampereは使いやすく、音楽を簡単に作成するための最も人気のあるプラットフォームになっています。

あなたは彼らのウェブサイトにログオンし、ジャンルとムードを拾う必要があります、そしてそれはそれだけです。 とても簡単です。 必要に応じて変更できるオーディオファイルを提供します。

アンペアが提供する音楽は決して悪くはありません。 YouTubeのプロモーションで使用したり、作成したビデオのバックグラウンドミュージックとして使用したりできます。 「コード化された」音楽と「書かれた」音楽を区別することはできません。

結論

一部の音楽プロデューサーにとって、機械学習アルゴリズムで曲を作成できるという考えは非常に「不気味」です。 現在、AIはグラミー賞を受賞できる曲を作るのに十分ではありません。 しかし、これは革命の始まりにすぎません。

現時点では、人工知能は音楽を制作するための強力なツールとして使用できます。 それでも、将来的には、AIは人間のミュージシャンに取って代わるのに十分な能力がありますが、ある程度はそうです。 AIがたくさんの曲を分析し、それから新しい曲を作成している間、人間には創造性の感覚があります。

したがって、現時点では、AIはコラボレーションのための信頼できるツールであり、音楽制作のプロセスをスピードアップしていると言えます。