Google CALM: O nouă tehnologie de model lingvistic

Publicat: 2022-12-20Google a anunțat o tehnologie inovatoare numită CALM care accelerează modelele mari de limbaj (cum ar fi GPT-3 și LaMDA) fără a compromite nivelurile de performanță.

Datele mai mari de antrenament sunt mai bune, dar au un cost

Modelele de limbaj mari (LLM) se antrenează pe cantități mari de date.

Antrenarea modelelor lingvistice pe cantități mai mari de date are ca rezultat modelul să învețe noi abilități pentru care nu sunt întotdeauna planificate.

De exemplu, adăugarea mai multor date de antrenament la un model de limbă poate duce în mod neașteptat la obținerea capacității acestuia de a traduce între diferite limbi, chiar dacă nu a fost instruit să facă asta.

Aceste noi abilități sunt numite abilități emergente, abilități pentru care nu sunt neapărat planificate.

O altă lucrare de cercetare (PDF) despre abilitățile emergente afirmă:

„Deși există zeci de exemple de abilități emergente, în prezent există puține explicații convingătoare pentru ce astfel de abilități apar în felul în care apar.”

Ei nu pot explica de ce sunt învățate diferite abilități.

Dar este bine cunoscut faptul că mărirea cantității de date pentru antrenarea mașinii îi permite să câștige mai multe abilități.

Dezavantajul creșterii datelor de antrenament este că este nevoie de mai multă putere de calcul pentru a produce o ieșire, ceea ce face ca AI să fie mai lentă în momentul în care generează o ieșire de text (un moment numit „timpul de inferență”).

Deci, compromisul cu a face o IA mai inteligentă cu mai multe date este că AI devine și mai lent la momentul deducerii.

Noua lucrare de cercetare Google ( Confident Adaptive Language Modeling PDF) descrie problema astfel:

„Progresele recente în modelele de limbaj mari (LLM) bazate pe Transformer au condus la îmbunătățiri semnificative ale performanței în multe sarcini.

Aceste câștiguri vin cu o creștere drastică a dimensiunii modelelor, ceea ce poate duce la o utilizare lentă și costisitoare la momentul deducerii.”

Modelarea limbajului adaptiv încrezător (CALM)

Cercetătorii de la Google au găsit o soluție interesantă pentru accelerarea modelelor lingvistice, menținând totodată performanța ridicată.

Soluția, pentru a face o analogie, seamănă oarecum cu diferența dintre a răspunde la o întrebare ușoară și a rezolva una mai dificilă.

La o întrebare ușoară, cum ar fi ce culoare este cerul, se poate răspunde cu puțină gândire.

Dar un răspuns greu necesită ca cineva să se oprească și să se mai gândească puțin pentru a găsi răspunsul.

Din punct de vedere computațional, modelele mari de limbaj nu fac o distincție între o parte grea a unei sarcini de generare de text și o parte ușoară.

Ele generează text atât pentru părțile ușoare, cât și pentru cele dificile folosind puterea lor de calcul completă la momentul deducerii.

Soluția Google se numește Confident Adaptive Language Modeling (CALM).

Ceea ce face acest nou cadru este să dedice mai puține resurse porțiunilor banale ale unei sarcini de generare de text și să dedice toată puterea pentru părțile mai dificile.

Lucrarea de cercetare despre CALM precizează problema și soluția astfel:

„Progresele recente în modelele de limbaj mari (LLM) bazate pe Transformer au condus la îmbunătățiri semnificative ale performanței în multe sarcini.

Aceste câștiguri vin cu o creștere drastică a dimensiunii modelelor, ceea ce poate duce la o utilizare lentă și costisitoare la momentul deducerii.

În practică, însă, seria de generații realizată de LLM este compusă din diferite niveluri de dificultate.

În timp ce anumite predicții beneficiază cu adevărat de capacitatea deplină a modelelor, alte continuări sunt mai banale și pot fi rezolvate cu un calcul redus.

… În timp ce modelele mari se descurcă mai bine în general, este posibil să nu fie necesară aceeași cantitate de calcul pentru fiecare intrare pentru a obține performanțe similare (de exemplu, în funcție de dacă intrarea este ușoară sau dificilă).”

Ce este Google CALM și funcționează?

CALM funcționează prin alocarea dinamică a resurselor în funcție de complexitatea părții individuale a sarcinii, folosind un algoritm pentru a prezice dacă ceva are nevoie de resurse complete sau parțiale.

Lucrarea de cercetare împărtășește că au testat noul sistem pentru diverse sarcini de procesare a limbajului natural („rezumat text, traducere automată și răspuns la întrebări”) și au descoperit că au fost capabili să accelereze inferența cu un factor de aproximativ trei (300%). .

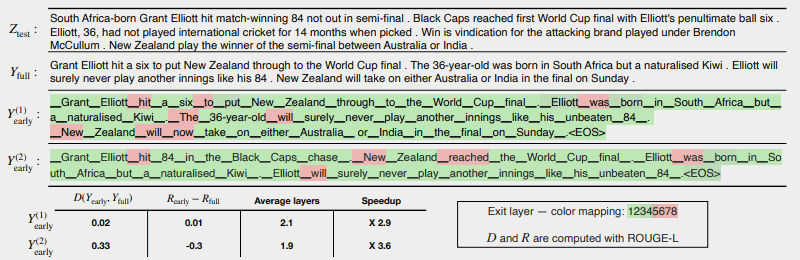

Următoarea ilustrație arată cât de bine funcționează sistemul CALM.

Cele câteva zone în roșu indică locul în care mașina a trebuit să-și folosească întreaga capacitate pentru acea secțiune a sarcinii.

Zonele în verde sunt unde mașina a folosit doar mai puțin de jumătate din capacitate.

Roșu = Capacitate completă/Verde = Capacitate mai mică de jumătate

Iată ce spune lucrarea de cercetare despre ilustrația de mai sus:

„CALM accelerează generarea prin ieșirea timpurie atunci când este posibil și folosind selectiv capacitatea completă a decodorului doar pentru câteva jetoane, demonstrat aici pe un exemplu CNN/DM cu măsură de încredere bazată pe softmax. Y (1) timpuriu și Y (2) timpuriu folosesc praguri de încredere diferite pentru ieșirea timpurie.

Mai jos (sic) text, raportăm coerența textuală măsurată și a riscului pentru fiecare dintre cele două rezultate, împreună cu câștigurile de eficiență.

Culorile reprezintă numărul de straturi de decodare utilizate pentru fiecare jeton - nuanțele de verde deschis indică mai puțin de jumătate din totalul straturilor.

Doar câteva jetoane selectate folosesc întreaga capacitate a modelului (colorate în roșu), în timp ce pentru majoritatea jetoanelor modelul iese după unul sau câteva straturi de decodare (colorate în verde).

Cercetătorii au încheiat lucrarea remarcând că implementarea CALM necesită doar modificări minime pentru a adapta un model de limbaj mare pentru a deveni mai rapid.

Această cercetare este importantă deoarece deschide ușa pentru crearea de modele AI mai complexe care sunt antrenate pe seturi de date substanțial mai mari, fără a experimenta o viteză mai mică, menținând în același timp un nivel ridicat de performanță.

Cu toate acestea, este posibil ca această metodă să beneficieze și de modele de limbaj mari care sunt antrenate și pe mai puține date.

De exemplu, modelele InstructGPT, dintre care ChatGPT este un model frate, sunt antrenate pe aproximativ 1,3 miliarde de parametri, dar sunt încă capabile să depășească modelele care sunt antrenate pe mult mai mulți parametri.

Cercetătorii au remarcat în concluzie:

„În general, cadrul nostru complet de calcul adaptiv pentru LM necesită modificări minime ale modelului de bază și permite câștiguri de eficiență, satisfacând în același timp garanții riguroase de calitate pentru rezultat.”

Aceste informații despre această lucrare de cercetare tocmai au fost publicate pe blogul Google AI pe 16 decembrie 2022. Lucrarea de cercetare în sine este datată 25 octombrie 2022.

Va fi interesant de văzut dacă această tehnologie ajunge în modelele de limbaj mari ale viitorului apropiat.

Citiți postarea Google pe blog:

Accelerarea generării de text cu modelarea limbajului adaptiv încrezător (CALM)

Citiți lucrarea de cercetare:

Modelare de limbaj adaptiv încrezător (PDF)

Imagine prezentată de Shutterstock/Master1305