Google CALM: Eine neue Sprachmodelltechnologie

Veröffentlicht: 2022-12-20Google kündigte eine bahnbrechende Technologie namens CALM an, die große Sprachmodelle (wie GPT-3 und LaMDA) beschleunigt, ohne die Leistungsfähigkeit zu beeinträchtigen.

Größere Trainingsdaten sind besser, aber mit Kosten verbunden

Large Language Models (LLMs) trainieren mit großen Datenmengen.

Das Training der Sprachmodelle mit größeren Datenmengen führt dazu, dass das Modell neue Fähigkeiten erlernt, die nicht immer vorgesehen sind.

Beispielsweise kann das Hinzufügen weiterer Trainingsdaten zu einem Sprachmodell unerwartet dazu führen, dass es die Fähigkeit erhält, zwischen verschiedenen Sprachen zu übersetzen, obwohl es dafür nicht trainiert wurde.

Diese neuen Fähigkeiten werden emergente Fähigkeiten genannt, Fähigkeiten, die nicht unbedingt geplant sind.

In einem anderen Forschungsbericht (PDF) über emergente Fähigkeiten heißt es:

„Obwohl es Dutzende von Beispielen für emergente Fähigkeiten gibt, gibt es derzeit nur wenige überzeugende Erklärungen dafür, warum solche Fähigkeiten auf diese Weise entstehen.“

Sie können nicht erklären, warum unterschiedliche Fähigkeiten erlernt werden.

Aber es ist bekannt, dass die Skalierung der Datenmenge zum Trainieren der Maschine dazu führt, dass sie mehr Fähigkeiten erhält.

Der Nachteil des Hochskalierens der Trainingsdaten besteht darin, dass mehr Rechenleistung benötigt wird, um eine Ausgabe zu erzeugen, wodurch die KI langsamer wird, wenn sie eine Textausgabe generiert (ein Moment, der als „Inferenzzeit“ bezeichnet wird).

Der Kompromiss, eine KI mit mehr Daten intelligenter zu machen, besteht also darin, dass die KI zur Inferenzzeit auch langsamer wird.

Das neue Forschungspapier von Google ( Confident Adaptive Language Modeling PDF) beschreibt das Problem wie folgt:

„Die jüngsten Fortschritte bei Transformer-basierten Large Language Models (LLMs) haben zu erheblichen Leistungsverbesserungen bei vielen Aufgaben geführt.

Diese Gewinne gehen mit einer drastischen Vergrößerung der Modelle einher, was möglicherweise zu einer langsamen und kostspieligen Verwendung zum Zeitpunkt der Inferenz führt.“

Selbstbewusste adaptive Sprachmodellierung (CALM)

Forscher bei Google stießen auf eine interessante Lösung, um die Sprachmodelle zu beschleunigen und gleichzeitig eine hohe Leistung beizubehalten.

Die Lösung, um eine Analogie zu machen, ist so etwas wie der Unterschied zwischen der Beantwortung einer einfachen Frage und der Lösung einer schwierigeren.

Eine einfache Frage, wie die Farbe des Himmels, kann mit wenig Nachdenken beantwortet werden.

Aber eine schwierige Antwort erfordert, dass man innehält und ein wenig mehr nachdenkt, um die Antwort zu finden.

Rechnerisch unterscheiden große Sprachmodelle nicht zwischen einem schwierigen Teil einer Textgenerierungsaufgabe und einem einfachen Teil.

Sie generieren Text sowohl für die einfachen als auch für die schwierigen Teile, indem sie zur Inferenzzeit ihre volle Rechenleistung nutzen.

Die Lösung von Google heißt Confident Adaptive Language Modeling (CALM).

Was dieses neue Framework tut, ist, weniger Ressourcen für triviale Teile einer Textgenerierungsaufgabe aufzuwenden und die volle Leistung für schwierigere Teile aufzuwenden.

Das Forschungspapier zu CALM beschreibt das Problem und die Lösung wie folgt:

„Die jüngsten Fortschritte bei Transformer-basierten Large Language Models (LLMs) haben zu erheblichen Leistungsverbesserungen bei vielen Aufgaben geführt.

Diese Gewinne gehen mit einer drastischen Vergrößerung der Modelle einher, was möglicherweise zu einer langsamen und kostspieligen Verwendung zum Zeitpunkt der Inferenz führt.

In der Praxis setzt sich die Generationsreihe der LLMs jedoch aus unterschiedlichen Schwierigkeitsgraden zusammen.

Während bestimmte Vorhersagen wirklich von der vollen Kapazität der Modelle profitieren, sind andere Fortsetzungen trivialer und können mit reduzierter Rechenleistung gelöst werden.

…Während große Modelle im Allgemeinen besser abschneiden, ist möglicherweise nicht für jede Eingabe der gleiche Rechenaufwand erforderlich, um eine ähnliche Leistung zu erzielen (z. B. je nachdem, ob die Eingabe einfach oder schwierig ist).“

Was ist Google CALM und funktioniert es?

CALM funktioniert durch dynamisches Zuweisen von Ressourcen in Abhängigkeit von der Komplexität des einzelnen Teils der Aufgabe, wobei ein Algorithmus verwendet wird, um vorherzusagen, ob etwas vollständige oder teilweise Ressourcen benötigt.

Das Forschungspapier teilt mit, dass sie das neue System für verschiedene Aufgaben zur Verarbeitung natürlicher Sprache („Textzusammenfassung, maschinelle Übersetzung und Beantwortung von Fragen“) getestet und festgestellt haben, dass sie die Inferenz um etwa den Faktor drei (300 %) beschleunigen konnten. .

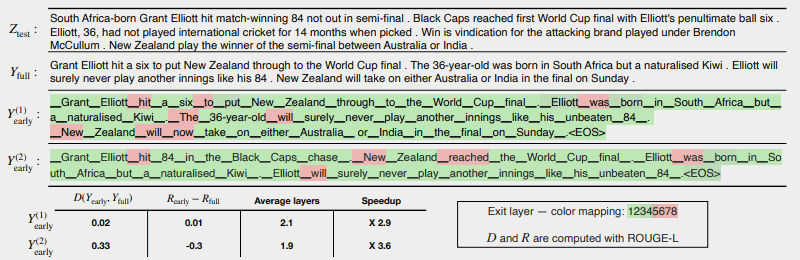

Die folgende Abbildung zeigt, wie gut das CALM-System funktioniert.

Die wenigen Bereiche in Rot zeigen an, wo die Maschine bei diesem Abschnitt der Aufgabe ihre volle Kapazität nutzen musste.

In den grünen Bereichen hat die Maschine nur weniger als die Hälfte ausgelastet.

Rot = Volle Kapazität/Grün = Weniger als die Hälfte der Kapazität

Folgendes sagt das Forschungspapier über die obige Abbildung:

„CALM beschleunigt die Generierung durch frühzeitiges Beenden, wenn möglich, und selektives Verwenden der vollen Decoderkapazität nur für wenige Token, wie hier an einem CNN/DM-Beispiel mit Softmax-basiertem Konfidenzmaß demonstriert. Y (1) früh und Y (2) früh verwenden unterschiedliche Konfidenzschwellen für einen frühen Ausstieg.

Unter (sic) dem Text berichten wir die gemessene Text- und Risikokonsistenz jedes der beiden Ergebnisse zusammen mit den Effizienzgewinnen.

Die Farben stellen die Anzahl der Decodierungsschichten dar, die für jedes Token verwendet werden – hellgrüne Schattierungen zeigen weniger als die Hälfte der gesamten Schichten an.

Nur wenige ausgewählte Token nutzen die volle Kapazität des Modells (in Rot eingefärbt), während bei den meisten Token das Modell nach einer oder wenigen Decodierungsschichten (in Grün eingefärbt) aussteigt.“

Die Forscher schlossen das Papier mit der Feststellung, dass die Implementierung von CALM nur minimale Änderungen erfordert, um ein großes Sprachmodell anzupassen, damit es schneller wird.

Diese Forschung ist wichtig, da sie die Tür zur Erstellung komplexerer KI-Modelle öffnet, die auf wesentlich größeren Datensätzen trainiert werden, ohne dass die Geschwindigkeit verringert wird, während ein hohes Leistungsniveau beibehalten wird.

Es ist jedoch möglich, dass diese Methode auch großen Sprachmodellen zugute kommt, die ebenfalls mit weniger Daten trainiert werden.

Zum Beispiel werden InstructGPT-Modelle, von denen ChatGPT ein Geschwistermodell ist, mit etwa 1,3 Milliarden Parametern trainiert, sind aber immer noch in der Lage, Modelle zu übertreffen, die mit wesentlich mehr Parametern trainiert wurden.

Die Forscher stellten in der Schlussfolgerung fest:

„Insgesamt erfordert unser vollständiges adaptives Compute-Framework für LMs minimale Änderungen am zugrunde liegenden Modell und ermöglicht Effizienzgewinne bei gleichzeitiger Erfüllung strenger Qualitätsgarantien für die Ausgabe.“

Diese Informationen zu dieser Forschungsarbeit wurden soeben am 16. Dezember 2022 im KI-Blog von Google veröffentlicht. Die Forschungsarbeit selbst ist vom 25. Oktober 2022 datiert.

Es wird interessant sein zu sehen, ob diese Technologie den Weg in große Sprachmodelle der nahen Zukunft finden wird.

Lesen Sie den Blogbeitrag von Google:

Beschleunigung der Textgenerierung mit Confident Adaptive Language Modeling (CALM)

Lesen Sie das Forschungspapier:

Zuverlässige adaptive Sprachmodellierung (PDF)

Vorgestelltes Bild von Shutterstock/Master1305