Google CALM: nowa technologia modelu językowego

Opublikowany: 2022-12-20Firma Google ogłosiła przełomową technologię o nazwie CALM, która przyspiesza duże modele językowe (takie jak GPT-3 i LaMDA) bez uszczerbku dla poziomu wydajności.

Większe dane treningowe są lepsze, ale wiążą się z kosztami

Duże modele językowe (LLM) uczą się na dużych ilościach danych.

Trenowanie modeli językowych na większej ilości danych powoduje, że model uczy się nowych możliwości, które nie zawsze są planowane.

Na przykład dodanie większej liczby danych szkoleniowych do modelu językowego może nieoczekiwanie spowodować, że uzyska on możliwość tłumaczenia między różnymi językami, nawet jeśli nie został do tego przeszkolony.

Te nowe zdolności nazywane są zdolnościami wyłaniającymi się, zdolnościami, które niekoniecznie są planowane.

W innym artykule badawczym (PDF) na temat pojawiających się zdolności stwierdza się:

„Chociaż istnieją dziesiątki przykładów pojawiających się zdolności, obecnie istnieje niewiele przekonujących wyjaśnień, dlaczego takie zdolności pojawiają się w taki sposób”.

Nie potrafią wyjaśnić, dlaczego uczy się różnych zdolności.

Ale dobrze wiadomo, że zwiększenie ilości danych do szkolenia maszyny pozwala jej zdobyć więcej umiejętności.

Wadą skalowania w górę danych treningowych jest to, że do wygenerowania danych wyjściowych potrzeba większej mocy obliczeniowej, co powoduje, że sztuczna inteligencja jest wolniejsza w momencie generowania danych wyjściowych tekstowych (moment nazywany „czasem wnioskowania”).

Tak więc kompromis polegający na uczynieniu sztucznej inteligencji inteligentniejszą z większą ilością danych polega na tym, że sztuczna inteligencja staje się również wolniejsza w czasie wnioskowania.

Nowy artykuł badawczy Google ( Confident Adaptive Language Modeling PDF) opisuje problem w następujący sposób:

„Ostatnie postępy w dużych modelach językowych (LLM) opartych na transformatorze doprowadziły do znacznej poprawy wydajności wielu zadań.

Zyski te wiążą się z drastycznym wzrostem rozmiaru modeli, co potencjalnie prowadzi do powolnego i kosztownego użytkowania w czasie wnioskowania”.

Pewne adaptacyjne modelowanie językowe (CALM)

Badacze z Google wpadli na ciekawe rozwiązanie pozwalające przyspieszyć modele językowe przy jednoczesnym zachowaniu wysokiej wydajności.

Rozwiązanie, aby dokonać analogii, przypomina trochę różnicę między udzieleniem odpowiedzi na łatwe pytanie a rozwiązaniem trudniejszego.

Na proste pytanie, takie jak kolor nieba, można odpowiedzieć bez zastanowienia.

Ale trudna odpowiedź wymaga zatrzymania się i zastanowienia się trochę więcej, aby znaleźć odpowiedź.

Obliczeniowo duże modele językowe nie rozróżniają trudnej części zadania generowania tekstu od łatwej części.

Generują tekst zarówno dla łatwych, jak i trudnych części, wykorzystując pełną moc obliczeniową w czasie wnioskowania.

Rozwiązanie Google nazywa się Confident Adaptive Language Modeling (CALM).

Ta nowa struktura polega na poświęceniu mniejszej ilości zasobów na trywialne części zadania generowania tekstu i poświęceniu pełnej mocy trudniejszym częściom.

Artykuł badawczy na temat CALM przedstawia problem i rozwiązanie w następujący sposób:

„Ostatnie postępy w dużych modelach językowych (LLM) opartych na transformatorze doprowadziły do znacznej poprawy wydajności wielu zadań.

Zyski te wiążą się z drastycznym wzrostem rozmiaru modeli, co potencjalnie prowadzi do powolnego i kosztownego użytkowania w czasie wnioskowania.

W praktyce jednak seria generacji tworzonych przez LLM składa się z różnych poziomów trudności.

Podczas gdy niektóre prognozy naprawdę korzystają z pełnej wydajności modeli, inne kontynuacje są bardziej trywialne i można je rozwiązać przy zmniejszonej mocy obliczeniowej.

… Chociaż duże modele generalnie radzą sobie lepiej, taka sama ilość obliczeń może nie być wymagana dla każdego wejścia, aby osiągnąć podobną wydajność (np. w zależności od tego, czy dane wejściowe są łatwe, czy trudne).”

Co to jest Google CALM i czy działa?

CALM działa poprzez dynamiczną alokację zasobów w zależności od złożoności poszczególnych części zadania, używając algorytmu do przewidywania, czy coś wymaga pełnych, czy częściowych zasobów.

W artykule naukowym podano, że przetestowali nowy system pod kątem różnych zadań związanych z przetwarzaniem języka naturalnego („podsumowanie tekstu, tłumaczenie maszynowe i odpowiadanie na pytania”) i odkryli, że byli w stanie przyspieszyć wnioskowanie około trzykrotnie (300%) .

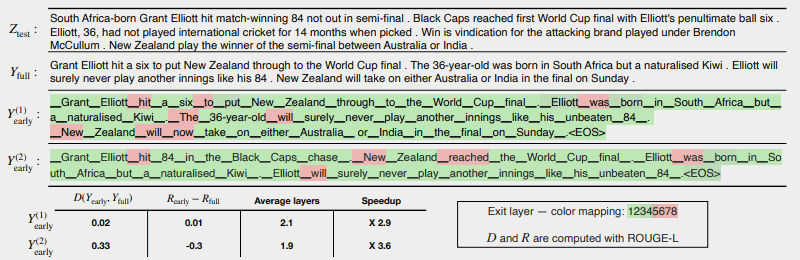

Poniższa ilustracja pokazuje, jak dobrze działa system CALM.

Kilka obszarów zaznaczonych na czerwono wskazuje miejsca, w których maszyna musiała w pełni wykorzystać swoje możliwości w tej części zadania.

Obszary zaznaczone na zielono to miejsca, w których maszyna zużywała mniej niż połowę wydajności.

Czerwony = pełna pojemność/zielony = mniej niż połowa pojemności

Oto, co artykuł badawczy mówi o powyższej ilustracji:

„CALM przyspiesza generowanie, jeśli to możliwe, wczesne wychodzenie i selektywne wykorzystywanie pełnej pojemności dekodera tylko dla kilku tokenów, co zademonstrowano tutaj na przykładzie CNN/DM z miarą pewności opartą na softmax. Y (1) wcześnie i Y (2) wcześnie używają różnych progów ufności dla wczesnego wyjścia.

Poniżej (sic) tekstu przedstawiamy zmierzoną spójność tekstu i ryzyka dla każdego z dwóch wyników, wraz ze wzrostem wydajności.

Kolory reprezentują liczbę warstw dekodowania użytych dla każdego żetonu — jasnozielone odcienie wskazują mniej niż połowę wszystkich warstw.

Tylko kilka wybranych tokenów wykorzystuje pełną pojemność modelu (kolor czerwony), podczas gdy dla większości tokenów model kończy się po jednej lub kilku warstwach dekodowania (kolor zielony).”

Naukowcy zakończyli artykuł, zauważając, że wdrożenie CALM wymaga jedynie minimalnych modyfikacji w celu dostosowania dużego modelu językowego, aby stał się szybszy.

Te badania są ważne, ponieważ otwierają drzwi do tworzenia bardziej złożonych modeli sztucznej inteligencji, które są szkolone na znacznie większych zestawach danych bez odczuwania mniejszej szybkości przy zachowaniu wysokiego poziomu wydajności.

Jednak możliwe jest, że ta metoda może również przynieść korzyści dużym modelom językowym, które są również szkolone na mniejszej ilości danych.

Na przykład modele InstructGPT, których bliźniaczym modelem jest ChatGPT, są szkolone na około 1,3 miliarda parametrów, ale nadal są w stanie przewyższyć modele, które są szkolone na znacznie większej liczbie parametrów.

Naukowcy zauważyli w konkluzji:

„Ogólnie rzecz biorąc, nasza kompletna adaptacyjna platforma obliczeniowa dla LM wymaga minimalnych modyfikacji podstawowego modelu i umożliwia wzrost wydajności przy jednoczesnym spełnieniu rygorystycznych gwarancji jakości danych wyjściowych”.

Ta informacja o tym artykule badawczym została właśnie opublikowana na blogu Google AI 16 grudnia 2022 r. Sam artykuł badawczy jest datowany na 25 października 2022 r.

Ciekawe, czy ta technologia znajdzie się w dużych modelach językowych najbliższej przyszłości.

Przeczytaj wpis na blogu Google:

Przyspieszenie generowania tekstu dzięki pewnemu adaptacyjnemu modelowaniu językowemu (CALM)

Przeczytaj artykuł badawczy:

Pewne adaptacyjne modelowanie języka (PDF)

Wyróżniony obraz autorstwa Shutterstock/Master1305