Google CALM:一种新的语言模型技术

已发表: 2022-12-20谷歌宣布了一项名为 CALM 的突破性技术,该技术可在不影响性能水平的情况下加速大型语言模型(如 GPT-3 和 LaMDA)。

训练数据越大越好,但需要付出代价

大型语言模型 (LLM) 在大量数据上进行训练。

在大量数据上训练语言模型会导致模型学习并非总是计划的新能力。

例如,向语言模型添加更多训练数据可能会意外地导致它获得在不同语言之间进行翻译的能力,即使它没有接受过这样的训练。

这些新能力被称为紧急能力,不一定是计划的能力。

另一篇关于突发能力的研究论文 (PDF) 指出:

“虽然有许多涌现能力的例子,但目前很少有令人信服的解释为什么这些能力会以它们的方式出现。”

他们无法解释为什么会习得不同的能力。

但众所周知,扩大用于训练机器的数据量可以让它获得更多的能力。

扩大训练数据的缺点是需要更多的计算能力来产生输出,这会使 AI 在生成文本输出时变慢(这一时刻称为“推理时间”)。

因此,通过更多数据让 AI 变得更聪明的代价是 AI 在推理时也会变得更慢。

Google 的新研究论文 ( Confident Adaptive Language Modeling PDF) 是这样描述这个问题的:

“基于 Transformer 的大型语言模型 (LLM) 的最新进展已导致许多任务的性能显着提高。

这些收益伴随着模型大小的急剧增加,可能导致在推理时使用缓慢且成本高昂。”

自信的自适应语言建模 (CALM)

谷歌的研究人员想出了一个有趣的解决方案来加速语言模型,同时保持高性能。

打个比方,答案有点像回答一个简单的问题和解决一个更难的问题之间的区别。

一个简单的问题,比如天空是什么颜色,可以不假思索地回答。

但是一个艰难的答案需要一个人停下来多想想才能找到答案。

在计算上,大型语言模型不会区分文本生成任务的困难部分和简单部分。

他们在推理时使用全部计算能力为简单和困难的部分生成文本。

Google 的解决方案称为自信自适应语言建模 (CALM)。

这个新框架所做的是将更少的资源投入到文本生成任务的琐碎部分,而将全部资源投入到更困难的部分。

关于 CALM 的研究论文是这样陈述问题和解决方案的:

“基于 Transformer 的大型语言模型 (LLM) 的最新进展已导致许多任务的性能显着提高。

这些收益伴随着模型大小的急剧增加,可能导致推理时使用缓慢且成本高昂。

然而,在实践中,LLM 生成的系列是由不同难度级别组成的。

虽然某些预测真正受益于模型的全部容量,但其他延续更为微不足道,可以通过减少计算来解决。

……虽然大型模型通常表现更好,但并非每个输入都需要相同数量的计算才能实现相似的性能(例如,取决于输入是简单还是困难)。”

什么是 Google CALM,它有用吗?

CALM 的工作原理是根据任务各个部分的复杂性动态分配资源,使用算法来预测某项任务是需要全部资源还是部分资源。

研究论文指出,他们针对各种自然语言处理任务(“文本摘要、机器翻译和问答”)测试了新系统,发现他们能够将推理速度提高约三倍 (300%) .

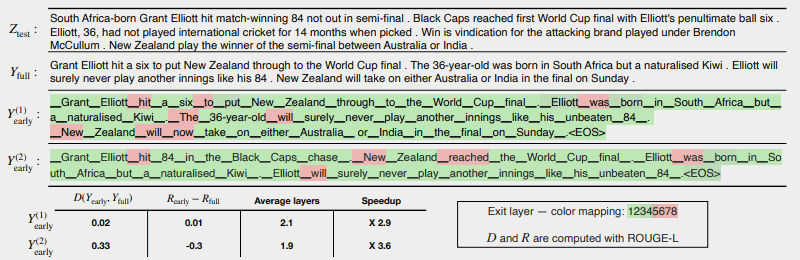

下图显示了 CALM 系统的工作情况。

红色的几个区域表示机器必须在该任务部分使用其全部容量的位置。

绿色区域是机器只使用了不到一半容量的地方。

红色 = 满容量/绿色 = 小于一半容量

这是研究论文对上图的描述:

“CALM 通过在可能的情况下提前退出来加速生成,并有选择地仅对少数标记使用完整解码器的容量,此处在 CNN/DM 示例中使用基于 softmax 的置信度度量进行了演示。 Y (1) early 和 Y (2) early 使用不同的置信度阈值来提前退出。

在文本下方(原文如此),我们报告了两个输出中每个输出的测量文本和风险一致性,以及效率增益。

颜色表示用于每个标记的解码层数——浅绿色阴影表示不到总层数的一半。

只有少数选定的标记使用模型的全部容量(红色),而对于大多数标记,模型在一个或几个解码层后退出(绿色)。”

研究人员在论文的结尾指出,实施 CALM 只需进行最少的修改即可使大型语言模型变得更快。

这项研究很重要,因为它为创建更复杂的 AI 模型打开了大门,这些模型在更大的数据集上进行训练,而不会在保持高性能水平的同时降低速度。

然而,这种方法也可能有利于在较少数据上训练的大型语言模型。

例如,InstructGPT 模型(ChatGPT 是其同级模型)在大约 13 亿个参数上进行了训练,但仍然能够胜过在更多参数上进行训练的模型。

研究人员在结论中指出:

“总的来说,我们完整的 LM 自适应计算框架需要对基础模型进行最少的修改,并在满足严格的输出质量保证的同时提高效率。”

有关这篇研究论文的信息刚刚于 2022 年 12 月 16 日发布在 Google 的 AI 博客上。该研究论文本身的日期是 2022 年 10 月 25 日。

看看这项技术是否会在不久的将来进入大型语言模型将会很有趣。

阅读谷歌的博客文章:

使用可靠的自适应语言建模 (CALM) 加速文本生成

阅读研究论文:

自信的自适应语言建模 (PDF)

Shutterstock/Master1305 特色图片