Google CALM: una nuova tecnologia del modello linguistico

Pubblicato: 2022-12-20Google ha annunciato una tecnologia rivoluzionaria chiamata CALM che accelera i modelli di linguaggio di grandi dimensioni (come GPT-3 e LaMDA) senza compromettere i livelli di prestazioni.

Dati di addestramento più grandi sono migliori ma hanno un costo

I Large Language Models (LLM) si addestrano su grandi quantità di dati.

L'addestramento dei modelli linguistici su quantità maggiori di dati fa sì che il modello apprenda nuove abilità che non sono sempre pianificate.

Ad esempio, l'aggiunta di più dati di addestramento a un modello linguistico può comportare inaspettatamente l'acquisizione della capacità di tradurre tra lingue diverse, anche se non è stato addestrato a farlo.

Queste nuove abilità sono chiamate abilità emergenti, abilità che non sono necessariamente pianificate.

Un altro documento di ricerca (PDF) sulle abilità emergenti afferma:

"Sebbene ci siano dozzine di esempi di abilità emergenti, al momento ci sono poche spiegazioni convincenti sul motivo per cui tali abilità emergono nel modo in cui lo fanno."

Non possono spiegare perché vengono apprese abilità diverse.

Ma è risaputo che aumentare la quantità di dati per addestrare la macchina le consente di acquisire più abilità.

Lo svantaggio di aumentare i dati di addestramento è che ci vuole più potenza di calcolo per produrre un output, il che rende l'IA più lenta nel momento in cui genera un output di testo (un momento chiamato "tempo di inferenza").

Quindi il compromesso nel rendere un'IA più intelligente con più dati è che anche l'IA diventa più lenta al momento dell'inferenza.

Il nuovo documento di ricerca di Google ( Confident Adaptive Language Modeling PDF) descrive il problema in questo modo:

“I recenti progressi nei modelli di linguaggio di grandi dimensioni (LLM) basati su Transformer hanno portato a significativi miglioramenti delle prestazioni in molte attività.

Questi guadagni derivano da un drastico aumento delle dimensioni dei modelli, che potrebbe portare a un utilizzo lento e costoso al momento dell'inferenza".

Confident Adaptive Language Modeling (CALM)

I ricercatori di Google hanno trovato una soluzione interessante per velocizzare i modelli linguistici mantenendo al tempo stesso prestazioni elevate.

La soluzione, per fare un'analogia, è un po' come la differenza tra rispondere a una domanda facile e risolverne una più difficile.

Una domanda facile, come di che colore è il cielo, può essere risolta con poca riflessione.

Ma una risposta difficile richiede di fermarsi e pensare un po' di più per trovare la risposta.

Dal punto di vista computazionale, i modelli di linguaggio di grandi dimensioni non fanno distinzione tra una parte difficile di un'attività di generazione di testo e una parte facile.

Generano testo sia per le parti facili che per quelle difficili utilizzando tutta la loro potenza di calcolo al momento dell'inferenza.

La soluzione di Google si chiama Confident Adaptive Language Modeling (CALM).

Ciò che fa questo nuovo framework è dedicare meno risorse a parti banali di un'attività di generazione di testo e dedicare tutta la potenza per parti più difficili.

Il documento di ricerca su CALM afferma il problema e la soluzione in questo modo:

“I recenti progressi nei modelli di linguaggio di grandi dimensioni (LLM) basati su Transformer hanno portato a significativi miglioramenti delle prestazioni in molte attività.

Questi vantaggi derivano da un drastico aumento delle dimensioni dei modelli, che potrebbe portare a un utilizzo lento e costoso al momento dell'inferenza.

In pratica, però, la serie di generazioni compiute dai LLM è composta da vari livelli di difficoltà.

Mentre alcune previsioni traggono davvero vantaggio dalla piena capacità dei modelli, altre continuazioni sono più banali e possono essere risolte con un calcolo ridotto.

…Sebbene i modelli di grandi dimensioni funzionino meglio in generale, la stessa quantità di calcolo potrebbe non essere richiesta per ogni input per ottenere prestazioni simili (ad esempio, a seconda che l'input sia facile o difficile).”

Cos'è Google CALM e funziona?

CALM funziona allocando dinamicamente le risorse in base alla complessità della singola parte dell'attività, utilizzando un algoritmo per prevedere se qualcosa necessita di risorse complete o parziali.

Il documento di ricerca condivide il fatto che hanno testato il nuovo sistema per varie attività di elaborazione del linguaggio naturale ("riepilogo del testo, traduzione automatica e risposta alle domande") e hanno scoperto di essere in grado di accelerare l'inferenza di circa un fattore tre (300%) .

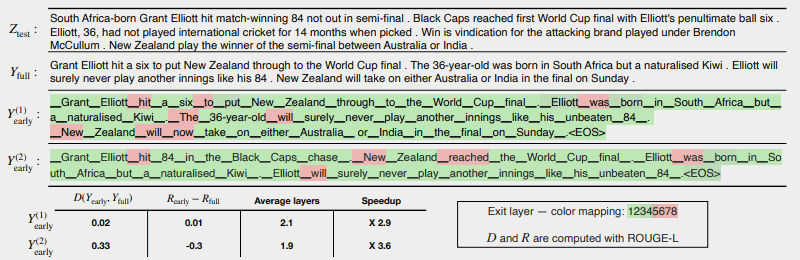

L'illustrazione seguente mostra come funziona il sistema CALM.

Le poche aree in rosso indicano dove la macchina ha dovuto utilizzare la sua piena capacità in quella sezione dell'attività.

Le aree in verde sono quelle in cui la macchina ha utilizzato solo meno della metà della capacità.

Rosso = Piena capacità/Verde = Meno della metà della capacità

Questo è ciò che dice il documento di ricerca sull'illustrazione sopra:

“CALM accelera la generazione uscendo presto quando possibile e utilizzando selettivamente la capacità completa del decodificatore solo per pochi token, dimostrato qui su un esempio CNN/DM con misura di confidenza basata su softmax. Y (1) e Y (2) utilizzano soglie di confidenza diverse per l'uscita anticipata.

Sotto (sic) il testo, riportiamo la coerenza testuale e di rischio misurata di ciascuno dei due output, insieme ai guadagni di efficienza.

I colori rappresentano il numero di livelli di decodifica utilizzati per ciascun token: le sfumature verde chiaro indicano meno della metà dei livelli totali.

Solo pochi token selezionati utilizzano la piena capacità del modello (colorato in rosso), mentre per la maggior parte dei token il modello esce dopo uno o pochi strati di decodifica (colorati in verde).”

I ricercatori hanno concluso il documento osservando che l'implementazione di CALM richiede solo modifiche minime per adattare un modello di linguaggio di grandi dimensioni per diventare più veloce.

Questa ricerca è importante perché apre le porte alla creazione di modelli di intelligenza artificiale più complessi che vengono addestrati su set di dati sostanzialmente più grandi senza subire velocità inferiori pur mantenendo un livello di prestazioni elevato.

Tuttavia, è possibile che questo metodo possa anche avvantaggiare modelli linguistici di grandi dimensioni che vengono addestrati anche su meno dati.

Ad esempio, i modelli InstructGPT, di cui ChatGPT è un modello di pari livello, vengono addestrati su circa 1,3 miliardi di parametri, ma sono ancora in grado di superare i modelli addestrati su un numero sostanzialmente maggiore di parametri.

I ricercatori hanno notato nella conclusione:

"Nel complesso, il nostro framework di calcolo adattivo completo per LM richiede modifiche minime al modello sottostante e consente guadagni di efficienza soddisfacendo al tempo stesso rigorose garanzie di qualità per l'output".

Queste informazioni su questo documento di ricerca sono state appena pubblicate sul blog AI di Google il 16 dicembre 2022. Il documento di ricerca stesso è datato 25 ottobre 2022.

Sarà interessante vedere se questa tecnologia si farà strada nei grandi modelli linguistici del prossimo futuro.

Leggi il post sul blog di Google:

Accelerazione della generazione di testo con la modellazione linguistica adattiva sicura (CALM)

Leggi il documento di ricerca:

Modellazione linguistica adattiva sicura (PDF)

Immagine in primo piano di Shutterstock/Master1305