Google CALM:一種新的語言模型技術

已發表: 2022-12-20谷歌宣布了一項名為 CALM 的突破性技術,該技術可在不影響性能水平的情況下加速大型語言模型(如 GPT-3 和 LaMDA)。

訓練數據越大越好,但需要付出代價

大型語言模型 (LLM) 在大量數據上進行訓練。

在大量數據上訓練語言模型會導致模型學習並非總是計劃的新能力。

例如,向語言模型添加更多訓練數據可能會意外地導致它獲得在不同語言之間進行翻譯的能力,即使它沒有接受過這樣的訓練。

這些新能力被稱為緊急能力,不一定是計劃的能力。

另一篇關於突發能力的研究論文 (PDF) 指出:

“雖然有許多湧現能力的例子,但目前很少有令人信服的解釋為什麼這些能力會以它們的方式出現。”

他們無法解釋為什麼會習得不同的能力。

但眾所周知,擴大用於訓練機器的數據量可以讓它獲得更多的能力。

擴大訓練數據的缺點是需要更多的計算能力來產生輸出,這會使 AI 在生成文本輸出時變慢(這一時刻稱為“推理時間”)。

因此,通過更多數據讓 AI 變得更聰明的代價是 AI 在推理時也會變得更慢。

Google 的新研究論文 ( Confident Adaptive Language Modeling PDF) 是這樣描述這個問題的:

“基於 Transformer 的大型語言模型 (LLM) 的最新進展已導致許多任務的性能顯著提高。

這些收益伴隨著模型大小的急劇增加,可能導致在推理時使用緩慢且成本高昂。”

自信的自適應語言建模 (CALM)

谷歌的研究人員想出了一個有趣的解決方案來加速語言模型,同時保持高性能。

打個比方,答案有點像回答一個簡單的問題和解決一個更難的問題之間的區別。

一個簡單的問題,比如天空是什麼顏色,可以不假思索地回答。

但是一個艱難的答案需要一個人停下來多想想才能找到答案。

在計算上,大型語言模型不會區分文本生成任務的困難部分和簡單部分。

他們在推理時使用全部計算能力為簡單和困難的部分生成文本。

Google 的解決方案稱為自信自適應語言建模 (CALM)。

這個新框架所做的是將更少的資源投入到文本生成任務的瑣碎部分,而將全部資源投入到更困難的部分。

關於 CALM 的研究論文是這樣陳述問題和解決方案的:

“基於 Transformer 的大型語言模型 (LLM) 的最新進展已導致許多任務的性能顯著提高。

這些收益伴隨著模型大小的急劇增加,可能導致推理時使用緩慢且成本高昂。

然而,在實踐中,LLM 生成的系列是由不同難度級別組成的。

雖然某些預測真正受益於模型的全部容量,但其他延續更為微不足道,可以通過減少計算來解決。

……雖然大型模型通常表現更好,但並非每個輸入都需要相同數量的計算才能實現相似的性能(例如,取決於輸入是簡單還是困難)。”

什麼是 Google CALM,它有用嗎?

CALM 的工作原理是根據任務各個部分的複雜性動態分配資源,使用算法來預測某項任務是需要全部資源還是部分資源。

研究論文指出,他們針對各種自然語言處理任務(“文本摘要、機器翻譯和問答”)測試了新系統,發現他們能夠將推理速度提高約三倍 (300%) .

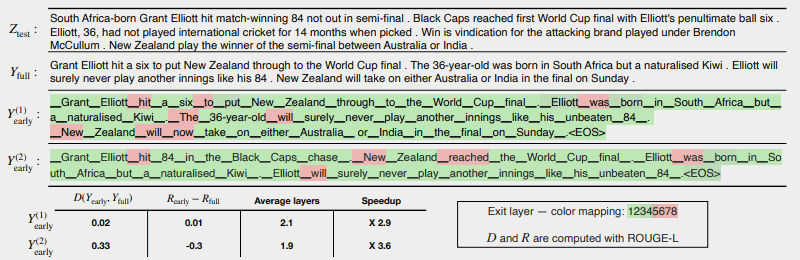

下圖顯示了 CALM 系統的工作情況。

紅色的幾個區域表示機器必須在該任務部分使用其全部容量的位置。

綠色區域是機器只使用了不到一半容量的地方。

紅色 = 滿容量/綠色 = 小於一半容量

這是研究論文對上圖的描述:

“CALM 通過在可能的情況下提前退出來加速生成,並有選擇地僅對少數標記使用完整解碼器的容量,此處在 CNN/DM 示例中使用基於 softmax 的置信度度量進行了演示。 Y (1) early 和 Y (2) early 使用不同的置信度閾值來提前退出。

在文本下方(原文如此),我們報告了兩個輸出中每個輸出的測量文本和風險一致性,以及效率增益。

顏色表示用於每個標記的解碼層數——淺綠色陰影表示不到總層數的一半。

只有少數選定的標記使用模型的全部容量(紅色),而對於大多數標記,模型在一個或幾個解碼層後退出(綠色)。”

研究人員在論文的結尾指出,實施 CALM 只需進行最少的修改即可使大型語言模型變得更快。

這項研究很重要,因為它為創建更複雜的 AI 模型打開了大門,這些模型在更大的數據集上進行訓練,而不會在保持高性能水平的同時降低速度。

然而,這種方法也可能有利於在較少數據上訓練的大型語言模型。

例如,InstructGPT 模型(ChatGPT 是其同級模型)在大約 13 億個參數上進行了訓練,但仍然能夠勝過在更多參數上進行訓練的模型。

研究人員在結論中指出:

“總的來說,我們完整的 LM 自適應計算框架需要對基礎模型進行最少的修改,並在滿足嚴格的輸出質量保證的同時提高效率。”

有關這篇研究論文的信息剛剛於 2022 年 12 月 16 日發佈在 Google 的 AI 博客上。該研究論文本身的日期是 2022 年 10 月 25 日。

看看這項技術是否會在不久的將來進入大型語言模型將會很有趣。

閱讀谷歌的博客文章:

使用可靠的自適應語言建模 (CALM) 加速文本生成

閱讀研究論文:

自信的自適應語言建模 (PDF)

Shutterstock/Master1305 特色圖片