Google CALM: 新しい言語モデル テクノロジー

公開: 2022-12-20Google は、パフォーマンス レベルを損なうことなく大規模な言語モデル (GPT-3 や LaMDA など) を高速化する CALM と呼ばれる画期的なテクノロジを発表しました。

トレーニング データが大きいほど優れていますが、コストがかかります

大規模言語モデル (LLM) は、大量のデータでトレーニングします。

大量のデータで言語モデルをトレーニングすると、モデルは常に計画されていない新しい能力を学習することになります。

たとえば、言語モデルにさらにトレーニング データを追加すると、異なる言語間で翻訳するようにトレーニングされていなくても、予期せず、その能力が得られる可能性があります。

これらの新しい能力は緊急能力と呼ばれ、必ずしも計画されていない能力です。

創発能力に関する別の研究論文 (PDF) は次のように述べています。

「創発的能力の例は何十もありますが、現在、そのような能力がそのように現れる理由について説得力のある説明はほとんどありません。」

なぜ異なる能力が学習されるのか、彼らは説明できません。

しかし、マシンをトレーニングするためのデータ量をスケールアップすると、より多くの能力を獲得できることはよく知られています。

トレーニング データをスケールアップすることの欠点は、出力を生成するためにより多くの計算能力が必要になることです。これにより、AI がテキスト出力を生成している時間 (「推論時間」と呼ばれる瞬間) が遅くなります。

したがって、より多くのデータを使用して AI をよりスマートにすることのトレードオフは、AI の推論時間も遅くなることです。

Google の新しい研究論文 ( Confident Adaptive Language Modeling PDF) は、この問題を次のように説明しています。

「Transformer ベースの大規模言語モデル (LLM) の最近の進歩により、多くのタスクでパフォーマンスが大幅に向上しました。

これらの利点は、モデルのサイズの大幅な増加に伴い、推論時の使用が遅くなり、コストがかかる可能性があります。」

信頼できる適応言語モデリング (CALM)

Google の研究者は、高いパフォーマンスを維持しながら言語モデルを高速化するための興味深いソリューションを見つけました。

例えるなら、解決策は、簡単な質問に答えるのと、より難しい質問に答えるのとの違いのようなものです。

空は何色かというような簡単な質問は、ほとんど考えずに答えることができます。

しかし、難しい答えは、答えを見つけるために立ち止まってもう少し考える必要があります.

計算上、大規模な言語モデルは、テキスト生成タスクの難しい部分と簡単な部分を区別しません。

推論時に完全な計算能力を使用して、簡単な部分と難しい部分の両方のテキストを生成します。

Google のソリューションは、Confident Adaptive Language Modeling (CALM) と呼ばれます。

この新しいフレームワークが行うことは、テキスト生成タスクの些細な部分により少ないリソースを割り当て、より難しい部分に全力を注ぐことです。

CALM に関する研究論文は、問題と解決策を次のように述べています。

「Transformer ベースの大規模言語モデル (LLM) の最近の進歩により、多くのタスクでパフォーマンスが大幅に向上しました。

これらの利点は、モデルのサイズの大幅な増加に伴い、推論時の使用が遅くなり、コストがかかる可能性があります。

ただし、実際には、LLM によって作成される一連の世代は、さまざまなレベルの難易度で構成されています。

特定の予測はモデルの全容量から本当に恩恵を受けますが、他の継続はより自明であり、計算量を削減して解決できます。

…大規模なモデルは一般的に優れていますが、同様のパフォーマンスを達成するために、すべての入力に対して同じ量の計算が必要になるとは限りません (たとえば、入力が簡単か難しいかによって異なります)。」

Google CALM とは何ですか?

CALM は、タスクの個々の部分の複雑さに応じて動的にリソースを割り当て、アルゴリズムを使用してリソースの全部または一部が必要かどうかを予測します。

この研究論文は、さまざまな自然言語処理タスク (「テキスト要約、機械翻訳、および質問応答」) に対して新しいシステムをテストしたことを共有し、推論を約 3 倍 (300%) 高速化できることを発見しました。 .

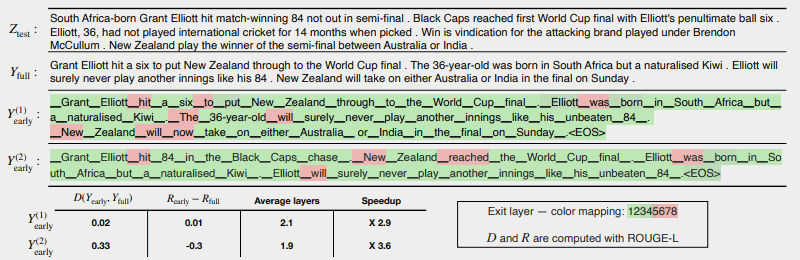

次の図は、CALM システムがどのように機能するかを示しています。

赤で示されたいくつかの領域は、タスクのそのセクションでマシンが全能力を使用しなければならなかった場所を示しています。

緑色の領域は、マシンが半分未満の容量しか使用していない場所です。

赤 = フル容量/緑 = 容量の半分未満

これは、研究論文が上記の図について述べていることです。

「CALMは、可能な場合は早期に終了し、少数のトークンに対してのみ完全なデコーダーの容量を選択的に使用することにより、生成を加速します。これは、ソフトマックスベースの信頼度測定を使用したCNN / DMの例で示されています. Y (1) 早期および Y (2) 早期は、早期終了に異なる信頼しきい値を使用します。

以下のテキスト (原文のまま) では、2 つの出力のそれぞれについて測定されたテキストとリスクの一貫性を、効率の向上とともに報告します。

色は、各トークンに使用されるデコード レイヤーの数を表します。薄緑色の色合いは、レイヤー全体の半分未満であることを示します。

一部の選択されたトークンのみがモデルの全容量を使用しますが (赤で表示)、ほとんどのトークンでは、1 つまたはいくつかのデコード レイヤー (緑で表示) の後にモデルが終了します。」

研究者は、大規模な言語モデルを高速化するために、CALM の実装には最小限の変更しか必要ないことを指摘して、論文を締めくくりました。

この研究は、高いパフォーマンス レベルを維持しながら速度を低下させることなく、大幅に大規模なデータ セットでトレーニングされる、より複雑な AI モデルを作成するための扉を開くため、重要です。

しかし、この方法は、より少ないデータでトレーニングされた大規模な言語モデルにもメリットをもたらす可能性があります。

たとえば、ChatGPT が兄弟モデルである InstructGPT モデルは、約 13 億のパラメーターでトレーニングされていますが、さらに多くのパラメーターでトレーニングされているモデルよりも優れたパフォーマンスを発揮します。

研究者は結論で次のように述べています。

「全体として、LM 向けの完全な適応計算フレームワークは、基礎となるモデルへの変更を最小限に抑え、出力の厳格な品質保証を満たしながら効率を向上させます。」

この研究論文に関するこの情報は、2022 年 12 月 16 日に Google の AI ブログで公開されたばかりです。研究論文自体の日付は 2022 年 10 月 25 日です。

この技術が近い将来の大規模な言語モデルに採用されるかどうかは興味深いところです。

Google のブログ記事を読む:

Confident Adaptive Language Modeling (CALM) によるテキスト生成の高速化

研究論文を読む:

信頼できる適応型言語モデリング (PDF)

Shutterstock/Master1305 の主な画像