5 лучших статистических данных о сканировании в Google Search Console

Опубликовано: 2021-04-16В Google Search Console есть один отчет, который безумно полезен и его довольно сложно найти, особенно если вы только начинаете свой путь в SEO.

Это один из самых мощных инструментов для каждого специалиста по SEO, хотя вы даже не можете получить к нему доступ из основного интерфейса Google Search Console.

Я говорю об отчете статистики сканирования.

В этой статье вы узнаете, почему этот отчет так важен, как получить к нему доступ и как использовать его в целях SEO.

Как сканируется ваш сайт?

Бюджет сканирования (количество страниц, которые робот Googlebot может и хочет сканировать) имеет важное значение для SEO, особенно для крупных веб-сайтов.

Если у вас есть проблемы с краулинговым бюджетом вашего веб-сайта, Google может не проиндексировать некоторые из ваших ценных страниц.

И как говорится, если Google что-то не проиндексировал, то этого не существует.

Google Search Console может показать вам, сколько страниц на вашем сайте ежедневно посещает робот Googlebot.

Вооружившись этими знаниями, вы сможете найти аномалии, которые могут вызывать проблемы с SEO.

Погружение в статистику сканирования: 5 ключевых идей

Чтобы получить доступ к отчету о статистике сканирования, войдите в свою учетную запись Google Search Console и выберите « Настройки» > «Статистика сканирования» .

Вот все параметры данных, которые вы можете проверить в отчете статистики сканирования:

1. Хост

Представьте, что у вас есть интернет-магазин на shop.website.com и блог на blog.website.com.

Используя отчет «Статистика сканирования», вы можете легко просмотреть статистику сканирования, относящуюся к каждому поддомену вашего веб-сайта.

К сожалению, этот метод в настоящее время не работает с подпапками.

2. HTTP-статус

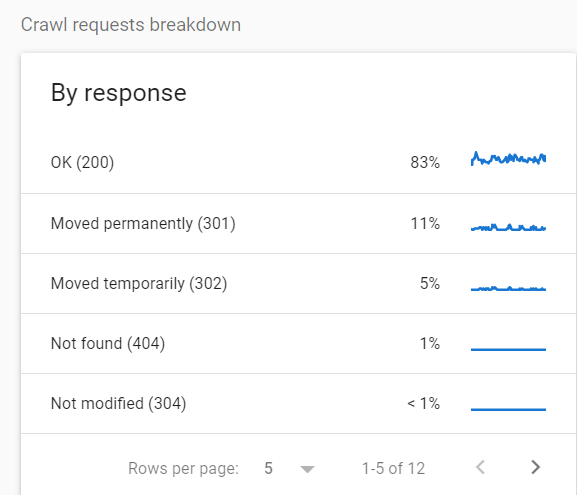

Еще один пример использования отчета о статистике обхода – просмотр кодов состояния просканированных URL-адресов.

Это потому, что вы не хотите, чтобы робот Googlebot тратил ресурсы на сканирование страниц, которые не поддерживают HTTP 200 OK. Это пустая трата вашего краулингового бюджета.

Чтобы просмотреть разбивку просканированных URL-адресов по коду состояния, выберите « Настройки» > «Статистика сканирования» > «Разбивка запросов на сканирование».

В данном конкретном случае 16% всех запросов были сделаны для перенаправленных страниц.

Если вы видите подобную статистику, я рекомендую продолжить расследование и найти переходы перенаправления и другие потенциальные проблемы.

На мой взгляд, один из худших случаев, которые вы можете здесь увидеть, — это большое количество ошибок 5xx.

Цитируя документацию Google: «Если сайт тормозит или отвечает с ошибками сервера, лимит уменьшается, и робот Googlebot сканирует меньше».

Если вам интересна эта тема, Роджер Монтти написал подробную статью об ошибках 5xx в Google Search Console.

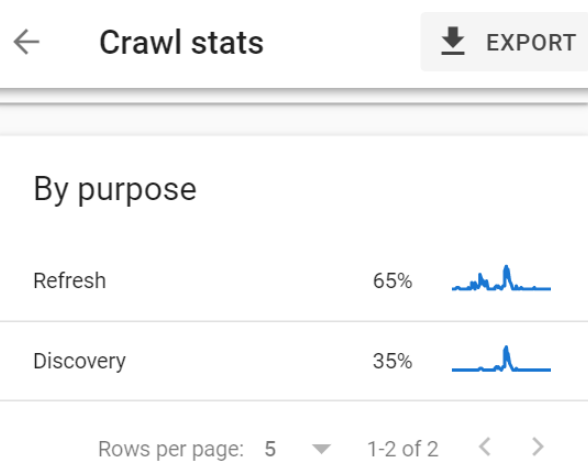

3. Цель

В отчете о статистике сканирования цель сканирования разбита на две категории:

- URL-адреса, просканированные для целей обновления (повторное сканирование уже известных страниц, например, робот Googlebot посещает вашу домашнюю страницу, чтобы обнаружить новые ссылки и контент).

- URL-адреса, просканированные в целях обнаружения (URL-адреса, просканированные впервые).

Эта разбивка безумно полезна, и вот пример:

Недавно я столкнулся с веб-сайтом с примерно 1 миллионом страниц, классифицированным как «Обнаружен — в настоящее время не проиндексирован».

Об этой проблеме сообщалось на 90% всех страниц этого сайта.

(Если вы не знакомы с этим, «Обнаружено, но не проиндексировано» означает, что Google обнаружил данную страницу, но не посетил ее. Если вы обнаружили новый ресторан в своем городе, но не пробовали, например .)

Один из вариантов — подождать, надеясь, что Google постепенно проиндексирует эти страницы.

Другим вариантом было просмотреть данные и диагностировать проблему.

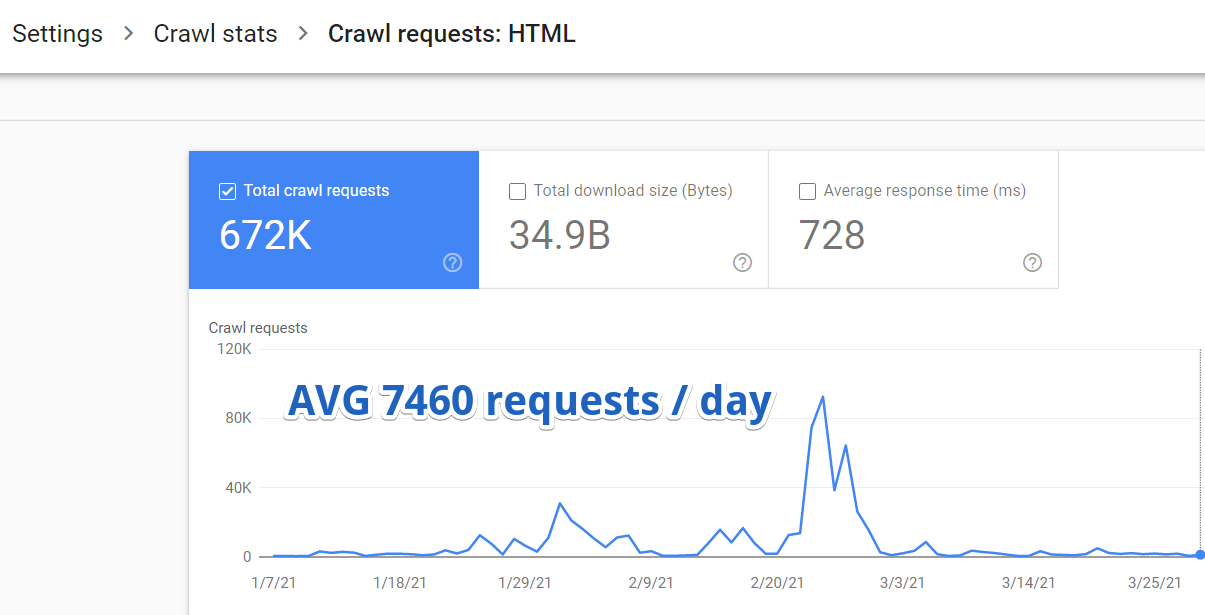

Поэтому я вошел в Google Search Console и перешел в «Настройки» > «Статистика сканирования» > «Запросы на сканирование: HTML» .

Выяснилось, что в среднем Google просматривал на этом сайте всего 7460 страниц в день.

Но вот кое-что еще более важное.

Благодаря отчету о статистике сканирования я обнаружил, что только 35% из этих 7460 URL-адресов были просканированы в целях обнаружения.

Это всего 2611 новых страниц, обнаруженных Google в день.

2611 из более чем миллиона.

Google потребовалось бы 382 дня, чтобы полностью проиндексировать весь веб-сайт с такой скоростью.

Обнаружение этого изменило правила игры. Все остальные поисковые оптимизации были отложены, так как мы полностью сосредоточились на оптимизации краулингового бюджета.

4. Тип файла

Статистика GSC Crawl может быть полезна для веб-сайтов JavaScript. Вы можете легко проверить, как часто робот Googlebot сканирует файлы JS, необходимые для правильного рендеринга.

Если ваш сайт заполнен изображениями и поиск изображений имеет решающее значение для вашей SEO-стратегии, этот отчет также очень поможет — вы можете увидеть, насколько хорошо Googlebot может сканировать ваши изображения.

5. Тип робота Google

Наконец, в отчете о статистике сканирования содержится подробная информация о типах роботов Google, используемых для сканирования вашего сайта.

Вы можете узнать процент запросов, сделанных ботами Googlebot для мобильных и настольных компьютеров, а также ботами для изображений, видео и рекламы.

Другая полезная информация

Стоит отметить, что в отчете статистики сканирования содержится бесценная информация, которую вы не найдете в журналах своего сервера:

- Ошибки DNS.

- Время ожидания страницы.

- Проблемы с хостом, такие как проблемы с получением файла robots.txt.

Использование статистики сканирования в инструменте проверки URL

Вы также можете получить доступ к некоторым детальным данным обхода вне отчета статистики обхода, в Инструменте проверки URL.

Недавно я работал с крупным веб-сайтом электронной коммерции и после некоторого первоначального анализа заметил две насущные проблемы:

- Многие страницы продуктов не были проиндексированы в Google.

- Между продуктами не было внутренней связи. Единственным способом для Google обнаружить новый контент были карты сайта и страницы категорий с разбивкой на страницы.

Естественным следующим шагом было получить доступ к журналам сервера и проверить, просканировал ли Google страницы категорий с разбивкой на страницы.

Но получить доступ к журналам сервера часто очень сложно, особенно если вы работаете с крупной организацией.

На помощь пришел отчет Google Search Console о статистике сканирования.

Позвольте мне рассказать вам о процессе, который я использовал и который вы можете использовать, если боретесь с похожей проблемой:

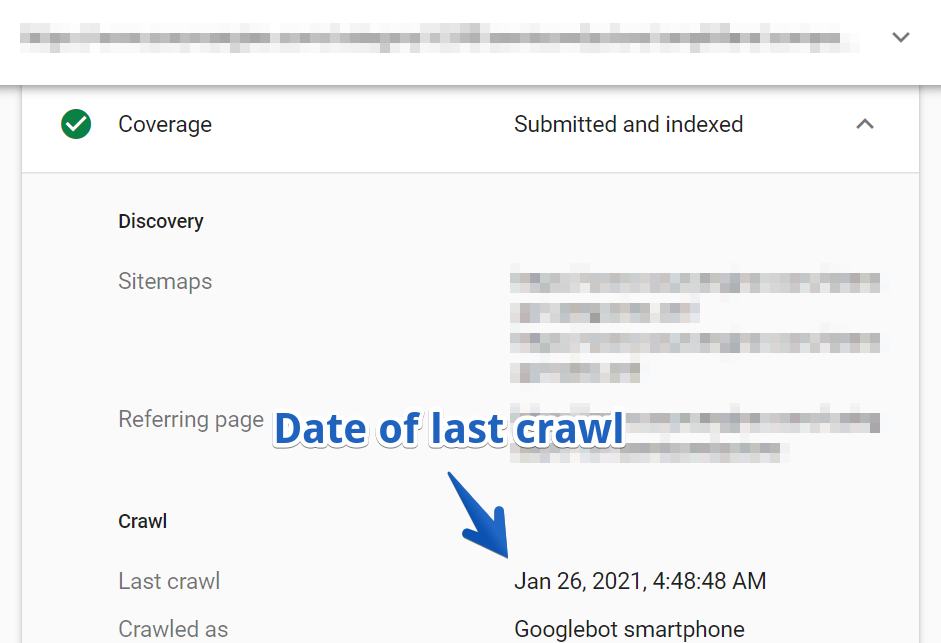

1. Сначала найдите URL-адрес в инструменте проверки URL-адресов. Я выбрал одну из разбитых на страницы страниц одной из основных категорий сайта.

2. Затем перейдите к Покрытие > Отчет о сканировании .

В этом случае последний раз URL-адрес сканировался три месяца назад.

Имейте в виду, что это была одна из основных страниц категорий веб-сайта, которая не сканировалась более трех месяцев!

Я пошел глубже и проверил образец других страниц категорий.

Оказалось, что робот Googlebot никогда не посещал многие страницы основных категорий. Многие из них до сих пор неизвестны Google.

Я не думаю, что мне нужно объяснять, насколько важно иметь эту информацию, когда вы работаете над улучшением видимости любого веб-сайта.

Отчет о статистике сканирования позволяет вам просматривать такие вещи в течение нескольких минут.

Подведение итогов

Как видите, отчет о статистике сканирования — это мощный SEO-инструмент, хотя вы можете годами использовать Google Search Console, так и не найдя его.

Это поможет вам диагностировать проблемы с индексацией и оптимизировать краулинговый бюджет, чтобы Google мог быстро находить и индексировать ценный контент, что особенно важно для крупных сайтов.

Я дал вам пару вариантов использования для размышления, но теперь мяч на вашей стороне.

Как вы будете использовать эти данные для улучшения видимости вашего сайта?

Дополнительные ресурсы:

- Crawl-First SEO: руководство из 12 шагов, которым нужно следовать перед сканированием

- 7 советов по оптимизации краулингового бюджета для SEO

- Как работают поисковые системы

Кредиты изображений

Все скриншоты сделаны автором, апрель 2021 г.