Warum Serverprotokolle für SEO wichtig sind

Veröffentlicht: 2022-01-11Die Bedeutung von Webserver-Logs ist den meisten Website-Betreibern nicht bewusst. Sie zeichnen die Serverprotokolle ihrer Website nicht auf, geschweige denn analysieren sie. Insbesondere große Marken nutzen die Serverprotokollanalyse nicht und verlieren unwiederbringlich nicht aufgezeichnete Serverprotokolldaten.

Unternehmen, die sich für die Analyse von Serverprotokollen als Teil ihrer laufenden SEO-Bemühungen entscheiden, zeichnen sich häufig durch die Google-Suche aus. Wenn Ihre Website aus 100.000 Seiten oder mehr besteht und Sie herausfinden möchten, wie und warum Serverprotokolle eine enorme Wachstumschance darstellen, lesen Sie weiter.

Warum Serverprotokolle wichtig sind

Jedes Mal, wenn ein Bot eine auf einem Webserver gehostete URL anfordert, wird automatisch ein Protokolleintrag erstellt, der die während des Prozesses ausgetauschten Informationen widerspiegelt. Bei der Abdeckung eines längeren Zeitraums werden die Serverprotokolle repräsentativ für den Verlauf der empfangenen Anfragen und der zurückgegebenen Antworten.

Die in den Serverprotokolldateien gespeicherten Informationen umfassen typischerweise die IP-Adresse des Clients, Datum und Uhrzeit der Anfrage, die angeforderte Seiten-URL, den HTTP-Antwortcode, die Menge der bereitgestellten Bytes sowie den Benutzeragenten und den Referrer.

Während Serverprotokolle bei jeder Anforderung einer Webseite erstellt werden, einschließlich Benutzer-Browser-Anfragen, konzentriert sich die Suchmaschinenoptimierung ausschließlich auf die Verwendung von Bot-Server-Protokolldaten. Dies ist relevant im Hinblick auf rechtliche Überlegungen zu Datenschutzrahmen wie DSGVO/CCPA/DSGVO. Da niemals Benutzerdaten für SEO-Zwecke einbezogen werden, bleibt die rohe, anonymisierte Webserver-Protokollanalyse unbelastet von ansonsten möglicherweise geltenden gesetzlichen Bestimmungen.

Es ist erwähnenswert, dass bis zu einem gewissen Grad ähnliche Erkenntnisse basierend auf den Crawl-Statistiken der Google Search Console möglich sind. Diese Proben sind jedoch hinsichtlich Volumen und abgedeckter Zeitspanne begrenzt. Im Gegensatz zur Google Search Console, deren Daten nur die letzten Monate widerspiegeln, liefern ausschließlich Server-Logfiles ein klares Gesamtbild langfristiger SEO-Trends.

Die wertvollen Daten in Serverprotokollen

Jedes Mal, wenn ein Bot eine auf dem Server gehostete Seite anfordert, wird eine Protokollinstanz erstellt, die eine Reihe von Datenpunkten aufzeichnet, darunter:

- Die IP-Adresse des anfragenden Clients.

- Die genaue Uhrzeit der Anfrage, oft basierend auf der internen Uhr des Servers.

- Die angeforderte URL.

- Für die Anfrage wurde HTTP verwendet.

- Der zurückgegebene Antwortstatuscode (z. B. 200, 301, 404, 500 oder andere).

- Die User-Agent-Zeichenfolge von der anfordernden Entität (z. B. ein Suchmaschinen-Bot-Name wie Googlebot/2.1).

Ein typisches Beispiel für einen Serverprotokolleintrag könnte wie folgt aussehen:

150.174.193.196 - - [15/Dec/2021:11:25:14 +0100] "GET /index.html HTTP/1.0" 200 1050 "-" "Googlebot/2.1 (+http://www.google.com/bot.html)" "www.example.ai"

In diesem Beispiel:

-

150.174.193.196ist die IP der anfragenden Entität.

-

[15/Dec/2021:11:25:14 +0100]ist sowohl die Zeitzone als auch die Uhrzeit der Anfrage.

-

"GET /index.html HTTP/1.0"ist die verwendete HTTP-Methode (GET), die angeforderte Datei (index.html) und die verwendete HTTP-Protokollversion.

-

200ist die zurückgegebene HTTP-Statuscodeantwort des Servers.

-

1050ist die Bytegröße der Serverantwort.

-

"Googlebot/2.1 (+http://www.google.com/bot.html)"ist der User-Agent der anfragenden Entität.

-

"www.example.ai"ist die verweisende URL.

So verwenden Sie Serverprotokolle

Aus SEO-Sicht gibt es drei Hauptgründe, warum Webserver-Protokolle unvergleichliche Einblicke liefern:

- Unterstützung beim Herausfiltern von unerwünschtem Bot-Verkehr ohne SEO-Bedeutung aus erwünschtem Suchmaschinen-Bot-Verkehr, der von legitimen Bots wie Googlebot, Bingbot oder YandexBot stammt.

- Bereitstellung von SEO-Einblicken in die Crawl-Priorisierung und damit dem SEO-Team die Möglichkeit, sein Crawl-Budget-Management proaktiv zu optimieren und zu optimieren.

- Ermöglicht die Überwachung und Bereitstellung einer Erfolgsbilanz der an Suchmaschinen gesendeten Serverantworten.

Gefälschte Suchmaschinen-Bots können lästig sein, wirken sich aber nur selten auf Websites aus. Es gibt eine Reihe spezialisierter Dienstleister wie Cloudflare und AWS Shield, die dabei helfen können, unerwünschten Bot-Traffic zu managen. Bei der Analyse von Webserver-Logs spielen gefälschte Suchmaschinen-Bots eher eine untergeordnete Rolle.

Um genau einschätzen zu können, welche Teile einer Website neben den großen Suchmaschinen priorisiert werden, muss der Bot-Traffic bei der Durchführung einer Protokollanalyse gefiltert werden. Je nach Zielmarkt kann der Fokus auf Suchmaschinen-Bots wie Google, Apple, Bing, Yandex oder anderen liegen.

Insbesondere bei Websites, bei denen die Aktualität der Inhalte von entscheidender Bedeutung ist, kann die Häufigkeit des erneuten Crawlens dieser Websites deren Nützlichkeit für Benutzer entscheidend beeinflussen. Mit anderen Worten, wenn Inhaltsänderungen nicht schnell genug aufgegriffen werden, werden die Signale der Benutzererfahrung und die Rankings der organischen Suche wahrscheinlich nicht ihr volles Potenzial entfalten.

Während Google dazu neigt, alle verfügbaren Informationen zu crawlen und bereits bekannte URL-Muster regelmäßig erneut zu crawlen, sind seine Crawl-Ressourcen nicht unbegrenzt. Aus diesem Grund hängen die Re-Crawling-Zyklen bei großen Websites mit Hunderttausenden von Zielseiten von den Algorithmen zur Crawling-Priorisierungszuweisung von Google ab.

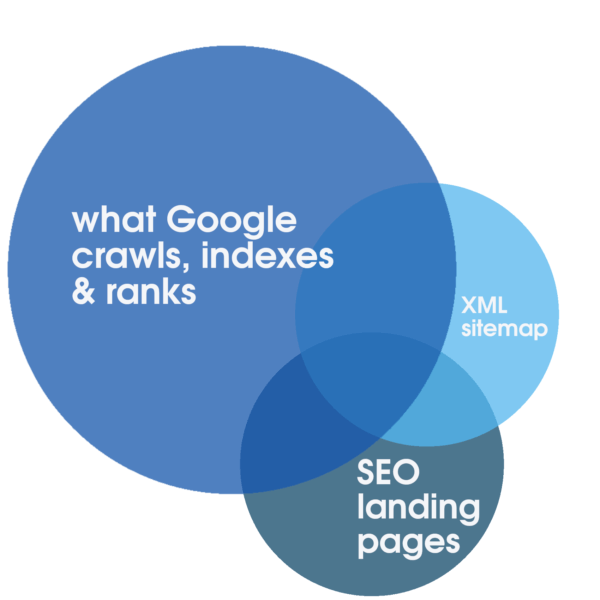

Diese Allokation kann mit zuverlässiger Betriebszeit und hochgradig reaktionsschnellen Webdiensten, die speziell für ein schnelles Erlebnis optimiert sind, positiv stimuliert werden. Allein diese Schritte sind SEO förderlich. Allerdings ist es nur durch die Analyse vollständiger Serverprotokolle, die einen längeren Zeitraum abdecken, möglich, den Grad der Überschneidung zwischen dem Gesamtvolumen aller crawlbaren Landingpages und der typischerweise geringeren Anzahl relevanter, optimierter und indexierbarer SEO-Landingpages zu identifizieren, die in der dargestellt werden Sitemap und was Google regelmäßig für Crawling, Indexierung und Ranking priorisiert.

Eine solche Log-Analyse ist fester Bestandteil eines technischen SEO-Audits und die einzige Methode, um den Grad der Crawl-Budget-Verschwendung aufzudecken. Und ob crawlbare Filter, Platzhalter oder schlanke Inhaltsseiten, ein Open-Staging-Server oder andere veraltete Teile der Website beeinträchtigen immer wieder das Crawling und letztendlich die Rankings. Gerade die Erkenntnisse aus einem SEO-Audit inklusive Server-Log-Analyse entscheiden unter Umständen, etwa bei einer geplanten Migration, oft über Erfolg oder Misserfolg der Migration.

Zusätzlich bietet die Log-Analyse für große Websites entscheidende SEO-Einblicke. Es kann Aufschluss darüber geben, wie lange Google benötigt, um die gesamte Website erneut zu crawlen . Wenn diese Antwort entscheidend lang ist – Monate oder länger – können Maßnahmen gerechtfertigt sein, um sicherzustellen, dass die indexierbaren SEO-Zielseiten gecrawlt werden. Andernfalls besteht ein großes Risiko, dass SEO-Verbesserungen der Website möglicherweise Monate nach der Veröffentlichung von Suchmaschinen unbemerkt bleiben, was wiederum ein Rezept für schlechte Rankings ist.

Serverantworten sind entscheidend für eine hervorragende Sichtbarkeit in der Google-Suche. Während die Google Search Console einen wichtigen Einblick in die jüngsten Serverantworten bietet, müssen alle Daten, die die Google Search Console den Website-Betreibern anbietet, als repräsentative, aber begrenzte Stichprobe angesehen werden. Obwohl dies nützlich sein kann, um schwerwiegende Probleme zu identifizieren, ist es mit einer Serverprotokollanalyse möglich, alle HTTP-Antworten zu analysieren und zu identifizieren, einschließlich aller quantitativ relevanten Nicht-200-OK-Antworten, die das Ranking gefährden können. Mögliche alternative Antworten können auf Leistungsprobleme hinweisen (z. B. 503 Service Unavailable geplante Ausfallzeit), wenn sie übermäßig sind.

Wo anfangen

Trotz des Potenzials, das die Server-Log-Analyse bietet, nutzen die meisten Website-Betreiber die sich bietenden Möglichkeiten nicht. Serverlogs werden entweder gar nicht aufgezeichnet oder regelmäßig überschrieben oder unvollständig. Die überwältigende Mehrheit der Websites speichert Serverprotokolldaten nicht für einen nennenswerten Zeitraum. Das sind gute Nachrichten für alle Betreiber, die im Gegensatz zu ihren Konkurrenten bereit sind, Server-Logfiles für die Suchmaschinenoptimierung zu sammeln und zu nutzen.

Bei der Planung der Erfassung von Server-Log-Daten ist zu beachten, welche Datenfelder in den Server-Log-Dateien mindestens vorgehalten werden müssen, damit die Daten nutzbar sind. Die folgende Liste kann als Richtlinie angesehen werden:

- entfernte IP-Adresse der anfragenden Entität.

- User-Agent-String der anfragenden Entität.

- Anforderungsschema (zB war die HTTP-Anforderung für http oder https oder wss oder etwas anderes).

- Anfrage-Hostname (z. B. für welche Subdomain oder Domain war die HTTP-Anfrage).

- Anforderungspfad, oft ist dies der Dateipfad auf dem Server als relative URL.

- Anforderungsparameter, die Teil des Anforderungspfads sein können.

- Anforderungszeit, einschließlich Datum, Uhrzeit und Zeitzone.

- Anforderungsmethode.

- Antwort http-Statuscode.

- Reaktionszeiten.

Wenn der Anfragepfad eine relative URL ist, sind die Felder, die in Server-Logdateien oft vernachlässigt werden, die Aufzeichnung des Hostnamens und des Schemas der Anfrage. Aus diesem Grund ist es wichtig, mit Ihrer IT-Abteilung zu überprüfen, ob der Anforderungspfad eine relative URL ist, damit der Hostname und das Schema auch in den Server-Logdateien aufgezeichnet werden. Eine einfache Problemumgehung besteht darin, die gesamte Anforderungs-URL als ein Feld aufzuzeichnen, das das Schema, den Hostnamen, den Pfad und die Parameter in einer Zeichenfolge enthält.

Beim Sammeln von Serverprotokolldateien ist es auch wichtig, Protokolle einzubeziehen, die von CDNs und anderen Drittanbieterdiensten stammen, die die Website möglicherweise verwendet. Erkundigen Sie sich bei diesen Drittanbieterdiensten, wie Sie die Protokolldateien regelmäßig extrahieren und speichern können.

Überwindung von Hindernissen bei der Analyse von Serverprotokollen

Häufig werden zwei Haupthindernisse angeführt, um der dringenden Notwendigkeit der Aufbewahrung von Serverprotokolldaten entgegenzuwirken: Kosten und rechtliche Bedenken. Obwohl beide Faktoren letztendlich von individuellen Umständen wie Budgetierung und Gerichtsbarkeit bestimmt werden, müssen beide Faktoren keine ernsthaften Hindernisse darstellen.

Cloud-Speicher kann eine langfristige Option sein, und physischer Hardwarespeicher dürfte auch die Kosten begrenzen. Mit Einzelhandelspreisen für etwa 20-TB-Festplatten unter 600 USD sind die Hardwarekosten vernachlässigbar. Angesichts der Tatsache, dass die Preise für Speicherhardware seit Jahren sinken, werden die Speicherkosten letztendlich wahrscheinlich keine ernsthafte Herausforderung für die Aufzeichnung von Serverprotokollen darstellen.

Darüber hinaus fallen Kosten für die Protokollanalysesoftware oder für die Erbringung des Dienstes durch den SEO-Audit-Anbieter an. Diese Kosten müssen zwar ins Budget einkalkuliert werden, sind aber angesichts der Vorteile der Server-Log-Analyse wiederum leicht zu rechtfertigen.

Obwohl dieser Artikel die inhärenten Vorteile der Serverprotokollanalyse für SEO skizzieren soll, sollte er nicht als rechtliche Empfehlung betrachtet werden. Eine solche Rechtsberatung kann nur durch einen qualifizierten Anwalt im Rahmen der gesetzlichen Rahmenbedingungen und der einschlägigen Rechtsprechung erfolgen. In diesem Zusammenhang können eine Reihe von Gesetzen und Verordnungen wie GDPR/CCPA/DSGVO gelten. Besonders wenn Sie von der EU aus operieren, ist der Datenschutz ein wichtiges Anliegen. Für Zwecke der Server-Log-Analyse für SEO sind jedoch keine benutzerbezogenen Daten relevant. Alle Aufzeichnungen, die anhand der IP-Adresse nicht eindeutig verifiziert werden können, sind zu ignorieren.

Im Hinblick auf Datenschutzbedenken dürfen alle Protokolldaten, die keinen validierten und keinen bestätigten Suchmaschinen-Bot darstellen, nicht verwendet werden und können stattdessen nach einem definierten Zeitraum auf der Grundlage einschlägiger gesetzlicher Empfehlungen gelöscht oder anonymisiert werden. Dieser bewährte Ansatz wird von einigen der größten Website-Betreiber regelmäßig angewendet.

Wann anfangen

Die wichtigste verbleibende Frage ist, wann mit dem Sammeln von Serverprotokolldaten begonnen werden soll. Die Antwort ist jetzt!

Serverprotokolldaten können nur dann sinnvoll verwendet werden und zu umsetzbaren Ratschlägen führen, wenn sie in ausreichendem Umfang verfügbar sind. Die kritische Masse der Nützlichkeit von Serverprotokollen für SEO-Audits liegt typischerweise zwischen sechs und sechsunddreißig Monaten, je nachdem, wie groß eine Website ist und welche Crawl-Priorisierungssignale sie haben.

Es ist wichtig zu beachten, dass nicht aufgezeichnete Serverprotokolle zu einem späteren Zeitpunkt nicht erfasst werden können. Es besteht die Möglichkeit, dass alle heute begonnenen Bemühungen zur Aufbewahrung und Aufbewahrung von Serverprotokollen bereits im folgenden Jahr Früchte tragen werden. Daher muss das Sammeln von Serverprotokolldaten zum frühestmöglichen Zeitpunkt beginnen und ununterbrochen fortgesetzt werden, solange die Website in Betrieb ist und darauf abzielt, in der organischen Suche gut abzuschneiden.

Die in diesem Artikel geäußerten Meinungen sind die des Gastautors und nicht unbedingt Search Engine Land. Mitarbeiter Autoren sind hier aufgelistet.