O que são testes A / A e por que os profissionais de marketing devem se preocupar?

Publicados: 2017-05-18Você já passou por esse cenário? Você configura um teste A / B para descobrir se seu novo botão e combinação de título gerará mais conversões ...

Você direciona o tráfego igual para ambas as páginas de destino pós-clique - o controle e a variação - e para depois de um mês, quando seu software declara sua variação a vencedora com 99% de confiança ...

Você lança o novo design “vencedor”, mas vários ciclos de negócios depois, aquele aumento de 50% na taxa de conversão não mostra nenhum impacto em seus resultados financeiros. Você está confuso. Você está chateado ...

E você provavelmente é vítima de um resultado de teste falso positivo.

O que é um resultado de teste falso positivo?

Por que esse aumento de 50% na taxa de conversão não está se traduzindo em mais vendas? A razão, diz Lance Jones da Copyhackers, é porque provavelmente não existia.

É perfeitamente possível (até provável) que você não veja o aumento nas vendas ou receita do seu teste porque, para começo de conversa, ele nunca existiu. Você pode ter recebido, sem saber, um “falso positivo” em seu teste - conhecido como erro estatístico Tipo I, também conhecido como rejeição incorreta de uma hipótese nula verdadeira. Isso é um bocado, então eu simplesmente me lembro como um falso positivo.

Com a boca cheia ou não, esses erros estatísticos do Tipo 1 são mais comuns do que você imagina. Estima-se que cerca de 80% dos resultados do teste AB sejam imaginários.

Clique para tweetar

Se você está tomando decisões importantes com base em falsos positivos, na melhor das hipóteses, está deixando a otimização ao acaso. Na pior das hipóteses, você está piorando a taxa de conversão de suas páginas de destino pós-clique.

Felizmente, existem algumas maneiras de combater dados venenosos. Um deles é semelhante a um método de teste com o qual você provavelmente já está familiarizado ...

O que são testes A / A?

O teste A / B envolve direcionar o tráfego para duas páginas diferentes - uma original (seu controle) e outra versão (sua variação) - para ver qual tem melhor desempenho.

Da mesma forma, o teste A / A envolve direcionar o tráfego para duas páginas para ver qual tem melhor desempenho. Mas, ao contrário de um teste A / B, um teste A / A coloca duas páginas idênticas uma contra a outra - e em vez de descobrir um aumento, o objetivo deles é não encontrar nenhuma diferença entre seu controle e variação.

Por que você faria um teste A / A?

Não o culpamos por coçar a cabeça, imaginando "O que diabos o teste de duas páginas idênticas uma contra a outra resultaria?"

Pode parecer bobo, mas é uma técnica que alguns testadores profissionais usam para testar seu teste A / B antes de fazer o teste. (Huh?)

Resultados de teste precisos requerem mais do que significância estatística

Qualquer pessoa pode executar um teste A / B, mas poucos podem executar um teste A / B válido (lembre-se: apenas cerca de 20% dos resultados do teste são realmente legítimos).

A produção de dados de teste precisos envolve mais do que alcançar significância estatística com um tamanho de amostra grande e representativo. Para ter certeza sobre seus resultados, você deve garantir que a amostra não seja contaminada por uma série de ameaças de validade.

Uma dessas ameaças, o efeito do instrumento, é o que os testes A / A são mais úteis para combater.

Qual é o efeito do instrumento?

A proteção contra ameaças de validade começa antes mesmo de você começar o teste A / B. O efeito do instrumento, diz Peep Laja da CXL, é o que envenena a maioria dos resultados dos testes:

Este é o problema mais comum. É quando algo acontece com as ferramentas de teste (ou instrumentos) que causam dados falhos no teste. Geralmente é devido à implementação de código incorreto no site e distorce todos os resultados.

É por isso que, ao configurar um teste, é importante ter certeza de que suas ferramentas estão configuradas corretamente e funcionando como deveriam. Se não estiverem, estes problemas comuns podem surgir:

- Relatório incorreto de indicadores-chave de desempenho. Apenas um erro em uma ferramenta pode confundir seus dados, e é por isso que você nunca deve confiar em uma única plataforma para rastrear todas as suas informações de teste. No mínimo, integre com o Google Analytics para verificar se as métricas que você vê em seu software de teste e rastreamento de site são precisas. Para resultados ainda melhores, verifique três vezes com outra ferramenta. Desconfie de quaisquer relatórios que não correspondam de forma relativamente próxima.

- problemas de exibição da página de destino pós-clique. Pequenos erros de codificação podem causar grandes ameaças de validade, como problemas de exibição, durante o teste A / B. É por isso que é crucial garantir que suas páginas de destino pós-clique tenham a aparência esperada em todos os dispositivos e navegadores, e que os visitantes não sejam afetados por algo chamado de “efeito de oscilação”. Entre outros, um site lento pode causar esse problema, que ocorre quando seu controle é momentaneamente exibido ao visitante antes da variação.

- Interrompendo um teste muito cedo. Alguns softwares de teste declararão uma página vencedora prematuramente - quando o tamanho da amostra não for grande o suficiente ou representativo de seu cliente-alvo. Lembre-se: alcançar significância estatística não significa que é hora de interromper o teste. Quanto mais tempo você executá-lo, mais precisos serão os resultados.

Qualquer um desses problemas (e mais) pode levar a um falso positivo na conclusão do seu teste, e é por isso que Peep avisa os testadores para ficarem vigilantes:

Ao configurar um teste, observe-o como um falcão. Observe que cada meta e métrica que você rastreia está sendo registrada. Se alguma métrica não estiver enviando dados (por exemplo, adicionar ao carrinho de dados de clique), pare o teste, encontre e corrija o problema e reinicie redefinindo os dados.

Mas nem todo mundo se sente confortável imediatamente para o teste A / B com os dois pés - especialmente ao usar um novo software. Portanto, como precaução adicional, alguns profissionais testam A / A para avaliar suas ferramentas antes de iniciar o teste A / B.

Se sua experiência estiver configurada corretamente, no final de um teste A / A, ambas as páginas devem sair com uma taxa de conversão semelhante. Como os testadores a seguir mostram, porém, isso nem sempre acontece.

Exemplos de teste A / A

Os falsos positivos são realmente tão comuns? Uma página pode realmente superar seu clone? Esses caras usaram o teste A / A para descobrir e revelaram suas descobertas nas seguintes postagens do blog ...

1. O teste de divisão da página inicial revela a principal deficiência das ferramentas de teste populares

Em 11 de novembro de 2012, a equipe Copyhackers começou um teste A / A split em sua página inicial, ilustrada abaixo:

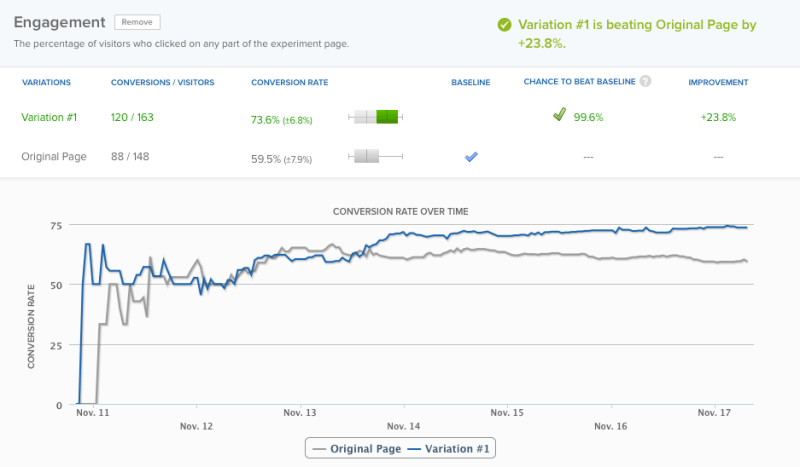

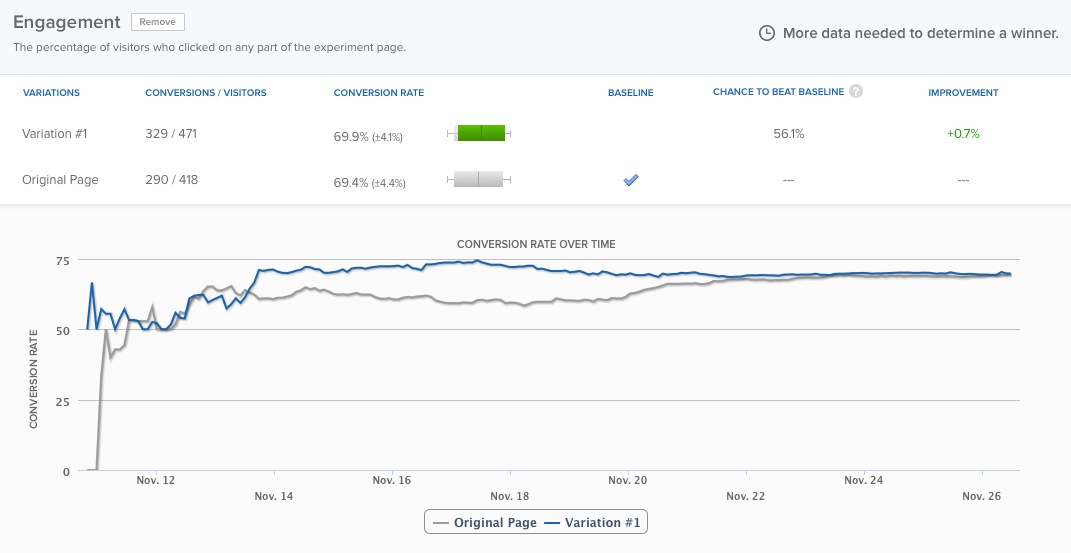

No dia 18 - 6 dias depois - sua ferramenta de teste foi declarada a vencedora com 95% de confiança. Por uma questão de precisão, porém, a equipe decidiu deixar o teste rodar mais um dia - ponto em que seu software foi declarado um vencedor com um nível de confiança de 99,6%:

A página inicial estava com um desempenho quase 24% melhor do que a mesma página exata , e havia apenas 0,4% de chance de o resultado ser um falso positivo, de acordo com o software. Ainda assim, a equipe deixou o teste rodar por cerca de mais três dias, e as diferenças eventualmente se equilibraram:

Mas esse não é o ponto. A questão é: a ferramenta de teste foi declarada vencedora muito cedo. Se a equipe de Copyhackers não o tivesse mantido em execução, eles teriam assumido incorretamente que havia um problema com seu experimento. Leia mais sobre o teste aqui.

2. Teste A / A: como aumentei as conversões em 300% ao fazer absolutamente nada

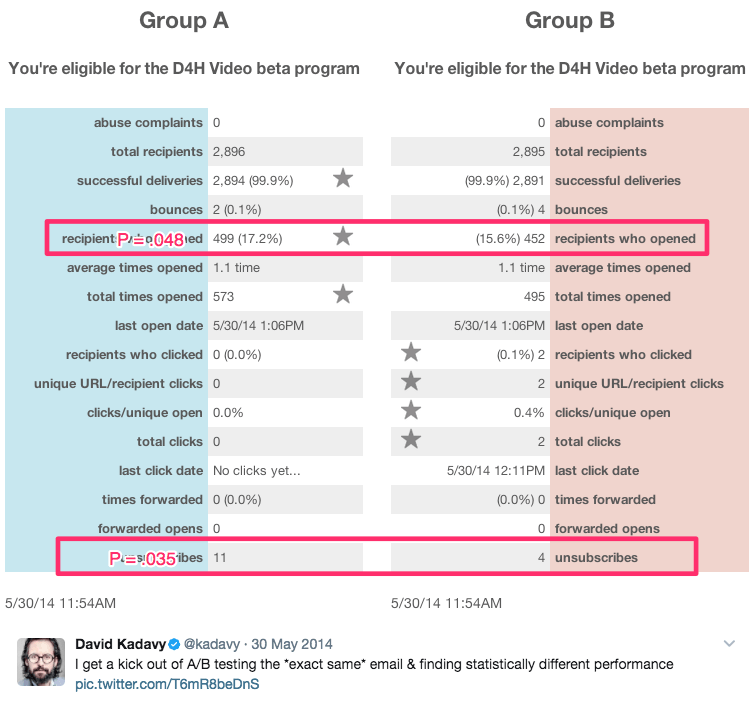

Este título sarcástico vem do autor e autoproclamado “empresário em recuperação”, David Kadavy, que realizou vários testes A / A ao longo de 8 meses em 750.000 assinantes de e-mail. Durante esse tempo, ele gerou resultados estatisticamente significativos, como estes:

Entre esses resultados estavam:

- Um aumento de 9% nas aberturas de e-mail

- Um aumento de 300% nos cliques

- Uma taxa de cancelamento de inscrição 51% menor

Ele diz:

Para muitos empreendedores (inclusive o meu antigo), isso parece "Nossa, você aumentou as aberturas em 10%!" Eles podem até inseri-lo na calculadora de significância do Otimizador de website Visual e ver que p = 0,048. “É estatisticamente significativo!” eles (ou eu) podem exclamar.

A verdade é, porém, todos esses eram testes A / A. O conteúdo testado entre si era idêntico. Veja mais de seus resultados aqui.

Você deve executar testes A / A?

A resposta a esta pergunta depende de quem você pergunta.

Neil Patel, que continuou vendo grandes aumentos de conversão que não significavam mais receita, diz “É muito importante que você execute um teste A / A primeiro, pois isso ajudará a garantir que você não perca tempo com software impreciso”.

Por outro lado, Peep Laja da CXL diz que os próprios testes A / A são uma perda de tempo. Então, quem está certo?

Os dois principais problemas com o teste A / A

Do ponto de vista teórico, o teste A / A faz muito sentido. Acima de tudo, a precisão é mais importante ao executar um teste A / B, e testar seu teste é apenas uma das muitas maneiras de garanti-lo.

Em ambientes de teste do mundo real, no entanto, os testes A / A têm o potencial de causar mais danos do que benefícios. Craig Sullivan explica:

Para mim, o problema é sempre consumir tráfego real e tempo de teste, por ter que pré-carregar o tempo de execução do teste com um período de teste A / A. Se estou tentando fazer 40 testes por mês, isso prejudica minha capacidade de colocar as coisas no ar. Eu prefiro ter meio dia de teste de controle de qualidade no experimento do que executar 2 a 4 semanas de teste A / A para verificar se está alinhado.

Esse é o problema um. Os testes A / A custam tempo real e tráfego que você poderia usar para aprender mais sobre os visitantes do seu site com os testes A / B.

O problema dois é exemplificado no estudo de caso de Copyhackers. Como os testes A / B, os testes A / A precisam ser projetados e monitorados com cuidado, porque também são suscetíveis a falsos positivos.

Em outras palavras, seu teste A / A pode dizer que uma página está tendo um desempenho melhor do que a outra, quando não está (essa chance é muito maior do que você pensa - cerca de 50%)

Se a equipe da Copyhackers tivesse ouvido sua ferramenta de teste e declarado um vencedor apenas seis dias depois, eles teriam gasto ainda mais tempo tentando descobrir por que sua página inicial estava tendo um desempenho melhor do que seu gêmeo idêntico (quando realmente não estava) .

O principal benefício do teste A / A

Apesar desses problemas, o teste A / A tem o potencial de ajudá-lo a detectar problemas ainda maiores durante os testes reais . Quando os resultados desses testes são aqueles em que você está se baseando em importantes decisões de negócios, esse é um benefício poderoso a ser considerado.

Se você decidir fazer o teste A / A, existe uma maneira potencialmente menos desperdiçadora de fazê-lo, chamada de teste A / A / B.

Teste A / A / B vs. teste A / A

O método tradicional de teste A / A desperdiça tráfego porque não informa nada sobre seus visitantes na conclusão. Mas, se você adicionar uma variação “B” a esse teste, pode. Aqui está a diferença entre os dois:

- Teste A / A = 2 páginas idênticas testadas uma contra a outra

- Teste A / A / B = 2 páginas idênticas e uma variação testada entre si

Um teste A / A / B divide seu tráfego em três segmentos, o que significa que demorará mais para atingir significância estatística. Mas a vantagem é que, depois de fazer isso, você terá dados sobre a ferramenta de teste e os visitantes.

Compare os resultados de A vs. A para determinar se você pode confiar em seu teste. Se eles forem estatisticamente semelhantes, compare os resultados de A vs. B. Se não forem, você terá que jogar fora os resultados de todo o teste (que demorou mais do que um teste A / A tradicional para ser executado já que seu tráfego é segmentado de três maneiras).

Os benefícios do teste A / A superam os contras?

Alguns especialistas dizem "sim", enquanto outros dizem "não". Andrew First, da Leadplum, parece pensar que a resposta fica em algum lugar entre:

O teste A / A provavelmente não deve ser mensal, mas quando você está configurando uma nova ferramenta, vale a pena testar seus dados. Se você interceptar dados incorretos agora, terá mais confiança em seus resultados de teste meses depois.

Em última análise, depende de você. Se você estiver usando uma nova ferramenta, convém seguir o conselho de Andrew. Se você não estiver, no entanto, provavelmente é melhor seguir o exemplo de Craig Sullivan e, em vez disso, configurar um processo de controle de qualidade de pré-teste rigoroso. Economize seu tempo, recursos e tráfego para testes A / B.

Obtenha o máximo de seus esforços de teste e campanhas de anúncios digitais, inscreva-se para uma demonstração do Instapage Enterprise hoje mesmo.