Qu'est-ce que le test A/A et pourquoi les marketeurs devraient-ils s'en soucier ?

Publié: 2017-05-18Avez-vous vécu ce scénario? Vous mettez en place un test A/B pour découvrir si votre nouvelle combinaison bouton/titre générera plus de conversions…

Vous générez un trafic égal vers vos deux pages de destination post-clic - le contrôle et la variation - et vous arrêtez après un mois, lorsque votre logiciel déclare votre variation gagnante avec une confiance de 99%…

Vous déployez la nouvelle conception « gagnante », mais plusieurs cycles économiques plus tard, cette augmentation de 50 % du taux de conversion n'a aucun impact sur vos résultats. Vous êtes confus. Vous êtes ennuyé…

Et vous êtes probablement victime d'un résultat de test faussement positif.

Qu'est-ce qu'un résultat de test faussement positif ?

Pourquoi cette augmentation du taux de conversion de 50 % ne se traduit-elle pas par plus de ventes ? La raison, explique Lance Jones de Copyhackers, est qu'elle n'existait probablement pas.

Il est tout à fait possible (même probable) que vous ne voyiez pas l'augmentation des ventes ou des revenus de votre test, car cela n'a jamais été le cas. Vous avez peut-être reçu sans le savoir un « faux positif » dans votre test - connu sous le nom d'erreur statistique de type I, autrement connu sous le nom de rejet incorrect d'une véritable hypothèse nulle. C'est une bouchée, donc je m'en souviens simplement comme un faux positif.

Bouchées ou non, ces erreurs statistiques de type 1 sont plus courantes que vous ne le pensez. On estime qu'environ 80% des résultats des tests AB sont imaginaires.

Cliquez pour tweeter

Si vous prenez des décisions clés sur la base de faux positifs, au mieux, vous laissez l'optimisation au hasard. Au pire, vous détériorez en fait le taux de conversion de vos pages de destination post-clic.

Heureusement, il existe des moyens de lutter contre les données toxiques. L'un d'eux est similaire à une méthode de test que vous connaissez probablement déjà…

Qu'est-ce que le test A/A ?

Les tests A/B impliquent de diriger le trafic vers deux pages différentes - une version originale (votre contrôle) et une autre version (votre variante) - pour voir laquelle est la plus performante.

De même, les tests A/A impliquent de diriger le trafic vers deux pages pour voir laquelle est la plus performante. Mais contrairement à un test A/B, un test A/A oppose deux pages identiques - et au lieu de découvrir un ascenseur, leur objectif est de ne trouver aucune différence entre votre contrôle et votre variation.

Pourquoi feriez-vous un test A/A ?

Nous ne vous blâmons pas de vous être gratté la tête en vous demandant « Qu'est-ce que le fait de tester deux pages identiques l'une contre l'autre accomplirait ? »

Cela peut sembler idiot, mais c'est une technique que certains testeurs professionnels utilisent pour tester leur test A/B avant de tester. (Hein?)

Des résultats de test précis nécessitent plus que la signification statistique

N'importe qui peut exécuter un test A/B, mais peu peuvent exécuter un test A/B valide (rappelez-vous : seulement environ 20 % des résultats des tests sont réellement légitimes).

Produire des données de test précises implique plus que d'atteindre une signification statistique avec un échantillon de grande taille et représentatif. Pour être sûr de vos résultats, vous devez vous assurer que l'échantillon n'est pas entaché par un certain nombre de menaces de validité.

L'une de ces menaces, l'effet instrument, est ce que les tests A/A sont les plus utiles pour combattre.

Qu'est-ce que l'effet instrument ?

La protection contre les menaces de validité commence avant même de commencer les tests A/B. L'effet de l'instrument, selon Peep Laja de CXL, est ce qui empoisonne la plupart des résultats de test :

C'est le problème le plus courant. C'est quand quelque chose se passe avec les outils de test (ou instruments) qui causent des données erronées dans le test. Cela est souvent dû à une mauvaise implémentation du code sur le site Web et faussera tous les résultats.

C'est pourquoi, lors de la mise en place d'un test, il est important de s'assurer que vos outils sont correctement configurés et fonctionnent comme ils le devraient. Si ce n'est pas le cas, ces problèmes courants peuvent survenir :

- Mauvaise déclaration des indicateurs de performance clés. Une seule erreur dans un outil peut brouiller vos données, c'est pourquoi vous ne devez jamais vous fier à une seule plate-forme pour suivre toutes vos informations de test. À tout le moins, intégrez Google Analytics pour vérifier que les métriques que vous voyez dans votre logiciel de test et le suivi de votre site Web sont exactes. Pour des résultats encore meilleurs, vérifiez trois fois avec un autre outil. Méfiez-vous des rapports qui ne correspondent pas assez étroitement.

- problèmes d'affichage de la page de destination post-clic. De petites erreurs de codage peuvent entraîner de grandes menaces de validité, comme des problèmes d'affichage, lors de votre test A/B. C'est pourquoi il est crucial de s'assurer que vos pages de destination post-clic ont l'apparence qu'elles sont censées avoir sur tous les appareils et navigateurs, et que vos visiteurs ne sont pas affectés par ce que l'on appelle « l'effet de scintillement ». Entre autres, un site Web lent peut causer ce problème, qui se produit lorsque votre contrôle est momentanément affiché à votre visiteur juste avant la variation.

- Arrêter un test trop tôt. Certains logiciels de test déclareront une page gagnante prématurément, lorsque la taille de l'échantillon n'est pas assez grande ou représentative de votre client cible. N'oubliez pas : atteindre la signification statistique ne signifie pas qu'il est temps d'arrêter votre test. Plus vous l'exécutez longtemps, plus vos résultats seront précis.

N'importe lequel de ces problèmes (et bien d'autres) peut conduire à un faux positif à la fin de votre test, c'est pourquoi Peep avertit les testeurs d'être vigilants :

Lorsque vous configurez un test, regardez-le comme un faucon. Observez que chaque objectif et chaque métrique que vous suivez sont enregistrés. Si certaines métriques n'envoient pas de données (par exemple, ajouter au panier les données de clic), arrêtez le test, recherchez et résolvez le problème, puis recommencez en réinitialisant les données.

Mais tout le monde ne se sent pas à l'aise de se lancer immédiatement dans les tests A/B avec les deux pieds, en particulier lors de l'utilisation d'un nouveau logiciel. Ainsi, par précaution supplémentaire, certains praticiens testent A/A pour évaluer leurs outils avant de commencer les tests A/B.

Si votre test est correctement configuré, à la fin d'un test A/A, les deux pages devraient apparaître avec un taux de conversion similaire. Cependant, comme le montrent les testeurs suivants, cela n'arrive pas toujours.

Exemples de tests A/A

Les faux positifs sont-ils vraiment si fréquents ? Une page peut-elle vraiment surpasser son clone ? Ces gars ont utilisé des tests A/A pour découvrir et ont révélé leurs conclusions dans les articles de blog suivants…

1. Le test fractionné de la page d'accueil révèle une lacune majeure des outils de test populaires

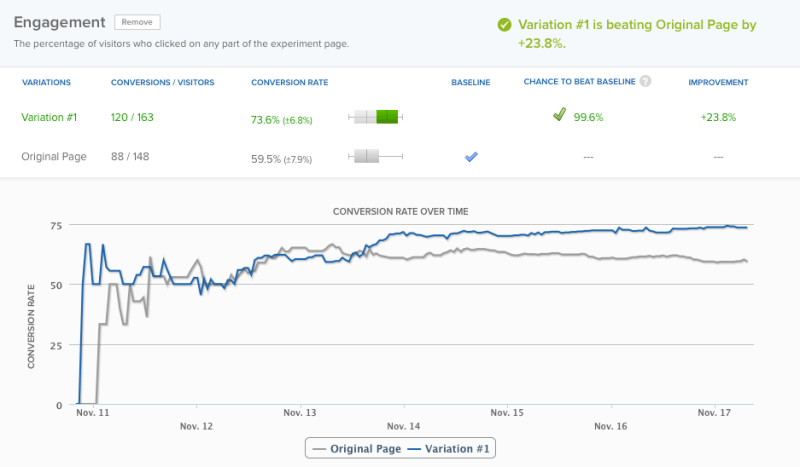

Le 11 novembre 2012, l'équipe Copyhackers a commencé un test fractionné A/A sur sa page d'accueil, illustré ci-dessous :

Le 18, 6 jours plus tard, leur outil de test a été déclaré gagnant avec une confiance de 95 %. Par souci de précision, cependant, l'équipe a décidé de laisser le test se dérouler un jour de plus. À ce stade, leur logiciel a déclaré vainqueur avec un niveau de confiance de 99,6 % :

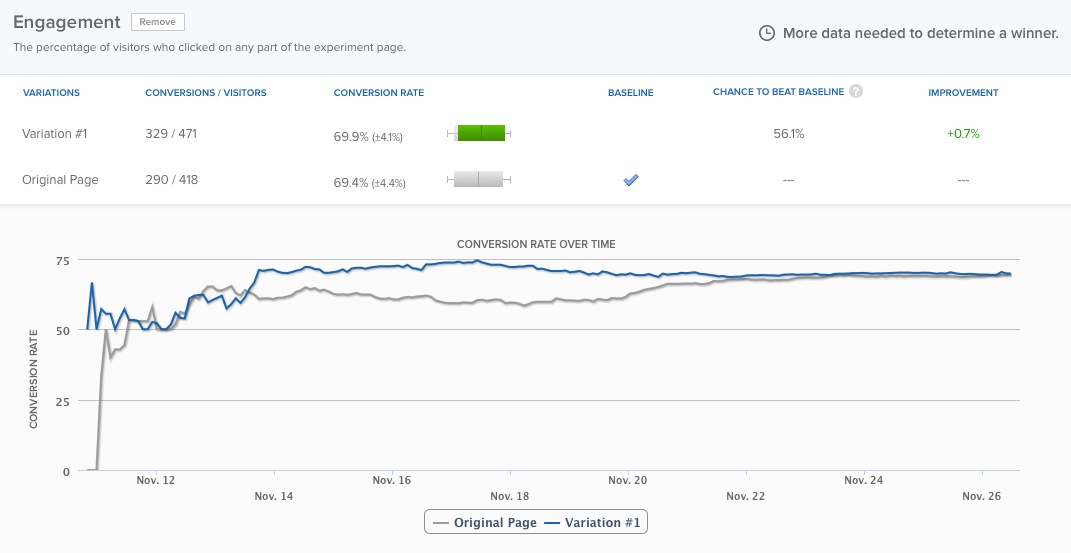

Leur page d'accueil fonctionnait près de 24% de mieux que la même page exacte , et il n'y avait que 0,4% de chance que le résultat soit un faux positif, selon le logiciel. Pourtant, l'équipe a laissé le test se dérouler pendant environ trois jours supplémentaires, et les différences se sont finalement aplanies :

Mais ce n'est pas le sujet. Le fait est que l'outil de test a été déclaré gagnant trop tôt. Si l'équipe de Copyhackers ne l'avait pas fait fonctionner, ils auraient supposé à tort qu'il y avait un problème avec leur expérience. En savoir plus sur le test ici.

2. Tests A/A : comment j'ai augmenté les conversions de 300 % en ne faisant absolument rien

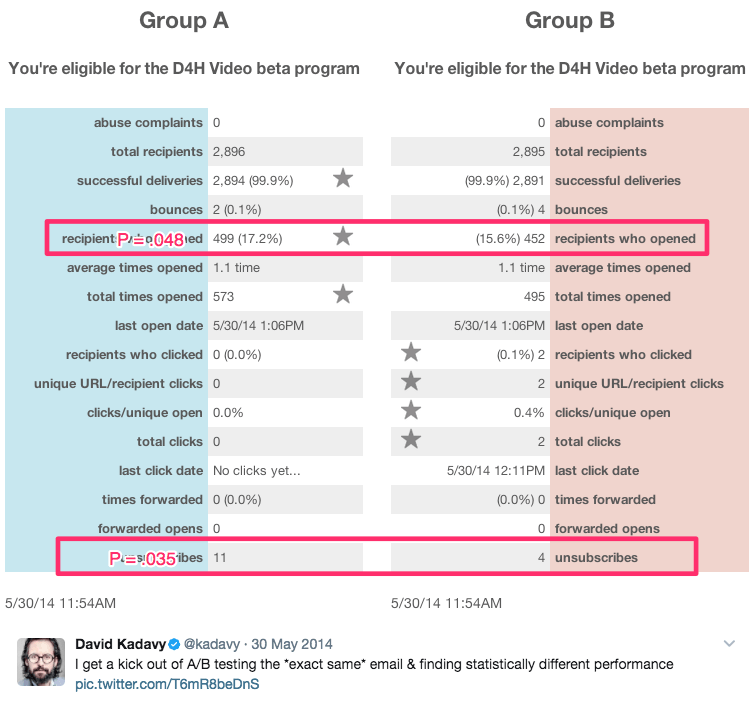

Ce titre sarcastique vient de l'auteur et autoproclamé « recovering wantrepreneur », David Kadavy, qui a effectué un certain nombre de tests A/A sur 8 mois auprès de 750 000 abonnés aux e-mails. Pendant ce temps, il a généré des résultats statistiquement significatifs, comme ceux-ci :

Parmi ces résultats figuraient :

- Une augmentation de 9% des ouvertures d'e-mails

- Une augmentation de 300 % des clics

- Un taux de désabonnement inférieur de 51 %

Il dit:

Pour de nombreux wantrepreneurs (y compris mon ancien moi), cela ressemble à « oh wow, vous avez augmenté les ouvertures de 10 % ! » Ils peuvent même le saisir dans le calculateur d'importance de Visual Website Optimizer et constater que p = 0,048. « C'est statistiquement significatif ! » ils (ou moi) pourraient s'exclamer.

La vérité est, cependant, que ce sont tous des tests A/A. Les contenus testés les uns par rapport aux autres étaient identiques. Voir plus de ses résultats ici.

Faut-il faire des tests A/A ?

La réponse à cette question dépend de qui vous demandez.

Neil Patel, qui n'arrêtait pas de constater d'importantes augmentations de conversion qui n'équivalaient pas à plus de revenus, déclare : « Il est vraiment important que vous exécutiez d'abord un test A/A, car cela vous aidera à vous assurer que vous ne perdez pas de temps avec des logiciels inexacts. »

D'un autre côté, Peep Laja de CXL dit que les tests A/A eux-mêmes sont une perte de temps. Alors qui a raison ?

Les deux problèmes majeurs des tests A/A

D'un point de vue théorique, les tests A/A ont beaucoup de sens. Par-dessus tout, la précision est la plus importante lors de l'exécution d'un test A/B, et tester votre test n'est qu'un des nombreux moyens de le garantir.

Dans les environnements de test du monde réel, cependant, les tests A/A ont le potentiel de faire plus de mal que de bien. Craig Sullivan explique :

Pour moi, le problème est toujours de consommer du trafic réel et du temps de test, en devant précharger le temps d'exécution du test avec une période de test A/A. Si j'essaie d'exécuter 40 tests par mois, cela paralysera ma capacité à mettre des choses en ligne. Je préfère avoir une demi-journée de tests d'assurance qualité sur l'expérience que d'exécuter 2 à 4 semaines de tests A/A pour vérifier qu'elle s'aligne.

C'est le problème un. Les tests A/A coûtent du temps réel et du trafic que vous pourriez utiliser pour en savoir plus sur les visiteurs de votre site Web avec les tests A/B.

Le problème deux est illustré dans l'étude de cas de Copyhackers. Comme les tests A/B, les tests A/A doivent être conçus et surveillés avec soin, car ils sont également sensibles aux faux positifs.

En d'autres termes, votre test A/A peut vous dire qu'une page est plus performante qu'une autre, alors que ce n'est pas le cas (cette chance est beaucoup plus élevée que vous ne le pensez - environ 50 %)

Si l'équipe de Copyhackers avait écouté leur outil de test et déclaré un gagnant seulement six jours plus tard, ils auraient passé encore plus de temps à essayer de comprendre pourquoi leur page d'accueil fonctionnait mieux que son jumeau identique (quand ce n'était vraiment pas le cas) .

Le principal avantage des tests A/A

Malgré ces problèmes, les tests A/A ont le potentiel de vous aider à détecter des problèmes encore plus importants lors de tests réels . Lorsque les résultats de ces tests sont ceux sur lesquels vous fondez des décisions commerciales importantes, c'est un avantage important à considérer.

Si vous décidez de faire un test A/A, il existe un moyen potentiellement moins coûteux de le faire, appelé test A/A/B.

Test A/A/B vs test A/A

La méthode traditionnelle de test A/A gaspille du trafic car elle ne vous dit rien sur vos visiteurs à la fin. Mais, si vous ajoutez une variation « B » à ce test, cela pourrait le faire. Voici la différence entre les deux :

- Test A/A = 2 pages identiques testées l'une contre l'autre

- Test A/A/B = 2 pages identiques et une variante testées l'une contre l'autre

Un test A/A/B divise votre trafic en trois segments, ce qui signifie qu'il faudra plus de temps pour atteindre la signification statistique. Mais l'avantage est qu'une fois que vous l'aurez fait, vous disposerez de données à la fois sur votre outil de test et sur vos visiteurs.

Comparez les résultats de A contre A pour déterminer si vous pouvez faire confiance à votre test. S'ils sont statistiquement similaires, comparez les résultats de A par rapport à B. Si ce n'est pas le cas, vous devrez rejeter les résultats de l'ensemble du test (qui a pris plus de temps qu'un test A/A traditionnel à exécuter puisque votre trafic est segmenté de trois manières).

Les avantages des tests A/A l'emportent-ils sur les inconvénients ?

Certains experts disent « oui », tandis que d'autres disent « non ». Andrew First de Leadplum semble penser que la réponse se situe quelque part entre :

Les tests A/A ne devraient probablement pas être une affaire mensuelle, mais lorsque vous configurez un nouvel outil, cela vaut la peine de prendre le temps de tester vos données. Si vous interceptez de mauvaises données maintenant, vous serez plus confiant dans les résultats de vos tests des mois plus tard.

En fin de compte, c'est à vous. Si vous utilisez un nouvel outil, il peut être judicieux de suivre les conseils d'Andrew. Si ce n'est pas le cas, il est probablement préférable de suivre l'exemple de Craig Sullivan et de mettre en place un processus d'assurance qualité pré-test rigoureux. Économisez votre temps, vos ressources et votre trafic pour les tests A/B.

Tirez le meilleur parti de vos efforts de test et de vos campagnes publicitaires numériques, inscrivez-vous dès aujourd'hui pour une démo Instapage Enterprise.