Che cos'è il test A/A e perché dovrebbe interessare ai marketer?

Pubblicato: 2017-05-18Hai vissuto questo scenario? Imposti un test A/B per scoprire se la tua nuova combinazione di pulsante e titolo genererà più conversioni...

Conduci lo stesso traffico a entrambe le pagine di destinazione post-clic, il controllo e la variazione, e ti fermi dopo un mese, quando il tuo software dichiara la tua variante vincitrice con una sicurezza del 99%...

Distribuisci il nuovo design "vincente", ma diversi cicli economici dopo, quell'aumento del 50% nel tasso di conversione non mostra alcun impatto sui tuoi profitti. Sei confuso. sei infastidito...

E probabilmente sei vittima di un risultato del test falso positivo.

Che cos'è un risultato del test falso positivo?

Perché quell'aumento del tasso di conversione del 50% non si traduce in più vendite? Il motivo, dice Lance Jones di Copyhackers, è perché probabilmente non esisteva.

È del tutto possibile (anche probabile) che tu non veda l'aumento delle vendite o dei ricavi dal tuo test perché non c'è mai stato in primo luogo. Potresti aver ricevuto inconsapevolmente un "falso positivo" nel tuo test, noto come errore statistico di tipo I, altrimenti noto come rifiuto errato di un'ipotesi nulla vera. È un boccone, quindi lo ricordo semplicemente come un falso positivo.

Bocchino o no, questi errori statistici di tipo 1 sono più comuni di quanto si pensi. Si stima che circa l'80% dei risultati dei test AB siano immaginari.

Fai clic per twittare

Se stai prendendo decisioni chiave basate su falsi positivi, nella migliore delle ipotesi, stai lasciando l'ottimizzazione al caso. Nel peggiore dei casi, stai effettivamente peggiorando il tasso di conversione delle tue pagine di destinazione post clic.

Fortunatamente, ci sono alcuni modi per combattere i dati velenosi. Uno di questi è simile a un metodo di test con cui probabilmente hai già familiarità...

Che cos'è il test A/A?

I test A/B comportano l'indirizzamento del traffico a due pagine diverse, una originale (il tuo controllo) e un'altra versione (la tua variante) per vedere quale funziona meglio.

Allo stesso modo, il test A/A comporta l'indirizzamento del traffico su due pagine per vedere quale funziona meglio. Ma a differenza di un test A/B, un test A/A mette due pagine identiche l'una contro l'altra - e invece di scoprire un passaggio, il loro obiettivo è quello di non trovare alcuna differenza tra il tuo controllo e la variazione.

Perché dovresti fare il test A/A?

Non ti biasimiamo per esserti grattato la testa, chiedendoti "Cosa diavolo farebbe testare due pagine identiche l'una contro l'altra?"

Può sembrare sciocco, ma è una tecnica che alcuni tester professionisti usano per testare il loro test A/B prima di eseguire il test. (eh?)

I risultati accurati dei test richiedono più della significatività statistica

Chiunque può eseguire un test A/B, ma pochi possono eseguire un test A/B valido (ricorda: solo il 20% circa dei risultati dei test è effettivamente legittimo).

La produzione di dati di test accurati implica molto di più che raggiungere la significatività statistica con una dimensione del campione ampia e rappresentativa. Per essere sicuro dei tuoi risultati, devi assicurarti che il campione non sia contaminato da una serie di minacce alla validità.

Una di queste minacce, l'effetto strumento, è ciò che i test A/A sono più utili per combattere.

Qual è l'effetto strumento?

La protezione contro le minacce alla validità inizia prima ancora di iniziare il test A/B. L'effetto strumento, dice Peep Laja di CXL, è ciò che avvelena la maggior parte dei risultati dei test:

Questo è il problema più comune. È quando succede qualcosa con gli strumenti (o gli strumenti) di test che causano dati errati nel test. Spesso è dovuto a un'implementazione errata del codice sul sito Web e distorcerà tutti i risultati.

Ecco perché, quando si imposta un test, è importante assicurarsi che i propri strumenti siano configurati correttamente e funzionino come dovrebbero. In caso contrario, possono sorgere questi problemi comuni:

- Segnalazione errata degli indicatori chiave di prestazione. Un solo errore in uno strumento può confondere i tuoi dati, motivo per cui non dovresti mai fare affidamento su una singola piattaforma per tenere traccia di tutte le informazioni del tuo test. Per lo meno, integra con Google Analytics per ricontrollare che le metriche che vedi nel tuo software di test e nel monitoraggio del sito web siano accurate. Per risultati ancora migliori, ricontrolla con un altro strumento. Diffida di tutti i rapporti che non corrispondono relativamente da vicino.

- problemi di visualizzazione della pagina di destinazione post clic. Piccoli errori di codifica possono causare grandi minacce alla validità, come problemi di visualizzazione, durante il test A/B. Ecco perché è fondamentale assicurarsi che le pagine di destinazione post clic appaiano come dovrebbero su tutti i dispositivi e browser e che i visitatori non siano influenzati da qualcosa chiamato "effetto sfarfallio". Tra l'altro, un sito web lento può causare questo problema, che si verifica quando il tuo controllo viene momentaneamente mostrato al tuo visitatore appena prima della variazione.

- Interrompere un test troppo presto. Alcuni software di test dichiareranno una pagina vincente prematuramente, quando una dimensione del campione non è abbastanza grande o rappresentativa del tuo cliente target. Ricorda: raggiungere la significatività statistica non significa che sia il momento di interrompere il test. Più a lungo lo esegui, più accurati saranno i risultati.

Ognuno di questi problemi (e altri) può portare a un falso positivo alla conclusione del test, motivo per cui Peep avverte i tester di essere vigili:

Quando imposti un test, osservalo come un falco. Osserva che ogni singolo obiettivo e metrica che tieni traccia viene registrato. Se alcune metriche non inviano dati (ad es. aggiungi al carrello i dati sui clic), interrompi il test, trova e risolvi il problema e ricomincia reimpostando i dati.

Ma non tutti si sentono a proprio agio nel lanciarsi immediatamente nei test A/B con entrambi i piedi, specialmente quando si utilizza un nuovo software. Quindi, come ulteriore precauzione, alcuni professionisti effettuano test A/A per valutare i propri strumenti prima di iniziare il test A/B.

Se il tuo esperimento è impostato correttamente, alla fine di un test A/A, entrambe le pagine dovrebbero emergere con un tasso di conversione simile. Tuttavia, come mostrano i seguenti tester, ciò non accade sempre.

Esempi di test A/A

I falsi positivi sono davvero così comuni? Una pagina può davvero superare il suo clone? Questi ragazzi hanno usato i test A/A per scoprirlo e hanno rivelato i loro risultati nei seguenti post sul blog...

1. Il test diviso della home page rivela una grave carenza di strumenti di test popolari

L'11 novembre 2012, il team di Copyhackers ha iniziato uno split test A/A sulla loro homepage, nella foto sotto:

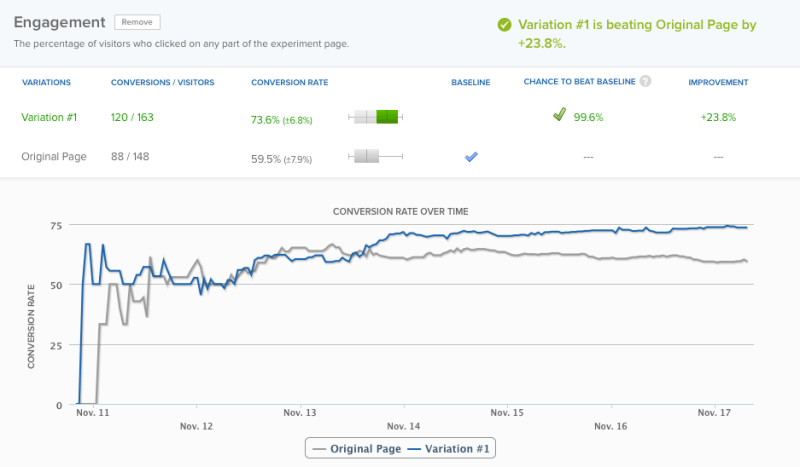

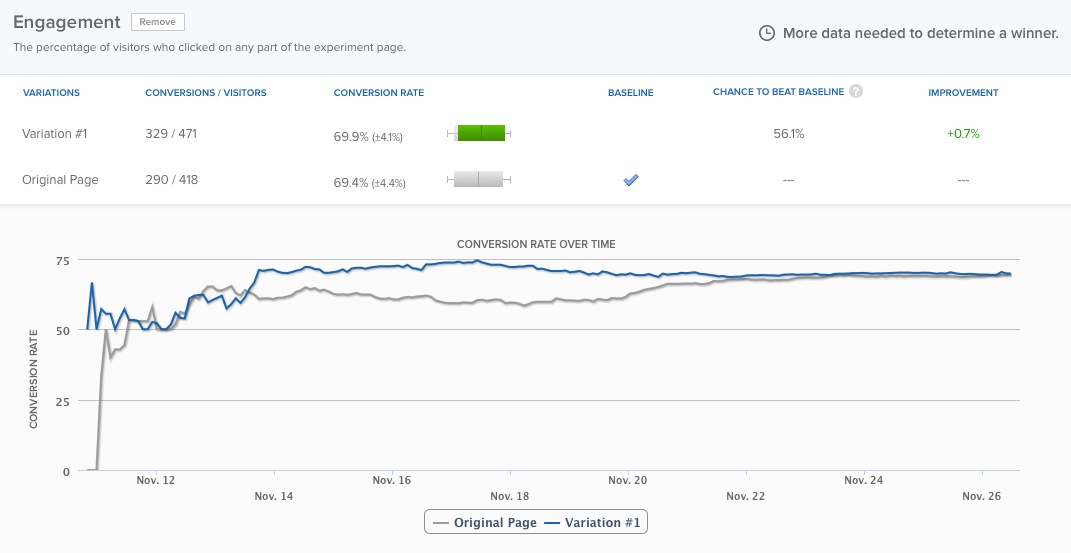

Il 18, 6 giorni dopo, il loro strumento di test ha dichiarato un vincitore con una fiducia del 95%. Per motivi di precisione, tuttavia, il team ha deciso di eseguire il test un altro giorno, a quel punto il loro software ha dichiarato vincitore con un livello di confidenza del 99,6%:

La loro homepage stava funzionando quasi del 24% in più rispetto alla stessa identica pagina e c'era solo una probabilità dello 0,4% che il risultato fosse un falso positivo, secondo il software. Tuttavia, il team ha lasciato funzionare il test per altri tre giorni circa e alla fine le differenze si sono uniformate:

Ma non è questo il punto. Il punto è: lo strumento di test ha dichiarato un vincitore troppo presto. Se il team di Copyhackers non lo avesse tenuto attivo, avrebbero erroneamente pensato che ci fosse un problema con il loro esperimento. Leggi di più sul test qui.

2. Test A/A: come ho aumentato le conversioni del 300% non facendo assolutamente nulla

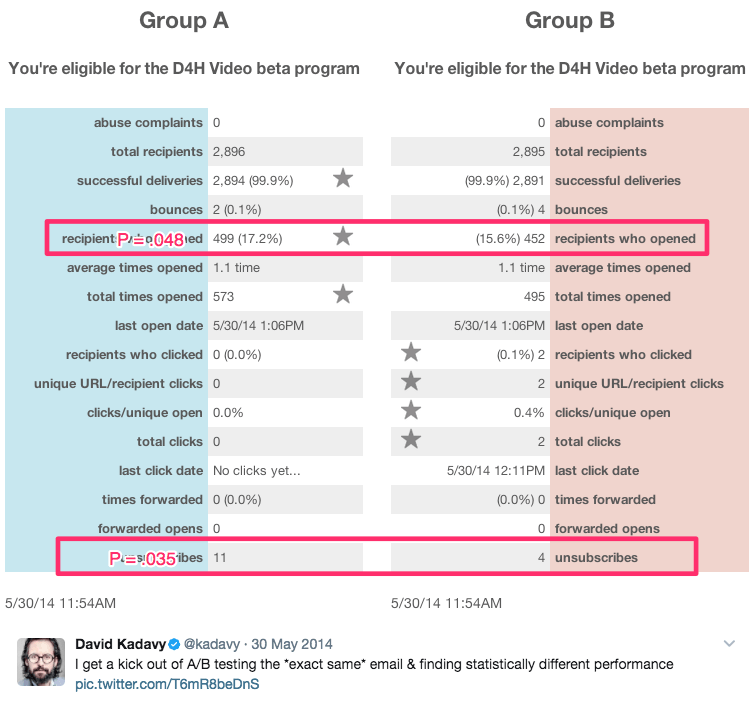

Questo titolo sarcastico proviene dall'autore e autoproclamatosi "recuperatore di fantasia", David Kadavy, che ha eseguito una serie di test A/A per 8 mesi su 750.000 abbonati alla posta elettronica. Durante quel periodo, ha generato risultati statisticamente significativi, come questi:

Tra questi risultati c'erano:

- Si apre un aumento del 9% delle email

- Un aumento del 300% dei clic

- Un tasso di annullamento dell'iscrizione inferiore del 51%

Lui dice:

A molti aspiranti rappresentanti (incluso il mio ex me stesso), questo sembra "oh wow, hai aumentato le aperture del 10%!" Potrebbero persino inserirlo nel calcolatore del significato di Visual Website Optimizer e vedere che p = 0,048. "È statisticamente significativo!" loro (o io) potrei esclamare.

La verità è, però, che questi erano tutti test A/A. Il contenuto testato l'uno contro l'altro era identico. Vedi più dei suoi risultati qui.

Dovresti eseguire test A/A?

La risposta a questa domanda dipende da chi chiedi.

Neil Patel, che continuava a vedere grandi incrementi di conversione che non equivalevano a maggiori entrate, afferma: "È davvero importante eseguire prima un test A/A in quanto ciò ti aiuterà a non perdere tempo con software impreciso".

D'altra parte, Peep Laja di CXL afferma che i test A/A stessi sono una perdita di tempo. Allora chi ha ragione?

I due problemi principali con i test A/A

Da un punto di vista teorico, il test A/A ha molto senso. Soprattutto, l'accuratezza è molto importante quando si esegue un test A/B e testare il test è solo uno dei tanti modi per assicurarlo.

Negli ambienti di test del mondo reale, tuttavia, i test A/A hanno il potenziale per fare più male che bene. Craig Sullivan spiega:

Per me, il problema è sempre consumare traffico reale e tempo di test, dovendo precaricare il tempo di esecuzione del test con un periodo di test A/A. Se sto cercando di eseguire 40 test al mese, questo paralizzerà la mia capacità di ottenere materiale dal vivo. Preferirei avere una mezza giornata di test QA sull'esperimento piuttosto che eseguire 2-4 settimane di test A/A per verificarne l'allineamento.

Questo è il problema uno. I test A/A costano tempo reale e traffico che potresti utilizzare per saperne di più sui visitatori del tuo sito web con i test A/B.

Il problema due è esemplificato nel caso di studio di Copyhackers. Come i test A/B, i test A/A devono essere progettati e monitorati con attenzione, perché sono anche suscettibili di falsi positivi.

In altre parole, il tuo test A/A potrebbe dirti che una pagina sta funzionando meglio dell'altra, quando non lo è (questa possibilità è molto più alta di quanto pensi - circa il 50%)

Se il team di Copyhackers avesse ascoltato il loro strumento di test e avesse dichiarato un vincitore solo sei giorni dopo, avrebbero trascorso ancora più tempo a cercare di capire perché la loro homepage stava funzionando meglio del suo gemello identico (quando in realtà non lo era) .

Il principale vantaggio del test A/A

Nonostante questi problemi, il test A/A ha il potenziale per aiutarti a rilevare problemi ancora più grandi durante i test reali . Quando i risultati di questi test sono quelli su cui stai basando importanti decisioni aziendali, questo è un potente vantaggio da considerare.

Se decidi di eseguire un test A/A, esiste un modo potenzialmente meno dispendioso per farlo, chiamato test A/A/B.

Test A/A/B vs. test A/A

Il metodo tradizionale di test A/A spreca traffico perché non ti dice nulla sui tuoi visitatori alla sua conclusione. Ma se aggiungi una variazione "B" a quel test, potrebbe. Ecco la differenza tra i due:

- A/A test = 2 pagine identiche testate l'una contro l'altra

- Test A/A/B = 2 pagine identiche e una variazione testate l'una contro l'altra

Un test A/A/B divide il tuo traffico in tre segmenti, il che significa che ci vorrà più tempo per raggiungere la significatività statistica. Ma il lato positivo è che, una volta fatto, avrai dati sia sul tuo strumento di test che sui tuoi visitatori.

Confronta i risultati di A contro A per determinare se puoi fidarti del tuo test. Se sono statisticamente simili, confronta i risultati di A con quelli di B. In caso contrario, dovrai eliminare i risultati dell'intero test (che ha richiesto più tempo di un test A/A tradizionale per essere eseguito poiché il tuo traffico è segmentato in tre modi).

I vantaggi del test A/A superano gli svantaggi?

Alcuni esperti dicono "sì", mentre altri dicono "no". Andrew First di Leadplum sembra pensare che la risposta rientri tra:

Probabilmente il test A/A non dovrebbe essere un affare mensile, ma quando stai configurando un nuovo strumento, vale la pena dedicare del tempo a testare i tuoi dati. Se intercettate i dati errati ora, sarete più sicuri dei risultati dei test a distanza di mesi.

Alla fine, dipende da te. Se stai usando un nuovo strumento, potrebbe essere saggio seguire il consiglio di Andrew. In caso contrario, probabilmente è meglio seguire l'esempio di Craig Sullivan e impostare invece un rigoroso processo di controllo qualità pre-test. Risparmia tempo, risorse e traffico per i test A/B.

Ottieni il massimo dai tuoi sforzi di test e dalle campagne pubblicitarie digitali, registrati oggi per una demo di Instapage Enterprise.