¿Qué son las pruebas A / A y por qué deberían preocuparse los especialistas en marketing?

Publicado: 2017-05-18¿Has pasado por este escenario? Configura una prueba A / B para descubrir si su nueva combinación de botón y título generará más conversiones ...

Dirige el mismo tráfico a las dos páginas de destino posteriores al clic (el control y la variación) y se detiene después de un mes, cuando su software declara que su variación es la ganadora con un 99% de confianza ...

Implementa el nuevo diseño "ganador", pero varios ciclos económicos más tarde, ese aumento del 50% en la tasa de conversión no muestra ningún impacto en su resultado final. Estas confundido. Estás molesto ...

Y probablemente sea víctima de un resultado de prueba falso positivo.

¿Qué es un resultado de prueba falso positivo?

¿Por qué ese aumento de la tasa de conversión del 50% no se traduce en más ventas? La razón, dice Lance Jones de Copyhackers, es porque probablemente no existía.

Es completamente posible (incluso probable) que no vea el aumento en las ventas o los ingresos de su prueba porque nunca estuvo allí en primer lugar. Es posible que, sin saberlo, haya recibido un "falso positivo" en su prueba, lo que se conoce como un error estadístico de Tipo I, también conocido como un rechazo incorrecto de una hipótesis nula verdadera. Eso es un bocado, así que simplemente lo recuerdo como un falso positivo.

Bocado o no, estos errores estadísticos de tipo 1 son más comunes de lo que piensas. Se estima que alrededor del 80% de los resultados de las pruebas AB son imaginarios.

Haga clic para twittear

Si está tomando decisiones clave basadas en falsos positivos, en el mejor de los casos, está dejando la optimización al azar. En el peor de los casos, en realidad está empeorando la tasa de conversión de sus páginas de destino posteriores al clic.

Afortunadamente, existen algunas formas de combatir los datos venenosos. Uno de ellos es similar a un método de prueba con el que probablemente ya esté familiarizado ...

¿Qué son las pruebas A / A?

Las pruebas A / B implican dirigir el tráfico a dos páginas diferentes, una original (su control) y otra versión (su variación), para ver cuál funciona mejor.

Del mismo modo, las pruebas A / A implican dirigir el tráfico a dos páginas para ver cuál funciona mejor. Pero a diferencia de una prueba A / B, una prueba A / A enfrenta dos páginas idénticas entre sí, y en lugar de descubrir un impulso, su objetivo es no encontrar ninguna diferencia entre su control y variación.

¿Por qué harías una prueba A / A?

No lo culpamos por rascarse la cabeza y preguntarse "¿Qué diablos lograría probar dos páginas idénticas entre sí?"

Puede parecer una tontería, pero es una técnica que utilizan algunos probadores profesionales para probar su prueba A / B antes de realizar la prueba. (¿Eh?)

Los resultados precisos de las pruebas requieren más que significación estadística

Cualquiera puede ejecutar una prueba A / B, pero pocos pueden ejecutar una prueba A / B válida (recuerde: solo alrededor del 20% de los resultados de las pruebas son realmente legítimos).

Producir datos de prueba precisos implica más que alcanzar significación estadística con un tamaño de muestra grande y representativo. Para tener confianza en sus resultados, debe asegurarse de que la muestra no esté contaminada por una serie de amenazas de validez.

Una de esas amenazas, el efecto instrumento, es lo que las pruebas A / A son más útiles para combatir.

¿Qué es el efecto del instrumento?

La protección contra las amenazas de validez comienza incluso antes de comenzar las pruebas A / B. El efecto del instrumento, dice Peep Laja de CXL, es lo que envenena la mayoría de los resultados de las pruebas:

Este es el problema más común. Es cuando sucede algo con las herramientas (o instrumentos) de prueba que causan datos defectuosos en la prueba. A menudo se debe a una implementación de código incorrecta en el sitio web y sesgará todos los resultados.

Por eso, al configurar una prueba, es importante asegurarse de que sus herramientas estén configuradas correctamente y funcionen como deberían. Si no es así, pueden surgir estos problemas comunes:

- Información errónea de los indicadores clave de desempeño. Un solo error en una herramienta puede alterar sus datos, por lo que nunca debe confiar en una plataforma única para rastrear toda la información de su prueba. Como mínimo, integre con Google Analytics para verificar que las métricas que ve en su software de prueba y en el seguimiento del sitio web sean precisas. Para obtener mejores resultados, verifique tres veces con otra herramienta. Sospeche de cualquier informe que no coincida relativamente.

- problemas de visualización de la página de destino después del clic. Los pequeños errores de codificación pueden causar grandes amenazas de validez, como problemas de visualización, durante su prueba A / B. Por eso es crucial asegurarse de que sus páginas de destino posteriores al clic se vean como se supone que deben tener en todos los dispositivos y navegadores, y que sus visitantes no se vean afectados por algo llamado "efecto de parpadeo". Entre otros, un sitio web lento puede causar este problema, que ocurre cuando su control se muestra momentáneamente a su visitante justo antes de la variación.

- Detener una prueba demasiado pronto. Algunos programas de prueba declaran una página ganadora antes de tiempo, cuando el tamaño de la muestra no es lo suficientemente grande o representativo de su cliente objetivo. Recuerde: Alcanzar la significación estadística no significa que sea hora de detener la prueba. Cuanto más tiempo lo ejecute, más precisos serán sus resultados.

Cualquiera de estos problemas (y más) puede dar lugar a un falso positivo al final de la prueba, por lo que Peep advierte a los evaluadores que estén atentos:

Cuando configure una prueba, obsérvela como un halcón. Observe que se están registrando todos los objetivos y métricas que rastrea. Si alguna métrica no envía datos (por ejemplo, agregar al carrito, haga clic en los datos), detenga la prueba, busque y solucione el problema y comience de nuevo restableciendo los datos.

Pero no todo el mundo se siente cómodo al saltar inmediatamente a las pruebas A / B con ambos pies, especialmente cuando se utiliza un nuevo software. Por lo tanto, como precaución adicional, algunos profesionales realizan pruebas A / A para evaluar sus herramientas antes de comenzar las pruebas A / B.

Si su experimento está configurado correctamente, al final de una prueba A / A, ambas páginas deberían aparecer con una tasa de conversión similar. Sin embargo, como muestran los siguientes evaluadores, eso no siempre sucede.

Ejemplos de pruebas A / A

¿Son los falsos positivos realmente tan comunes? ¿Puede una página superar realmente a su clon? Estos chicos usaron pruebas A / A para averiguarlo y revelaron sus hallazgos en las siguientes publicaciones del blog ...

1. La prueba dividida de la página de inicio revela una deficiencia importante de las herramientas de prueba más populares

El 11 de noviembre de 2012, el equipo de Copyhackers comenzó una prueba dividida A / A en su página de inicio, que se muestra a continuación:

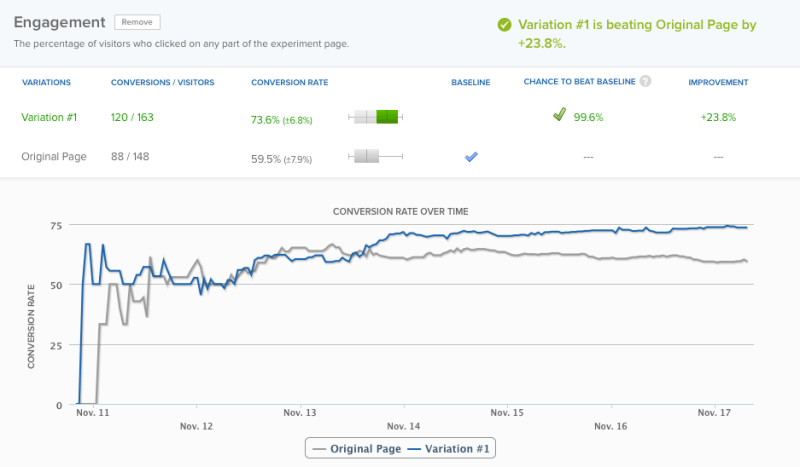

El día 18, 6 días después, su herramienta de prueba se declaró ganadora con un 95% de confianza. Sin embargo, en aras de la precisión, el equipo decidió dejar que la prueba se ejecutara un día más, momento en el que su software declaró un ganador con un nivel de confianza del 99,6%:

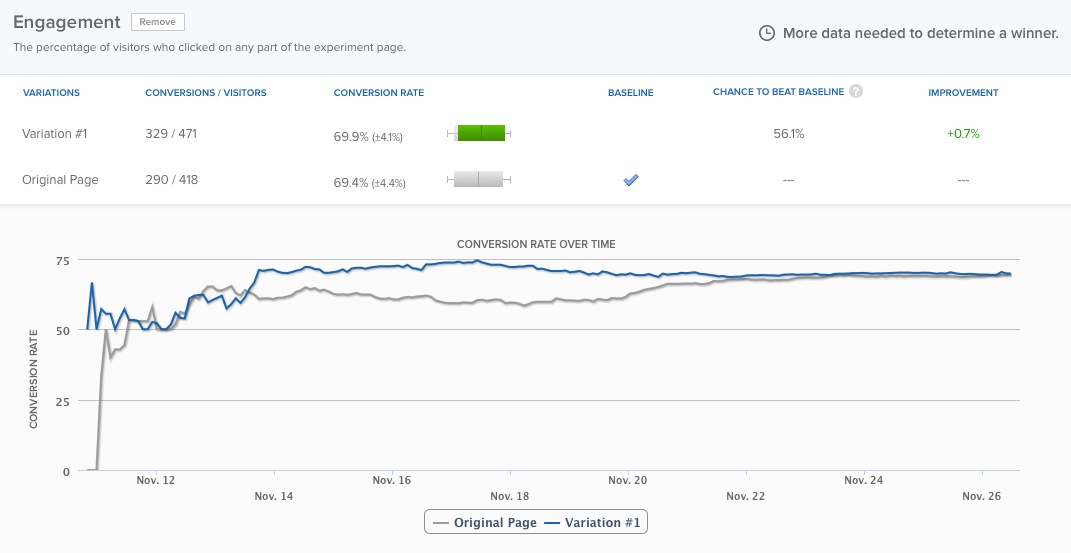

Su página de inicio tenía un rendimiento casi un 24% mejor que la misma página exacta , y solo había un 0,4% de probabilidad de que el resultado fuera un falso positivo, según el software. Aún así, el equipo dejó que la prueba se ejecutara durante unos tres días más, y las diferencias finalmente se nivelaron:

Pero ese no es el punto. El punto es: la herramienta de prueba declaró un ganador demasiado pronto. Si el equipo de Copyhackers no lo hubiera mantenido en funcionamiento, habrían asumido incorrectamente que había un problema con su experimento. Lea más sobre la prueba aquí.

2. Prueba A / A: cómo aumenté las conversiones en un 300% al no hacer absolutamente nada

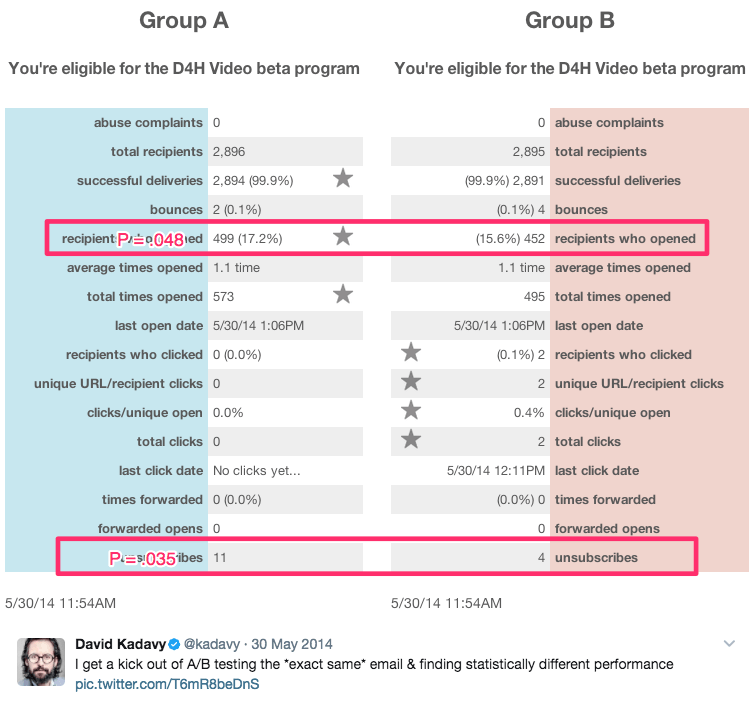

Este título sarcástico proviene del autor y autoproclamado "emprendedor en recuperación", David Kadavy, quien realizó una serie de pruebas A / A durante 8 meses con 750.000 suscriptores de correo electrónico. Durante ese tiempo, generó resultados estadísticamente significativos, como estos:

Entre esos resultados se encuentran:

- Se abre un aumento del 9% en el correo electrónico

- Un aumento del 300% en los clics.

- Una tasa de cancelación de suscripción un 51% más baja

Él dice:

Para muchos emprendedores deseosos (incluido mi antiguo yo), esto se ve como "¡vaya, aumentaste las aperturas en un 10%!" Incluso pueden ingresarlo en la calculadora de importancia del Optimizador de sitios web visual y ver que p = .048. "¡Es estadísticamente significativo!" ellos (o yo) podríamos exclamar.

Sin embargo, la verdad es que todas fueron pruebas A / A. El contenido probado entre sí fue idéntico. Vea más de sus resultados aquí.

¿Debería realizar pruebas A / A?

La respuesta a esta pregunta depende de a quién le pregunte.

Neil Patel, que siguió viendo grandes aumentos de conversión que no equivalen a más ingresos, dice: "Es realmente importante que ejecute una prueba A / A primero, ya que esto ayudará a garantizar que no pierda el tiempo con software inexacto".

Por otro lado, Peep Laja de CXL dice que las pruebas A / A en sí mismas son una pérdida de tiempo. Entonces, ¿quién tiene razón?

Los dos problemas principales con las pruebas A / A

Desde un punto de vista teórico, las pruebas A / A tienen mucho sentido. Por encima de todo, la precisión es lo más importante al ejecutar una prueba A / B, y probar su prueba es solo una de las muchas formas de garantizarla.

Sin embargo, en entornos de prueba del mundo real, las pruebas A / A tienen el potencial de hacer más daño que bien. Craig Sullivan explica:

Para mí, el problema siempre es consumir tráfico real y tiempo de prueba, al tener que precargar el tiempo de ejecución de la prueba con un período de prueba A / A. Si intento ejecutar 40 pruebas al mes, esto paralizará mi capacidad para publicar cosas. Prefiero tener medio día de pruebas de control de calidad en el experimento que ejecutar de 2 a 4 semanas de pruebas A / A para verificar que se alinee.

Ese es el problema uno. Las pruebas A / A cuestan tiempo real y tráfico que podría utilizar para obtener más información sobre los visitantes de su sitio web con las pruebas A / B.

El problema dos se ejemplifica en el estudio de caso de Copyhackers. Al igual que las pruebas A / B, las pruebas A / A deben diseñarse y monitorearse cuidadosamente, porque también son susceptibles a falsos positivos.

En otras palabras, su prueba A / A podría decirle que una página está funcionando mejor que la otra, cuando no lo es (esa probabilidad es mucho mayor de lo que cree, alrededor del 50%).

Si el equipo de Copyhackers hubiera escuchado su herramienta de prueba y hubiera declarado un ganador en solo seis días, habrían pasado aún más tiempo tratando de averiguar por qué su página de inicio estaba funcionando mejor que su gemela idéntica (cuando en realidad no lo era) .

El principal beneficio de las pruebas A / A

A pesar de estos problemas, las pruebas A / A tienen el potencial de ayudarlo a detectar problemas aún mayores durante las pruebas reales . Cuando los resultados de esas pruebas son aquellos en los que se basan las decisiones comerciales importantes, se trata de un poderoso beneficio a considerar.

Si decide realizar la prueba A / A, existe una forma potencialmente menos derrochadora de hacerlo, llamada prueba A / A / B.

Pruebas A / A / B frente a pruebas A / A

El método tradicional de prueba A / A desperdicia tráfico porque no le dice nada sobre sus visitantes al final. Pero, si agrega una variación "B" a esa prueba, podría hacerlo. Aquí está la diferencia entre los dos:

- Prueba A / A = 2 páginas idénticas probadas entre sí

- Prueba A / A / B = 2 páginas idénticas y una variación probada entre sí

Una prueba A / A / B divide su tráfico en tres segmentos, lo que significa que llevará más tiempo alcanzar la significación estadística. Pero la ventaja es que, una vez que lo haga, tendrá datos tanto sobre su herramienta de prueba como sobre sus visitantes.

Compare los resultados de A con A para determinar si puede confiar en su prueba. Si son estadísticamente similares, compare los resultados de A con B.Sin embargo, si no lo son, tendrá que descartar los resultados de toda la prueba (que tomó más tiempo que una prueba A / A tradicional en ejecutarse). ya que su tráfico está segmentado de tres maneras).

¿Los beneficios de las pruebas A / A superan los contras?

Algunos expertos dicen "sí", mientras que otros dicen "no". Andrew First de Leadplum parece pensar que la respuesta se encuentra en algún lugar entre:

Las pruebas A / A probablemente no deberían ser un asunto mensual, pero cuando está configurando una nueva herramienta, vale la pena tomarse el tiempo para probar sus datos. Si intercepta datos incorrectos ahora, tendrá más confianza en los resultados de sus pruebas meses después.

En última instancia, depende de ti. Si está utilizando una nueva herramienta, puede ser conveniente seguir el consejo de Andrew. Sin embargo, si no es así, probablemente sea mejor seguir el ejemplo de Craig Sullivan y, en su lugar, establecer un riguroso proceso de control de calidad previo a la prueba. Ahorre tiempo, recursos y tráfico para las pruebas A / B.

Aproveche al máximo sus esfuerzos de prueba y campañas publicitarias digitales, regístrese hoy para una demostración de Instapage Enterprise.