5 minacce comuni alla validità del tuo test A/B

Pubblicato: 2016-11-17Cattive notizie: quel 30% di conversione aumenta il tuo ultimo test A/B prodotto? Probabilmente non è così alto come pensavi.

In effetti, c'è la possibilità che non esista affatto.

"Almeno l'80% dei test vincenti sono completamente inutili", scrive il responsabile della ricerca Qubit, Martin Goodson, in un white paper aziendale. Quelli che di solito non portano piccoli ascensori sostenibili invece di quelli giganti che vedi pubblicizzati in tutto il web.

Allora perché il tuo software di test A/B ti dice diversamente?

Perché non è in grado di rilevare le numerose minacce invisibili alla validità che hanno il potenziale per avvelenare i tuoi dati. Concetti come l'effetto novità, la regressione alla media, l'effetto strumentazione e altri, possono farti vedere grandi aumenti di conversione dove non ce ne sono.

Quindi, se stai prendendo decisioni aziendali in base ai tuoi test A/B solo perché hanno raggiunto una significatività statistica, fermati ora. Devi raggiungere la significatività statistica prima di poter fare qualsiasi deduzione basata sui tuoi risultati, ma non è tutto ciò di cui hai bisogno. Devi anche eseguire un test valido.

Fai clic per twittare

La differenza tra significatività statistica e validità

La significatività statistica e la validità sono due necessità molto diverse ma ugualmente importanti per eseguire con successo split test.

La significatività statistica indica, con un certo grado di confidenza, la probabilità che i risultati del test siano affidabili e non dovuti al caso. Per raggiungere la significatività statistica è necessario conoscere:

- Il tasso di conversione di base della tua pagina di controllo

- La variazione minima del tasso di conversione che vuoi essere in grado di rilevare

- Quanto vuoi essere sicuro che i tuoi risultati siano significativi e non dovuti al caso (il livello di confidenza standard accettato è 95%)

- La tua dimensione del campione, ovvero quanto traffico devi generare prima di poter raggiungere la significatività statistica (usa questo calcolatore per capirlo)

La validità, d'altra parte, ha a che fare con il fatto che altri fattori al di fuori della dimensione del campione influiscano negativamente sui dati.

Allora perché hai bisogno di conoscerli entrambi?

Perché anche il 53% dei test A/A (stessa pagina contro stessa pagina test utilizzati per valutare l'impostazione del tuo esperimento) raggiungerà il 95% di significatività ad un certo punto. Se i test con due pagine identiche possono raggiungere la significatività statistica metà del tempo, come puoi essere sicuro che i risultati del tuo test A/B siano affidabili?

Non puoi, spiega Peep Laja di CXL:

“Se interrompi il test non appena vedi il significato, c'è una probabilità del 50% che sia un colpo di fortuna completo. Un lancio di moneta. Uccide totalmente l'idea di testare in primo luogo. "

Invece di fare affidamento esclusivamente sulla significatività statistica per determinare il vincitore di uno split test, è necessario raccogliere quanti più dati validi possibile. E per farlo, devi capire che tipo di minacce ti ostacolano.

Minacce comuni alla validità dei test A/B

1. Regressione verso la media

"La dimensione del campione è fondamentale quando si tratta di test A/B", afferma il marketer digitale Chase Dumont. Più persone sottoponi a test, più accurati diventano i tuoi risultati.

Troppo spesso, i tester A/B terminano i loro esperimenti in anticipo. Si emozionano quando vedono un grande sollevamento e dichiarano con sicurezza un vincitore. Tuttavia, i casi di studio hanno dimostrato che anche quando un test raggiunge una significatività statistica del 95% o superiore, anche quando è in esecuzione da un mese intero, i risultati possono essere fuorvianti.

Prendi ad esempio Chase, che ha testato due pagine di vendita di lunga durata per una delle sue attività. Nelle sue parole:

In un primo momento, la versione originale ha superato la variabile. Sono rimasto sorpreso da questo perché ho pensato che la variabile fosse migliore e più strettamente scritta e progettata.

In effetti, la variabile era migliore dell'originale, come aveva indicato l'istinto di Chase. Ma è stato solo dopo 6 mesi di test che ha mostrato. A quel punto, il tasso di conversione della pagina originale non solo era regredito verso la media, ma oltre, al punto da essere superato dalla variabile:

Quindi, cosa intendiamo per "regrediti alla media"?

In termini di test A/B, significa che la variazione ad alta conversione (in questo caso la pagina originale rappresentata dalla linea blu sul grafico) ha iniziato a funzionare più vicino alla media prevista man mano che sono stati raccolti più campioni. In termini ancora più semplici, è un altro modo per dire "le cose si uniformano nel tempo".

Considera un esempio dal mondo reale. Al Martini International Tournament del 1971, il golfista inglese John Anthony Hudson è diventato l'unica persona a colpire due buche consecutive in uno in un torneo professionale.

Su due buche, un par 4 e un par 3, ha tirato una combinazione di 2 — 5 colpi meglio della media di 7 che impiega la maggior parte dei professionisti.

Se guardassimo solo a queste due buche per confrontare le sue prestazioni con quelle degli altri partecipanti al torneo, diremmo “Wow, Hudson è molto meglio di tutti gli altri golfisti del torneo. Sicuramente vincerà".

E l'avrebbe fatto se avessero chiamato il torneo basandosi solo su quelle due buche.

Ma le buche in uno sono rare e i tornei durano molte buche. E quindi più Hudson giocava, più il suo punteggio è regredito alla media. Alla fine della competizione, era a pari merito per il nono posto, per nulla vicino alla vittoria.

Allo stesso modo, più dati raccogli anche dopo aver raggiunto la significatività statistica, più accurati saranno i tuoi risultati.

Potresti segnare due buchi in uno convertendo i primi due visitatori della tua variazione della pagina di destinazione post clic? Assolutamente. Ma questo significa che la tua nuova pagina verrà convertita al 100%? Non c'è modo. Ad un certo punto, quel tasso di conversione del 100% regredirà verso la media.

Ricorda che gli ascensori di conversione giganti, come i buchi in uno, sono rari. La maggior parte dei test di successo produrrà invece ascensori più piccoli e sostenibili.

2. L'effetto novità

Supponiamo che tu stia testando una variazione della pagina di destinazione post clic con un pulsante arancione più grande quando tutte le tue pagine di destinazione post clic finora ne hanno caratterizzato una piccola verde. Inizialmente, potresti scoprire che il pulsante arancione più grande produce più conversioni, ma il motivo potrebbe non essere il risultato del cambiamento e, invece, qualcosa chiamato "l'effetto novità".

L'effetto novità entra in gioco quando apporti un'alterazione che il tuo tipico visitatore non è abituato a vedere. La variazione del tasso di conversione è il risultato della modifica del colore del pulsante? O è perché sono attratti dalla novità del cambiamento? Un modo per capirlo è segmentare il traffico.

I visitatori di ritorno sono abituati a vedere il piccolo pulsante verde, quindi quello grande arancione potrebbe attirare più attenzione semplicemente perché è diverso da quello a cui sono abituati. Ma i nuovi visitatori non hanno mai visto il tuo piccolo pulsante verde, quindi se attira la loro attenzione, non sarà perché sono abituati a qualcosa di diverso. In questo caso, è più probabile che il pulsante arancione più grande attiri di più l'attenzione nel complesso.

Quando provi qualcosa di molto diverso da quello che il tuo pubblico è abituato a vedere, considera di indirizzare nuovo traffico verso di esso per assicurarti che l'effetto novità non influisca sui tuoi risultati.

3. L'effetto strumentazione

La minaccia più comune alla validità, chiamata "effetto strumentazione (o strumento)", ha a che fare con il tuo strumento di test. Funziona come dovrebbe? Tutto il tuo codice è implementato correttamente?

Non ci sono trucchi per sconfiggerlo al di fuori della vigilanza. Testa le tue campagne prima che vengano pubblicate esaminando le pagine di destinazione e gli annunci post clic su browser e dispositivi diversi. Inserisci i dati del test lead per assicurarti che i tuoi pixel di conversione si attivino e che il tuo CRM sia sincronizzato con il tuo modulo.

Quando vengono pubblicati, osserva attentamente ogni metrica e tieni d'occhio i rapporti sospetti. Il tuo strumento potrebbe non funzionare, potresti guidare traffico indesiderato o potresti essere vittima della prossima minaccia di validità...

4. L'effetto storia

Il tuo test A/B non viene somministrato in un laboratorio. Funziona nel mondo reale e, di conseguenza, è influenzato da eventi del mondo reale al di fuori del tuo controllo. Queste possono essere cose come festività, meteo, collasso del server e persino data e ora.

Cosa succede se stai testando il traffico da Twitter e il sito va offline? Cosa succede se si testa una pagina di destinazione post clic per la vendita al dettaglio che porta a Natale, quindi si esegue un test di follow-up a febbraio?

I tuoi dati saranno distorti.

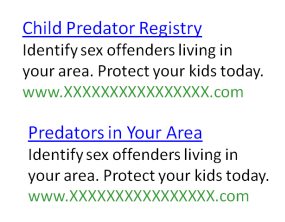

Prendi questo test da MarketingExperiments, ad esempio, che mirava a ottimizzare il clickthrough degli annunci sulle pagine dei risultati dei motori di ricerca. La destinazione era un sito Web del registro dei reati sessuali che avrebbe consentito ai visitatori di cercare i predatori nella loro zona.

In esso, quattro annunci con body copy identico ma titoli diversi sono stati testati l'uno contro l'altro.

Il test è stato chiamato dopo 7 giorni e 55.000 impression e, a prima vista, sembrava che il vincitore fosse chiaro. Ma, a un'ispezione più attenta, i tester hanno notato qualcosa che ha avvelenato i loro dati. Il dottor Flint McGlaughlin elabora:

“Ecco il problema. Durante il test, Dateline ha mandato in onda uno speciale intitolato "To Catch a Predator". È stato visto da 10 milioni di persone. Le parole predatore sono diventate il termine chiave associato al molestatore sessuale. Ora, torniamo indietro.

Vedi, tuo figlio è al sicuro. Vedi trovare predatori di bambini, predatori nella tua zona e registro di predatori di bambini. E poi, guarda nella copia. Identificare gli autori di reati sessuali, identificare gli autori di reati sessuali. Lo stesso, tranne il titolo, ma abbiamo tre di questi titoli con la parola predatore. Qual'era il risultato?"

I titoli con la parola "predatore" avevano una percentuale di clic del 133% superiore rispetto a quelli senza, tutto a causa di uno speciale televisivo.

Per combattere l'effetto della cronologia, usa uno strumento di monitoraggio dei media e assicurati che tutti nella tua azienda sappiano che stai testando. Più membri del team hai attinto al mondo esterno, più è probabile che uno di voi individui qualcosa che potrebbe influire sui risultati del test.

5. L'effetto di selezione

L'effetto di selezione si verifica quando uno sperimentatore mette alla prova un campione di soggetti che non è rappresentativo del pubblico di destinazione.

Ad esempio, diciamo che volevamo capire quale squadra di calcio professionistica fosse la più popolare negli Stati Uniti, ma abbiamo chiesto solo a persone della zona del New England. Probabilmente sentiremmo un sostegno schiacciante per i Patriots, che non sarebbe rappresentativo dell'intero paese.

In termini di test A/B, l'effetto di selezione può avere un impatto sul tuo test quando generi traffico da fonti diverse. È qualcosa in cui si è imbattuto Nick Usborne di MarketingExperiments quando lavorava con un importante editore di notizie:

“Avevamo radicalmente ridisegnato il loro processo di offerta di abbonamento per la versione elettronica ed eravamo nel bel mezzo dei test quando hanno lanciato una nuova campagna pubblicitaria con link di testo dal loro sito web principale al prodotto elettronico.

Ciò ha cambiato il mix di traffico in arrivo al processo di offerta di abbonamento da uno in cui praticamente tutto il traffico proveniva da motori di ricerca a pagamento a uno in cui molto traffico proveniva da un collegamento interno al loro sito Web (traffico altamente prequalificato).

Il tasso di conversione medio è aumentato durante la notte dallo 0,26% a oltre il 2%. Se non avessimo monitorato da vicino, avremmo potuto concludere che il nuovo processo aveva raggiunto un aumento del tasso di conversione del 600% o più".

Tenere d'occhio i tuoi clienti è importante, ma è altrettanto cruciale assicurarti di progettare il tuo test in un modo che non lo renda vulnerabile all'effetto della selezione. Scopri da dove proviene il tuo traffico e non alterare le fonti nel bel mezzo di un test. Il tuo campione dovrebbe rimanere il più coerente possibile per tutto il tempo.

Quando puoi terminare in sicurezza un test A/B?

Se non puoi fidarti della significatività statistica e tutte queste minacce alla validità possono potenzialmente avvelenare i tuoi dati, allora... quando puoi terminare in sicurezza il tuo test e fare affidamento con sicurezza sui risultati?

La sfortunata risposta è che non puoi mai essere veramente sicuro che i tuoi risultati siano affidabili al 100%. Tuttavia, puoi prendere precauzioni per assicurarti di avvicinarti il più possibile. Lo Strumento per ottimizzare il tasso di conversione, Peep Laja, rileva che seguire questi 4 criteri di solito funziona:

- La durata del test dovrebbe essere di minimo 3 settimane, 4 se possibile.

- La dimensione del campione deve essere calcolata in anticipo, utilizzando più strumenti.

- Le conversioni dovrebbero raggiungere tra 250 e 400 per ogni variante che stai testando.

- La significatività statistica dovrebbe essere minima del 95%.

Continua aggiungendo che, se non raggiungi 250-400 conversioni in 3 settimane, dovresti continuare a eseguire il test fino a quando non lo fai. E se necessario, assicurati di eseguire il test a cicli di una settimana intera. Se inizi il test di lunedì e raggiungi 400 conversioni 5 settimane dopo di mercoledì, continua il test fino al lunedì successivo (altrimenti, potresti ritrovarti vittima dell'effetto cronologia).

Non dimenticare di fare attenzione alle minacce alla validità di cui sopra e fai sapere a tutti i membri del tuo team (e al team del tuo cliente) che stai testando. Più informazioni sulla tua organizzazione, meno è probabile che qualcuno alteri un aspetto del test (effetto di selezione) e più è probabile che qualcuno si accorga quando entra in gioco una minaccia alla validità come l'effetto della strumentazione o l'effetto della cronologia.

Come hai migliorato il tuo sito web con i test A/B?

Utilizza i test A/B per ottimizzare il tuo sito Web e rilevare eventuali minacce alla validità. Inizia creando pagine post clic, richiedi oggi stesso una demo di Instapage Enterprise.