TechSEO360 Crawler Guide – Sitemaps und technische SEO-Audits

Veröffentlicht: 2019-05-21Der Crawler, den ich seit 10 Jahren für die technischen SEO-Website-Audits verwende, die ich bei Search Engine People durchführe, heißt heute TechSEO360. Ein verstecktes Juwel; kostengünstig, effizient (crawlt jede Website jeder Größe), zukunftsorientiert (z. B.: hatte AJAX-Unterstützung, bevor andere solche Crawler-Tools dies taten). Ich habe schon früher über diesen Website-Crawler geschrieben, wollte aber einen umfassenderen All-in-One-Beitrag schreiben.

TechSEO360 erklärt

TechSEO360 ist ein technischer SEO-Crawler mit folgenden Highlights:

- Native Software für Windows und Mac.

- Kann sehr große Websites standardmäßig crawlen.

- Flexible Crawler-Konfiguration für diejenigen, die es brauchen.

- Verwenden Sie integrierte oder benutzerdefinierte Berichte zur Analyse der gesammelten Website-Daten (obwohl ich mich normalerweise darauf verlasse, alle Daten nach Excel zu exportieren und dessen leistungsstarke Filter, Pivotierung, automatische Formatierung usw. zu verwenden).

- Erstellen Sie Bild-, Video- und hreflang-XML-Sitemaps zusätzlich zu visuellen Sitemaps.

Wie dieser Leitfaden aufgebaut ist

Dieser Leitfaden behandelt alle wichtigen SEO-Funktionen dieser Software.

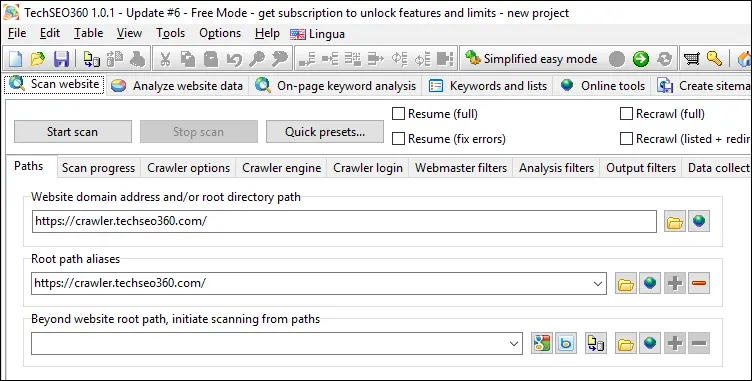

- Wir werden die Demo-Website https://Crawler.TechSEO360.com verwenden in allen unseren Beispielen.

- Alle Screenshots stammen von der Windows-Version – aber die Mac-Version enthält dieselben Funktionen und Tools.

- Wir werden TechSEO360 im kostenlosen Modus verwenden, das ist der Zustand, in den gewechselt wird, wenn die erste voll funktionsfähige kostenlose 30-Testversion endet.

- Sofern nicht anders angegeben, verwenden wir Standardeinstellungen für Website-Crawling und -Analyse.

- Wir beginnen mit der Konfiguration des Site-Crawls und gehen dann zu technischem SEO, Berichten und Sitemaps über.

Konfigurieren und Starten des Crawls

Die meisten Websites werden problemlos gecrawlt, wenn Sie die Standardeinstellungen verwenden. Das bedeutet, dass die einzige erforderliche Konfiguration in der Regel darin besteht, den Pfad der Website einzugeben, die Sie analysieren möchten – unabhängig davon, ob sie sich im Internet, auf einem lokalen Server oder auf einer lokalen Festplatte befindet.

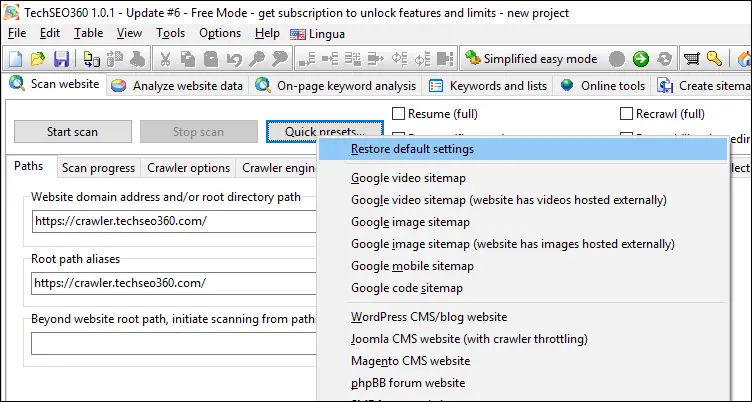

Als einfache Alternative zur manuellen Konfiguration ist es auch möglich, verschiedene „Schnellvoreinstellungen“ anzuwenden, die die zugrunde liegenden Einstellungen konfigurieren. Beispiele könnten sein:

- Sie wissen, dass Sie eine Video-Sitemap erstellen und sicherstellen möchten, dass Sie die bestmögliche erstellen können.

- Sie verwenden ein bestimmtes Website-CMS, das viele Thin-Content-URLs generiert, die ausgeschlossen werden sollten.

Für diejenigen, die in die Einstellungen eintauchen möchten, können Sie eine nahezu vollständige Kontrolle über den Crawling-Prozess geltend machen, einschließlich:

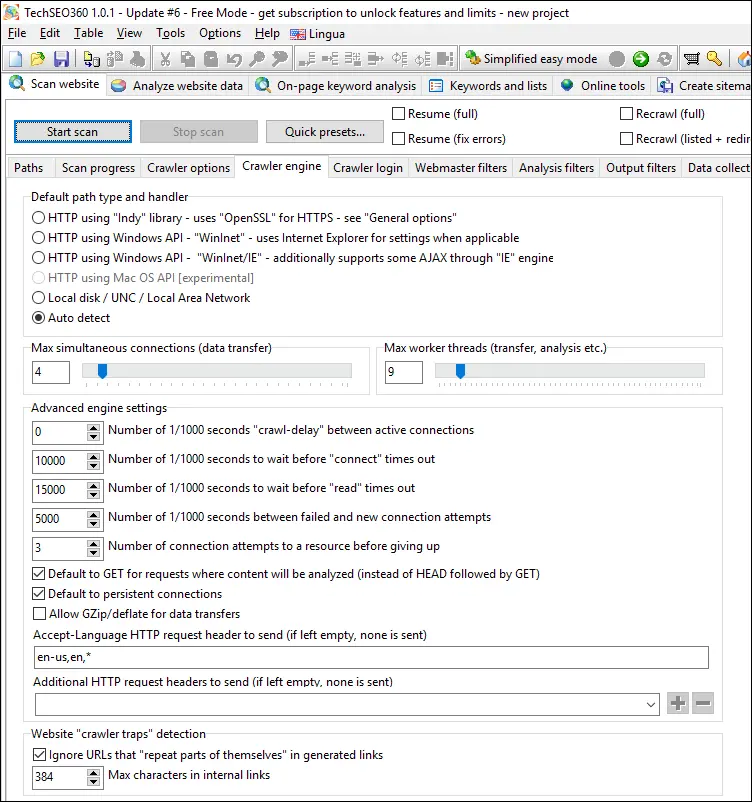

Crawler-Motor

Hier können Sie mit den tieferen Interna herumspielen, wie HTTP-Anforderungen ausgeführt werden. Eine besondere Sache ist, wie Sie die Crawling-Geschwindigkeit erhöhen können: Erhöhen Sie einfach die Anzahl der gleichzeitigen Threads und gleichzeitigen Verbindungen - stellen Sie nur sicher, dass Ihr Computer und Ihre Website die zusätzliche Last bewältigen können.

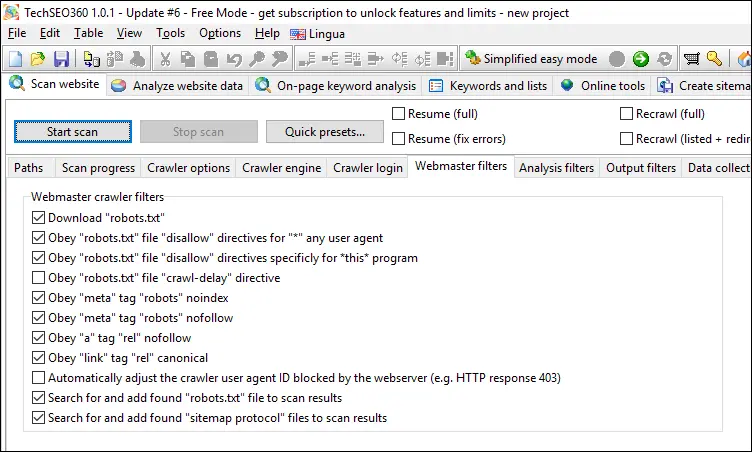

Webmaster-Filter

Steuern Sie, inwieweit der Crawler noindex, nofollow, robots.txt und ähnliches befolgen soll.

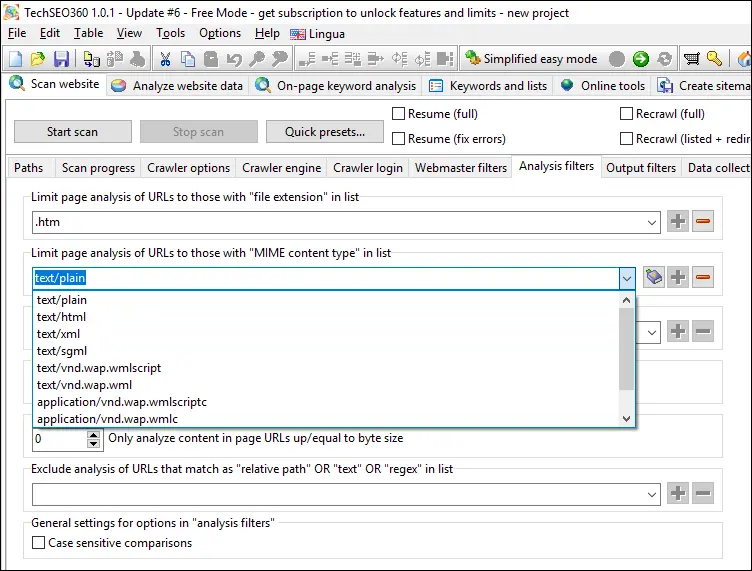

Analysefilter

Konfigurieren Sie Regeln, nach denen der Inhalt von URLs analysiert werden soll. Es stehen mehrere Filteroptionen zum „Ausschließen“ und „Einschränken auf“ zur Verfügung, darunter URL-Muster, Dateierweiterungen und MIME-Typen.

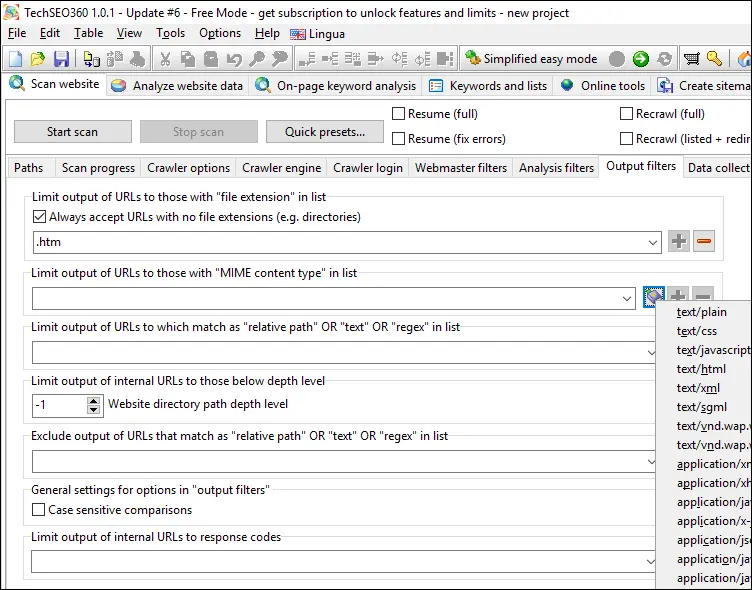

Ausgangsfilter

Ähnlich wie „Website scannen | Analysefilter“ – wird aber stattdessen verwendet, um zu steuern, welche URLs zum Entfernen „getaggt“ werden, wenn ein Website-Crawling abgeschlossen ist.

URLs, die von den Optionen „Website scannen | Webmaster-Filter“ und „Website scannen | Ausgabefilter“ ausgeschlossen wurden, können weiterhin beibehalten und angezeigt werden, nachdem das Website-Crawling beendet wurde, wenn die Option „Website scannen | Crawler-Optionen | Webmaster- und Ausgabefilter nach Website-Scan anwenden“ aktiviert ist stoppt" ist deaktiviert. Mit dieser Kombination:

- Bewahren Sie alle vom Crawler gesammelten Informationen auf, damit Sie alles überprüfen können.

- Vermeiden Sie dennoch, dass die URLs beim Erstellen von HTML- und XML-Sitemaps eingeschlossen werden.

- Erhalten Sie immer noch das richtige "Tagging" für Berichte und Exporte.

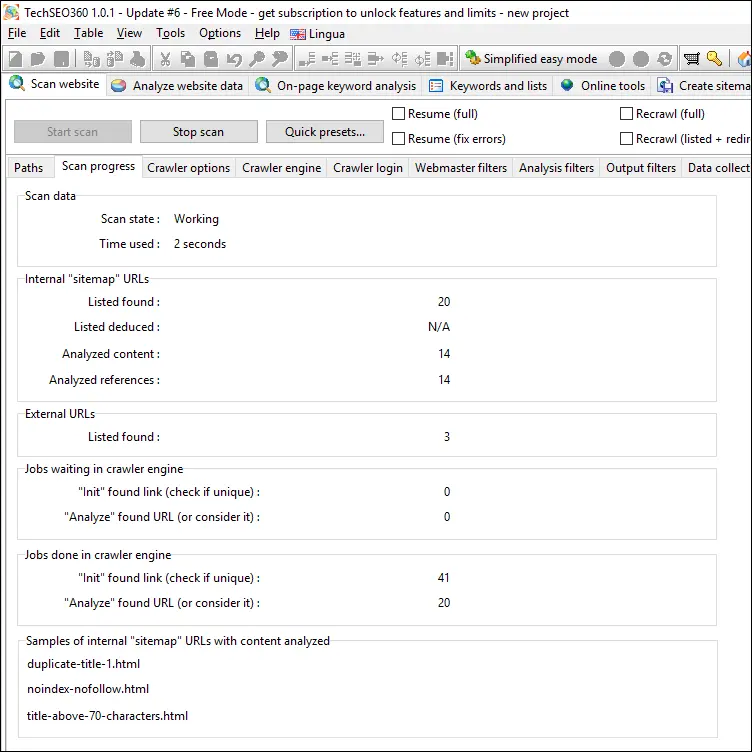

Crawling-Fortschritt

Während des Website-Crawls sehen Sie verschiedene Statistiken, die zeigen, wie viele URLs inhaltlich analysiert wurden, bei wie vielen Links und Verweisen aufgelöst wurden und wie viele URLs noch in Warteschlangen warten.

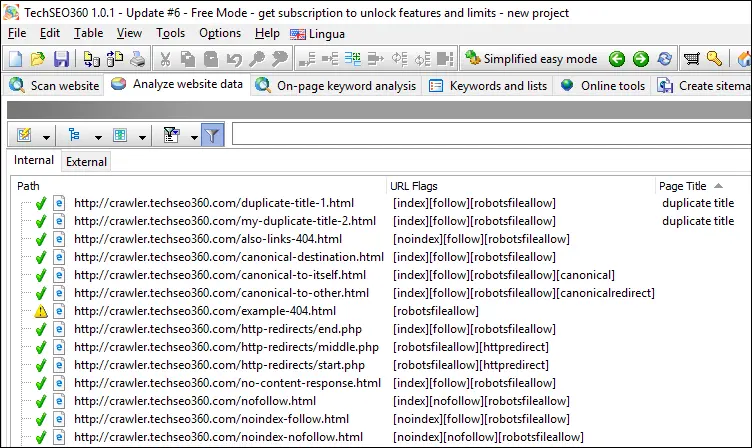

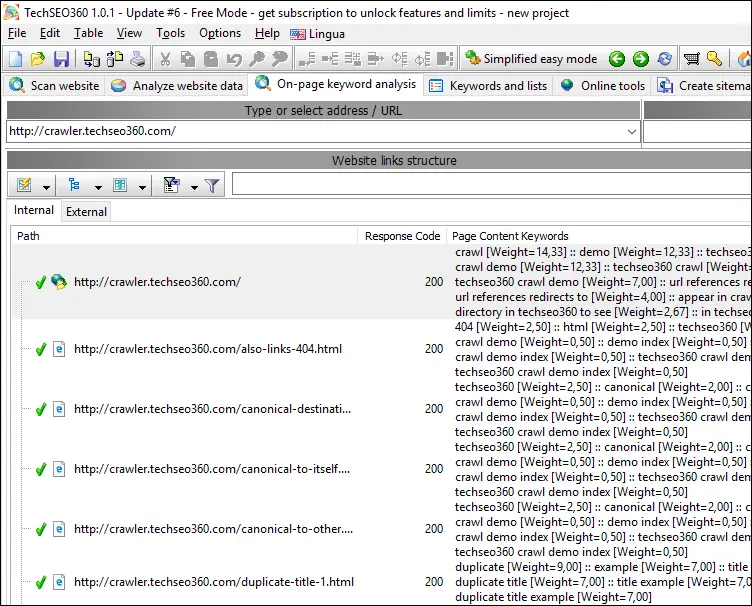

Website-Übersicht nach dem Crawl

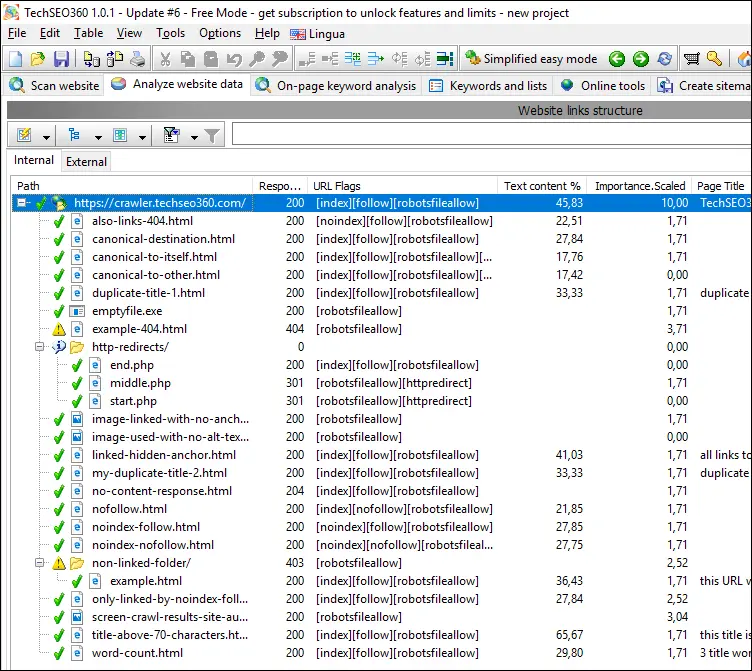

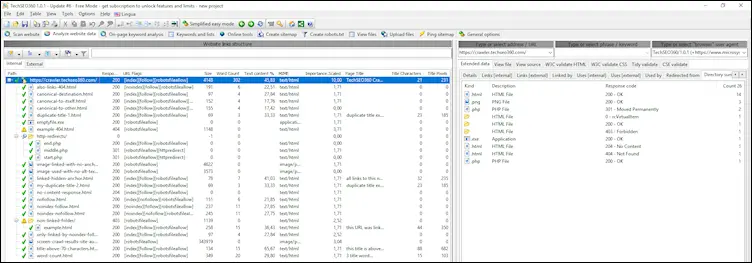

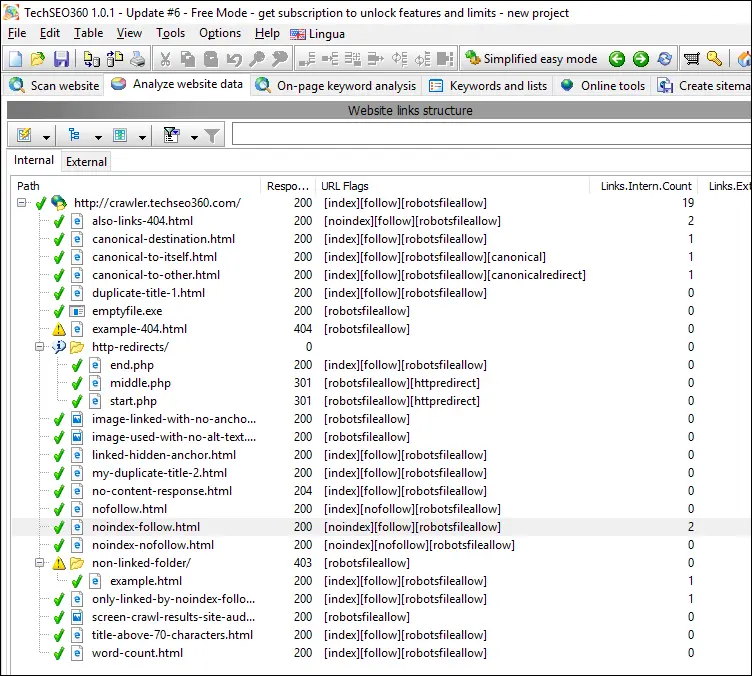

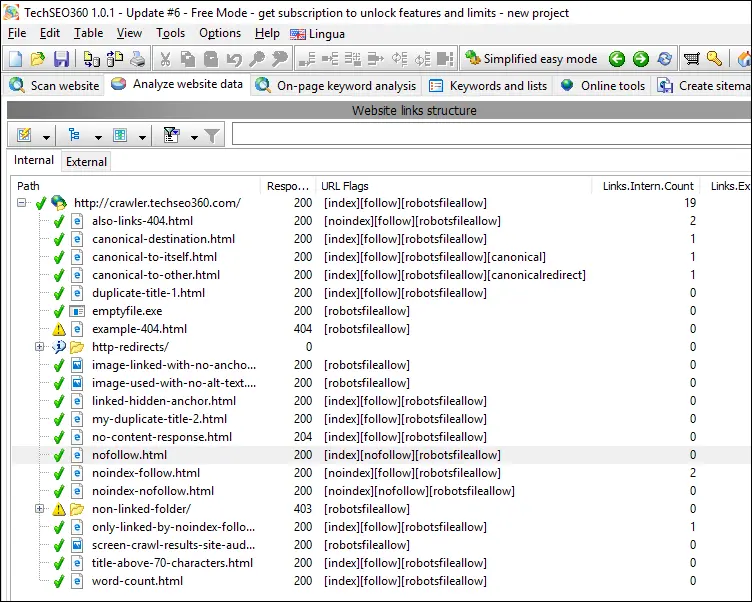

Nachdem ein Site-Crawl beendet ist, öffnet das Programm eine Ansicht mit Datenspalten auf der linken Seite:

Wenn Sie eine URL auswählen, können Sie rechts weitere Details anzeigen:

Hier ist ein Miniaturbild, wie es auf einem Bildschirm in voller Größe aussehen kann:

Linke Seite

Hier finden Sie URLs und zugehörige Daten, die beim Website-Scan gefunden wurden. Standardmäßig werden nur einige der wichtigsten Datenspalten angezeigt. Darüber befindet sich ein Panel bestehend aus fünf Schaltflächen und einem Textfeld. Ihre Zwecke sind:

#1

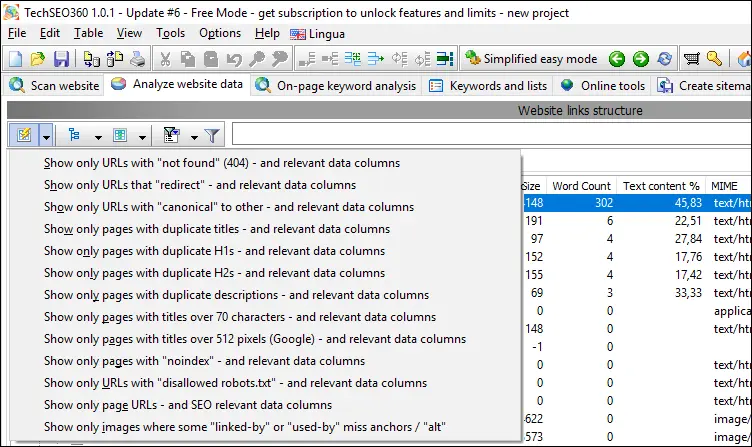

Dropdown mit vordefinierten "Schnellberichten". Diese können zur schnellen Konfiguration verwendet werden:

- Welche Datenspalten sichtbar sind.

- Welche "Schnellfilteroptionen" aktiviert sind.

- Der aktive "Schnellfiltertext", um die Anzeige weiter einzuschränken.

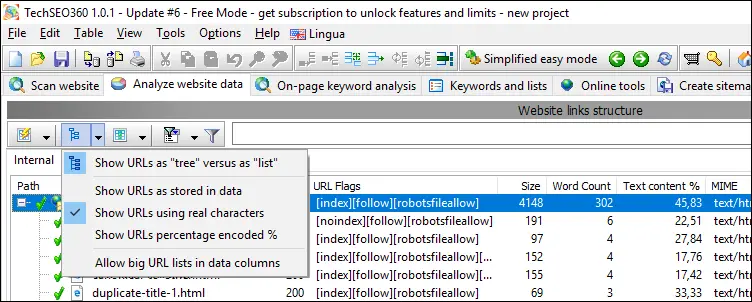

#2

Dropdown, um zwischen der Anzeige aller URLs auf der Website als flache "Liste" oder als "Baum" umzuschalten.

#3

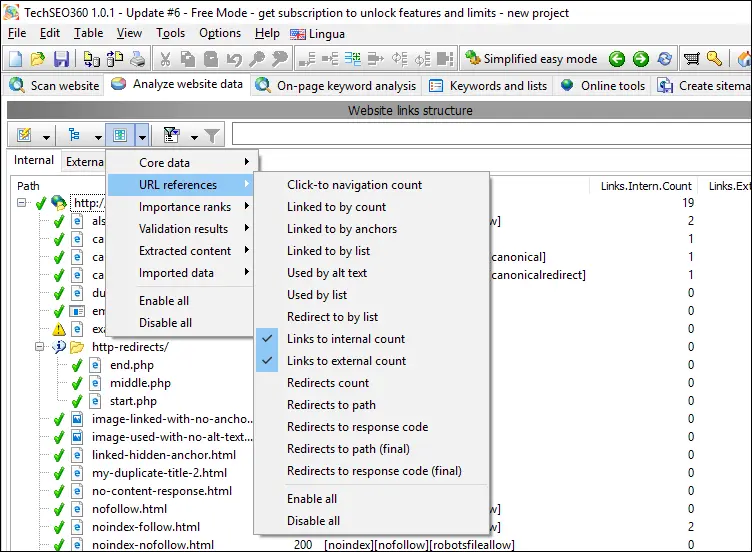

Dropdown, um zu konfigurieren, welche Datenspalten sichtbar sind.

#4

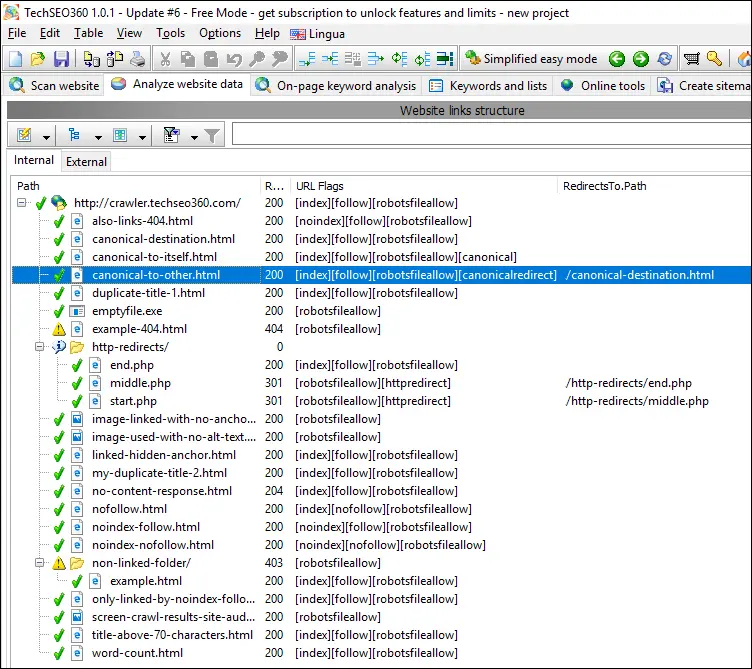

Im Vergleich zu oben sieht die Aktivierung der Sichtbarkeit der Datenspalte „Umleitungen auf Pfad“ folgendermaßen aus:

#5

Dropdown, um zu konfigurieren, welche "Schnellfilteroptionen" ausgewählt werden.

#6

Ein/Aus-Taste zum Aktivieren/Deaktivieren aller "Schnellfilter"-Funktionen.

#7

Feld mit dem "Schnellfiltertext", der verwendet wird, um die Anzeige weiter anzupassen.

Die Verwendung der Funktionen „Schnellberichte“ und „Schnellfilter“ wird später anhand von Beispielen erläutert.

Rechte Seite

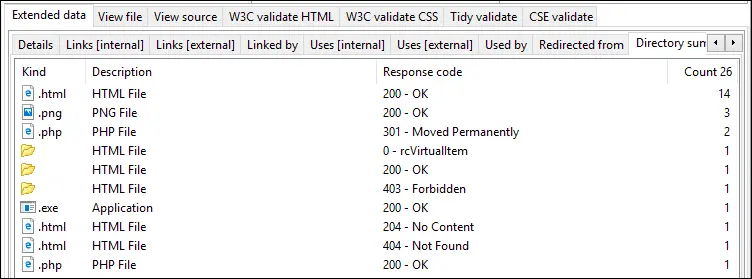

Hier sehen Sie auf der linken Seite weitere Details der ausgewählten URL. Dazu gehören die Liste „Verlinkt von“ mit zusätzlichen Details, die Liste „Links [intern]“, die Liste „Verwendet von“, „Verzeichniszusammenfassung“ und mehr.

Vergleichen Sie die folgenden zwei Szenarien, um zu verstehen, wie Sie dies bei der Untersuchung von Details verwenden.

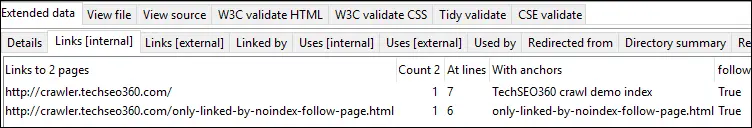

#1

Auf der linken Seite haben wir die URL http://crawler.techseo360.com/noindex-follow.html ausgewählt - wir können auch sehen, dass der Crawler sie mit "[noindex][follow]" in der Datenspalte "URL-Flags" gekennzeichnet hat:

Rechts in der Registerkarte "Links [intern]" können wir bestätigen, dass alle Links gefolgt wurden, einschließlich zusätzlicher Details .

#2

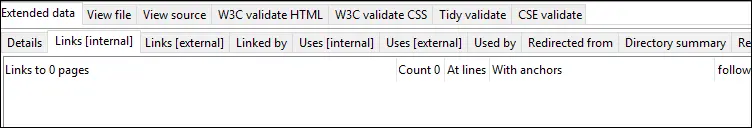

Auf der linken Seite haben wir die URL http://crawler.techseo360.com/nofollow.html ausgewählt - wir können auch sehen, dass der Crawler sie mit "[index][nofollow]" in der Datenspalte "URL-Flags" gekennzeichnet hat:

Rechts im Tab „Links [intern]“ können wir bestätigen, dass keine Links verfolgt wurden.

Verwenden von Schnellberichten

Wie gesagt, ich verwende diese nicht oft, sondern ziehe es vor, alle Datenspalten anzuzeigen und dann nach Excel zu exportieren. Aber für diejenigen, die diese Art von integrierten Berichten in anderen Tools mögen, sind hier einige der am häufigsten verwendeten Schnellberichte verfügbar:

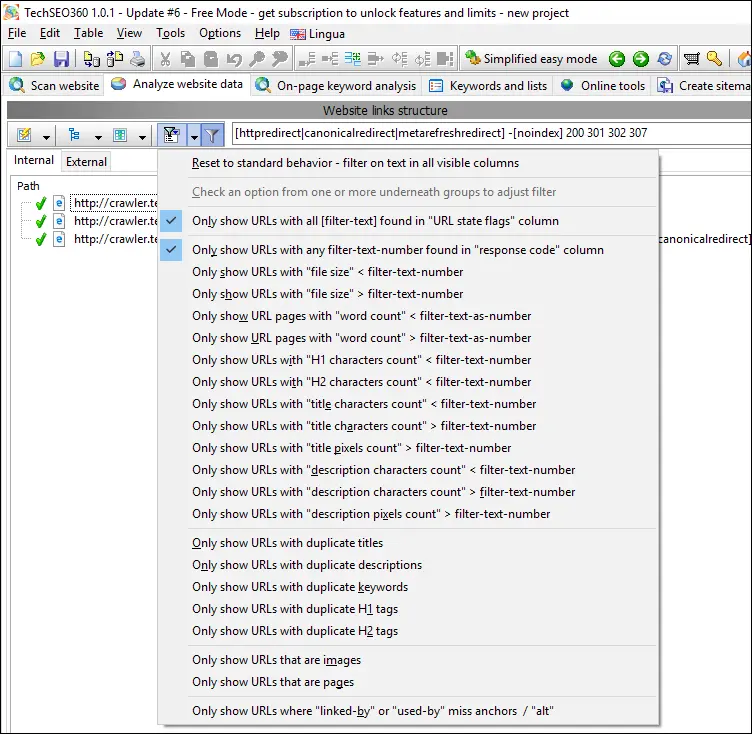

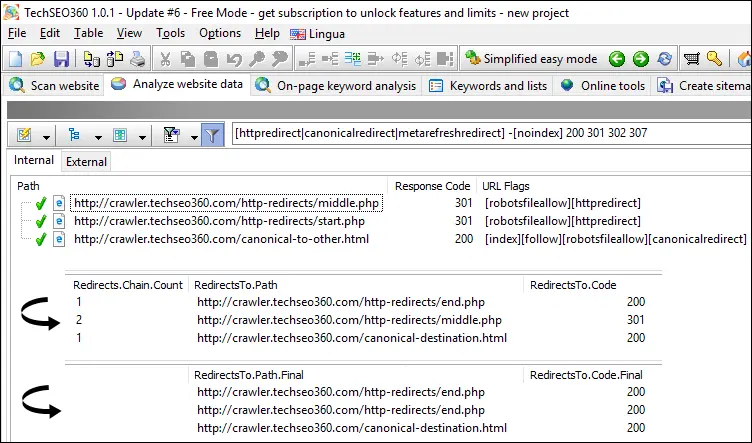

Alle Arten von Weiterleitungen

Der eingebaute "Schnellbericht", um alle Arten von Weiterleitungen anzuzeigen, einschließlich der Informationen, die zum Verfolgen von Weiterleitungsketten erforderlich sind:

Das hat im Wesentlichen:

- Die Sichtbarkeit von Datenspalten wurde auf die am besten geeigneten geändert.

- Setzen Sie den Filtertext auf:

[httpredirect|canonicalredirect|metarefreshredirect] -[noindex] 200 301 302 307 - Aktivierte Filter:

-

Only show URLs with all [filter-text] found in "URL state flags" column -

Only show URLs with any filter-text-number found in "response code" column

-

Dabei muss eine URL die folgenden drei Bedingungen erfüllen, um angezeigt zu werden:

- Muss entweder durch HTTP-Umleitung, kanonische Anweisung oder „0 Sekunden“-Metaaktualisierung auf eine andere URL verweisen.

- Darf keine "noindex"-Anweisung enthalten.

- Muss entweder den Antwortcode 200, 301, 302 oder 307 haben.

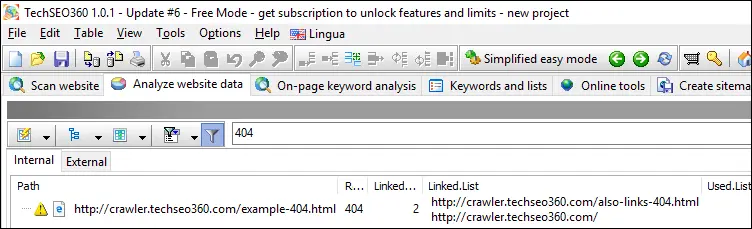

404 Nicht gefunden

Wenn Sie defekte Links und URL-Verweise schnell identifizieren müssen, ist dieser Bericht eine gute Wahl. Damit werden die Datenspalten „Linked.List“ (zB „a“-Tag), „Used.List“ (zB „src“-Attribut) und „Redirected.List“ sichtbar gemacht.

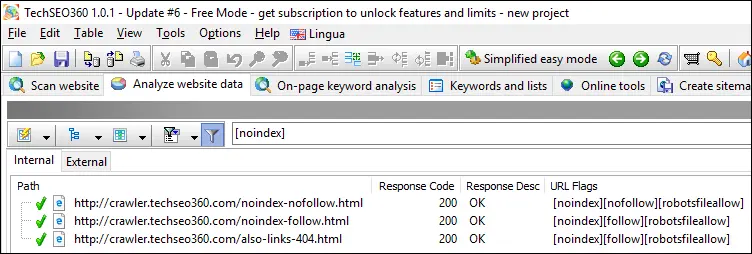

Kein Index

Zeigen Sie schnell alle Seiten mit der Anweisung "noindex" an.

Doppelte Titel #1

Sehen Sie schnell alle Seiten mit doppelten Titeln, einschließlich derer mit doppelten leeren Titeln.

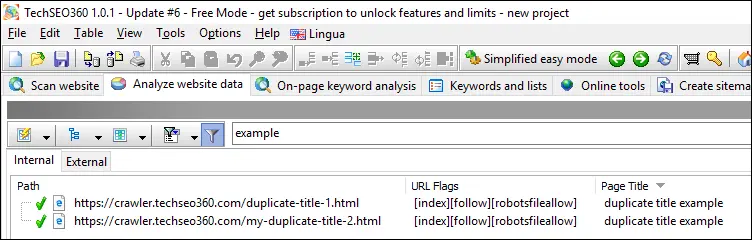

Doppelte Titel #2

Wenn nicht durch andere Filter überschrieben, filtern Sie Textübereinstimmungen mit Inhalten in allen sichtbaren Datenspalten. Hier haben wir unseren Bericht über doppelte Titel auf diejenigen eingegrenzt, die das Wort „Beispiel“ enthalten.

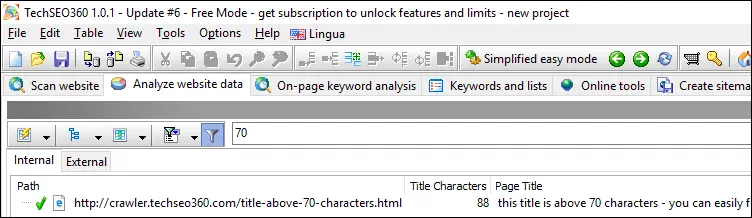

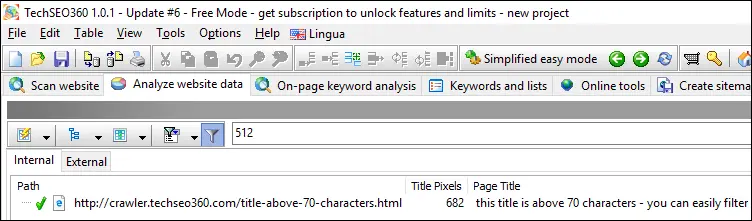

Anzahl der Titelzeichen

Beschränken Sie die URLs, die durch die Anzahl der Titelzeichen angezeigt werden. Sie können den Schwellenwert und ob darüber oder darunter steuern. Ähnliches steht für Beschreibungen zur Verfügung.

Anzahl der Titelpixel

Beschränken Sie die URLs, die durch die Anzahl der Titelpixel angezeigt werden. Sie können den Schwellenwert und ob darüber oder darunter steuern. Ähnliches steht für Beschreibungen zur Verfügung.

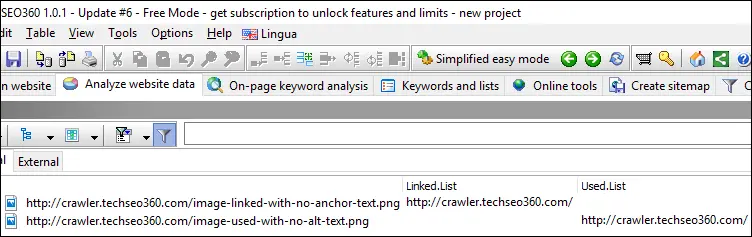

Bilder und fehlender Alt-/Ankertext

Nur Bild-URLs anzeigen, die entweder ohne Alternativtext verwendet oder ohne Ankertext verlinkt wurden.

Andere Werkzeuge

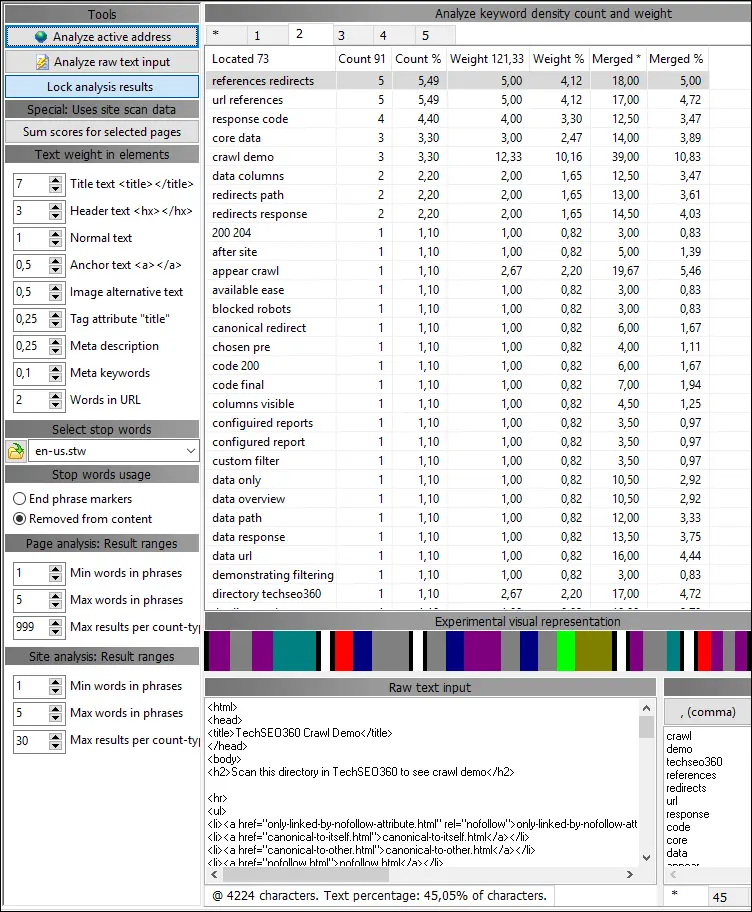

Onpage-Analyse

Standardmäßig wird beim Website-Crawl auf allen Seiten eine umfassende Textanalyse durchgeführt. Die dafür gefundene Option befindet sich in "Website scannen | Datenerfassung", die Ergebnisse wie diese liefert:

Sie können aber auch immer einzelne Seiten analysieren, ohne die gesamte Website zu crawlen:

Beachten Sie, dass Sie sehen können, auf welche Keywords und Phrasen auf einer gesamten Website abgezielt wird, wenn Sie die Schaltfläche „Ergebnisse für ausgewählte Seiten zusammenfassen“ verwenden.

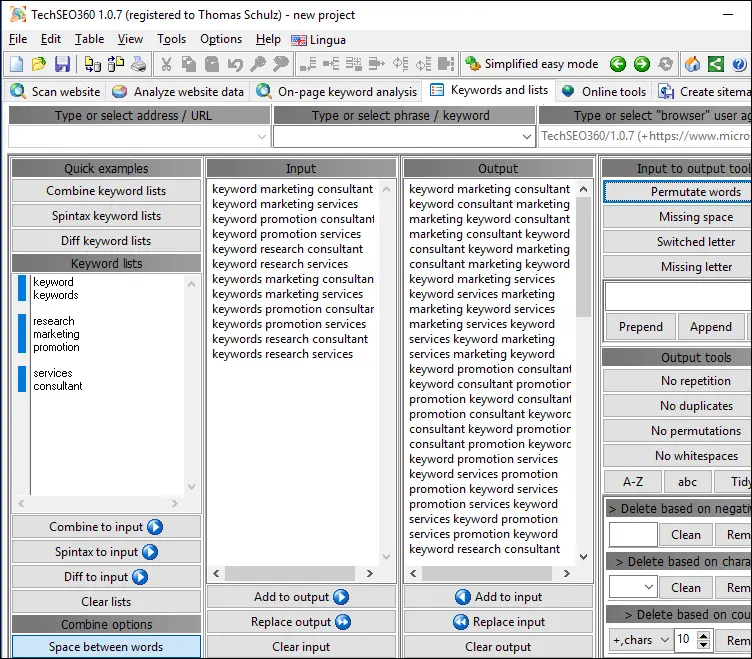

Stichwortlisten

Ein flexibler Keyword-Listen-Builder, der es ermöglicht, Keyword-Listen zu kombinieren und eine umfassende Bereinigung durchzuführen.

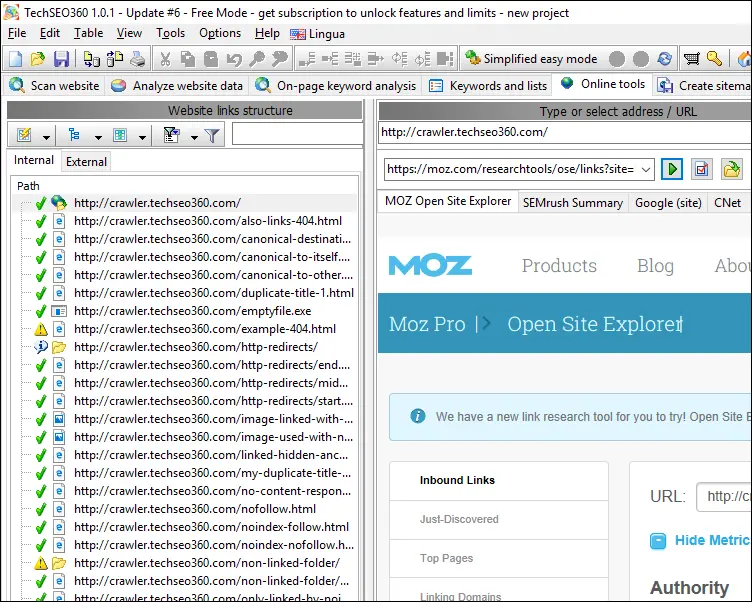

Online-Tools von Drittanbietern

Wenn Sie weitere Tools benötigen, können Sie diese selbst hinzufügen und sogar entscheiden, welche über Registerkarten statt nur über das Dropdown-Menü zugänglich sein sollen.

Die Software leitet automatisch die gewählte URL o.ä. an das gewählte Online-Tool weiter. Jedes Online-Tool wird durch eine Textdatei konfiguriert, die definiert, welche Daten übergeben werden und wie dies geschieht.

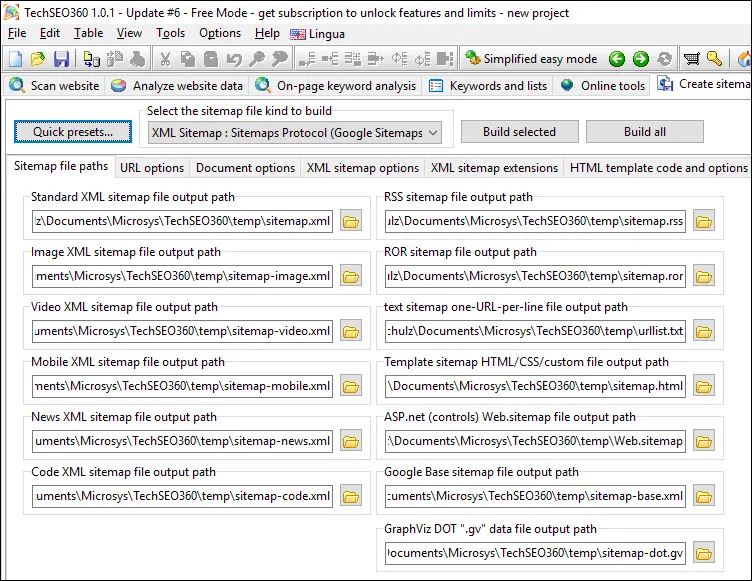

Sitemaps

Sitemap-Dateitypen

Mit 13 unterschiedlichen Sitemap-Dateiformaten werden Ihre Anforderungen wahrscheinlich abgedeckt. Dazu gehören XML-Sitemaps, Video-Sitemaps und Bilder-Sitemaps.

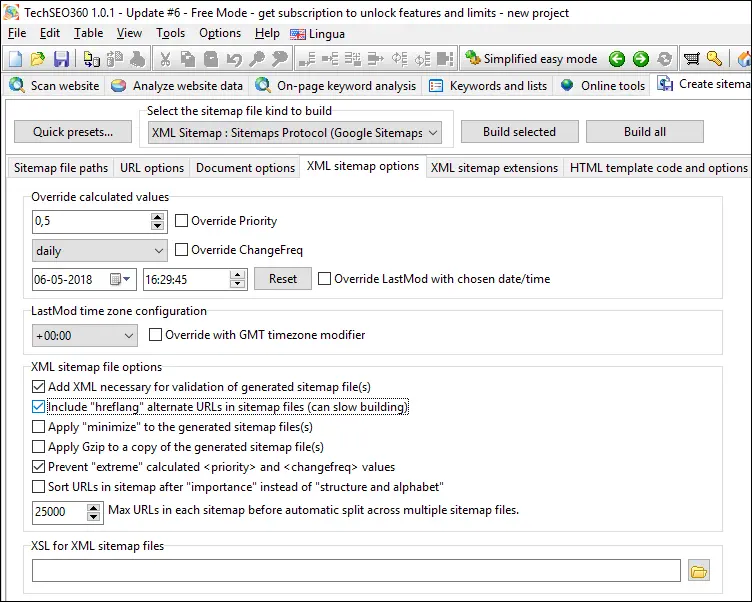

XML-Sitemaps und Hreflang

Selbst wenn Ihre Website kein Hreflang-Markup enthält, kann TechSEO360 häufig XML-Sitemaps mit geeigneten alternativen Hreflang-Informationen generieren, wenn Ihre URLs Teile enthalten, die einen Verweis auf die Sprachkultur oder das Land enthalten.

XML-Bild- und Video-Sitemaps

Sie können Ihre Konfiguration normalerweise beschleunigen, indem Sie eine der "Quick-Voreinstellungen" verwenden:

- Google Video-Sitemap

- Google Video-Sitemap (Website hat extern gehostete Videos)

- Google Bilder-Sitemap

- Google-Bilder-Sitemap (Website hat Bilder, die extern gehostet werden)

Wenn Sie beabsichtigen, sowohl Bilder- als auch Video-Sitemaps zu erstellen, verwenden Sie eine der Video-Optionen, da sie auch die gesamte Konfiguration enthalten, die für Bild-Sitemaps optimal ist.

TechSEO360 verwendet verschiedene Methoden, um zu berechnen, welche Seiten, Videos und Bilder in generierten XML-Sitemaps zusammengehören – etwas, das schwierig sein kann, wenn ein Bild oder Video an mehreren Stellen verwendet wird.

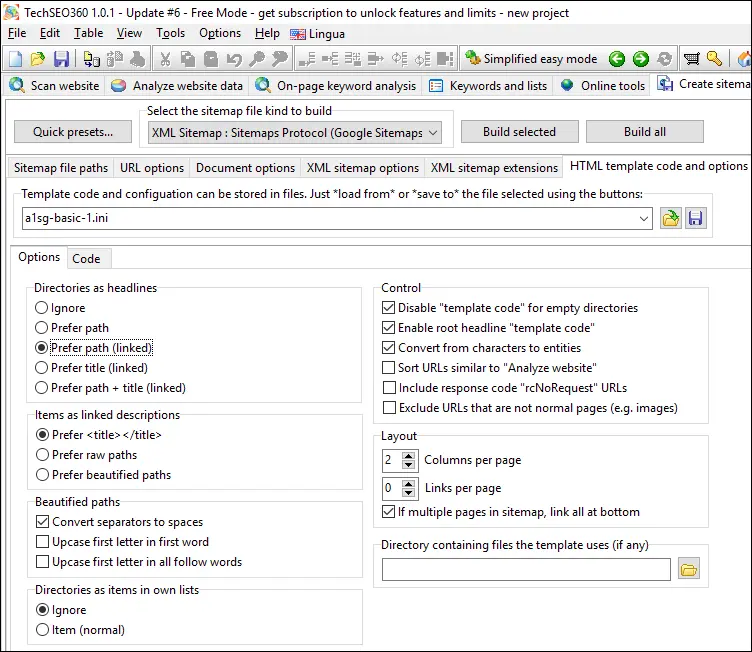

HTML-Sitemaps

Wählen Sie aus den integrierten HTML-Vorlagen oder entwerfen Sie Ihre eigenen, einschließlich des eigentlichen HTML/CSS/JS-Codes und verschiedener Optionen, die beim Erstellen der Sitemaps verwendet werden.

Andere Funktionalität

Javascript- und AJAX-Unterstützung

Sie können TechSEO360 so konfigurieren, dass Javascript-Code nach Datei- und URL-Referenzen durchsucht wird, indem Sie die Option „Website scannen | Crawler-Optionen | Suche in Javascript versuchen“ aktivieren.

Wenn Sie es mit einer AJAX-Website zu tun haben, können Sie unter "Website scannen | Crawler-Engine | Standardpfadtyp und -handler" zu einer AJAX-fähigen Lösung wechseln.

Benutzerdefinierte Text- und Codesuche

Es kann oft sinnvoll sein, eine ganze Website nach Text und Code zu durchsuchen - zB um Seiten mit altem Google Analytics-Code oder ähnlichem zu finden.

Unter „Website scannen | Datenerfassung“ | können Sie mehrere Suchen konfigurieren Suchen Sie nach benutzerdefinierten Zeichenfolgen, Codes und Textmustern".

Die Ergebnisse werden in der Datenspalte „Seitenbenutzerdefinierte Suchen“ mit einer Anzahl für jede Suche angezeigt – optional mit den aus dem Musterabgleich extrahierten Inhalten.

Berechneter Wichtigkeitswert

TechSEO360 berechnet die Wichtigkeit aller Seiten basierend auf interner Verlinkung und internen Weiterleitungen.

Sie können dies sehen, indem Sie die Sichtbarkeit der Datenspalte „Wichtigkeitswert skaliert“ aktivieren.

Erkennung ähnlicher Inhalte

Manchmal sind Seiten ähnlich, aber keine exakten Duplikate. Um diese zu finden, können Sie vor dem Scan die Option „Website scannen | Datenerfassung | Tracking und Speicherung erweiterter Daten | Keyword-Analyse für alle Seiten durchführen“ aktivieren.

Wenn Sie Ergebnisse anzeigen, aktivieren Sie die Sichtbarkeit der Datenspalte „Duplikate von Seiteninhalten (visuelle Ansicht)“ und Sie erhalten eine grafische Darstellung des Inhalts.

Befehlszeilenschnittstelle (CLI)

Wenn Sie die Test- oder kostenpflichtige Version verwenden, können Sie die Befehlszeile verwenden – hier ist ein Beispiel:

"techseo.exe" -exit -scan -build ":my-project.ini" @override_rootpath=http://example.com@

Das obige übergibt eine Projektdatei mit allen definierten Optionen, überschreibt die Website-Domain und weist TechSEO360 an, einen vollständigen Crawl durchzuführen, Sitemaps zu erstellen und zu beenden.

Importieren von Daten

Die Funktionalität "Datei | Importieren..." arbeitet intelligent und kann verwendet werden für:

- URL-Listen importieren. Wenn die importierten URLs aus gemischten Domänen stammen, bestimmt TechSEO360, ob es eine primäre Domäne gibt, und importiert sie entsprechend in die Registerkarten „Intern“ und „Extern“.

- TechSEO360 kann auch verschiedene andere Datenquellen erkennen, deren Inhalte stattdessen zu den vorhandenen Daten hinzugefügt werden:

- Apache-Serverprotokolle, um vom GoogleBot „[googlebot]“ besuchte URLs zu „taggen“ und URLs zu erkennen, die nicht intern verlinkt/verwendet werden „[orphan]“.

- Google Webmaster Tools exportiert URLs, die von Google „[googleindexed]“ indiziert sind, sowie Daten für Klicks und Impressionen, um sie zu „taggen“.

- Majestic CSV-Exporte für Backlink-Score-Daten.

Das obige "[...]" kann vom "Schnellfiltertext" verwendet werden, um weitere benutzerdefinierte Berichte zu erstellen.

Daten exportieren

Die Funktion "Datei | Exportieren..." kann Daten in CSV, Excel, HTML und mehr exportieren, je nachdem, was Sie exportieren. Benutzen:

- Wählen Sie das Steuerelement mit den Daten aus, die Sie exportieren möchten.

- Wenden Sie Optionen an, damit das Steuerelement nur die Daten enthält, die Sie exportieren möchten. (Dies kann zB "Datenspalten", "Schnellfilteroptionen" und "Schnellfiltertext" beinhalten)

- Klicken Sie auf die Schaltfläche „Exportieren“ und Sie haben nun die gewünschten Daten im gewünschten Format.

TechSEO360-Preise

Es gibt im Wesentlichen drei verschiedene Zustände:

- Wenn Sie die Software zum ersten Mal herunterladen, erhalten Sie eine voll funktionsfähige kostenlose 30-Tage-Testversion .

- Wenn die Testversion abläuft, funktioniert es weiterhin im kostenlosen Modus , der das Crawlen von 500 Seiten auf Websites ermöglicht.

- Beim Kauf beträgt der jährliche Abonnementpreis 99 US-Dollar für eine Einzelbenutzerlizenz, die sowohl auf Windows als auch auf Mac verwendet werden kann.

Sie können die Testversion für Windows und Mac unter https://TechSEO360.com herunterladen .