WordPress에서 "Googlebot이 CSS 및 JS 파일에 액세스할 수 없음" 경고를 수정하는 방법은 무엇입니까?

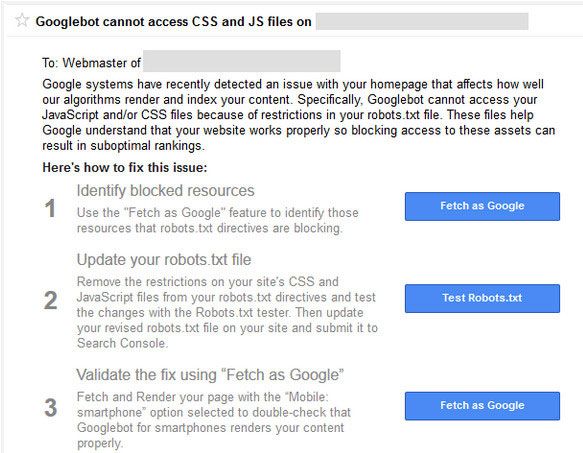

게시 됨: 2015-10-15WordPress 기반 사이트 또는 블로그를 사용하는 경우 과거에 Google 검색 콘솔 팀으로부터 Googlebot이 도메인의 CSS 및 JS 파일에 액세스할 수 없다는 경고를 받았거나 받을 수 있습니다.

Google에서 이 경고를 받은 경우 놀라지 마십시오. 기분이 나쁠 것 같지만 쉽게 고칠 수 있는 방법이 있습니다. 이메일 메시지에는 이 문제를 해결하는 방법에 대한 지침에 대한 링크가 포함되어 있습니다. 그러나 그 지침을 따르기가 그리 쉽지는 않습니다 .

Google 봇 및 기타 검색 스파이더는 htaccess 파일에 도달한 직후 웹사이트의 robots.txt 파일을 방문합니다.

Htaccess에는 IP 주소 차단, URL 리디렉션, gzip 압축 활성화 등 의 규칙이 있습니다 . robots.txt에는 검색 엔진에 대한 규칙 세트 도 있습니다. "Googlebot이 CSS 및 JS 파일에 액세스할 수 없습니다"라는 메시지가 표시되는 이유입니다.

Robots.txt에는 파일 및 디렉토리 크롤링을 차단하거나 허용하는 줄이 거의 없습니다. Google은 js 및 css 파일의 크롤링을 차단하는 웹사이트를 처벌하기 시작했습니다 . JavaScript 및 계단식 스타일 시트는 웹 사이트 렌더링을 담당하며 양식, 발생 이벤트 등을 처리합니다.

JS가 차단되면 Google 봇은 코드를 크롤링할 수 없으며 코드를 스팸 또는 링크 체계 위반으로 간주합니다. CSS 파일에도 동일한 논리가 적용됩니다.

이 경고 이메일을 아직 받지 못했다면 이메일 을 기다리지 않고 즉시 조치를 취할 수 있습니다.

WordPress Robots.txt는 무엇입니까?

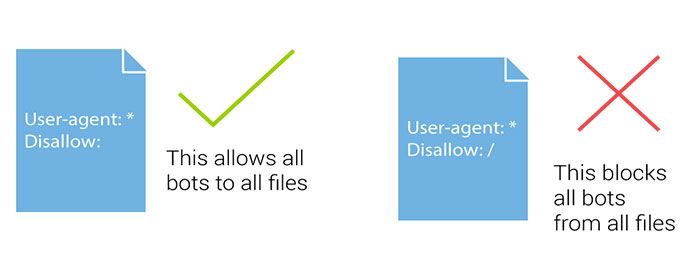

Robots.txt 파일은 검색 엔진 로봇이 크롤링할 부분과 피해야 할 부분을 지시하는 데 도움이 됩니다. 검색 봇이나 검색 엔진의 스파이더 가 귀하의 사이트에 와서 귀하의 사이트를 인덱싱하려고 할 때 robots.txt 파일을 먼저 따릅니다.

검색 봇 또는 스파이더는 웹사이트의 모든 페이지에 대해 색인을 생성하거나 색인을 생성하지 않기 위해 이 파일 방향을 따릅니다. WordPress를 사용하는 경우 WordPress 설치 루트에서 Robots.txt 파일을 찾을 수 있습니다.

robots.txt가 없으면 새 메모장 파일을 만들고 이름을 Robots.txt로 지정하기만 하면 됩니다. 그런 다음 FTP를 사용하거나 cPanel 파일 관리자를 통해 직접 도메인의 루트 디렉토리 에 업로드하십시오.

cPanel을 사용하여 서버의 FTP 계정에 로그인하여 WordPress robots.txt 파일을 편집하거나 플러그인을 사용할 수 있습니다. 사이트맵 URL과 함께 robots.txt 파일에 추가해야 하는 몇 가지 사항이 있습니다.

사이트맵 URL을 추가하면 검색 엔진 봇이 사이트맵 파일을 찾는 데 도움이 되므로 게시물과 페이지를 더 빨리 색인화할 수 있습니다. 다음은 샘플 robots.txt 파일 입니다. 사이트맵에서 사이트맵 URL을 블로그 URL로 바꿉니다.

사용자 에이전트: * # 이 디렉토리에 있는 모든 파일을 허용하지 않습니다. 허용하지 않음: /cgi-bin/ 허용하지 않음: /wp-admin/ 허용하지 않음: /archives/ 허용하지 않음: /*?* 허용하지 않음: *?replytocom 허용하지 않음: /wp-* 허용하지 않음: /comments/feed/ 사용자 에이전트: Googlebot-Image 허용: /wp-content/uploads/ 사용자 에이전트: Adsbot-Google 허용하다: / 사용자 에이전트: Googlebot-Mobile 허용하다: /

사이트맵: https://www.kasareviews.com/sitemap.xml

Google이 CSS 및 JS 파일에 액세스해야 하는 이유는 무엇입니까?

CSS 및 JavaScript 차단은 지난 10월 웹마스터 가이드라인에 작성된 이후로 Google에서 금지된 사항이었습니다. 최근에야 회사에서 이에 대한 경고를 발표했습니다.

사이트 에서 Googlebot 이 해당 파일에 액세스하지 못하도록 차단 한 경우 문제를 처리할 수 있도록 이에 대해 아는 것이 좋습니다.

Google은 사용자 친화적인 웹사이트에 더 나은 순위를 부여하는 데 중점을 두고 있습니다. 빠르고 좋은 사용자 경험을 제공하는 사이트 등. 웹사이트의 사용자 경험을 결정하기 위해 Google은 사이트의 CSS 및 JavaScript 파일을 방문할 수 있는 액세스 권한이 필요합니다.

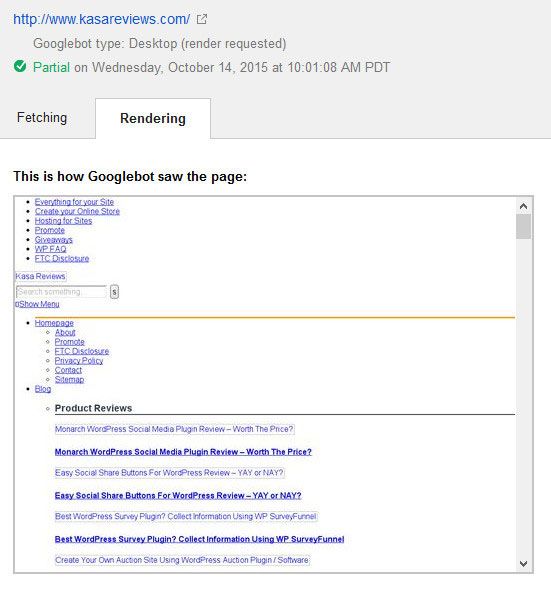

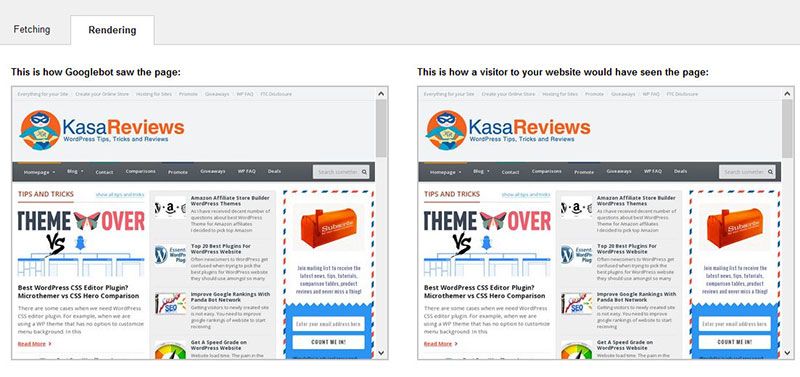

이것은 Google이 수정하기 전에 Kasa 리뷰 사이트를 본 방법입니다.

기본적으로 WordPress 는 검색 봇이 CSS 또는 JS 파일에 액세스하는 것을 차단하지 않습니다 . 그러나 일부 사이트 소유자는 추가 보안 조치를 추가하거나 WordPress 보안 플러그인을 사용하여 실수로 사이트를 차단할 수 있습니다.

이는 Googlebot이 사이트의 SEO 성능에 영향을 미칠 수 있는 CSS 및 JS 파일의 색인을 생성하는 것을 제한합니다. 쉽게 해결할 수 있으며 사이트의 robots.txt 파일을 수정하면 됩니다.

"Googlebot이 CSS 및 JS 파일에 액세스할 수 없음" 경고를 수정하는 방법은 무엇입니까?

robots.txt와 같은 용어가 생소하더라도 혼자가 아니므로 걱정하지 마십시오. SEO 업계에서는 흔한 용어이지만 블로거들 사이에서는 그다지 인기가 없습니다.

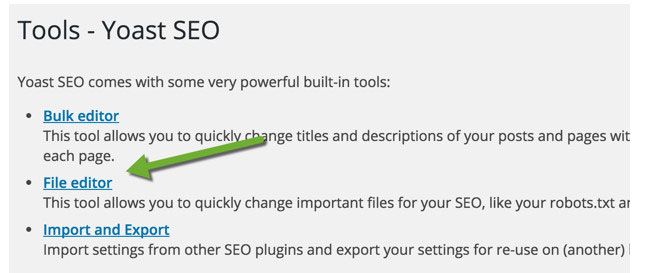

WordPress 블로그의 경우 cPanel(cPanel 장단점 참조)을 사용하여 FileZilla와 같은 FTP를 사용하여 robots.txt 파일을 편집하거나 Yoast의 SEO 파일 편집기 기능을 사용할 수 있습니다(Yoast 대 Rank Math 비교 확인).

Yoast SEO 플러그인을 사용하면 WordPress 대시보드에서 robots.txt 및 .htaccess 파일을 편집할 수 있습니다. WordPress 대시보드 내에서 SEO > 도구를 클릭하고 파일 편집기를 클릭합니다.

이 페이지에서 robots.txt 파일을 보고 수정할 수 있습니다. 대부분의 경우 다음 줄 을 제거 해야 합니다. Disallow: /wp-includes/

robots.txt 파일을 구성한 방법에 따라 대부분의 경고가 수정됩니다. 귀하의 사이트가 다음과 같은 일부 WordPress 디렉토리에 대한 액세스를 허용하지 않은 것을 볼 수 있습니다.

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

일부 사용자는 robots.txt 파일이 비어 있거나 존재하지 않는다는 것을 알 수 있습니다. Googlebot이 robots.txt 파일을 찾지 못하면 자동으로 모든 파일을 크롤링하고 색인을 생성합니다.

그러면 왜 이 경고가 표시됩니까? 드문 경우지만 일부 WordPress 호스팅 공급자는 봇용 기본 WordPress 폴더에 대한 액세스를 사전에 차단할 수 있습니다. 차단된 폴더에 대한 액세스를 허용하여 robots.txt에서 이를 무시할 수 있습니다.

User-agent: *

Allow: /wp-includes/js/

완료되면 robots.txt 파일을 저장합니다. fetch as Google 도구를 방문하여 가져오기 및 렌더링 버튼을 클릭합니다. 이제 가져오기 결과를 비교하면 대부분의 차단된 리소스 문제가 이제 사라져야 함을 알 수 있습니다.

robots.txt 파일을 수정하고 수정한 후 Google에서 Kasa 리뷰를 렌더링하는 방법은 다음과 같습니다. 또한 전체 사이트가 완전히 렌더링되는 것을 목표로 해야 합니다.

블로그의 robots.txt 파일을 수정한 후 Google 웹마스터 도구의 robots.txt 테스터를 사용하여 웹사이트의 모든 URL을 테스트하세요. 오류를 발견하거나 Googlebot이 리소스를 크롤링할 수 없는 경우 도구는 오류를 일으키는 행을 강조표시합니다.

문제를 제거하려면 강조 표시된 줄을 삭제하세요. 도움이 되었기를 바랍니다. 질문이 있는 경우 댓글 섹션을 통해 자유롭게 질문하세요 .