Wie behebt man die Warnung „Googlebot kann nicht auf CSS- und JS-Dateien zugreifen“ in WordPress?

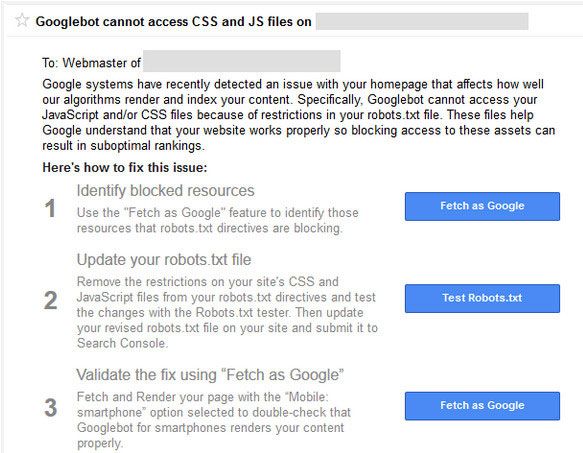

Veröffentlicht: 2015-10-15Wenn Sie eine WordPress-basierte Website oder einen WordPress-Blog verwenden, haben Sie in der Vergangenheit wahrscheinlich eine Warnung vom Google Search Console-Team erhalten (oder erhalten), dass der Googlebot nicht auf CSS- und JS-Dateien in Ihrer Domain zugreifen kann .

Seien Sie nicht beunruhigt, wenn Sie diese Warnung von Google erhalten haben. Das hört sich schlecht an, aber es gibt eine einfache Lösung dafür. Die E-Mail-Nachricht enthält Links zu Anweisungen zur Behebung dieses Problems. Aber diese Anweisungen sind nicht ganz einfach zu befolgen .

Der Google-Bot und andere Such-Spider besuchen die robots.txt-Datei Ihrer Website sofort, nachdem sie auf die htaccess-Datei geklickt haben.

Htaccess verfügt über Regeln zum Blockieren von IP-Adressen, Umleiten von URLs, Aktivieren der gzip-Komprimierung usw. Die robots.txt enthält auch eine Reihe von Regeln für die Suchmaschinen . Dies ist der Grund, warum Sie "Googlebot kann nicht auf CSS- und JS-Dateien zugreifen" erhalten haben.

Robots.txt enthält wenige Zeilen, die das Crawlen von Dateien und Verzeichnissen entweder blockieren oder zulassen . Google hat damit begonnen, Websites zu bestrafen , die das Crawlen von js- und css-Dateien blockieren. JavaScript und Cascading Stylesheets sind für das Rendern Ihrer Website verantwortlich und behandeln Formulare, Brandereignisse usw.

Wenn das JS blockiert ist, kann der Google-Bot den Code nicht crawlen und betrachtet den Code als Spam oder Verstoß gegen Linkschemata. Die gleiche Logik gilt für die CSS-Dateien.

Wenn Sie diese Warn-E-Mail noch nicht erhalten haben, können Sie sofort Maßnahmen ergreifen, anstatt auf die E-Mail zu warten .

Was ist WordPress Robots.txt?

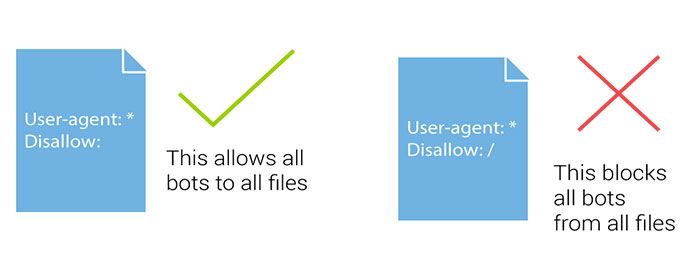

Die Datei Robots.txt hilft Suchmaschinen-Robots, zu bestimmen, welcher Teil gecrawlt und welcher Teil vermieden werden soll. Wenn ein Suchbot oder ein Spider einer Suchmaschine auf Ihre Website kommt und Ihre Website indizieren möchte, folgen sie zuerst der robots.txt-Datei.

Such-Bot oder -Spider folgen dieser Dateirichtung, um eine Seite Ihrer Website zu indizieren oder nicht zu indizieren. Wenn Sie WordPress verwenden , finden Sie die Datei Robots.txt im Stammverzeichnis Ihrer WordPress-Installation.

Wenn Sie keine robots.txt haben, können Sie einfach eine neue Notizblockdatei erstellen und sie als Robots.txt benennen. Dann laden Sie es einfach per FTP oder direkt über den cPanel-Dateimanager in das Stammverzeichnis Ihrer Domain hoch.

Sie können Ihre WordPress robots.txt- Datei entweder bearbeiten, indem Sie sich bei Ihrem FTP-Konto des Servers anmelden, cPanel verwenden oder das Plugin verwenden. Es gibt einige Dinge, die Sie zusammen mit Ihrer Sitemap-URL in Ihre robots.txt-Datei einfügen sollten.

Das Hinzufügen einer Sitemap-URL hilft Suchmaschinen-Bots, Ihre Sitemap-Datei zu finden und somit Ihren Beitrag und Ihre Seiten schneller zu indizieren. Hier ist eine robots.txt-Beispieldatei . Ersetzen Sie in der Sitemap die Sitemap-URL durch Ihre Blog-URL:

User-Agent: * # alle Dateien in diesen Verzeichnissen nicht zulassen Nicht zulassen: /cgi-bin/ Nicht zulassen: /wp-admin/ Nicht zulassen: /archive/ verbieten: //?* Verbieten: *?replytocom Nicht zulassen: /wp-* Nicht zulassen: /comments/feed/ User-Agent: Googlebot-Image Erlauben: /wp-content/uploads/ User-Agent: Adsbot-Google Erlauben: / User-Agent: Googlebot-Mobile Erlauben: /

Sitemap: https://www.kasareviews.com/sitemap.xml

Warum benötigt Google Zugriff auf CSS- und JS-Dateien?

Das Blockieren von CSS und JavaScript ist seit der Aufnahme in die Webmaster-Richtlinien im Oktober letzten Jahres ein Google No-Go. Erst vor kurzem hat das Unternehmen davor gewarnt.

Wenn Ihre Website den Googlebot daran gehindert hat, auf diese Dateien zuzugreifen, ist es gut, dass Sie darüber Bescheid wissen, damit Sie das Problem beheben können.

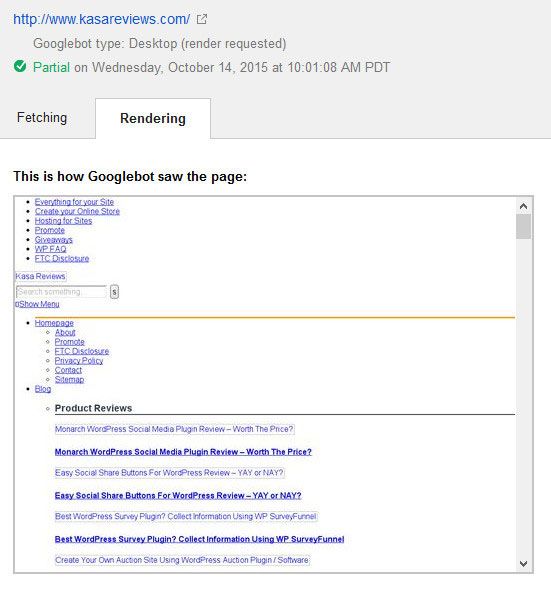

Google konzentriert sich darauf, benutzerfreundlichen Websites bessere Rankings zu verleihen. Websites, die schnell sind, eine gute Nutzererfahrung bieten usw. Um die Nutzererfahrung einer Website zu bestimmen, benötigt Google Zugriff, um die CSS- und JavaScript-Dateien der Website aufrufen zu können.

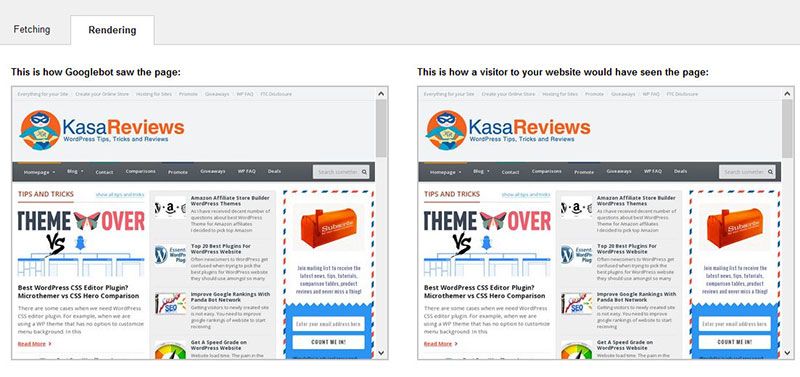

So sah Google die Website von Kasa Reviews vor dem Fix

Standardmäßig blockiert WordPress nicht den Zugriff von Such-Bots auf CSS- oder JS-Dateien. Einige Websitebesitzer können sie jedoch versehentlich blockieren, während sie versuchen, zusätzliche Sicherheitsmaßnahmen hinzuzufügen oder ein WordPress-Sicherheits-Plugin verwenden.

Dadurch wird der Googlebot daran gehindert, CSS- und JS-Dateien zu indizieren, was die SEO-Leistung Ihrer Website beeinträchtigen kann. Es gibt eine einfache Lösung dafür und beinhaltet die Bearbeitung der robots.txt-Datei Ihrer Website.

Wie behebt man die Warnung „Googlebot kann nicht auf CSS- und JS-Dateien zugreifen“?

Wenn Ihnen Begriffe wie robots.txt neu klingen, machen Sie sich keine Sorgen, denn Sie sind nicht allein. Es ist eine gängige Sprache in der SEO-Branche, aber bei Bloggern nicht so beliebt.

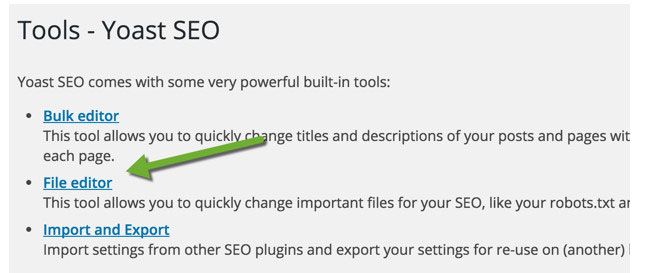

Für WordPress-Blog können Sie Ihre robots.txt-Datei mit FTP wie FileZilla bearbeiten, mit cPanel (siehe cPanel Vor- und Nachteile) oder die Datei-Editor-Funktion von SEO von Yoast verwenden (siehe Vergleich zwischen Yoast und Rank Math).

Mit dem Yoast SEO-Plugin können Sie Ihre robots.txt- und .htaccess-Datei über das WordPress-Dashboard bearbeiten. Klicken Sie in Ihrem WordPress-Dashboard auf SEO > Tools und klicken Sie auf Dateieditor

Auf dieser Seite können Sie Ihre robots.txt-Datei anzeigen und bearbeiten. In den meisten Fällen müssen Sie die folgende Zeile entfernen : Disallow: /wp-includes/

Je nachdem, wie Sie Ihre robots.txt-Datei konfiguriert haben, werden die meisten Warnungen behoben. Sie werden höchstwahrscheinlich feststellen, dass Ihre Website den Zugriff auf einige WordPress-Verzeichnisse wie folgt verweigert hat:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Einige Benutzer stellen möglicherweise fest, dass ihre robots.txt-Datei entweder leer ist oder gar nicht existiert. Wenn der Googlebot keine robots.txt-Datei findet, crawlt und indiziert er automatisch alle Dateien.

Warum sehen Sie dann diese Warnung? In seltenen Fällen können einige WordPress-Hosting-Anbieter den Zugriff auf Standard-WordPress-Ordner für Bots proaktiv blockieren. Sie können dies in der robots.txt-Datei überschreiben, indem Sie den Zugriff auf blockierte Ordner erlauben.

User-agent: *

Allow: /wp-includes/js/

Wenn Sie fertig sind, speichern Sie Ihre robots.txt-Datei. Rufen Sie das Tool zum Abrufen als Google auf und klicken Sie auf die Schaltfläche Abrufen und Rendern. Vergleichen Sie nun Ihre Abrufergebnisse, und Sie werden sehen, dass das Problem mit den meisten blockierten Ressourcen jetzt verschwinden sollte.

So rendert Google Kasa Reviews, nachdem die robots.txt-Datei bearbeitet und repariert wurde. Sie sollten auch darauf abzielen, dass Ihre gesamte Website vollständig gerendert wird.

Nachdem Sie die robots.txt-Datei Ihres Blogs geändert haben, testen Sie eine beliebige URL Ihrer Website mit dem robots.txt-Tester der Google Webmaster-Tools. Wenn Sie Fehler finden oder der Googlebot eine Ressource nicht crawlen kann, hebt das Tool die Zeile hervor, die den Fehler verursacht.

Löschen Sie die markierte Zeile, um das Problem zu beheben. Hoffe das hat geholfen. Wenn Sie Fragen haben, können Sie diese gerne über den Kommentarbereich stellen.