Como adicionar o arquivo Robots.txt para WordPress

Publicados: 2019-06-21

Apenas criar um site não é suficiente. Ser listado nos motores de busca é o objetivo essencial de todos os proprietários de sites para que um site se torne visível no SERP para determinadas palavras-chave. Essa listagem de um site e a visibilidade do conteúdo mais recente se devem principalmente aos robôs dos mecanismos de pesquisa que rastreiam e indexam sites. Os webmasters podem controlar a maneira como esses robôs analisam sites inserindo instruções em um arquivo especial chamado robots.txt.

Neste artigo, vou explicar como configurar um arquivo robots.txt do WordPress para o melhor SEO de um site. Observe que várias páginas de um site WordPress não precisam ser indexadas pelos motores de busca.

- O que é um arquivo Robots.txt?

- Por que criar Robots.txt para WordPress?

- Como criar Robots.txt para WordPress?

- Robots.txt avançado para WordPress

- O que incluir no Robots.txt para WordPress?

- Perguntas frequentes (FAQs)

O que é um arquivo Robots.txt?

Um robots.txt é um arquivo de texto localizado na raiz do seu site que diz aos rastreadores do mecanismo de pesquisa para não rastrear partes do seu site. Ele também é conhecido como Protocolo de Exclusão de Robôs, que impede que os mecanismos de pesquisa indexem certos conteúdos inúteis e / ou específicos (por exemplo, sua página de login e arquivos confidenciais).

Resumindo, o robots.txt diz aos bots dos mecanismos de pesquisa o que eles não devem rastrear no seu site.

É assim que funciona! Quando um robô de mecanismo de pesquisa está prestes a rastrear um URL de seu site (ou seja, ele rastreia e recupera informações para que possa ser indexado), ele primeiro procura seu arquivo robots.txt.

Por que criar Robots.txt para WordPress?

Normalmente, você não precisa adicionar o arquivo robots.txt para sites WordPress. Os mecanismos de pesquisa indexam todos os sites WordPress por padrão. No entanto, para melhorar o SEO, você pode adicionar um arquivo robots.txt ao diretório raiz para impedir especificamente que os mecanismos de pesquisa acessem áreas específicas do seu site WordPress.

IdeaBox - Estudo de Caso

Leia como a Cloudways ajudou uma agência WordPress a criar produtos melhores.

Obrigada

Seu Ebook está a caminho de sua caixa de entrada.

Como criar Robots.txt para WordPress?

Faça login no painel gerenciado de hospedagem na web do WordPress. No meu exemplo, estou usando Cloudways - plataforma de hospedagem em nuvem gerenciada.

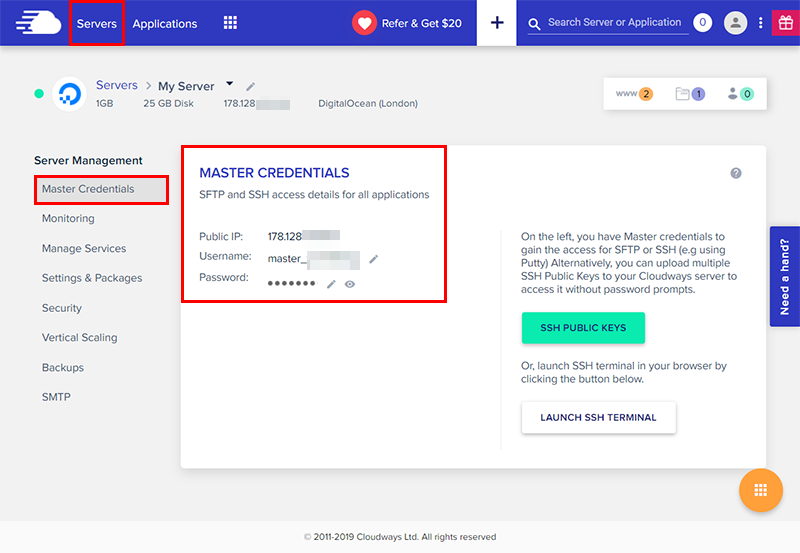

Vá para a guia Servidores na barra de menu superior e obtenha seu acesso SSH / SFTP em Gerenciamento de servidor → Credenciais principais .

Use qualquer aplicativo de servidor FTP para acessar seus arquivos de banco de dados do WordPress. Estou usando o FileZilla para este tutorial. Inicie-o e conecte-se ao seu servidor usando as credenciais principais .

Uma vez conectado, vá para a pasta / applications de seus arquivos de banco de dados do WordPress. Você verá pastas diferentes lá.

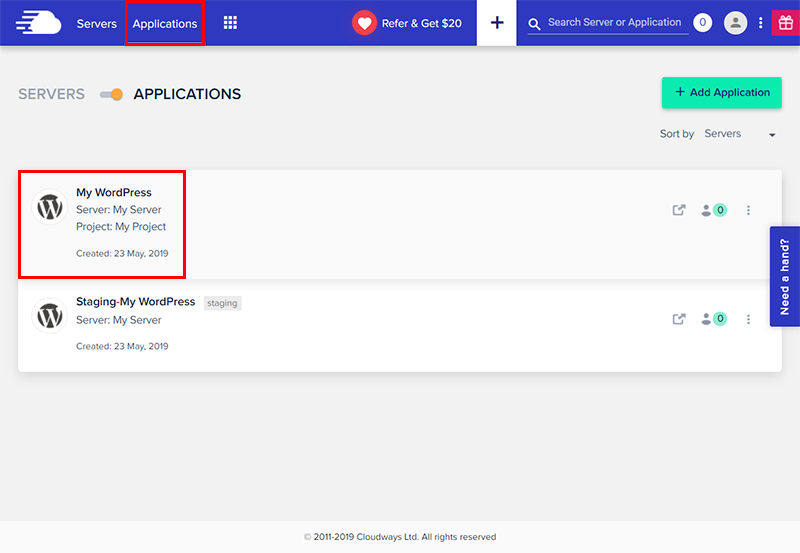

Agora volte para a Cloudways Platform e na barra superior esquerda, vá para Aplicativos . Selecione o aplicativo ao qual deseja adicionar o arquivo robots.txt:

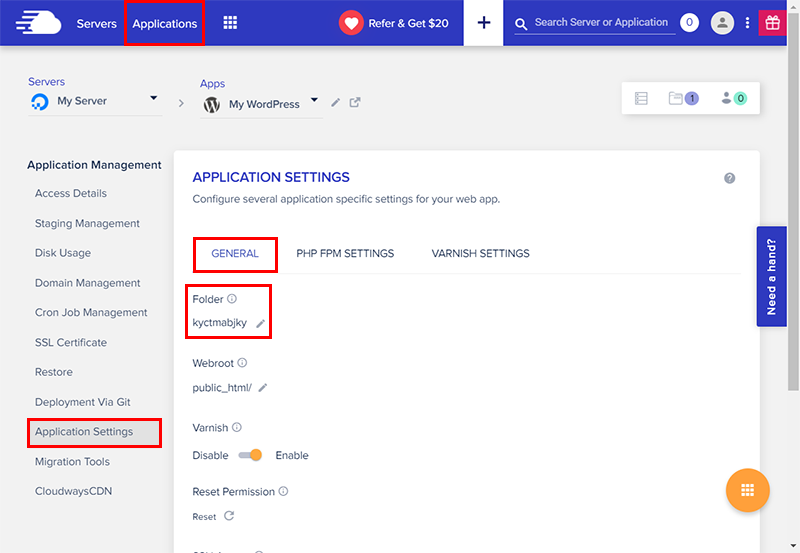

No painel esquerdo, vá para Gerenciamento de aplicativos → Configurações do aplicativo → Geral . Você encontrará o nome da pasta do seu aplicativo.

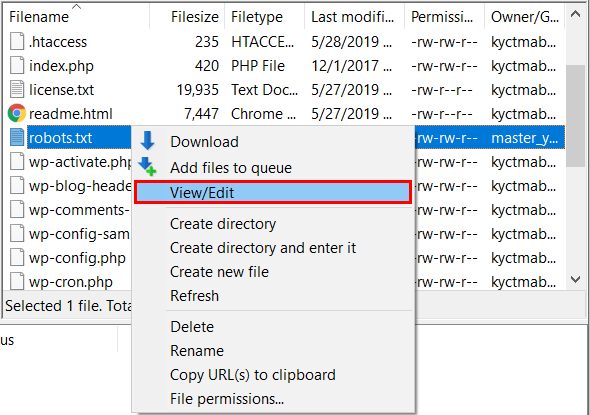

Volte para o FileZilla e navegue até / applications / [NOME DA PASTA] / public_html . Crie um novo arquivo de texto aqui e nomeie-o como robots.txt .

Clique com o botão direito do mouse no arquivo robots.txt e clique em Exibir / Editar para abri-lo em um editor de texto (o Bloco de notas é uma opção útil).

Robots.txt avançado para WordPress

Mecanismos de busca como Google e Bing suportam o uso de curingas no arquivo robots.txt. Esses curingas podem ser usados para permitir / proibir tipos de arquivo específicos em todo o site do WordPress.

Um asterisco (*) pode ser usado para lidar com uma ampla gama de opções / seleções.

Agente de usuário: * Disallow: /images/image*.jpg

Aqui, “*” significa que todas as imagens que começam com “imagem” e com a extensão “jpg” não serão indexadas pelos motores de busca. Aqui estão alguns exemplos de robots.txt do WordPress.

Exemplo: image1.jpg, image2.jpg, imagexyz.jpg não será indexado pelos motores de busca.

O poder de * não se limita apenas a imagens. Você pode até proibir todos os arquivos com uma extensão específica.

Agente de usuário: * Disallow: /downloads/*.pdf Disallow: /downloads/*.png

As afirmações acima solicitarão a todos os mecanismos de pesquisa que desabilitem todos os arquivos com extensões “pdf” e “png” encontrados na pasta de downloads.

Você pode até proibir os diretórios principais do WordPress usando *.

Agente de usuário: * Disallow: / wp - * /

A linha acima solicita que os mecanismos de pesquisa não rastreiem os diretórios que começam com “wp-”.

Exemplo: wp-includes, wp-content, etc. não serão indexados pelos motores de busca.

Outro símbolo curinga usado no arquivo robots.txt do WordPress é o símbolo do dólar ($).

Agente de usuário: * Disallow: referral.php

A declaração acima solicitará que os mecanismos de pesquisa não indexem referral.php e também referral.php? Id = 123 e assim por diante.

Mas e se você quiser bloquear apenas referral.php? Você só precisa incluir o símbolo $ logo após o referral.php.

O símbolo $ garante que apenas referral.php seja bloqueado, mas não referral.php? Id = 123.

Agente de usuário: * Disallow: referral.php $

Você também pode usar $ para diretórios.

Agente de usuário: * Disallow: / wp-content /

Isso instruirá os mecanismos de pesquisa a proibir a pasta wp-content mais todos os diretórios localizados dentro de wp-content. Se você deseja proibir apenas wp-content em vez de todas as subpastas, você deve usar o símbolo $. Por exemplo:

Agente de usuário: * Disallow: / wp-content / $

O símbolo $ garante que apenas wp-content não seja permitido. Todos os diretórios nesta pasta ainda estão acessíveis.

Abaixo está o arquivo robots.txt para o blog da Cloudways.

Agente de usuário: * Disallow: / admin / Disallow: / admin / *? * Desautorizar: / admin / *? Disallow: / blog / *? * Desautorizar: / blog / *?

A primeira linha indica o agente do usuário. Refere-se ao mecanismo de pesquisa que tem permissão para acessar e indexar o site. Uma lista completa de todos os robôs de mecanismos de pesquisa está disponível aqui .

Agente de usuário: *

Onde * significa todos os mecanismos de pesquisa. Você pode especificar cada mecanismo de pesquisa separadamente.

Disallow: / admin / Disallow: / admin / *? * Desautorizar: / admin / *?

Isso não permitirá que os mecanismos de pesquisa rastreiem o diretório “admin”. Freqüentemente, não é necessário que os mecanismos de pesquisa indexem esses diretórios.

Disallow: / blog / *? * Desautorizar: / blog / *?

Se o seu site WordPress for um site de blog, a prática recomendada é restringir os robôs dos mecanismos de pesquisa para não rastrearem suas consultas de pesquisa.

Se o seu site possui um mapa do site. Adicionar seu URL ajuda os robôs do mecanismo de pesquisa a encontrar o arquivo de mapa do site. Isso resulta em uma indexação mais rápida das páginas.

mapa do site: http://www.yoursite.com/sitemap.xml

O que incluir no Robots.txt para WordPress?

Você decide quais partes do site WordPress deseja incluir no SERP. Todo mundo tem suas próprias opiniões sobre a configuração do arquivo robots.txt do WordPress. Alguns recomendam não adicionar um arquivo robots.txt no WordPress. Embora, na minha opinião, deva-se adicionar e proibir / wp-admin / pasta. O arquivo Robots.txt é público. Você pode encontrar um arquivo robots.txt de qualquer site visitando www.example.com/robots.txt.

Terminamos com um arquivo robots.txt no WordPress. Se você tiver alguma dúvida sobre a configuração do arquivo robots.txt, fique à vontade para perguntar na seção de comentários abaixo.

Empacotando!

Como você pode ver, o arquivo robots.txt é uma ferramenta interessante para o seu SEO. Torna possível apontar para robôs de mecanismo de pesquisa o que indexar e o que não indexar. Mas deve ser tratado com cuidado. Uma configuração incorreta pode levar a uma desindexação total do seu site (exemplo: se você usar Disallow: /). Por isso tem cuidado!

Agora é sua vez. Diga-me se você usa esse tipo de arquivo e como o configura. Compartilhe-me seus comentários e feedback nos comentários.

T1. O que é o robots.txt?

O robots.txt é um arquivo de texto colocado na raiz do seu site. Este arquivo tem como objetivo proibir os robôs do mecanismo de pesquisa de indexar certas áreas do seu site. O arquivo robots.txt é um dos primeiros arquivos verificados por spiders (robôs).

2º trimestre. Por que um arquivo robots.txt é usado?

O arquivo robots.txt dá instruções aos robôs dos buscadores que analisam o seu site, é um protocolo de exclusão para robôs. Graças a este arquivo, você pode proibir a exploração e indexação do seu site para alguns robôs (também chamados de “crawlers” ou “spiders”).